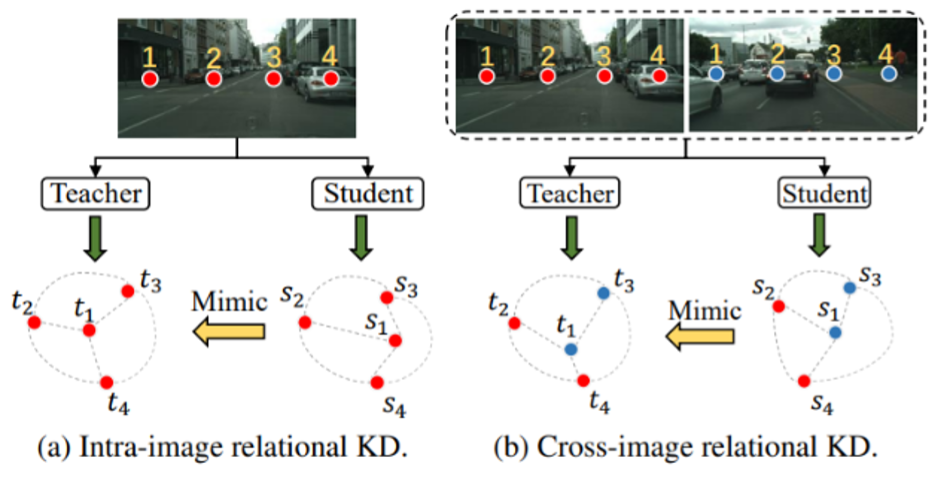

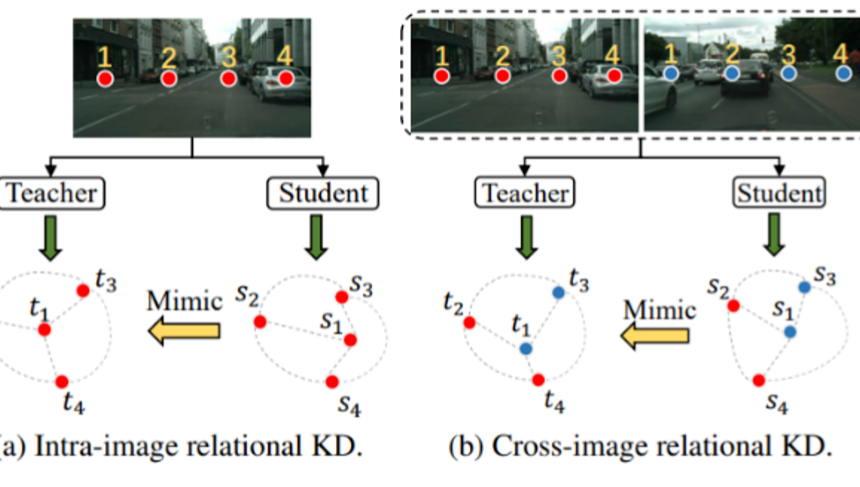

语义分割任务作为计算机视觉中的基础任务之一,其目的是对图像中的每一个像素进行分类。该任务也被广泛应用于实践,例如自动驾驶和医学图像分割。现有流行的用于语义分割任务的模型,例如DeepLab和PSPNet系列,虽然获得了很好的分割精度,但是所需的算力成本较高。本文考虑使用知识蒸馏(Knowledge Distillation,KD)算法来缓解这个问题。KD作为模型压缩里的一项重要技术,其核心思想是将教师模型中学习的知识作为监督信号来训练学生模型,使得学生模型得到更好的性能。虽然现有的语义分割知识蒸馏方法能够对学生网络的性能进行提升,但是这些方法通常是从单张图像中提取知识,忽略了跨图像之间的关系信息也是一种有价值的知识。最近,地平线-中科院提出了一种新颖的跨图像关系型KD方法用于语义分割任务-CIRKD。该方法尝试在语义分割任务中建模pixel-to-pixel和pixel-to-region这两种对比关系作为KD的监督信号。本文主要从方法介绍以及实验结果对提出的CIRKD进行讲解。

成为VIP会员查看完整内容