序列到序列的视觉-语言模型展现出了前景,但由于其自回归方式生成预测的方式,其应用受到了推理延迟的限制。我们提出了一种并行解码的序列到序列视觉-语言模型,该模型采用Query-CTC损失进行训练,可以在解码器中对多个推理路径进行边际化处理。这允许我们模拟令牌的联合分布,而不是像自回归模型那样限制于条件分布。结果模型,NARVL,在性能上与其最先进的自回归对应模型相当,但在推理时间上更快,将与顺序生成token相关的线性复杂度减少到常数时间的联合推理范式。

自回归的序列到序列Transformer模型是一种深度神经网络架构,将一系列代表文本片段的令牌(每个令牌表示为一个向量)映射到另一个序列上,通常代表相同序列向前移动一个位置的情况。这样的模型可以处理各种任务,其中输入(查询)文本可能是自然语言中的一个句子,输出(目标)可能是不同语言中的相同句子(翻译),或输入表达的问题的答案(问答QA),实体或类的名称等。Transformer架构的多功能和统一设计导致了全能(AIO)模型的发展,使得多种任务可以作为序列到序列翻译问题来处理。

视觉-语言AIO模型,包括序列到序列的模型,已经成功地将多模态输入(通常是图像和文本字符串)映射到文本输出,这些文本输出编码了可以表达为一串文本的任务,如视觉问答(VQA)、视觉定位(VG)、视觉蕴含(VE)和图像字幕(IC)。这些自回归序列到序列模型面临推理成本问题,因为它们往往笨重且需要执行T次以生成长度为T的输出序列。

在一些最新的视觉-语言AIO模型中提出了非自回归方法,这些方法将序列到序列映射定义为一个二分匹配问题。这种方法在视觉信息是关键的任务中表现出色,如对象定位和检测。然而,它在处理以语言为中心的任务,如视觉问答和图像字幕,方面的效果较差。这种差异可能源于任务的性质:在对象检测/定位中,令牌是无序的,每个令牌对应不同的对象或框,与句子中有序的令牌相比,对象间的相关性较弱,而句子中单词间的相关性更强。因此,与语言导向的任务相比,集合到集合、顺序独立的翻译方法更适合视觉任务。

主要假设:我们假设基于Transformer的架构可以利用输入和输出空间的同质性,同时使输出空间更加灵活。特别是,我们对一次性联合解码序列,而不是逐步解码的可能性感兴趣。我们测试这样的架构是否能够在显著降低推理成本的同时,达到与自回归基线相当的性能。

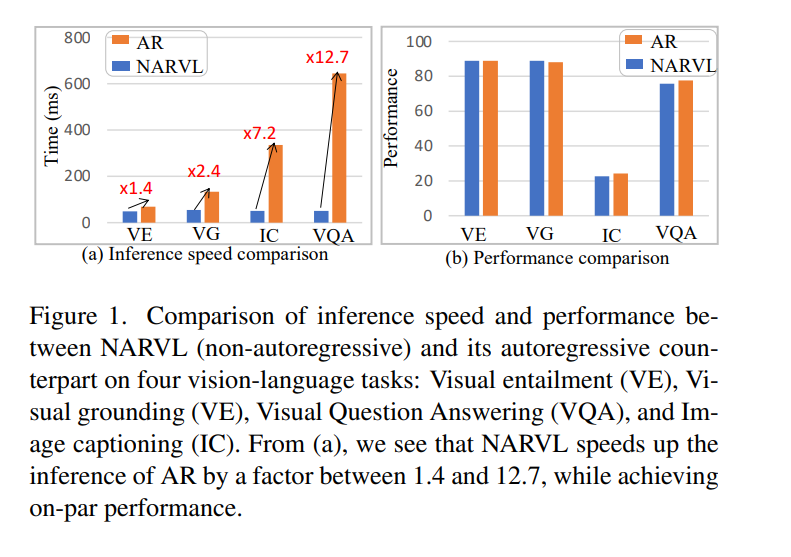

为了测试这一假设,我们开发了一个新的视觉语言全能模型,将基于Transformer的自回归一步预测模型转变为目标令牌的联合预测器,如第3节所述。在第4节中,我们展示了这样一个模型,我们命名为NARVL,可以用于多个视觉-语言任务(视觉问答VQA、字幕、蕴含、定位)。如图1所示,NARVL在性能上与最先进的自回归模型相当,但在速度上有显著优势,范围从1.4到12.7倍不等。

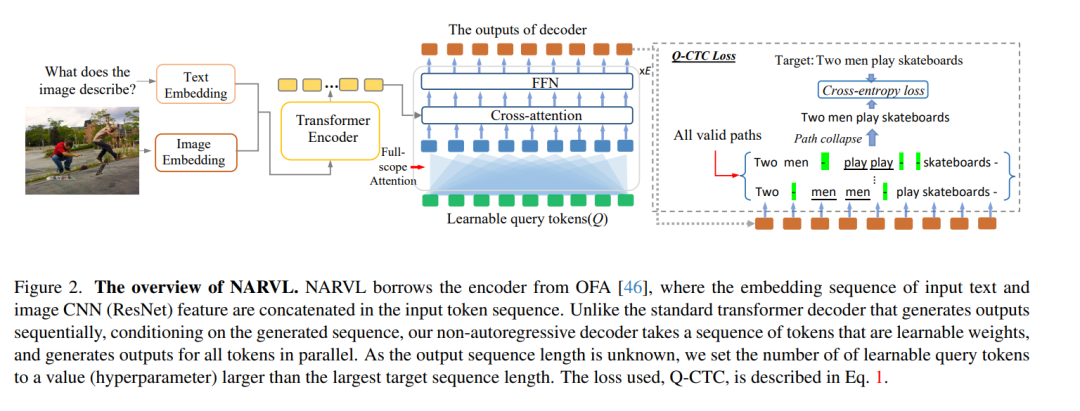

NARVL的实现通过重新利用自回归Transformer模型的解码器,并且模型有一层可学习的查询令牌(LQT),这些令牌在推理时固定,在微调期间学习。NARVL通过Query-CTC(Q-CTC)损失启用,这是CTC损失的一个变体,CTC损失用于音频和语言,但从未应用于视觉领域,在这个领域,普通的经验交叉熵损失(CE)相对于预测中的生成变异性被边际化。而在语言领域,多个解码假设源自编码器的输出,在视觉中这是限制的,因为输入和输出空间是异构的。因此,我们修改了CTC损失,使其不是相对于解码路径进行边际化,而是相对于从顺序可学习查询令牌的顺序索引到预测令牌的路径进行边际化。

因此,我们的关键贡献可以总结如下:(i)我们提出了一个新的序列到序列非自回归的全能视觉语言模型,该模型并行生成序列。(ii)我们引入Query-CTC损失来训练这一架构,灵感来自于音频识别和语言中使用的CTC损失,利用顺序可学习查询令牌生成多个生成路径,并在普通交叉熵损失中对结果种群进行边际化。我们展示了(iii)所得到的架构与多个视觉-语言任务中的最先进自回归架构具有竞争力,且由于模型在推理时仅执行一次,而不是按照输出层中的令牌数量顺序执行多个步骤,因此大大减少了推理时间。