Uber AI 论文 | 一种可微塑性的新方法

译者 | 刘畅Troy

出品 | AI科技大本营(公众号ID:rgznai100)

【 AI 科技大本营导读】为了给我们的智能产品提供类脑的学习能力,Uber 人工智能实验室开发了一种称为可微塑性的新方法,这种方法能够通过梯度下降训练塑性连接的行为,以帮助以前训练的网络适应未来的新条件。

神经网络,作为 Uber 公司机器学习系统的基础,已经成功解决了许多复杂的问题。这些问题包括图像识别,语言理解和游戏玩法等。然而,这些网络通常使用一种叫梯度下降的方法进行训练优化,这样做的原因是因为梯度下降算法能够在多次靠近最优点的过程中,根据网络性能来逐步调整网络间的连接。一旦训练完成,网络结构就被固定了,它们之间的连接状态也不会再改变; 因此,除非以后再次训练( 会再需要更多的数据 )这个模型,网络实际上在训练结束时就已经停止学习。

相比之下,生物大脑表现出了一种可塑性——也就是说,在生物整个生命过程中,神经元之间的连接能力是在不断的自动变化,使动物能够在日新月异的生活中快速且高效地学习。而大脑中不同区域和连接的可塑性水平,则是数百万年来进化的结果,它能够让生物在一生中进行有效的学习。由此产生的持续学习能力可以让动物在只需很少的附加数据下,适应变化莫测或不可预测的环境。这就是为什么我们可以快速记住我们以前从未见过的模式,或者在完全陌生的情况下只需几次试验,就能学习到新的模式。

为了给我们的智能产品提供类似的能力,Uber人工智能实验室开发了一种称为可微塑性的新方法,而且这种方法能使用梯度下降来训练其塑性连接行为,这可以帮助以前训练好的网络适应新的条件。虽然演化这种塑性神经网络的过程在进化计算已经有长期的研究,但据我们所知,这里介绍的工作是第一个表明可以通过梯度下降来优化塑性网络本身。因为基于梯度的方法最近在人工智能( 包括图像识别,机器翻译,Atari 视频游戏和 Go 玩 )方面有许多突破,使采用梯度下降方法训练的塑性网络,可能会在某种程度上极大地扩展这两种方法本身的力量。

▌可微塑性如何工作

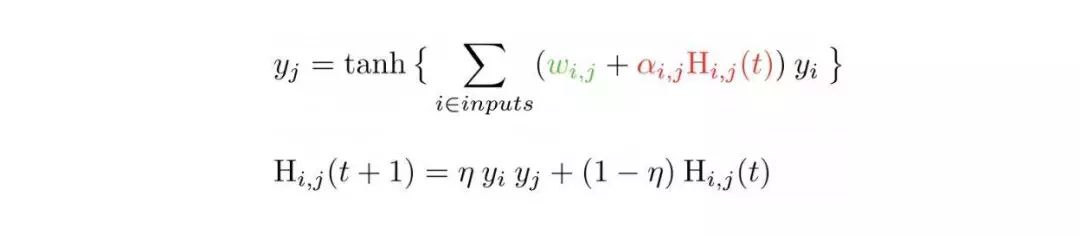

在我们的方法中,每个连接都会有一个初始化权重,以及一个决定塑性连接的系数。更确切地说,神经元 i 的激活 y_i 是由如下公式计算得到的:

第一个公式是神经网络单元中典型的激活函数,除了输入权重具有一个固定的分量( 绿色 )和塑性分量( 红色 )之外。塑性部件中的 H_ij 项通过输入和输出函数进行自动更新( 如第二个公式中所述,注意如论文中所讨论的,其他更新方法也是可以的 )。

在初始训练阶段,梯度下降会调节结构参数 w_ij 和 α_ij ,这决定了固定参数和塑性部件有多大。因此,在初始训练之后,智能体可以从正进行的实验中自动学习,因为每个连接的塑性部件都经过神经活动的充分塑造,以存储信息。这不禁让人想起动物( 包括人类 )中的某些学习形式。

▌证明可微塑性

为了证明可微塑性的潜在能力,我们将其应用于几个具有挑战性的任务,这些任务都需要快速从不可预知的环境中进行学习。

在图像重构任务中( 图 1 ),网络存储了一组前所未见的自然图像; 然后显示这些图像中的一张,但图像的一半被擦除了,需要网络从内存中重构丢失的那一半图像。我们表明,可微塑性可以有效地训练具有数百万参数的大型网络来解决这个任务。重要的是,具有非塑性连接的传统网络( 包括 LSTM 等最先进的循环体系结构 )无法解决此任务,并且需要花费相当多的时间来学习一个大规模网络的简化版本。

图1:图像填充完整的过程( 每行表示一次独立的实验 )。在给定三张图像之后,在网络中输入一部分图像,然后必须从内存中重构出丢失的部分。非塑性网络( 包括 LSTM )无法解决此类任务。源图像来自 CIFAR10 数据集。

我们还训练了塑性网络来解决 Omniglot 识别任务( 标准的“少样本学习”任务 ),这需要从每种字符的单个图像中学习,并识别一组新的手写符号。此外,该方法还可以应用于强化学习问题:在迷宫探索任务中,这个任务就是智能体必须发现,记忆并反复到达迷宫内的奖励位置( 如图 2 ),结果显示塑性网络胜过非塑性网络。将可塑性系数添加到神经网络这一简单的思想为我们解决需要从持续的经验中不断学习的问题提供了一种全新的方法——有时还是最好的方法。

图2:迷宫探索任务。智能体( 黄色方块 )需要尽可能多的找到奖励位置( 绿色方块 )来获得相应的奖励( 智能体在每次发现奖励后将被随机传送到其它地点 )。在第 1 个循环中(左),智能体的行为本质上是随机的。经过 300,000次迭代后(右),智能体已经记住了奖励地点并直接导向它。

结语

实际上,可微塑性为“学习学习器”或“元学习”这些经典问题提供了一种新的生物启发式方法。该方法也非常灵活,其中的基本构建块( 塑性连接 )可以使用梯度下降更新。正如上述不同的任务所展示的那样,我们可以以各种有力的方式利用它。

此外,它打开了多个新的研究途径的大门。例如,我们是否可以通过塑性连接来改进现有的复杂网络体系结构,如 LSTM ?如果连接的可塑性受到网络本身的控制,就好像在生物大脑中神经调节器的影响?可塑性网络是否能提供一种比只循环更有效的记忆形式( 请注意,循环将传入的信息存储在神经活动中,而可塑性将其存储在更多的连接中 )?

我们打算在今后的工作中研究这些以及其他令人兴奋的问题,并希望其他人能够加入我们的探索。为了鼓励对这种新方法的研究,我们在 GitHub 上发布了上述实验的代码,以及描述我们的方法和结果的论文。

作者:Thomas Miconi, Jeff Clune and Kenneth O. Stanley

原文链接:https://eng.uber.com/differentiable-plasticity/

Github链接: https://github.com/uber-common/differentiable-plasticity

论文链接:https://arxiv.org/abs/1804.02464

AI科技大本营现招聘AI记者和资深编译,有意者请将简历投至:gulei@csdn.net,期待你的加入!

AI科技大本营读者群(计算机视觉、机器学习、深度学习、NLP、Python、AI硬件、AI+金融、AI+PM方向)正在招募中,和你志同道合的小伙伴也在这里!关注AI科技大本营微信公众号,后台回复:读者群,添加营长请务必备注姓名,研究方向。

☟☟☟点击 | 阅读原文 | 查看更多精彩内容