【选介】基于全卷积网络的迭代非盲反卷积

编者按:由于图像降质过程中存在信息丢失,解决图像复原问题往往需要施加有效的先验约束,并用较高的代价求解一个非凸优化问题。近年来,深度学习方法的出现正在改变这一现状。依靠大数据的训练,网络能够快速有效地进行图像复原。目前,这些方法正越来越多地直面真实的应用场景,带给我们解决实际场景下图像复原问题的新思路。

今天带来的是CVPR 2017上的一篇关于非盲反卷积的工作。该工作[1]将非盲反卷积拆成图像去噪和图像反卷积两步,并使用全卷积网络在图像的梯度域上进行去噪,利用学习得到的梯度图指导图像的反卷积。通过使用一个迭代的框架进行联合去噪和反卷积,本文方法学到了自适应的图像先验,同时保持局部图像细节和全局图像结构。

设计思路

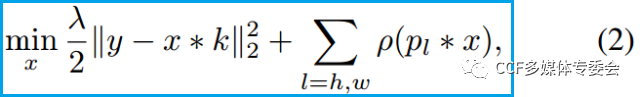

半二次分裂(Half-quadratic splitting)被广泛用于非盲图像去模糊。传统的复原模型为:

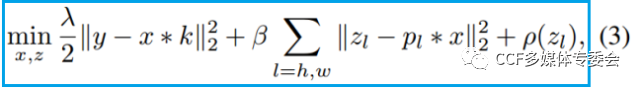

其中,Ph和Pw是水平和垂直的梯度算子,加号后的式子是对图像梯度的约束。使用半二次分裂,模型(2)能被重写为:

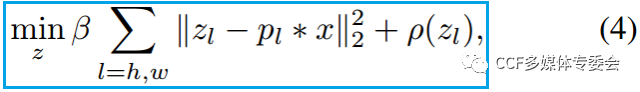

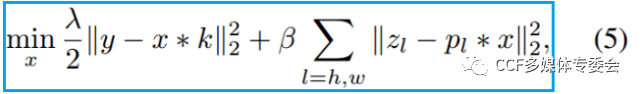

zl是辅助变量,Beta是权重。该半二次优化问题可以分裂后进行交替求解:

其中,求解(4)是一个去噪的问题,而求解(5)是对x进行反卷积的问题。因此,求解该问题的核心在于,如果定义一个求解问题(4)的合适先验。

网络结构

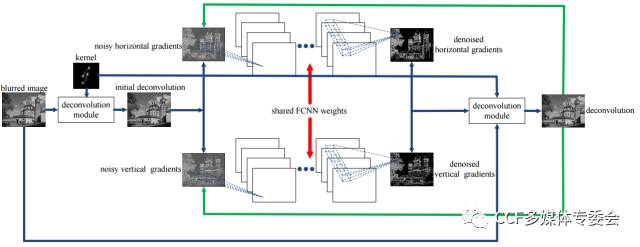

基于上述设计思路,本文提出了图1所示的网络。网络的输入是模糊的图像和对应的模糊核。网络首先通过反卷积模块对输入的模糊图像进行反卷积,然后对水平和垂直方向上的梯度图进行卷积,产生去噪后的结果。最后,反卷积模块作用在去噪后的梯度图上,生成干净的图像。

图1 本文提出的非盲反卷积的网络结构图,主要包括去噪和反卷积两个部分

去噪与反卷积

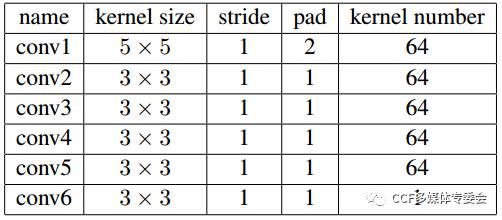

去噪网络使用一个全卷积网络结构,配置如表1所示。在训练当中,将垂直的梯度图转置,使对水平和垂直梯度进行处理的网络在训练时进行参数共享。

表 1. 单个迭代的全卷积网络结构

求得zl后,可以基于(5),通过快速傅里叶变换求解x。

实验结果

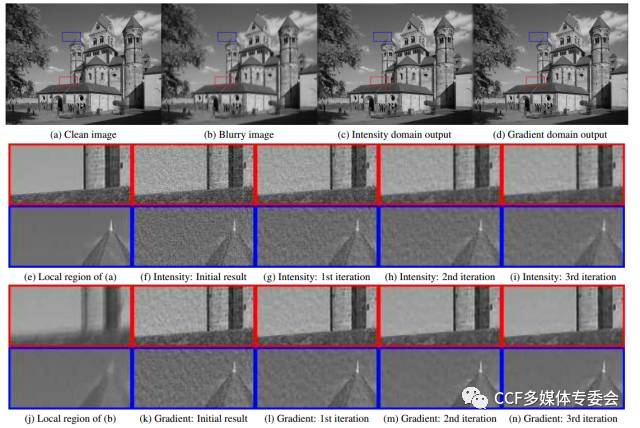

文章首先验证了,相比于在灰度域,本文方法在梯度域中进行卷积滤波的有效性。

图 2. 在不同域中,每次迭代生成结果的视觉效果

转自:CCF多媒体专委会