论文题目: Graph Transformer Network

论文摘要:

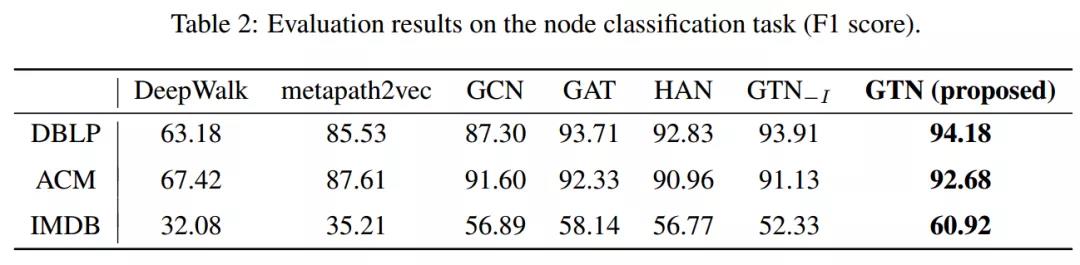

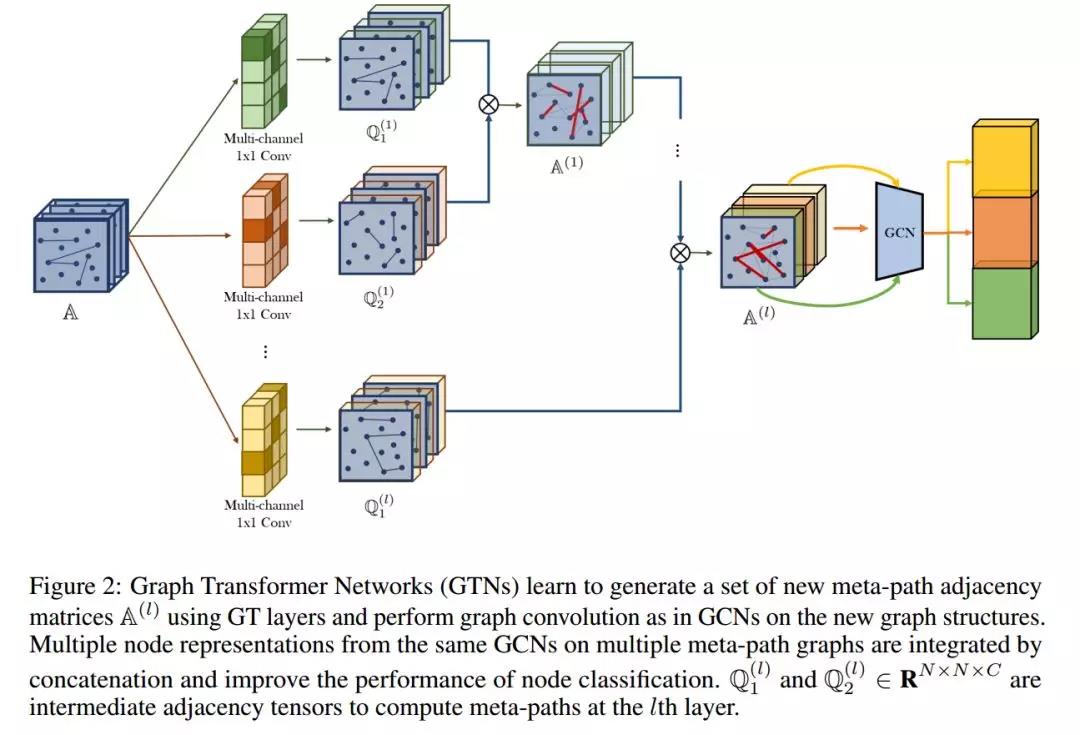

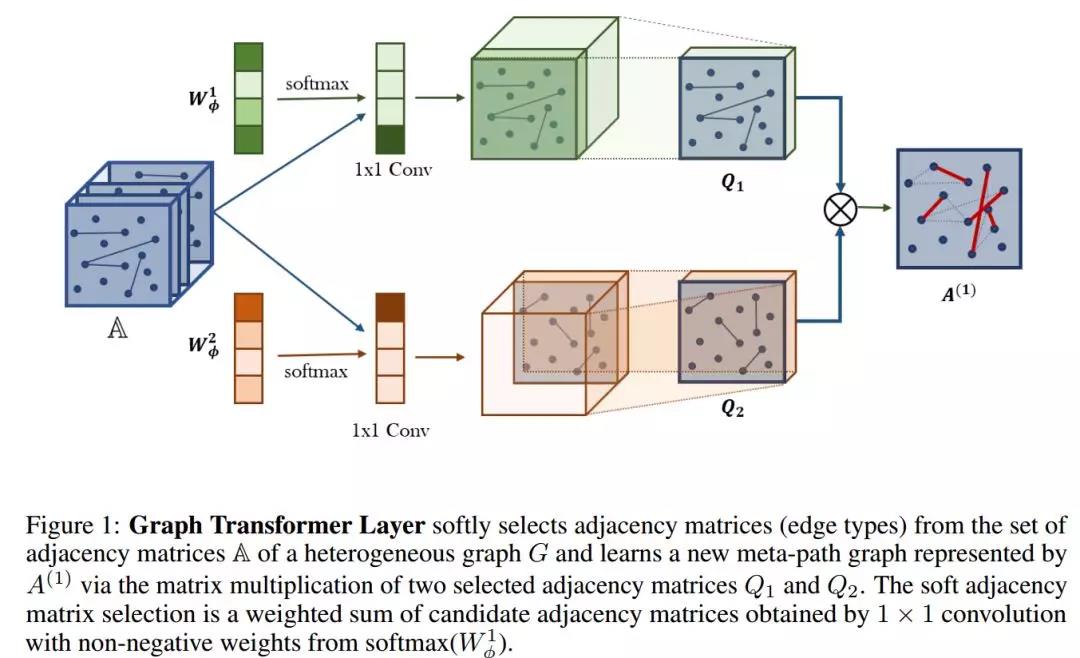

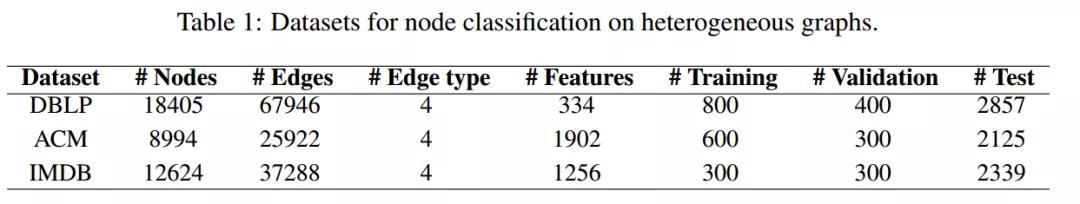

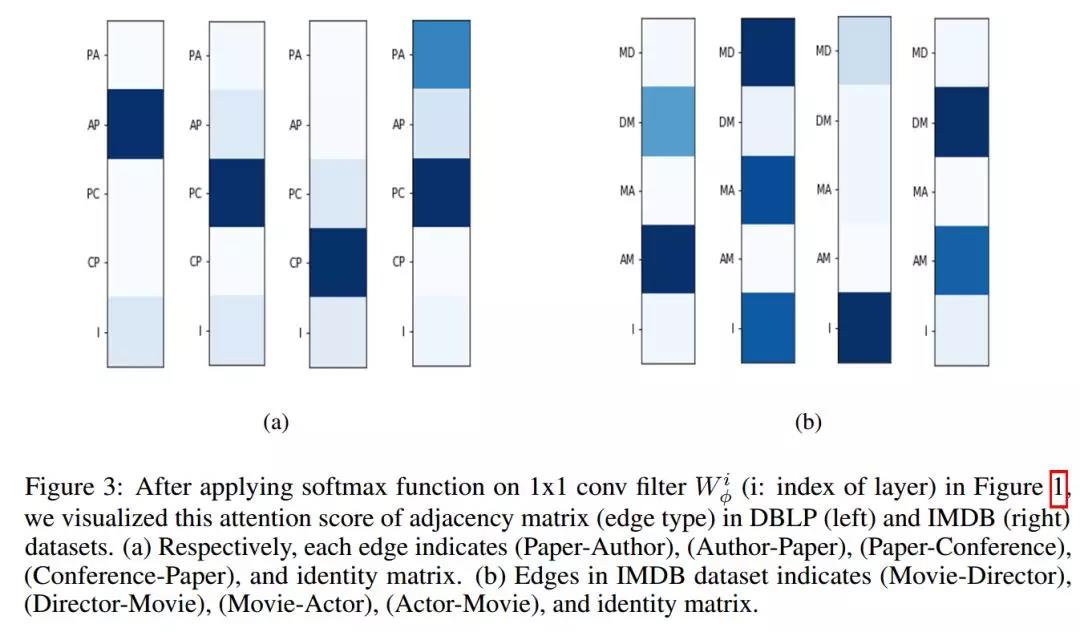

图神经网络(GNNs)在图表示学习中得到了广泛的应用,实现了节点分类和连接预测等任务的最佳性能。然而,大多数现有的GNNs都被设计为在固定(fix)和同质(homogeneous)的图上学习节点表示。当在不确定的图或由各种类型的节点和边组成的异构(heterogeneous)图上学习表示时,这些限制尤其成问题。本文提出了能够生成新的图结构的图变换网络(Graph Transformer Networks, GTNs),它涉及在原始图上识别未连接节点之间的有用连接,同时以端到端方式学习新图上的有效节点表示。图变换层是GTNs的核心层,学习边类型和复合关系的软选择,以产生有用的多跳连接,即所谓的元路径。我们的实验表明,GTNs基于数据和任务,在没有领域知识(domain knowledge)的情况下学习新的图结构,并通过在新图上的卷积产生强大的节点表示。在没有域特定的图预处理的情况下,GTNs在所有三个benchmark节点分类任务中实现了对比需要领域知识的预定义的元路径的现有技术方法的最佳性能。本文提出了能够生成新的图结构的图变换网络(Graph Transformer Networks, GTNs),该方法将异构图转化为由任意边类型和任意长度的元路径定义的多个新图,同时通过对学习到的元路径图进行卷积学习节点表示。GTN打破了手工构建元路径的现状,构建了自动化的图生成及表示学习模式。

作者简介:

Raehyun Kim目前在高丽大学计算机科学与工程学院,研究领域为股票市场预测,推荐系统,决策支持系统。

Hyunwoo J. Kim目前在高丽大学计算机科学与工程学院助理教授,研究兴趣为机器学习、计算机视觉、数值优化、多方面统计数据、深度学习。