谷歌大脑新研究:单一任务的强化学习遇瓶颈?是「灾难性遗忘」的锅!图灵奖得主Bengio参与

鱼羊 发自 凹非寺

量子位 报道 | 公众号 QbitAI

雅达利游戏,又被推上了强化学习基础问题研究的舞台。

来自谷歌大脑的最新研究提出,强化学习虽好,效率却很低下,这是为啥呢?

——因为AI遭遇了「灾难性遗忘」!

所谓灾难性遗忘,是机器学习中一种常见的现象。在深度神经网络学习不同任务的时候,相关权重的快速变化会损害先前任务的表现。

而现在,这项图灵奖得主Bengio参与的研究证明,在街机学习环境(ALE)的单个任务中,AI也遇到了灾难性遗忘的问题。

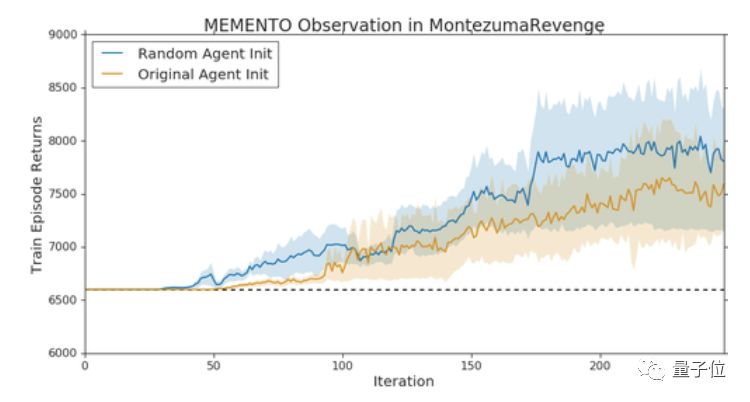

研究人员还发现,在他们提出的Memento observation中,在原始智能体遭遇瓶颈的时候,换上一只相同架构的智能体接着训练,就能取得新的突破。

单一游戏中的「灾难性干扰」

在街机学习环境(Arcade Learning Environment,ALE)中,多任务研究通常基于一个假设:一项任务对应一个游戏,多任务学习对应多个游戏或不同的游戏模式。

研究人员对这一假设产生了质疑。

单一游戏中,是否存在复合的学习目标?也就是说,是否存在这样一种干扰,让AI觉得它既要蹲着又要往前跑?

来自谷歌大脑的研究团队挑选了「蒙特祖玛的复仇」作为研究场景。

「蒙特祖玛的复仇」被认为是雅达利游戏中最难的游戏之一,奖励稀疏,目标结构复杂。

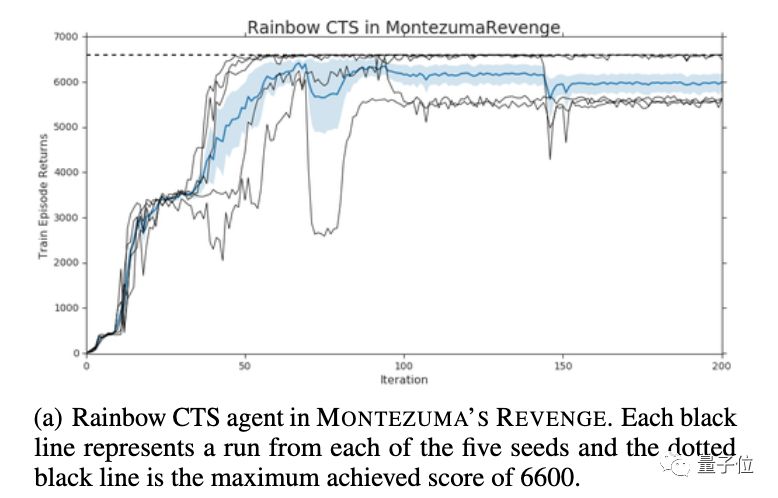

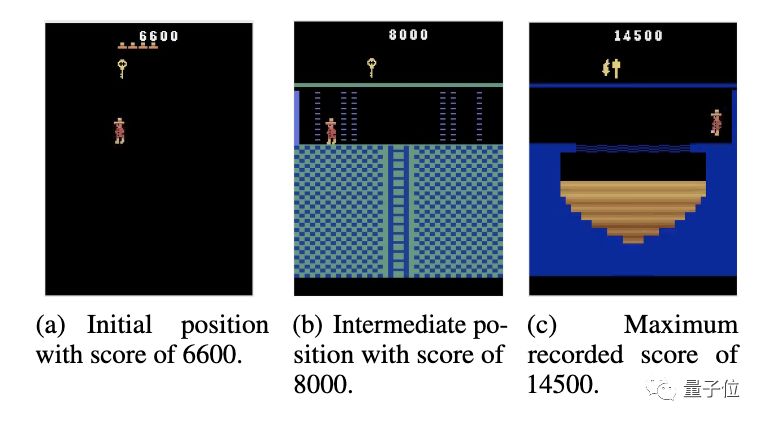

研究人员观察到,CTS模型计算的Rainbow智能体,会在6600分的时候到达瓶颈。更长时间的训练和更大的模型大小都不能有所突破。

不过,只需从这个位置开始,换上一只具有相同架构的新智能体,就能突破到8000分的水平。

如此再重置一次,AI的最高分就来到了14500分。

需要说明的是,在换上新智能体的时候,其权重设置与初始的智能体无关,学习进度和权重更新也不会影响到前一个智能体。

研究人员给这种现象起了一个名字,叫Memento observation。

Memento observation表明,探索策略不是限制AI在这个游戏中得分的主要因素。

原因是,智能体无法在不降低第一阶段游戏性能的情况下,集成新阶段游戏的信息,和在新区域中学习值函数。

也就是说,在稀疏奖励信号环境中,通过新的奖励集成的知识,可能会干扰到过去掌握的策略。

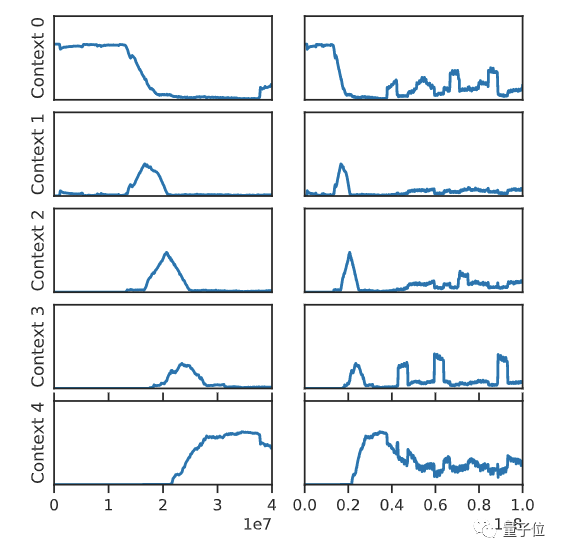

上图是整个训练过程中,对游戏的前五个环境进行采样的频率。

在训练早期(左列),因为尚未发现之后的环节,智能体总是在第一阶段进行独立训练。到了训练中期,智能体的训练开始结合上下文,这就可能会导致干扰。而到了后期,就只会在最后一个阶段对智能体进行训练,这就会导致灾难性遗忘。

并且,这种现象广泛适用。

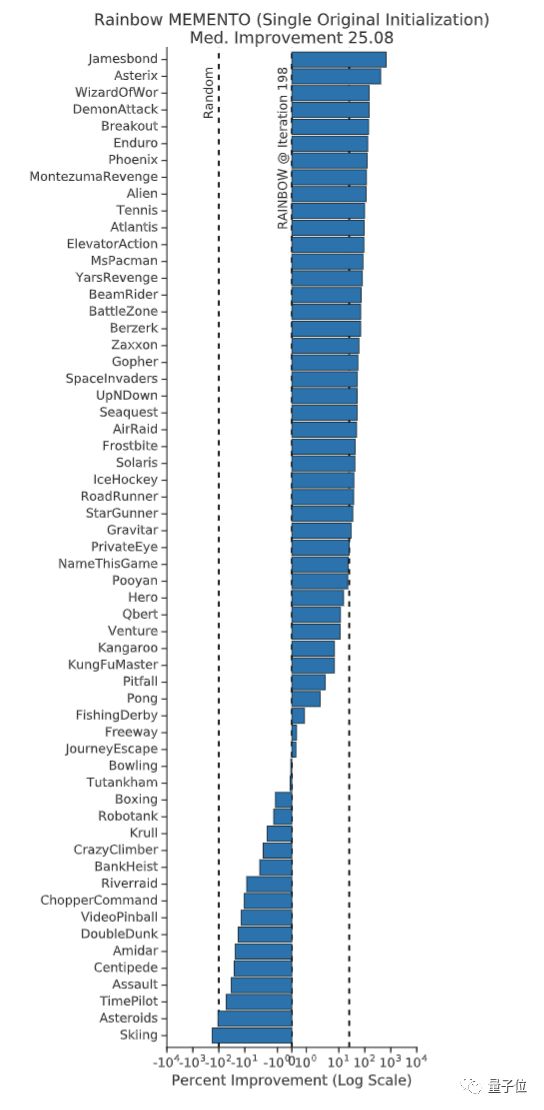

上面这张图中,每柱对应一个不同的游戏,其高度代表Rainbow Memento智能体相对于Rainbow基线增长的百分比。

在整个ALE中,Rainbow Memento智能体在75%的游戏中表现有所提升,其中性能提升的中位数是25%。

这项研究证明,在深度强化学习中,单个游戏中的AI无法持续学习,是因为存在「灾难性干扰」。

并且,这一发现还表明,先前对于「任务」构成的理解可能是存在误导的。研究人员认为,理清这些问题,将对强化学习的许多基础问题产生深远影响。

传送门

论文地址:

https://arxiv.org/abs/2002.12499

GitHub:

https://github.com/google-research/google-research/tree/master/memento

作者系网易新闻·网易号“各有态度”签约作者

— 完 —

2020年是个天文大年,4月8日有全年最大的超级月亮,6月有横跨中国的日环食,8月有英仙座流星雨,10月还有两年一次的火星冲日,12月有双子座流星雨。

我们邀请美国国家地理极致中国探享家刘允和天文爱好者们,组建了一个天文航天亲子社群,群里除了交流天文航天知识,还会组织一系列讲座、线下观星、航天探访活动。

如果你家有小朋友,也热爱天文航天,一起来玩啊:

天文航天亲子社群招募中,一起来玩吧~

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

喜欢就点「在看」吧 !