IJCAI 2022 | 使用陈述句进行视觉问答的Prompt Tuning

Declaration-based Prompt Tuning for Visual Question Answering

IJCAI 2022

论文链接:

https://arxiv.org/abs/2205.02456

简介

近年来,“预训练+微调”范式在跨模态任务中取得了巨大的成功,例如视觉问答(VQA),首先通过自监督任务(如 MLM、ITM 和 ITC)在大规模图文数据集上训练优化 visual-language pre-training 模型,再通过添加一个新的特定于任务的目标函数(如 answer prediction)进行微调以适应下游任务(如 VQA)。

然而,预训练任务目标和微调任务目标形式的不一致性(如微调 VQA 属于输入 image 和 question 的多分类任务,和预训练的任何一个任务都有很大的区别),不仅严重限制了预训练 VL 模型对下游任务的泛化,而且需要引入额外的参数和需要大量有标签数据进行微调。

1.2 方案

作者提出了一种新的 VL 微调范式(Declaration-based Prompt Tuning,简称DPT),这是第一次尝试使用陈述句进行视觉回答的 Prompt Tuning,即将下游 VQA 任务的优化目标形式重新转化为预训练阶段的形式,最大限度地缩小两个阶段之间的差距,促进预训练模型对下游任务的有效适应。

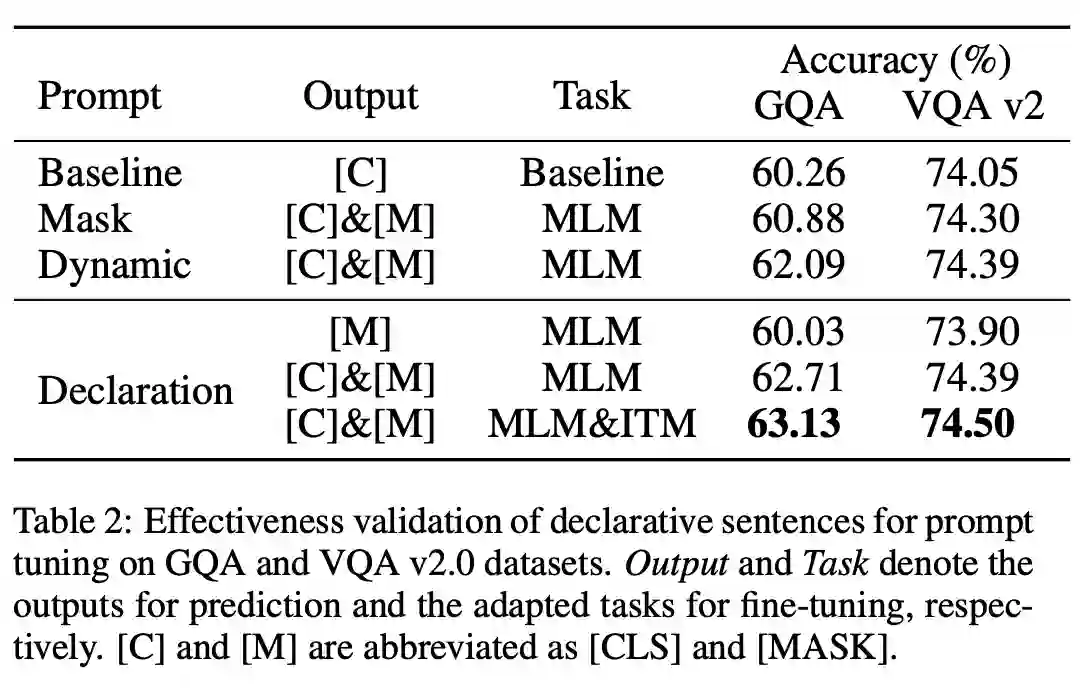

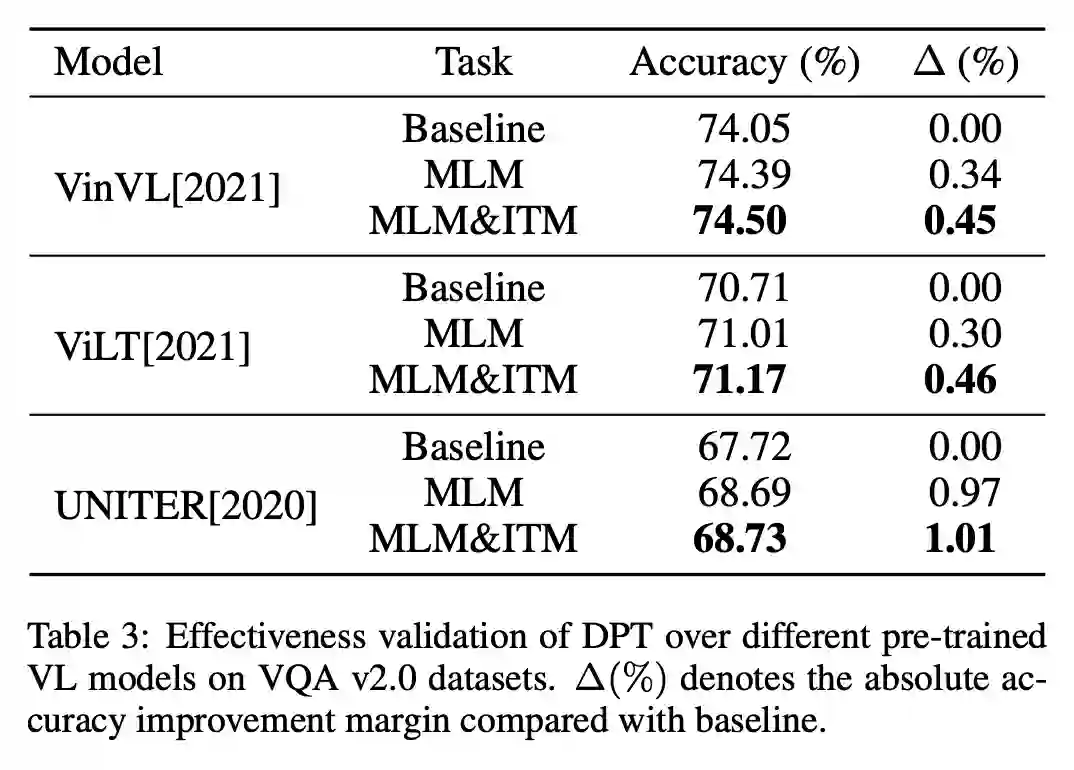

具体而言,DPT 通过:1)textual adaptation,将给定的 question 疑问句转化为陈述句形式进行 Prompt Tuning;2)task adaptation,以预训练阶段的任务目标来优化 VQA,即把 VQA 多分类任务转化为 MLM 和 ITM 任务,通过从陈述句中恢复 mask token 并选择最匹配的 image 来解决 VQA 问题的任务适应。

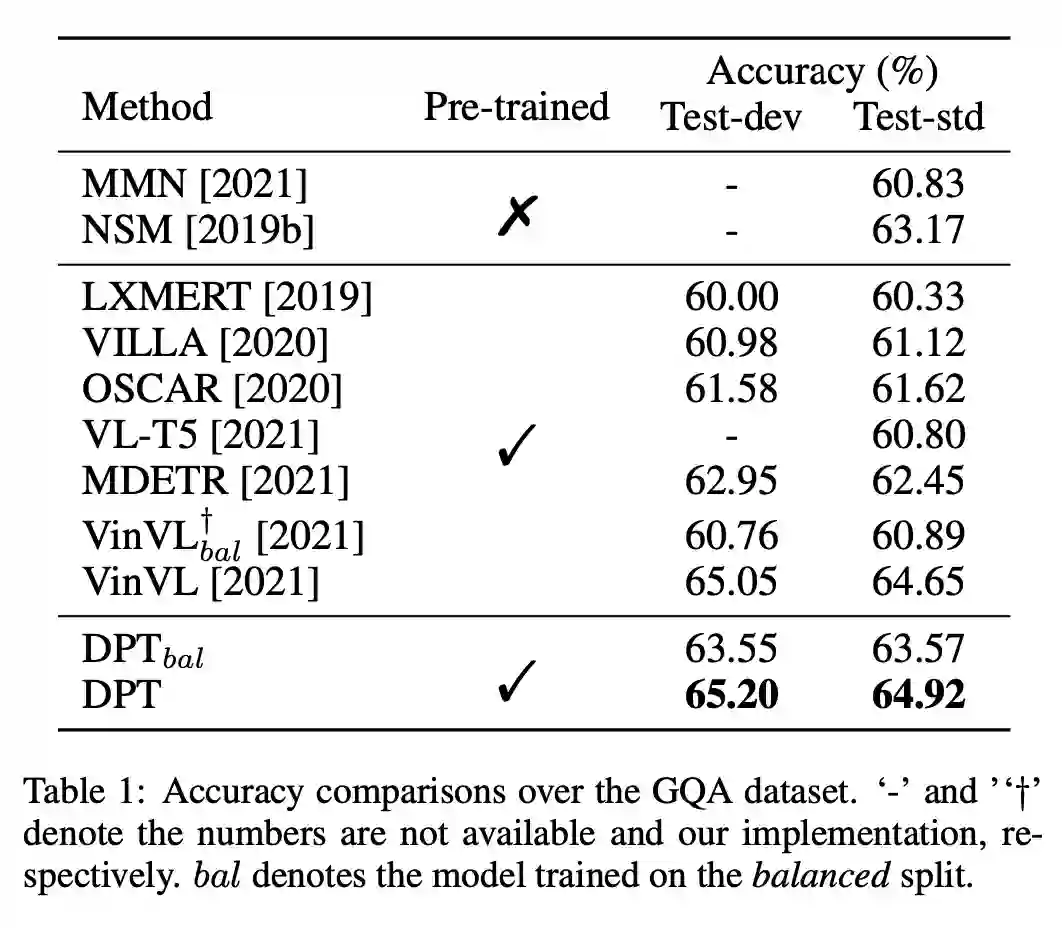

在 GQA 数据集上的实验结果表明,DPT 在 fully-supervised(2.68%)和 zero-shot/fewshot(over 31%)的准确性方面都优于其他微调方案。

相关工作

2.1 Pre-trained Vision-language Models

最近两年,针对各种下游跨模态任务训练一个通用模型的工作很多,例如 visual question answering 或 image captioning。具体而言,在预训练阶段,首先构建了一个类似 bert 的体系结构,通过各种自监督任务学习多模态表示的预训练,例如,在多模态上下文中进行的 MLM 任务或图像-文本匹配 ITM 任务。接下来,在微调阶段对预训练的模型进行微调,以适应使用完全不同的任务特定目标的下游任务,例如预测 VQA 任务的答案。

在本研究中,作者并没有引入全新的任务目标进行优化,而是尝试将 VQA 重新制定为预训练的范式,促进了预训练的 VL 模型对下游任务的有效泛化。

2.2 Cross-modal Prompt Tuning

Prompt Tuning 具有保持预训练模型优化目标与下游任务一致的能力,这使得预训练模型泛化到下游任务,只需 few/zero 样本进行微调。然而,由于 VQA 任务给定问题的语义复杂性,固定的疑问句 template 或预先设定的统一生成范式在设计合适的 Prompt 模型时可能存在不足。为了克服这一问题,本文提出了一种新的基于陈述句的 Prompt 模型,利用问题自适应陈述句作为 Prompt template,使 VQA 任务的文本格式更符合预训练阶段,缩小预训练和微调阶段之间的文本形式差距。

方法

3.1 Preliminary

给定一个在大规模图文数据集上预训练好的模型,微调 VQA 表示为输入一系列从 image 提取的 region features 和从 question 提取的 text features,将其拼接 fed to 预训练好的模型,输出的 [CLS] token通过额外的、特定于 VQA 任务的 MLP 层输出答案。

3.2 Declaration-based Prompt Tuning

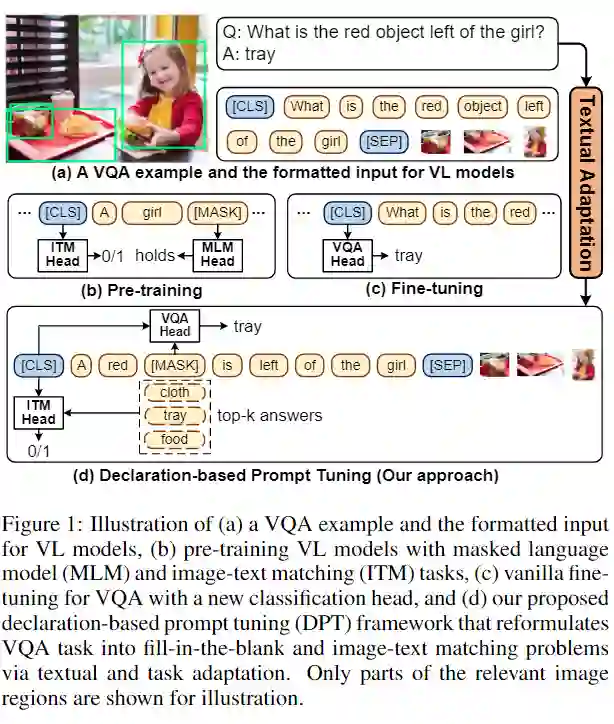

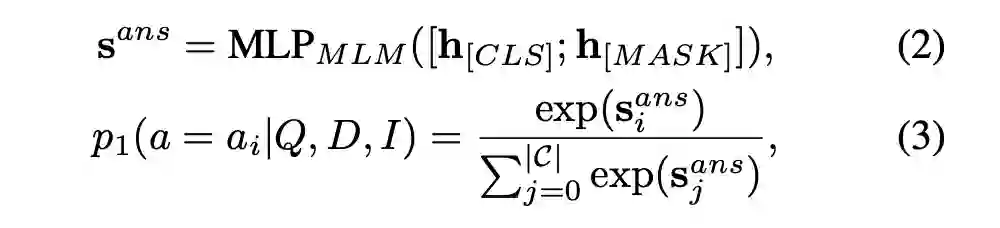

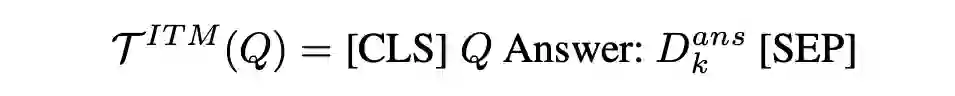

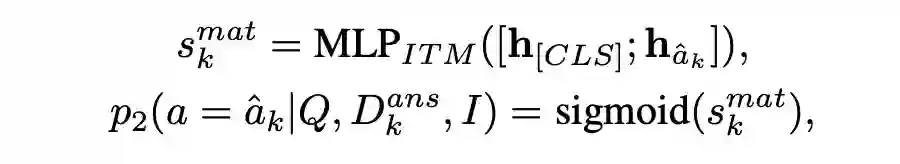

如图 1(b-d)所示,想要将微调 VQA 任务转换为预训练任务的形式,有两个挑战,一个是文本输入格式的不同(question vs declaration)和任务目标形式(MLM&ITM vs answer classification)的不同。因此,作者提出(1)Textual Adaptation,将问题转换为相应的陈述句;(2)Task Adaptation,将答案预测重新制定为 MLM 和 ITM 任务。

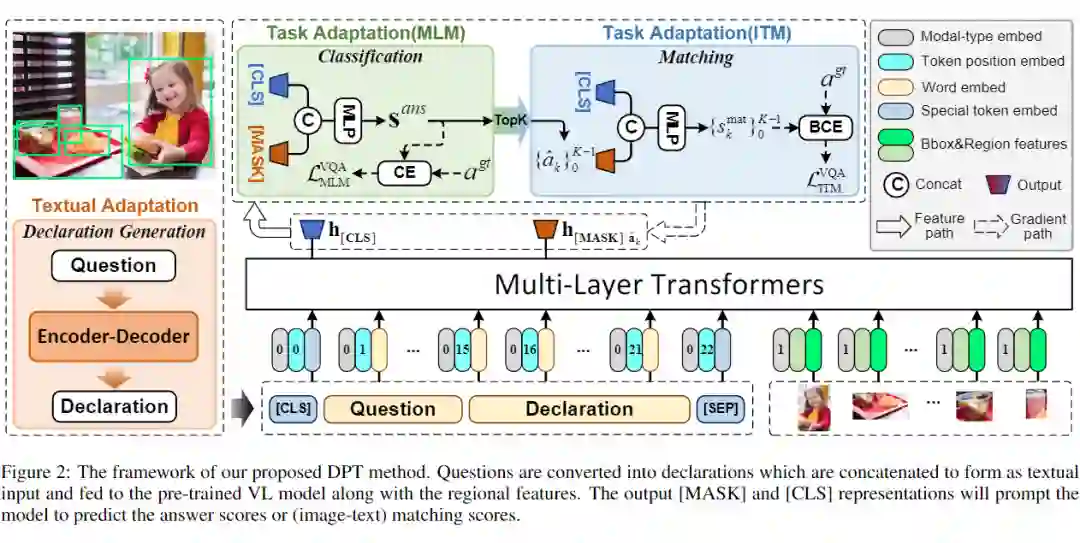

图2为整体方法架构,其中左下角 Declaration Generation 为将问题疑问句转化为陈述句的形式。最下方为 VQA 模型的输入,包含 text features 和 image region features,Multi-Layer Transformers 为预训练好的模型,如 VinVL、Oscar、VisualBert 等等,上方为 Task Adaptation,对应预训练模型的 MLM 和 ITM 任务,目的是为了预测 top-k 个候选答案,并通过图文匹配的方式选择最匹配的答案。

Textual Adaptation via Declaration Generation. Textual Adaptation 旨在将疑问句转化为陈述句,例如,“What is the red object left of the girl?” 的陈述句形式是 “A red [MASK] is left of the girl.”。为此,作者引入了陈述生成,将此过程表述为翻译问题,其中源文本和目标文本分别为问题疑问句和对应的陈述句。

首先使用来自 GQA 数据集的注释构建一个陈述句数据集,其中 “fullAnswer” 被视为陈述句,“fullAnswer” 中的 short answer word/phrase 被替换为 [MASK]。然后,在该数据集上训练 encoder-decoder 模型 T5,并使用 auto-regressive cross-entropy 进行优化。最后,该模型可用于将各种 VQA 数据集的问题疑问句转换为陈述句。

实验

Datasets. GQA,VQA v2.0

总结

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编