EMNLP 2020即将召开,中国学者最高产:单人9篇主会论文!

今晚开始,EMNLP 2020就将于线上召开啦!(11月16日-11月20日)

与此同时,在全球范围内,邴立东博士同清华大学刘知远、Salesforce AI的 Xiong Caiming 并列为本次大会最高产作者,同时,哈工大刘挺教授此次也有7篇主会论文入选。

以下AI科技评论对这四位作者本次EMNLP 2020 论文录取情况做简单介绍。

达摩院邴立东

邴立东博士目前在达摩院自然语言智能实验室,他于香港中文大学获得博士学位,曾是卡耐基梅隆大学机器学习博士后研究员。他的研究兴趣包括低资源自然语言处理、情感分析、文本生成/摘要、信息提取、知识库等。

个人主页:https://lidongbing.github.io/

邴立东博士团队主导的8篇投稿论文,实现了100%录取率(大会主会平均录取率为22.4%)。

入选的论文集中于四个领域,包括论辩挖掘及情感分析(Argument & Sentiment)、低资源命名体识别(Low-resource NER)、表示学习及应用(Representation Learning & Application)、文本生成(Text Generation),在任务、数据、方法和模型上有显著的贡献。

比如,新任务包括:论辩对挖掘、知识库增强的实体描述生成,两个任务均提供了新数据集。

新方法/模型包括:基于生成的数据增强、无监督句子表示学习、动态轻量图神经网络、跨语言跨领域的预训练特征迁移、端到端的细粒度情感三元组抽取。

论辩对挖掘任务:邴博士团队首次提出了从构成辩论关系的两篇文档中,抽取论辩对的任务。现有论辩挖掘的任务是基于单一文本进行抽取,如法律文件、论文等。辩论对挖掘任务第一次探索从两篇文档中,挖掘互相构成论辩关系的文本片段。举例来讲,司法诉讼中的起诉状和答辩状构成一个文档对,论辩对挖掘技术可以从起诉状中抽取原告观点,从答辩状中识别被告的答辩。作者公开了一个大规模的数据集,包括5000+个文档对,和全部文档对内的论辩对标注。

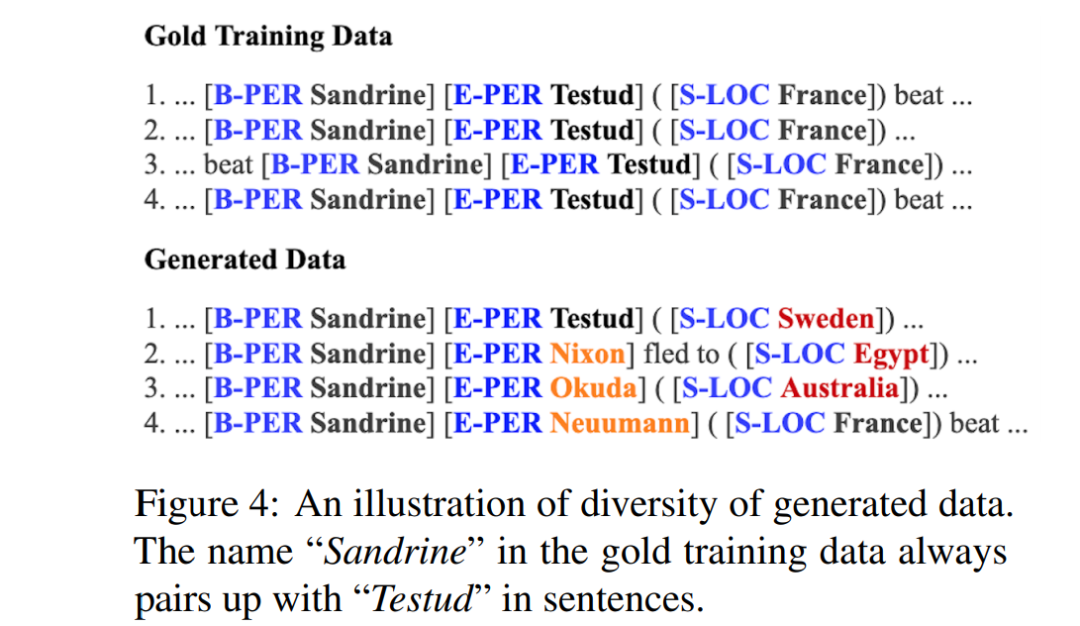

基于生成的数据增强:提出了一种全新的 NLP 数据增强技术,可以应用于各种序列标注任务。相比于计算机视觉和语音,在自然语言处理的序列标注任务上,当前并没有有效的数据增强技术,以往提出的同义词替换等方法过于简单且效果不佳。而其他的数据增强方法如反向翻译等仅适用于翻译或者分类任务,并不适用于序列标注任务。

邴博士团队提出的基于语言模型的数据增强方法,先对原有的序列标注数据进行线性化,把文本数据和序列标注转化为语言模型的训练数据,再通过训练好的语言模型,生成更多的可用于序列标注训练的数据,以此达到数据增强的目的。

以下是邴立东博士团队所有主会录取论文:

清华大学刘知远

刘知远是清华大学计算机科学与技术系长聘副教授。他分别于2006年和2011年从清华大学计算机科学与技术系获得工学学士学位和博士学位。他的研究兴趣包括自然语言处理与社会计算。他已经在国际期刊与会议上发表了超过90篇论文,包括ACM Transactions、IJCAI、AAAI、ACL和EMNLP等 。

个人主页:http://nlp.csai.tsinghua.edu.cn/~lzy/

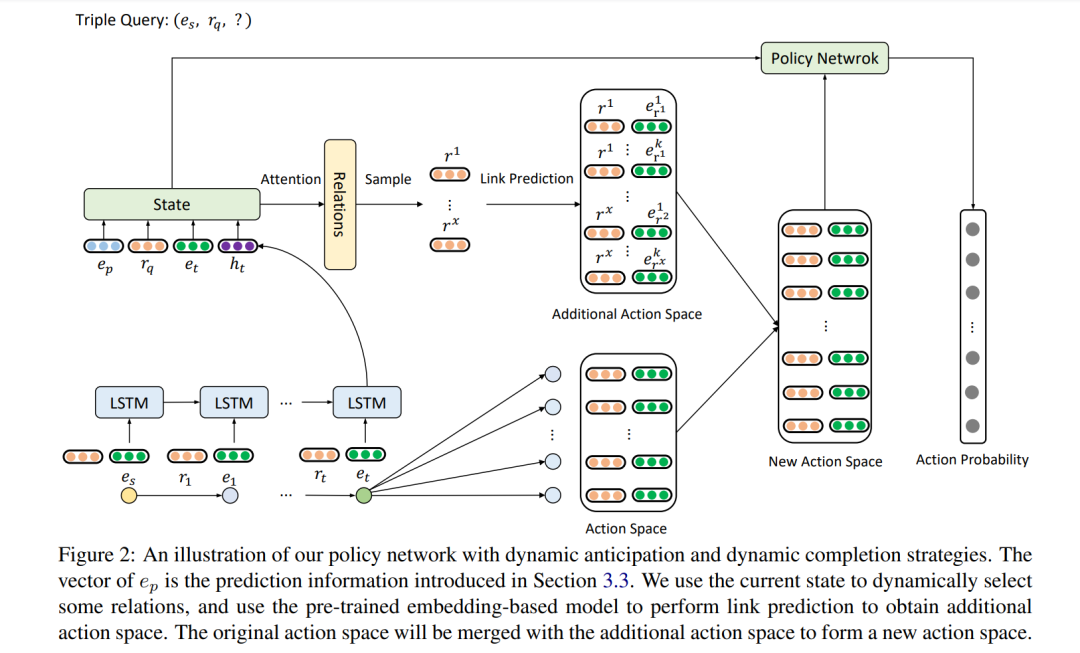

以下介绍其中一篇题为《Dynamic Anticipation and Completion for Multi-Hop Reasoning over Sparse Knowledge Graph》 的论文。

Xiong Caiming

哈工大刘挺

刘挺,哈尔滨工业大学教授,现任哈工大计算学部主任兼计算机学院院长,国家“万人计划”科技创新领军人才 。中国计算机学会理事,中国中文信息学会常务理事/社会媒体处理专委会(SMP)主任 ,曾任国际顶级会议ACL、EMNLP领域主席。

主要研究方向为人工智能、自然语言处理和社会计算。2012-2017年在自然语言处理领域顶级会议发表的论文数量列世界第8位(据剑桥大学统计)。

大会展望

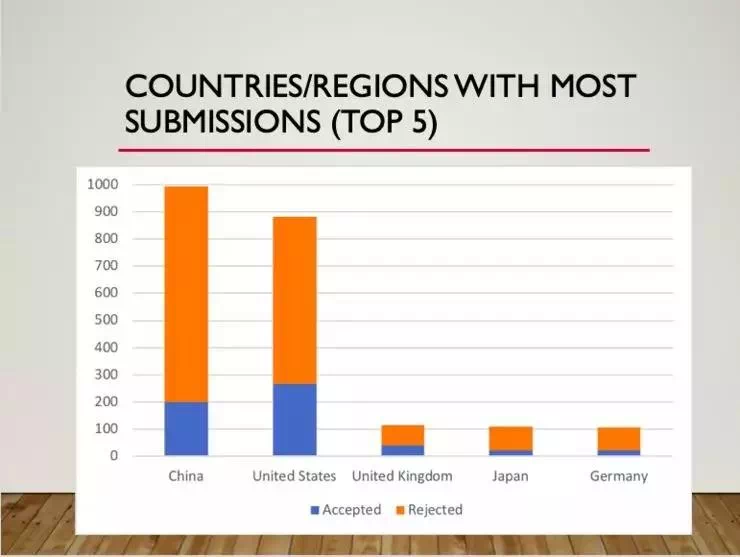

首先回顾一下EMNLP-IJCLPN 2019年录取情况:

在ACM MM 2020上,南开大学获得最佳论文奖,西安交大获最佳学生论文奖。

点击阅读原文,直达EMNLP小组!