【ACL2019】深度贝叶斯自然语言处理,304页ppt带你了解最新研究进展

【导读】本文为大家带来了ACL2019的最新教程,全面介绍深度贝叶斯方法在自然语言处理领域的应用。

介绍:

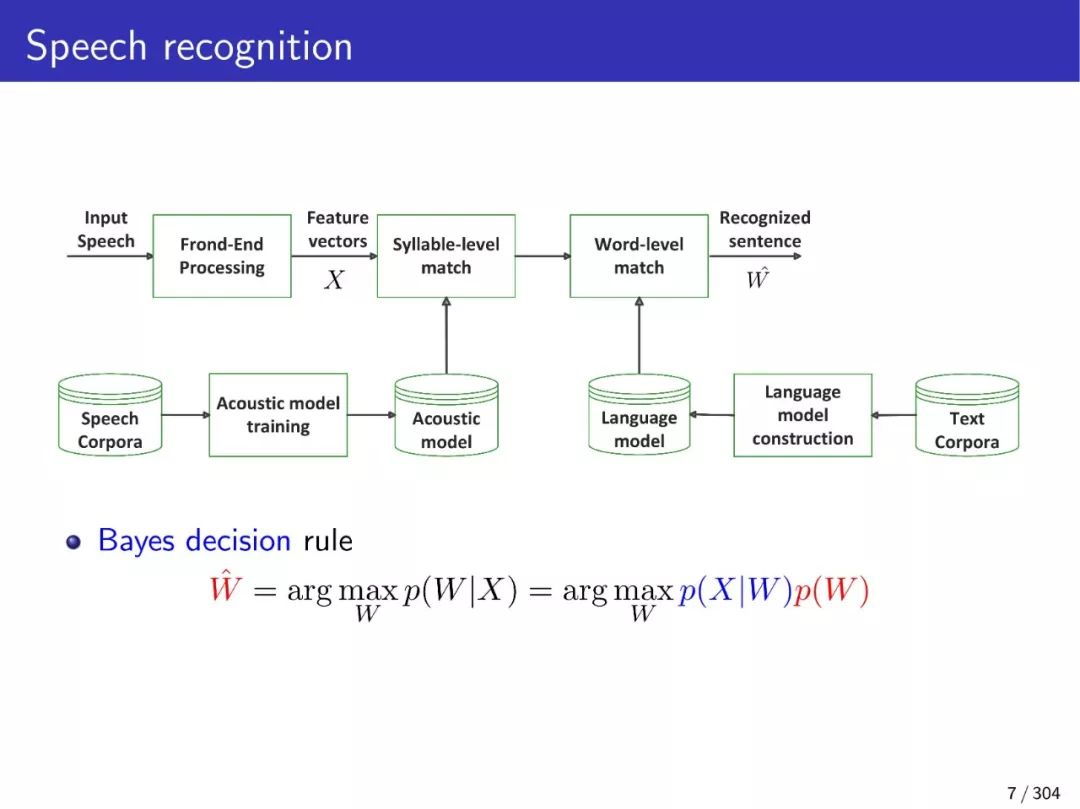

本入门教程介绍了NLP深度贝叶斯学习的最新研究进展,此类进展可应用于:语音识别、文本摘要、文本分类、文本分割、信息提取、图片标题生产、句子生成、对话控制、情感分类、推荐系统等问题中。从传统上说,“深度学习”被认为是一种学习的过程,其中的推理或优化环节,是通过real-valued deterministic模型实现的。从大型词表中提取出的单词、句子、实体、动作等语义结构,难以在数学或计算机程序中得到很好的表达。用于NLP的离散或连续隐变量模型中的“分布函数”可能无法被适当地分解或估计。

本教程将介绍统计模型与神经网络的基础知识,重点介绍一系列先进的贝叶斯模型和深层模型,包括层次Dirichlet过程、chinese restaurant process、 hierarchical Pitman-Yor process、Indian buffer process、循环神经网络、长短期记忆模型、seq2seq模型、变分自编码器、生成式对抗网络、注意力机制、增强记忆神经网络、skip神经网络、随机神经网络、策略神经网络和马尔可夫递归神经网络。我们将介绍这些模型的连接方式,以及为什么它们适用于自然语言中符号和复杂模式的各种应用。最后介绍了一系列的案例研究,以解决深度贝叶斯学习中的不同问题。最后,我们将指出未来研究的一些方向和展望。

请关注专知公众号(点击上方蓝色专知关注)

后台回复“ACL2019DBNLP” 就可以获取《深度贝叶斯自然语言处理》的下载链接~

教程大纲:

介绍

背景与动机

概率模型

神经网络

贝叶斯学习

推断与优化

变分贝叶斯推断

蒙特卡洛马尔可夫链推断

贝叶斯非参

层次主题模型

Nested Indian buffet process

深度序列学习

deep unfolded主题模型

门式递归神经网络

贝叶斯递归神经网络

记忆增强神经网络

seq2seq学习

卷积神经网络

扩大神经网络

注意力网络与transformer

深度贝叶斯序列学习

变分自编码器

变分递归自编码器

层次变分自编码器

随机递归神经网络

正规递归神经网络

skip递归神经网络

马尔可夫递归神经网络

时序差分变分自编码器

未来的挑战以及优势

附PPT内容预览:

更多精彩内容,请关注公众号下载观看!

-END-

专 · 知

专知,专业可信的人工智能知识分发,让认知协作更快更好!欢迎登录www.zhuanzhi.ai,注册登录专知,获取更多AI知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程视频资料和与专家交流咨询!

请加专知小助手微信(扫一扫如下二维码添加),加入专知人工智能主题群,咨询技术商务合作~

专知《深度学习:算法到实战》课程全部完成!560+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程