AAAI2019教程抢先看!《深度贝叶斯与序列学习》,279页PPT带你知晓深度贝叶斯序列模型在NLP最新进展

【导读】人工智能领域的国际顶级会议 AAAI 2019 即将于 1 月 27 日至 2 月 1 日在美国夏威夷举行。大会一项很重要的内容就是来自世界研究学者给出的关于各方面研究主题的最新Tutorial,是了解最新进展的非常好的材料。来自台湾国立交通大学给了深度贝叶斯与序列学习的报告《 Deep Bayesian and Sequential Learning》,共279页PPT,包含深度贝叶斯学习与深度序列学习等,是非常好的关于深度贝叶斯序列学习教程。

深度贝叶斯与序列学习

网址:

http://chien.cm.nctu.edu.tw/home/aaai-tutorial/

摘要:

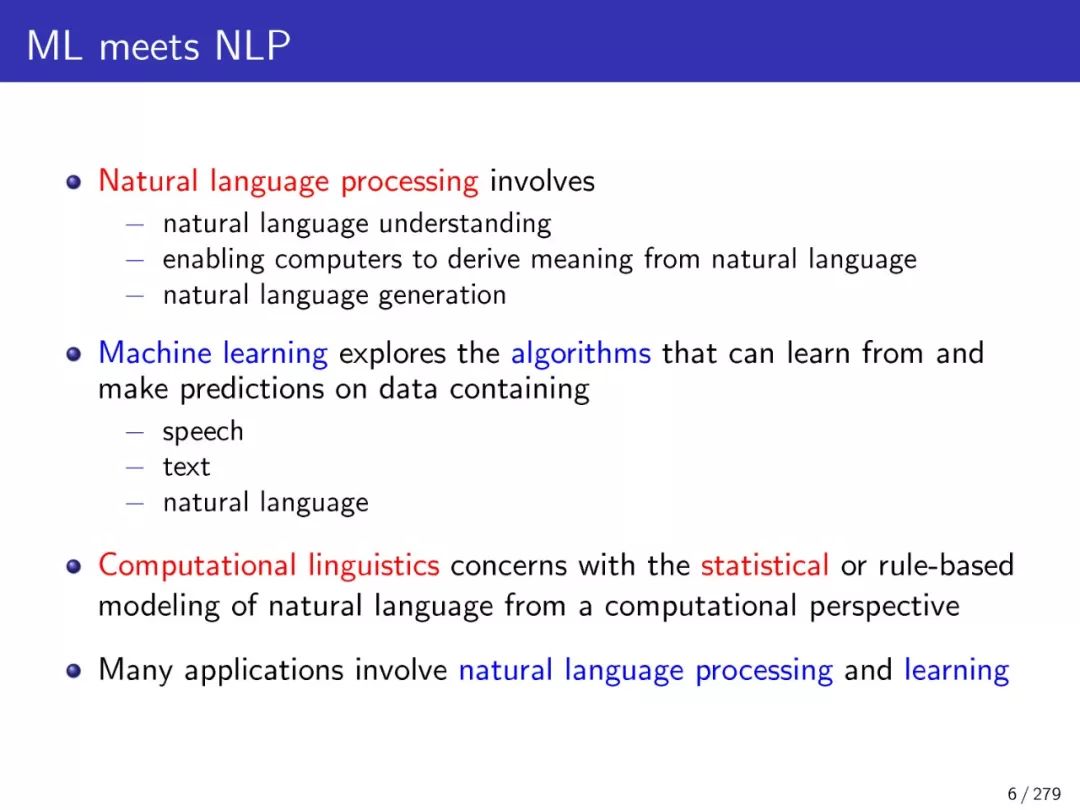

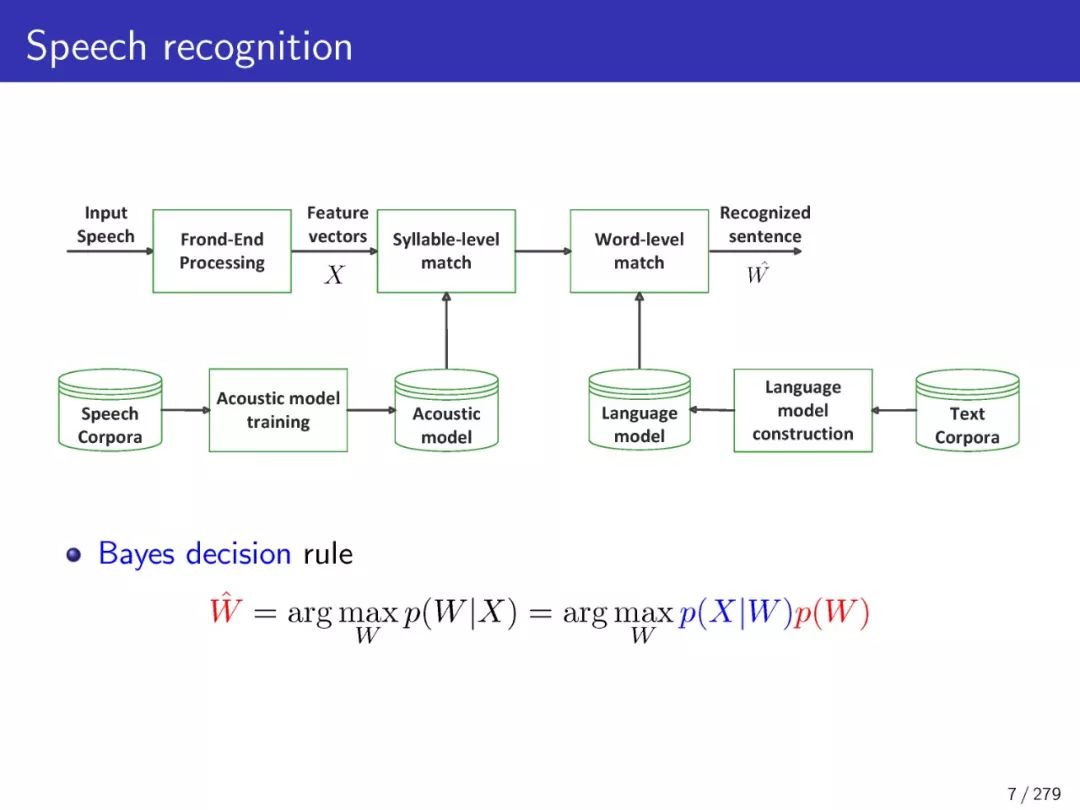

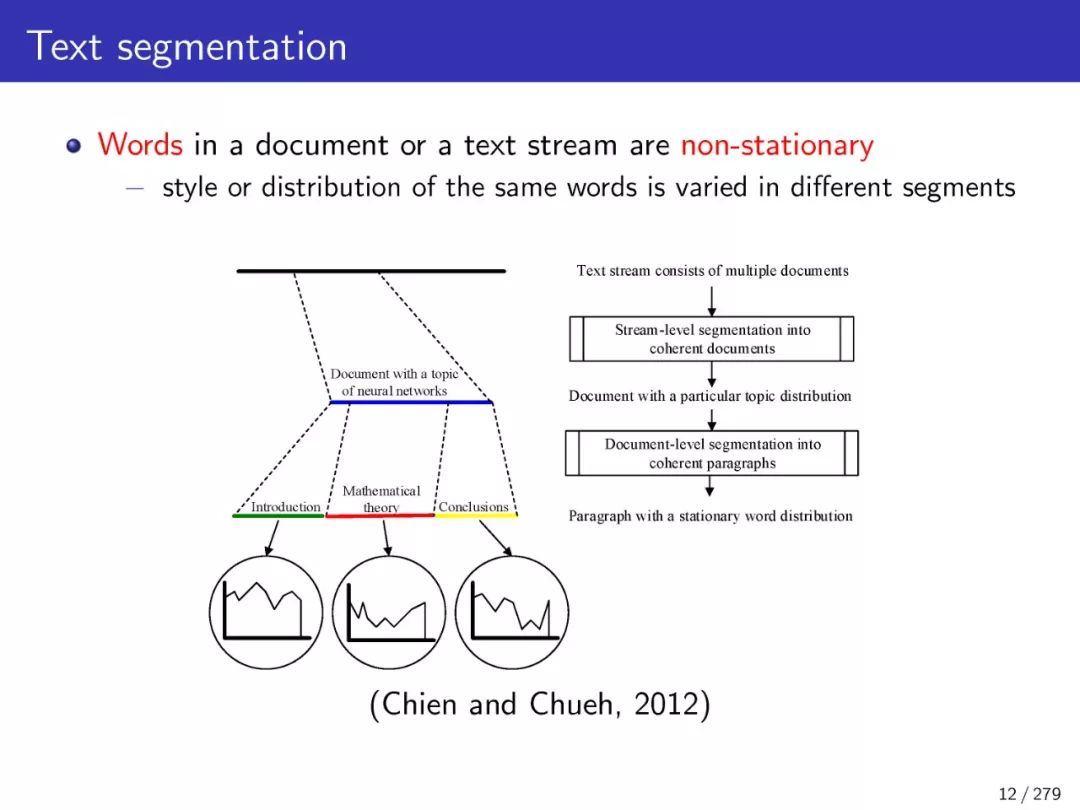

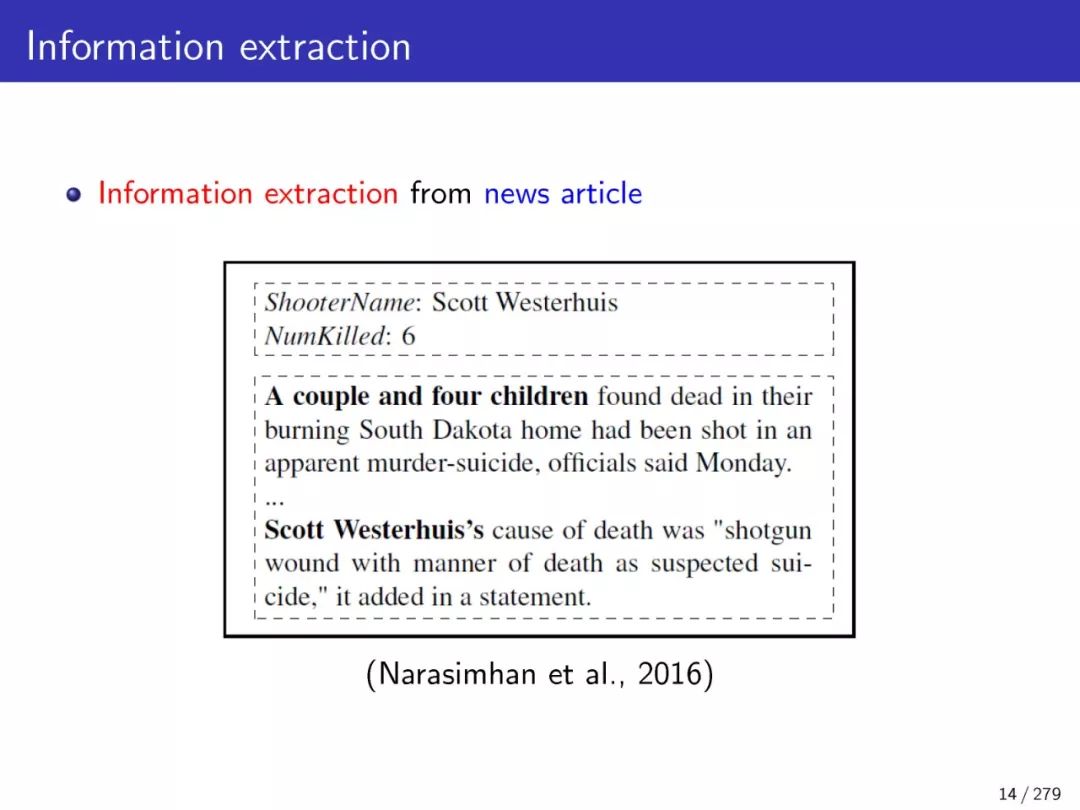

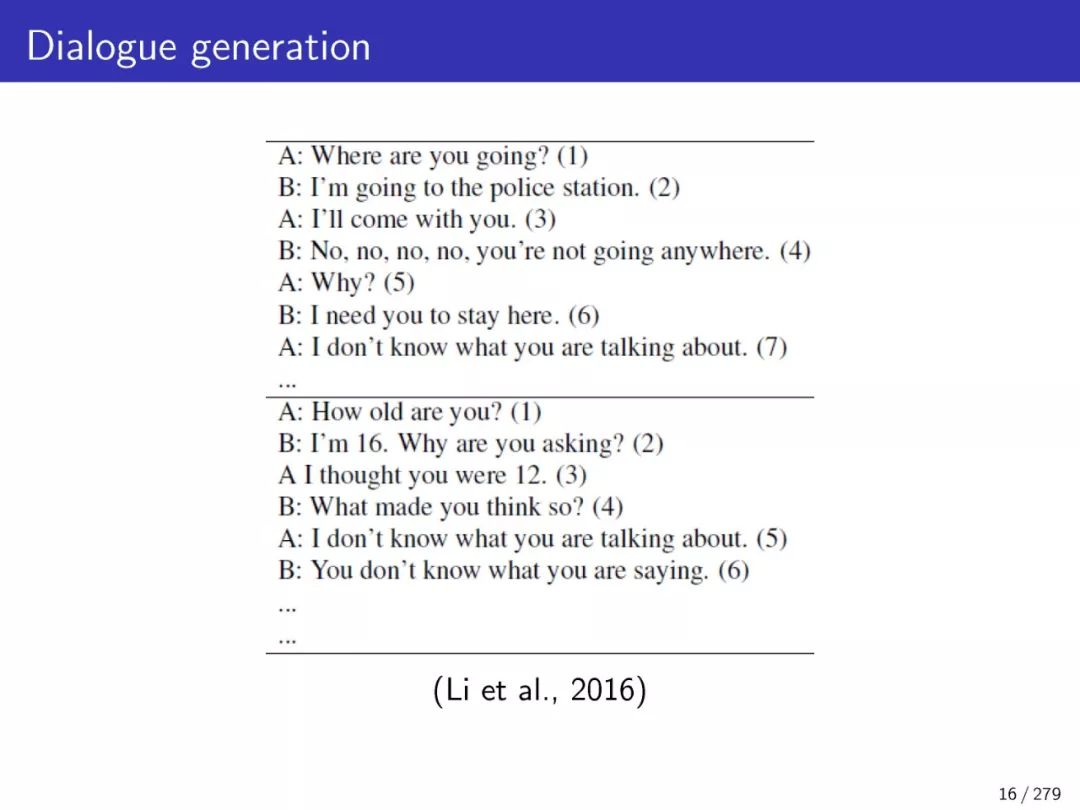

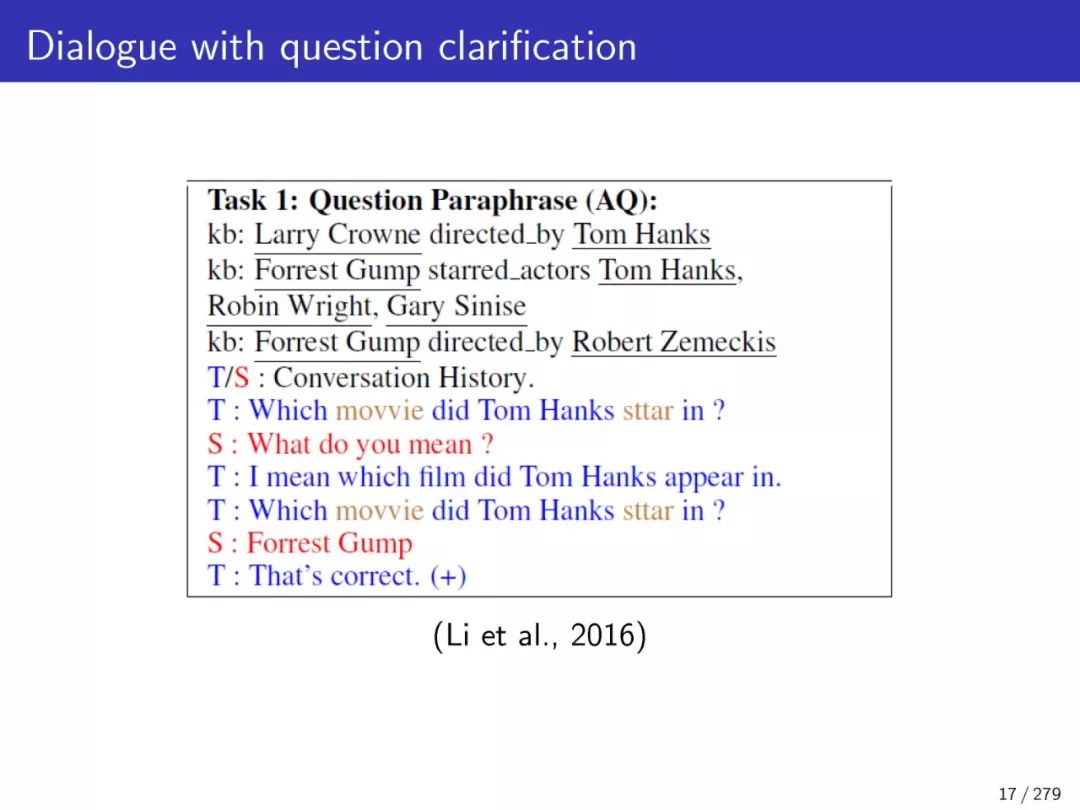

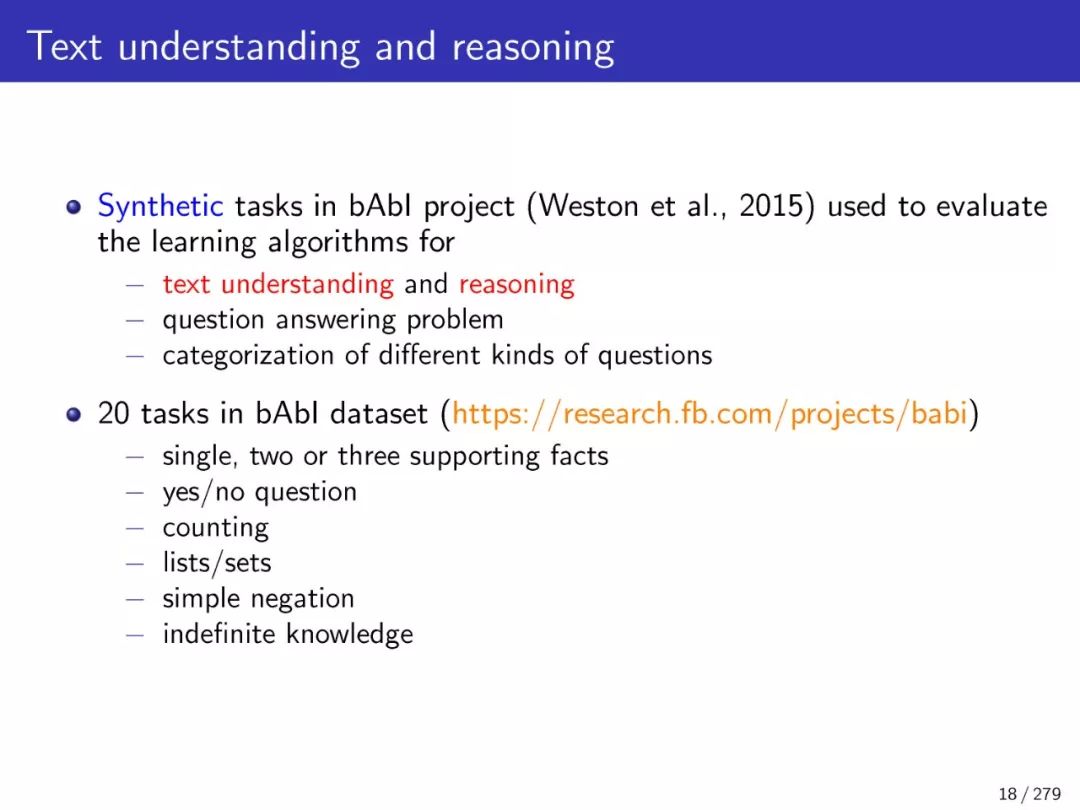

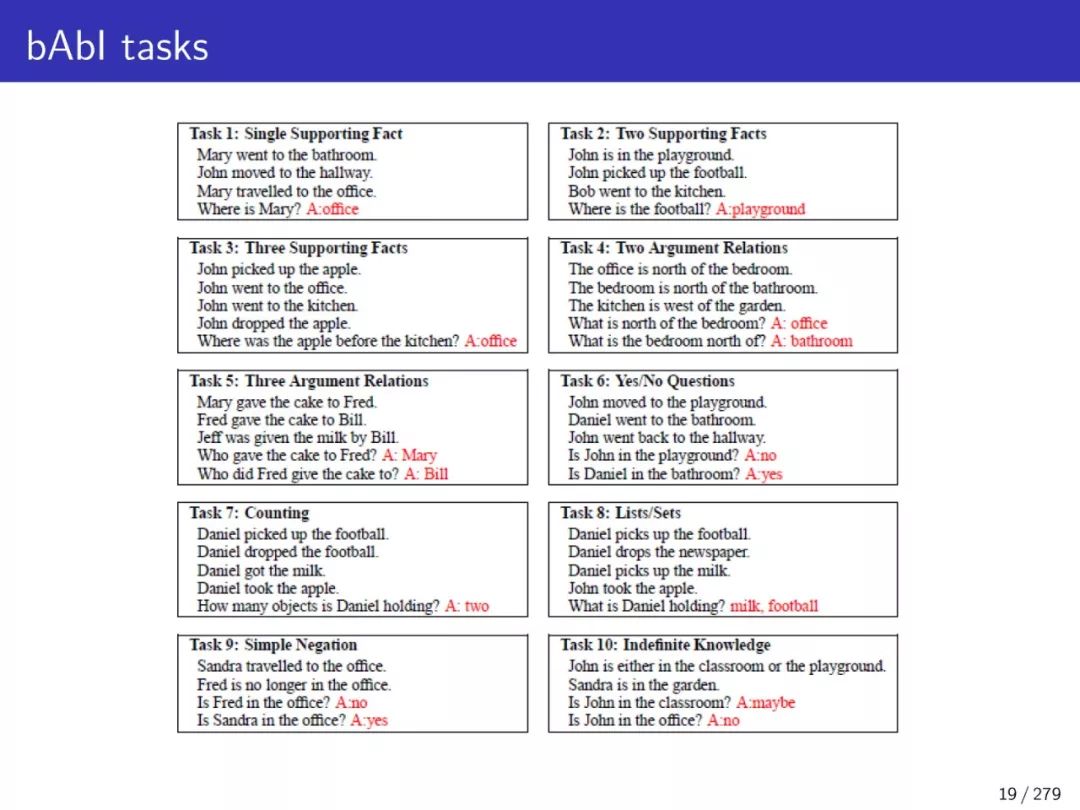

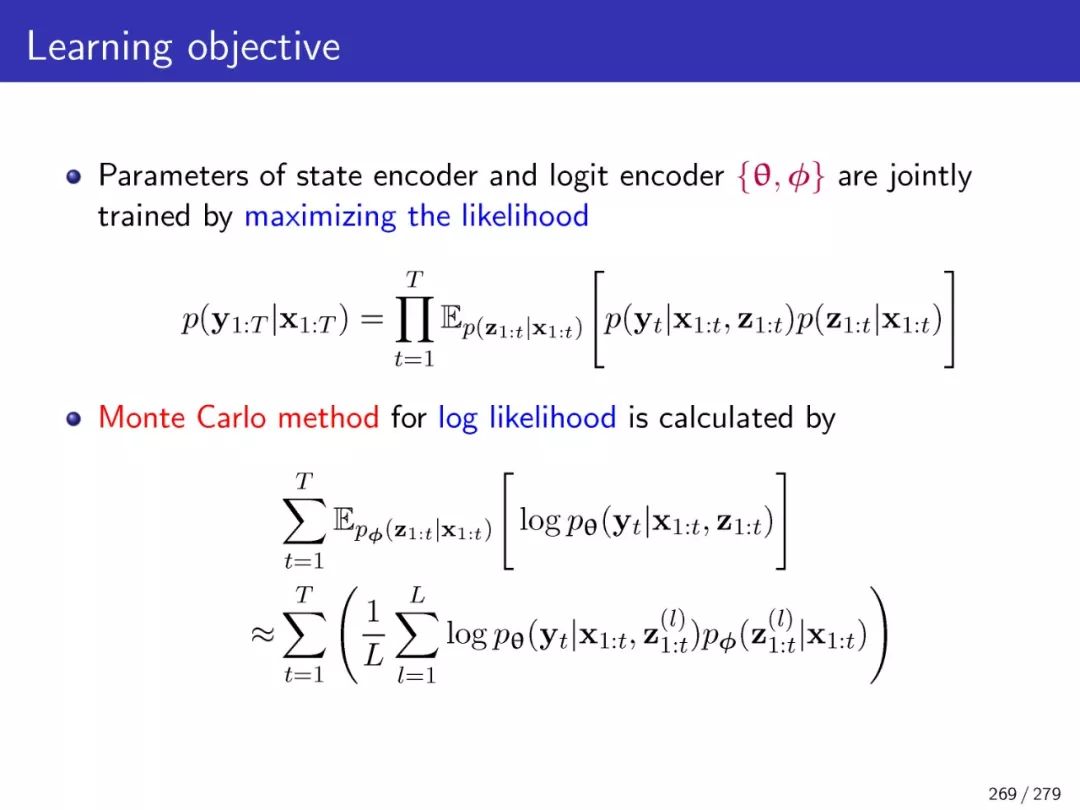

本教程介绍自然语言的深度贝叶斯和序列学习的进展,其广泛在语音识别、文档摘要、文本分类、文本分割、信息提取、图像标题生成、句子生成、对话控制、情感分类、推荐系统、问答和机器翻译等。传统上,“深度学习”被认为是基于实值判别模型进行推理或优化的学习过程。从大量词汇表中抽取的单词、句子、实体、动作和文档中的“语义结构”,在数理逻辑或计算机程序中可能不能很好地表达或正确地优化。自然语言的离散或连续潜在变量模型中的“分布函数”在模型推理中可能无法正确分解或估计。本教程介绍统计模型和神经网络的基本原理,并专注于一系列先进的贝叶斯模型和深度模型包括分层狄利克雷的过程,中国餐馆的过程,层次Pitman-Yor过程,印度自助过程,递归神经网络,长期短期记忆,sequence-to-sequence模型、变分auto-encoder,生成对抗网络,注意机制,memory-augmented神经网络、随机神经网络,预测状态神经网络、策略梯度和强化学习。我们将介绍这些模型是如何连接的,以及它们为什么适用于自然语言中符号和复杂模式的各种应用程序。针对复杂模型的优化问题,提出了变分推理和抽样方法。词语和句子的嵌入、聚类和共聚类与语言和语义约束相结合。针对深度贝叶斯学习和理解中的不同问题,提出了一系列的案例研究。最后,我们将指出一些未来研究的方向和展望。

【教程下载】

请关注专知公众号(点击上方蓝色专知关注)

后台回复“DBSL” 就可以获取《深度贝叶斯与序列学习》教程的下载链接~

专知2019年《深度学习:算法到实战》精品课程,欢迎扫码报名学习!

教程结构:

本教程的演示分为五个部分。首先,我们分享了自然语言处理、统计建模和深度神经网络的研究现状,并解释了离散值观测和潜在语义深度贝叶斯学习的关键问题。现代自然语言模型用于从语言处理到语义学习和记忆网络的数据分析。其次,我们介绍一些贝叶斯模型,从自然语言中推断出层次、主题和稀疏主题。第三部分介绍了深度展开、贝叶斯递归神经网络、序列到序列学习、卷积神经网络、生成对抗网络和变分自编码器等一系列深度模型。第四部分阐述了深度贝叶斯学习是如何扩展来推断自然语言理解的递归和扩展神经网络的。特别是在语音识别、阅读理解、句子生成、对话系统、问答和机器翻译等实际任务中引入了记忆网络、神经变分学习和马尔科夫神经网络。最后,我们重点讨论了大数据、异构条件和动态系统的未来发展方向和面临的挑战。特别强调深度学习、结构学习、时空建模、长历史表示和随机学习。

-END-

专 · 知

专知《深度学习:算法到实战》课程全部完成!460+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

请加专知小助手微信(扫一扫如下二维码添加),咨询《深度学习:算法到实战》参团限时优惠报名~

欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程