论文浅尝 | Seq2Seq 知识图谱补全与问答

笔记整理:李行,天津大学硕士

论文题目:Sequence-to-Sequence Knowledge Graph Completion and Question Answering

链接:https://arxiv.org/pdf/2203.10321.pdf

动机

知识图嵌入 (KGE) 模型用低维嵌入向量表示知识图 (KG) 的每个实体和关系。这些方法最近已应用于知识图谱链接预测和不完整知识图谱 (KGQA) 上的问答。KGE 通常为图中的每个实体创建一个嵌入,这会导致在具有数百万个实体的真实世界图上产生大型模型。对于下游任务,这些原子实体表示通常需要集成到多级管道中,从而限制了它们的实用性。现成的编码器-解码器 Transformer 模型可以用作可扩展且通用的 KGE 模型,为 KG 链接预测和不完整的 KG 问答获得最先进的结果。本文提出了KGT5,将 KG 链接预测作为序列到序列的任务,并将先前 KGE 方法采用的三重评分方法与自回归解码进行交换,与传统的 KGE 模型相比,这种简单但功能强大的方法可将模型大小减少多达 98%,同时保持推理时间的可控性。在针对不完整 KG 的 KGQA 任务对该模型进行微调后,该方法在多个大规模数据集上的性能优于基线,而无需进行广泛的超参数调整。

亮点

KGT5的亮点主要包括:

1.将 KG 链接预测和问答可以被视为序列到序列的任务。2.使用KGT5 方法,将 KG 链接预测的模型大小减少了 98%,同时在具有 90M 实体的数据集上优于传统的 KGE。3.通过 KGQA 对不完整图的任务展示了KGT5的多功能性。

概念及模型

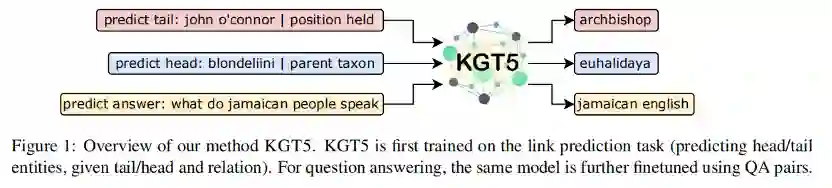

KGT5 首先在链接预测任务上进行训练(预测头/尾实体,给定尾/头和关系)。对于问答,使用 QA 对进一步微调相同的模型。方法的概述图如下:

在进行问答训练时,使用链接预测目标进行规范化。KGT5产生了一个可扩展的 KG 链接预测模型,其参数比用于大型 KG 的传统 KGE 模型少得多。KGT5赋予模型简单性和多功能性,因此无论问题复杂性如何,它都可以轻松地适应任何数据集上的 KGQA。

将 KG 链接预测作为 seq2seq 任务需要两个步骤:

•Text mapping:对于链接预测,需要在实体/关系及其文本表示之间进行一对一的映射。•Verbalization:通过语言化将 (s, p, ?) 查询回答转换为序列到序列的任务查询 (s, p, ?) 到文本表示。

•训练KGT5进行链接预测

为了训练 KGT5,需要一组(input, output)序列。对于训练图中的每个三元组 (s, p, o),对查询 (s, p, ?) 和 (?, p, o) 进行表述,以获得两个输入序列。相应的输出序列分别是 o 和 s 的文本提及。KGT5 使用teacher forcing和交叉熵损失进行训练。需要注意,实验在没有显式负采样的情况下进行训练。 在解码的每一步,模型都会生成可能的下一个标记的概率分布。在训练时,该分布因与“真实”分布不同(即,真正的下一个令牌的概率为 1,所有其他令牌的概率为 0)而受到惩罚,使用交叉熵损失。除了不是针对所有其他实体对真实实体进行评分,在每一步都针对所有其他令牌对真实令牌进行评分,并且该过程重复的次数与标记化真实实体的长度一样多。这避免了对许多负样本的需求,并且与实体的数量无关。

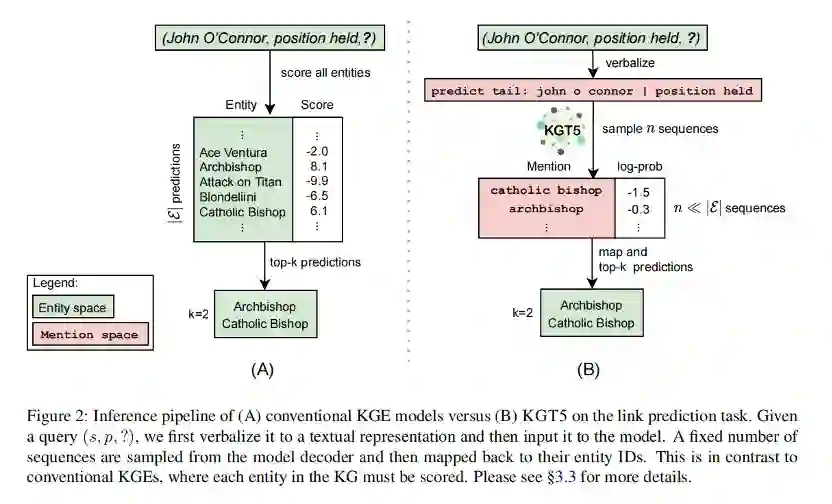

•链接预测推理

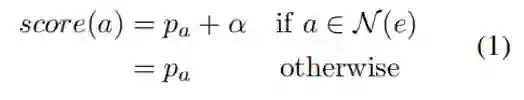

在传统的 KGE 模型中,通过找到分数 来回答查询 (s, p, ?),其中 f 是特定于模型的评分函数。然后根据分数对实体 o 进行排名。在KGT5中,给定查询 (s, p, ?),首先将其进行描述,然后再将其提供给 KGT5。然后,从解码器中采样固定数量的序列,然后将其映射到它们的实体 ID。通过使用这样的生成模型,能够近似(以高置信度)top-m 模型预测,而无需对所有模型进行评分KG 中的实体,正如传统的 KGE 模型所做的那样。对于每个解码的实体,为其分配一个等于解码其序列的(log)概率的分数。

其中 α 是一个常数超参数,N (e) 是主题实体的 n 跳邻域(n = 1、2 或 3)。

这产生了一组(entity, score)对。为了计算与传统 KGE 模型相当的最终排名指标,作者为在采样过程中未遇到的所有实体分配一个无穷小的分数。

传统KGE模型与KGT5的推理策略对比如图所示。

•KGQA训练和推理

对于 KGQA,使用链接预测任务在背景 KG 上预训练模型。这种预训练策略类似于其他 KGQA 工作中使用的“KGE 模块训练”。然后对相同的模型进行微调以进行问答。因此,采用与 Roberts 等人相同的策略将一个新的任务前缀(预测答案:)与输入问题连接起来,并将答案实体的提及字符串定义为输出。 这种统一的方法允许将 KGT5 应用于任何 KGQA 数据集,而不管问题的复杂性如何,并且不需要实体链接等子模块。

为了在 QA 微调过程中对抗过拟合(尤其是在具有小 KG 的任务上),作者设计了一种正则化方案:将从背景 KG 随机采样的链接预测序列添加到每个批次中,这样一个批次由相同数量的 QA 和链接预测序列组成。对于推理,使用波束搜索,然后使用基于邻域的重新排序来获得模型的预测,这是一个单一的答案。

理论分析

实验

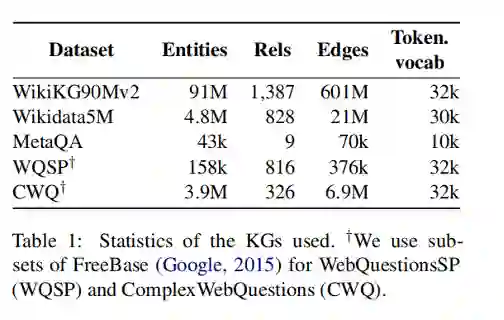

作者采用了5个数据集进行实验,分别是:WikiKG90Mv2、Wikidata5M、MetaQA、WQSP、CWQ,其中前两个数据集用来评估KGT5的链接预测能力,后三个数据集用来评估其QA能力。

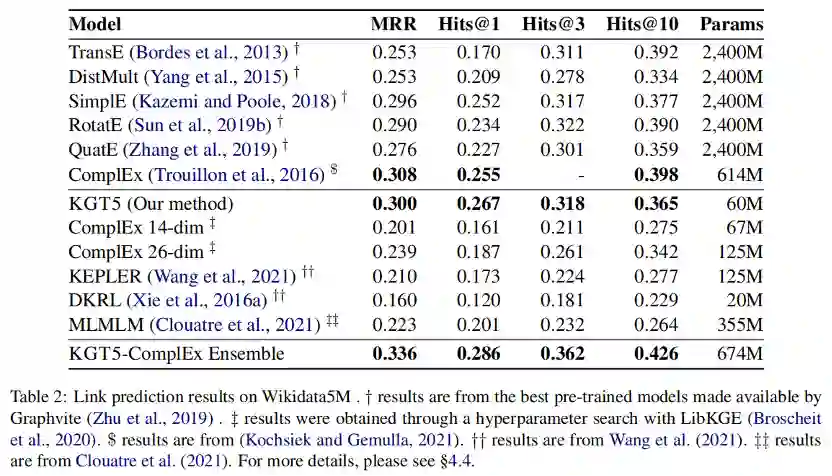

下图显示了 Wikidata5M 上的链接预测性能,这是一个更小但研究得更好的 KG。可以看到 KGT5 在所有指标上都优于所有低参数计数模型。与大型 ComplEx 模型相比,MRR 下降了 0.008 点,而 hits@1 则增加了 0.012 点。

作者根据 Wikidata5M 的查询类型对模型预测进行了更细粒度的分析,创建了一个 ComplEx 和 KGT5 的集合,它按如下方式回答查询:如果查询在训练 KG 中没有答案,则使用 KGT5;否则使用 ComplEx (614M)。上图所示,由这个简单的规则创建的集成优于所有其他单一模型,并在 Wikidata5M 上达到了 state-of-theart。

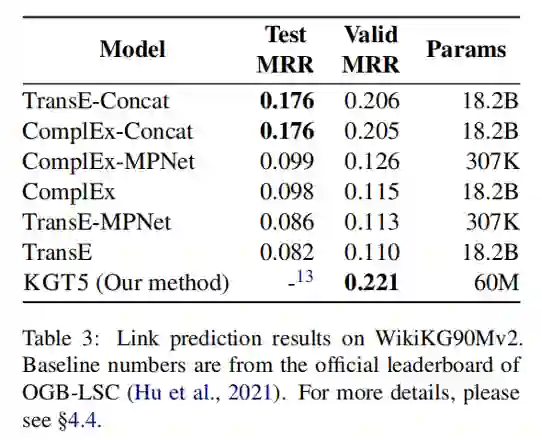

类似地,下图显示了在WikiKG90Mv2上的链路预测性能。可以看出,KGT5在验证集上获得了最高的MRR,同时比排行榜上表现最好的模型少98%。

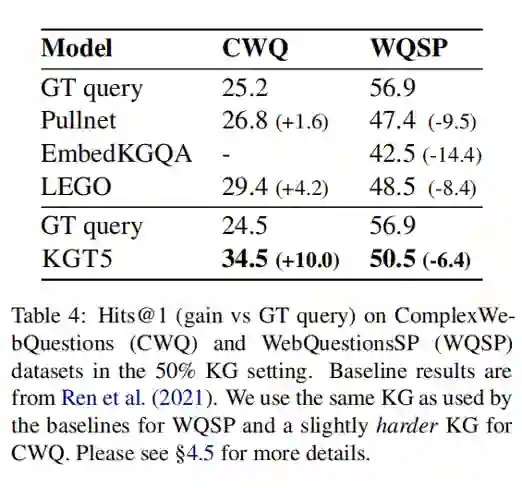

作者在两个数据集上评估了KGT5对于不完整KG的QA能力。在这两个数据集上,KGT5 都优于所有基线。就复杂性和 KG 大小而言,ComplexWebQuestions 是最难的数据集,其收益是最大的。

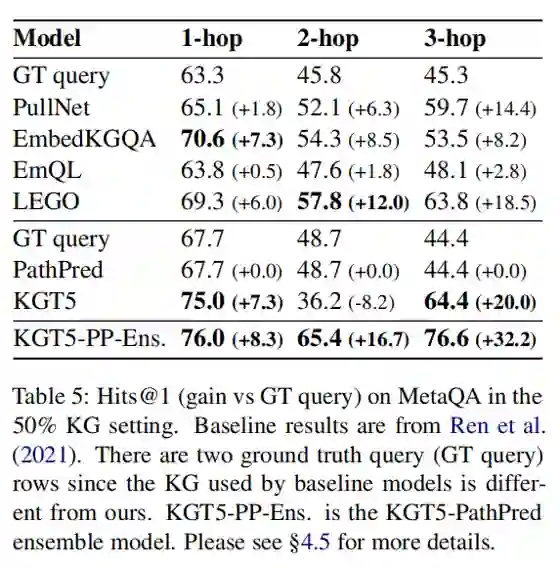

下图显示了 MetaQA 数据集上的 hits@1 性能。然而,在 MetaQA 2-hop 上,与基线相比,性能明显更差,甚至比地面实况查询更差。为了解决这个问题并创建一个更忠实于不完整 KG 中存在的知识的模型,作者设计了一个带有 PathPred 基线的 KGT5 集合。集成工作如下:给定一个问题 q,尝试使用 PathPred 回答它。如果这返回一个空集,就使用 KGT5。

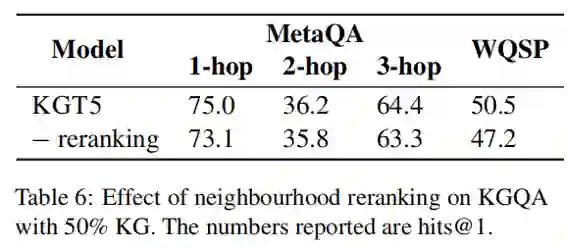

最后,作者进行了消融来研究邻域重新排序对 KGQA 性能的影响,发现重新排序在所有数据集上都带来了小而一致的收益。见下图:

总结

本文证明了KG 链接预测和问答可以被视为 seq2seq 任务,并使用单个编码器-解码器 Transformer 模型成功解决。通过在链接预测任务上训练具有与 T5-small 相同架构的 Transformer 模型来做到这一点,然后在 QA 任务上对其进行微调。这种简单但功能强大的方法(KGT5)与用于在大型 KG 上完成 KG 的最先进方法具有竞争力,同时使用的参数减少了 98%。在 KGQA 对不完整 KG 的任务中,发现本文的统一方法在多个大型基准数据集上优于基线。此外,还将语言建模预训练与 KG 链接预测训练进行了比较,发现对于 KGQA 等知识密集型任务,链接预测训练可能效果更好。

OpenKG

OpenKG(中文开放知识图谱)旨在推动以中文为核心的知识图谱数据的开放、互联及众包,并促进知识图谱算法、工具及平台的开源开放。

点击阅读原文,进入 OpenKG 网站。