题目: KG-BERT: BERT for Knowledge Graph Completion

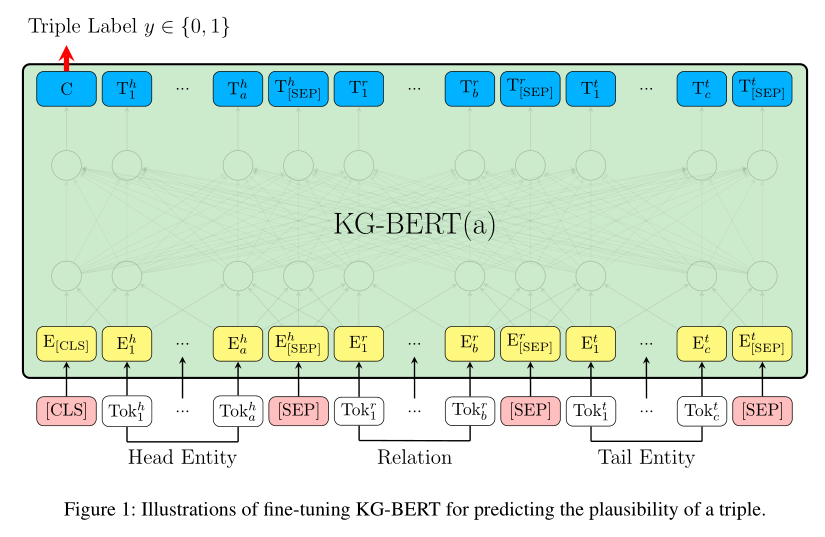

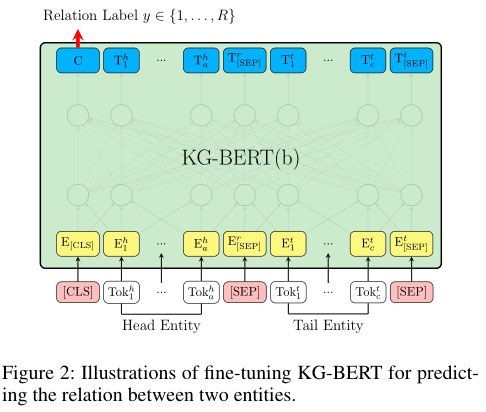

摘要: 知识图谱是许多人工智能任务的重要资源,但往往是不完整的。在这项工作中,我们使用预训练的语言模型来对知识图谱进行补全。我们将知识图谱中的三元组视为文本序列,并提出了一种新的框架结构——知识图谱双向编码方向转换器(KG-BERT)来对这些三元组进行建模。该方法以一个三元组的实体描述和关系描述作为输入,利用KG-BERT语言模型计算三元组的评分函数。在多个基准知识图谱上的实验结果表明,我们的方法在三元组分类、链接预测和关系预测任务上都能达到最新的性能。

成为VIP会员查看完整内容

相关内容

知识图谱(Knowledge Graph),在图书情报界称为知识域可视化或知识领域映射地图,是显示知识发展进程与结构关系的一系列各种不同的图形,用可视化技术描述知识资源及其载体,挖掘、分析、构建、绘制和显示知识及它们之间的相互联系。

知识图谱是通过将应用数学、图形学、信息可视化技术、信息科学等学科的理论与方法与计量学引文分析、共现分析等方法结合,并利用可视化的图谱形象地展示学科的核心结构、发展历史、前沿领域以及整体知识架构达到多学科融合目的的现代理论。它能为学科研究提供切实的、有价值的参考。

专知会员服务

59+阅读 · 2020年6月30日

专知会员服务

36+阅读 · 2020年5月11日

专知会员服务

78+阅读 · 2020年5月11日

Arxiv

20+阅读 · 2019年12月19日

Arxiv

6+阅读 · 2019年8月17日