![]()

定位蒸馏 (LD, CVPR 2022)

![]()

Localization Distillation for Dense Object Detection

论文地址:

https://arxiv.org/abs/2102.12252

代码地址1:

https://github.com/HikariTJU/LD

地址代码2:

https://github.com/open-mmlab/mmdetection/tree/master/configs/ld

方法概括:把用于分类 head 的 KD(知识蒸馏),用于目标检测的定位 head,即有了 LD(Localization Distillation)。

做法:先把 bbox 的 4 个 logits 输出值,离散化成 4n 个 logits 输出值,之后与分类 KD 完全一致。

意义:LD 使得 logit mimicking 首次战胜了 Feature imitation。分类知识与定位知识的蒸馏应分而治之、因地制宜。

1.1 LD的诞生

1.1.1 bbox分布与定位模糊性

说起 LD,就不得不说起 bbox 分布建模,它主要来源于 GFocalV1(NeurIPS 2020)

[1]

与 Offset-bin(CVPR 2020)[2] 这两篇论文。

我们知道 bbox 的表示通常是 4 个数值,一种如 FCOS 中的点到上下左右四条边的距离(tblr),还有一种是 anchor-based 检测器中所用的偏移量,即 anchor box 到 GT box 的映射(encoded xywh)。

GFocalV1 针对 tblr 形式的 bbox 建模出了 bbox 分布,Offset-bin 则是针对 encoded xywh 形式建模出了 bbox 分布,它们共同之处就在于尝试将 bbox 回归看成一个分类问题。并且这带来的好处是可以建模出 bbox 的定位模糊性。

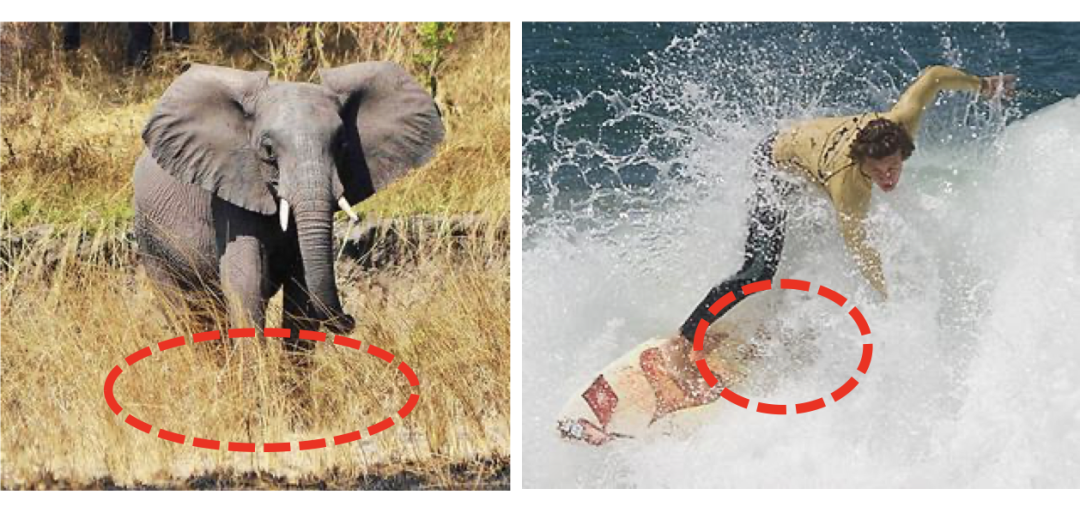

![]()

那么用 n 个概率值去描述一条边,可以显示出模型对一个位置的定位模糊估计,越尖锐的分布说明这个位置几乎没有模糊性(比如大象的上边界),越平坦的分布说明这个位置有很强的模糊性(大象的下边界)。当然不光是 bbox 分布的平坦度,形状上还可分为单峰型,双峰型,甚至多峰型。

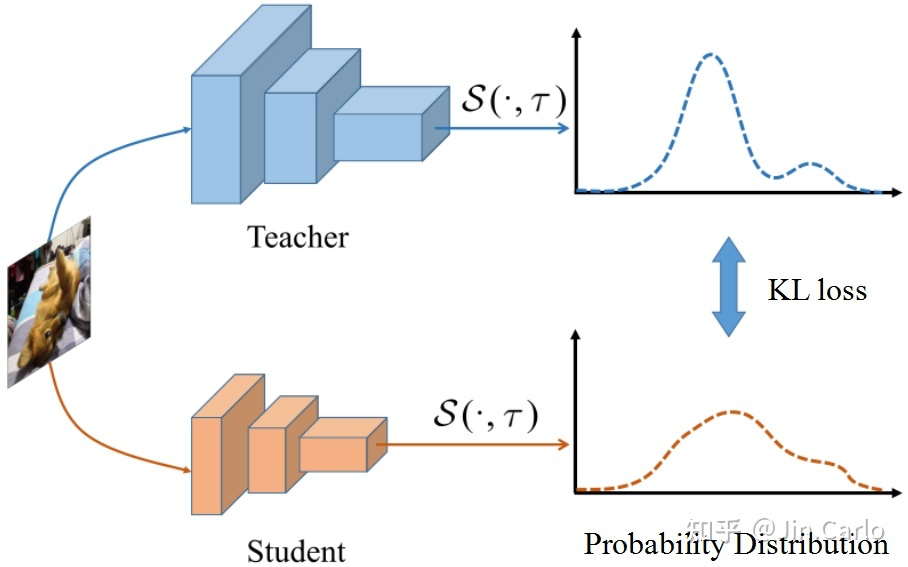

1.1.2 知识蒸馏

Knowledge Distillation(KD)最早是针对图像分类而设计的。核心思想是:

用一个预训练的大模型(teacher)去指导一个小模型(student)的学习

。

![]()

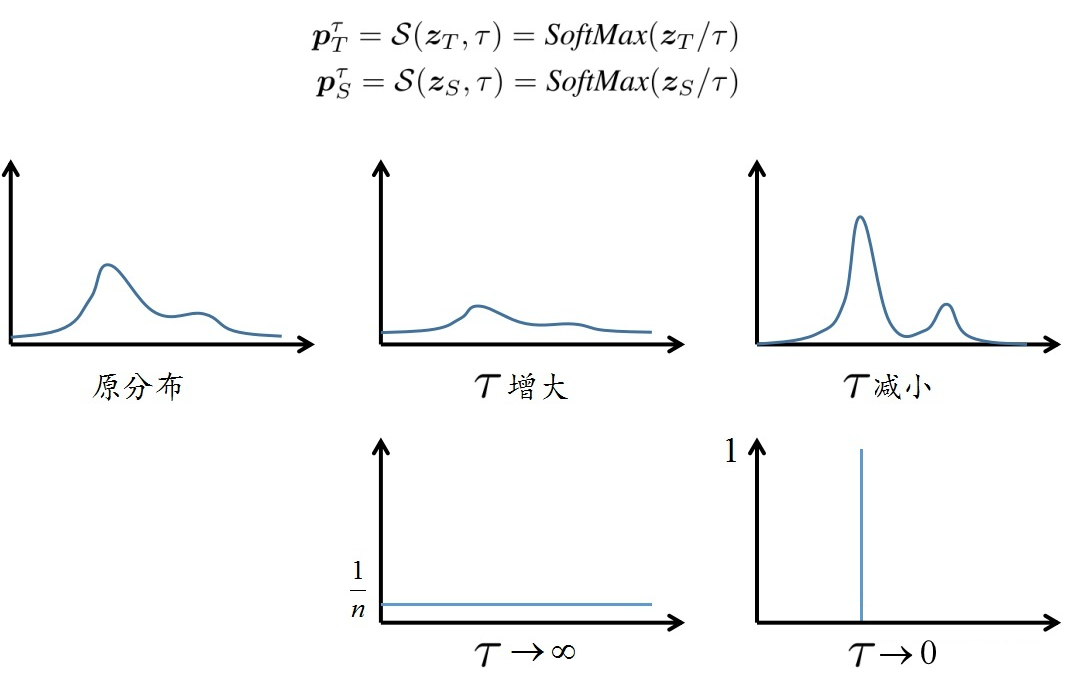

网络模型输出 n 个 logits

,

经过一个带有温度

的 softmax 变换

,便得到了概率分布

。

那么只要去最小化 student 的概率分布

与 teacher 的概率分布

的 KL loss,就可以将大模型的知识迁移至小模型。这里温度

对图像分类任务是常见的选取,即软化分类知识。

![]()

1.2 定位蒸馏

看到这里,LD 的 idea 已经不言自明,bbox 的一条边是 n 个 logits

,一个 bbox 就有 4 个

,每个

作用上一个带有温度

的 softmax 函数,把定位知识软化一下,随后一样的 KL loss,让 student 的 bbox 分布去拟合 teacher 的 bbox 分布。

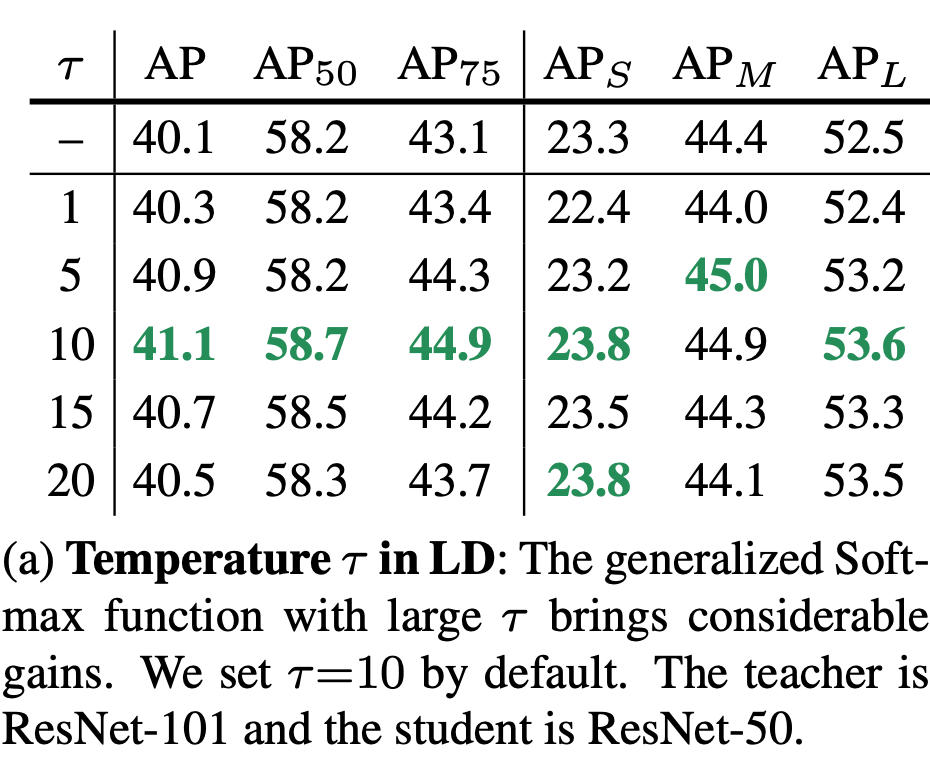

为验证 LD 的有效性,我们先在检测器的 positive location 上进行,也就是哪里进行了 bbox regression,哪里就进行 LD。大模型 teacher 是一个已经训练了 24 epochs 的高精度检测器(比如 ResNet-101),小模型 student 可以是 ResNet-50。在 COCO 数据集上,我们只需要稍微调一调温度

就可以在 GFocalV1 的基础上提高 1.0AP,特别是 AP75 的提升最为显著,说明 LD 确实显著改善了定位精度。

![]()

由以上可以看到,定位蒸馏 LD 与分类蒸馏 KD 从公式上来看是完全一致的,都是针对 head 的输出 logits 做知识传递,这为目标检测知识蒸馏提供了一个

统一的 logit mimicking 框架

。

1.3 分类KD的低效性与Feature imitation

以往许多工作指出了分类 KD 的蒸馏效率低下(涨点低),这主要有两个方面:

-

在不同的数据集中,类别数量会变化,较少的类别可能给 student 提供不了很多有用的信息。

一直以来 logit mimicking 都只能在分类 head 上操作,而无法在定位 head 上操作,这自然忽视了定位知识传递的重要性。

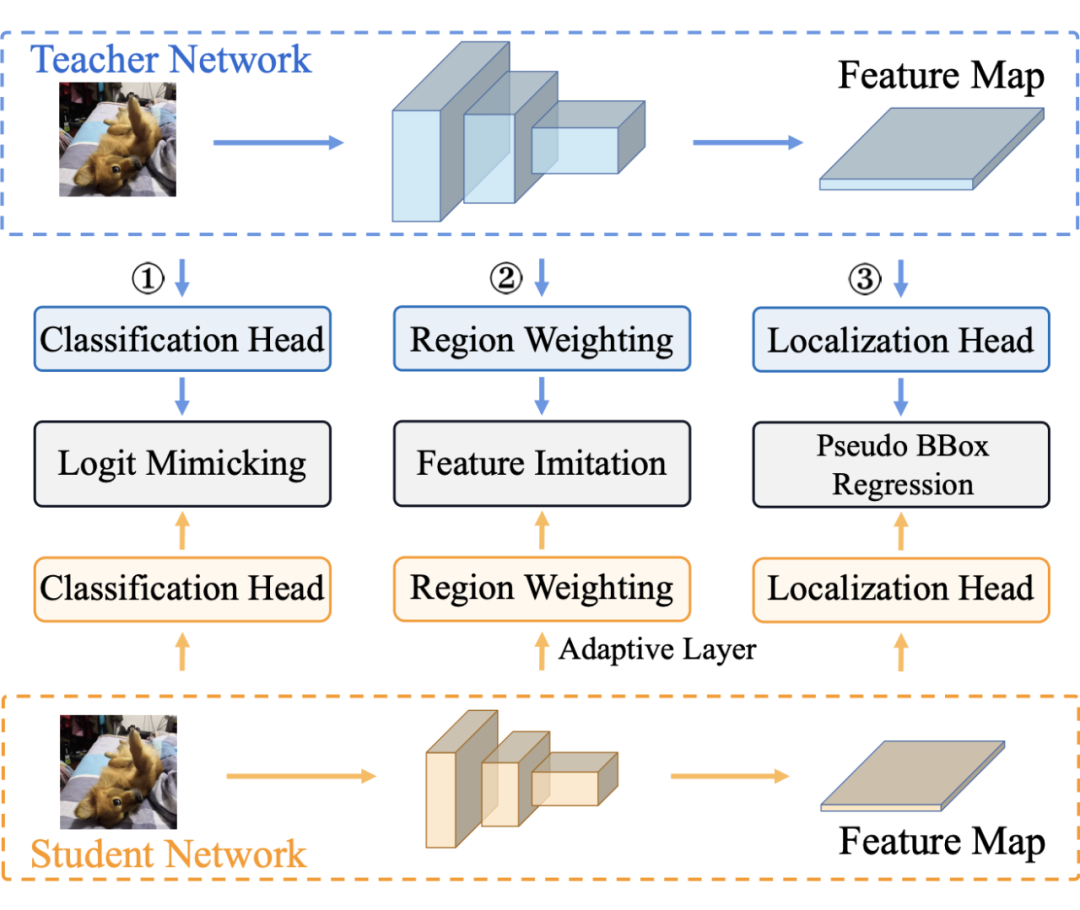

基于这两个原因,人们将视线转向了另一个很有前景的知识蒸馏方法,Feature imitation。该方法主要受到 FitNet 的启发,一言以概之,就是不光分类 head 上要做 logit mimicking,中间隐藏层(特征图)也要让 student 去拟合 teacher,通过最小化 L2 loss 来完成。

![]()

其中分类 head 上是 logit mimicking(分类 KD),特征图上是 Feature imitation (teacher 与 student 特征图之间的 L2 loss),定位 head 上是伪 bbox regression,即把 teacher 预测框当成额外的回归目标。

Feature imitation 在师生的特征图上施加监督,最常见的做法是先将 student 的特征图尺寸与 teacher 特征图对齐,之后再选择一些感兴趣的区域作为蒸馏区域,例如 FitNet(ICLR 2015)[3] 在全图上蒸馏;Fine-Grained(CVPR 2019)[4] 在一些 anchor box 的 location 上蒸馏;还有 DeFeat(CVPR 2021)[5] 在 GT box 内部用小 loss weight,在 GT box 外部用大 loss weight;亦或者是 GI imitation(CVPR 2021)[6] 的动态蒸馏区域,但无论选择何种区域,最后都是在蒸馏区域上计算二者的 L2 loss.

那么 Feature imitation 有什么好处呢?

在 multi-task learning 框架下,特征图相当于树根,下游的各个 head 相当于树的叶子。那么特征图显然包含了所有叶子所需要的知识。进行 Feature imitation 自然就会同时传递分类知识与定位知识,而分类 KD 却无法传递定位知识。

Feature imitation 有什么弊端呢?

答案自然还是它会在蒸馏区域中的每个 location 上同时传递分类知识与定位知识。

分类知识与定位知识的分布是

不同的

。这一点在以往的工作中有提到,例如 Sibling Head(CVPR 2020)[7]。

两种知识的分布不同,自然就导致了并不是在一个 location 上同时传递分类知识与定位知识都有利。很有可能某些区域仅对分类知识传递有利,也有可能某些区域仅对定位知识传递有利。换言之,我们需要

分而治之、因地制宜

地传递知识。这显然就是 Feature imitation 无能为力的事情了,因为它只会传递混合知识。

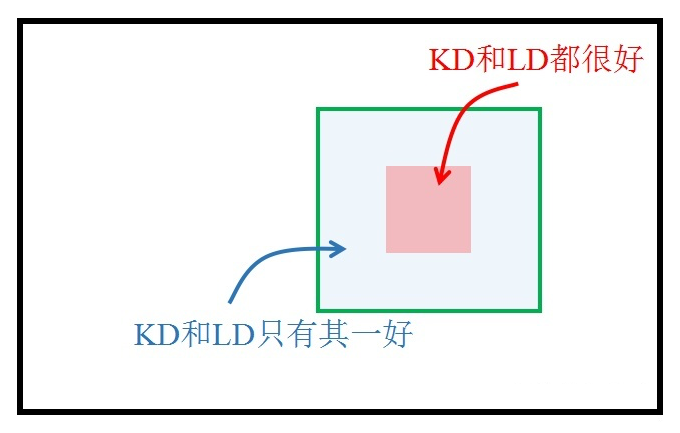

![]()

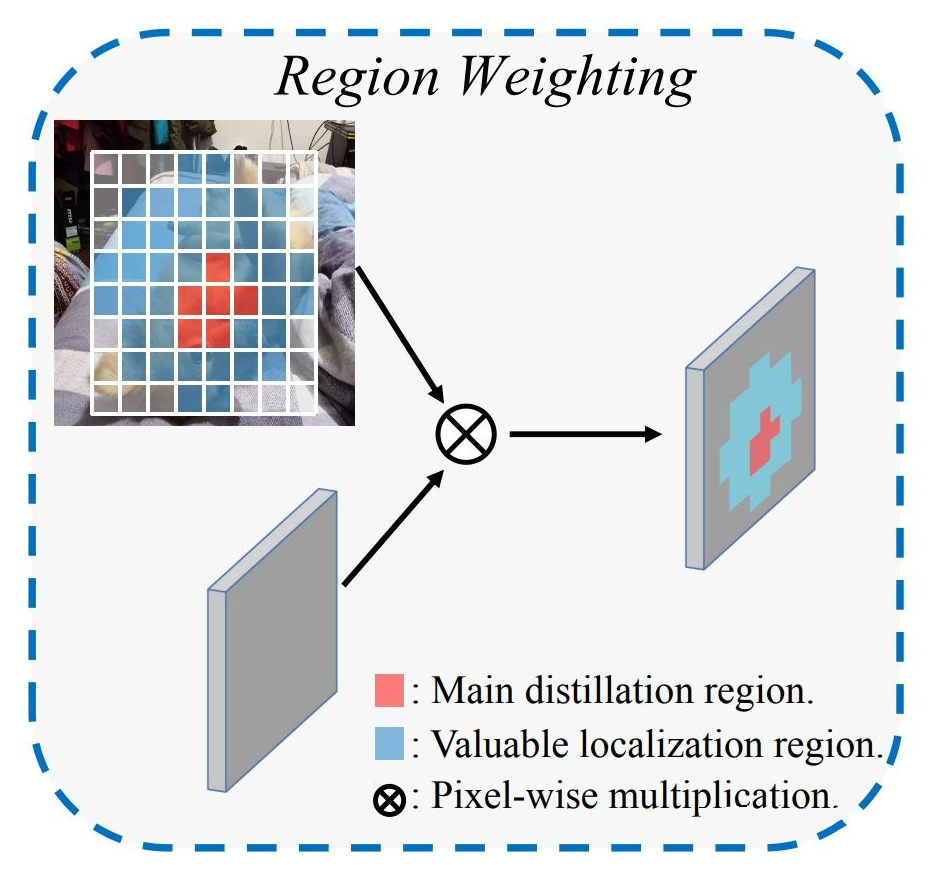

于是我们利用 multi-task learning 天然地把知识解耦成不同类型,这就允许我们在一个区域中有选择性地进行知识蒸馏。为此,我们引入了一个有价值定位区域 VLR (Valuable Localization Region)的概念,来帮助我们进行分而治之的蒸馏。

![]()

与以往的 Feature imitation 方法不同,我们的蒸馏分为两个区域:

-

Main distillation region (主蒸馏区域):即检测器的 positive location,通过 label assignment 获得。

VLR:与一般的 label assignment 做法类似,但区域更大,包含了 Main region,但去掉了 Main region。VLR 可以视为是 Main region 的向外扩张。

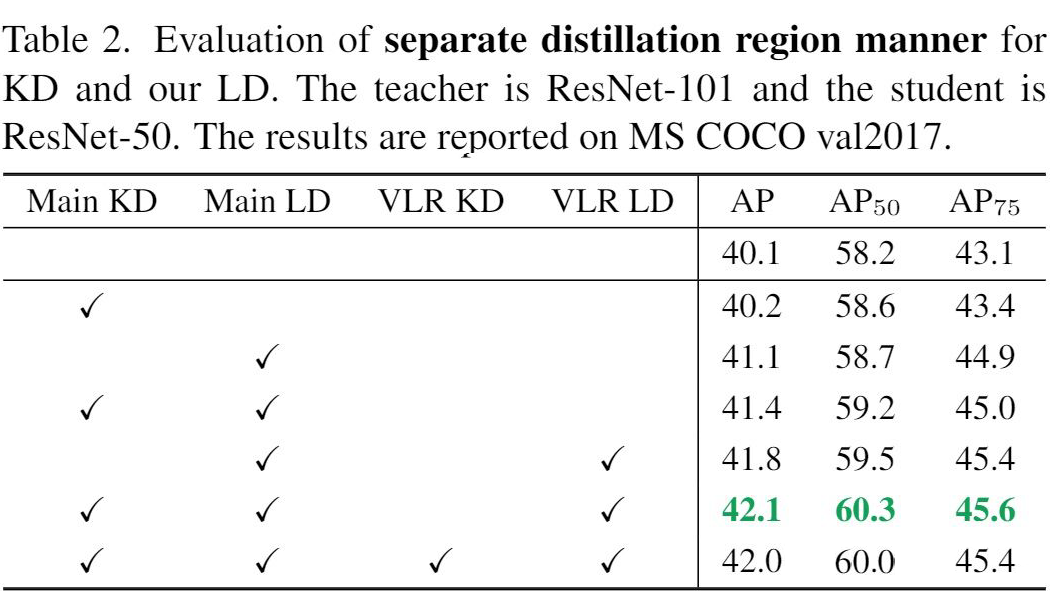

于是我们来探究一下在这两个区域上进行分类的 KD 与定位的 LD 会有什么效果。

![]()

-

可以看到在 Main 区域上,KD 与 LD 均有效,说明在这个区域上传递分类或定位知识都有好处。但明显 LD 提升更大,说明定位知识的传递更有利于性能的提升。

VLR 上 LD 也有效,这也是为什么我们把这样的区域命名为有价值定位区域。但 VLR KD 的加入却损害了性能。

于是就得到了本文的 logit mimicking 策略,

Main KD + Main LD + VLR LD

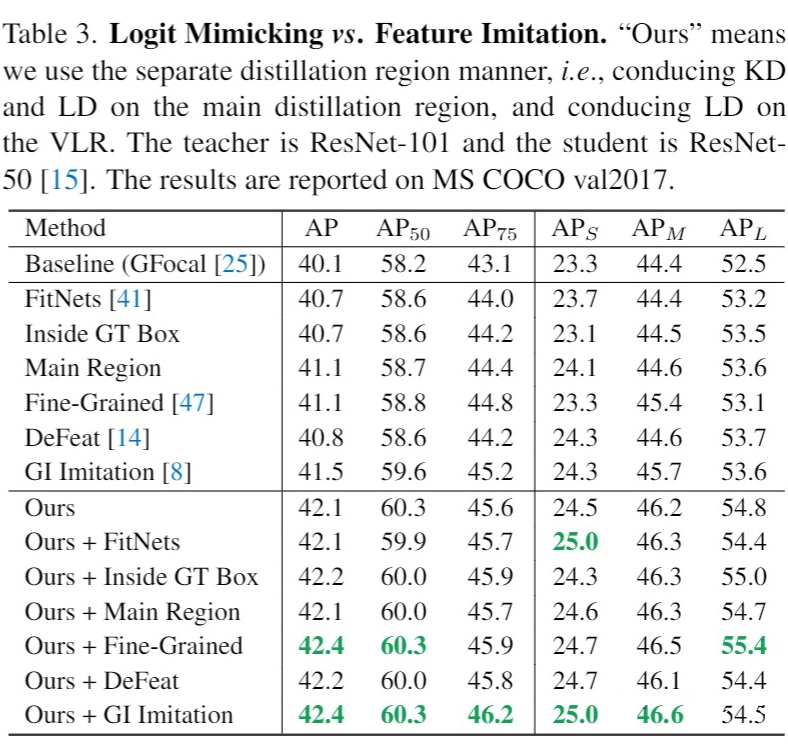

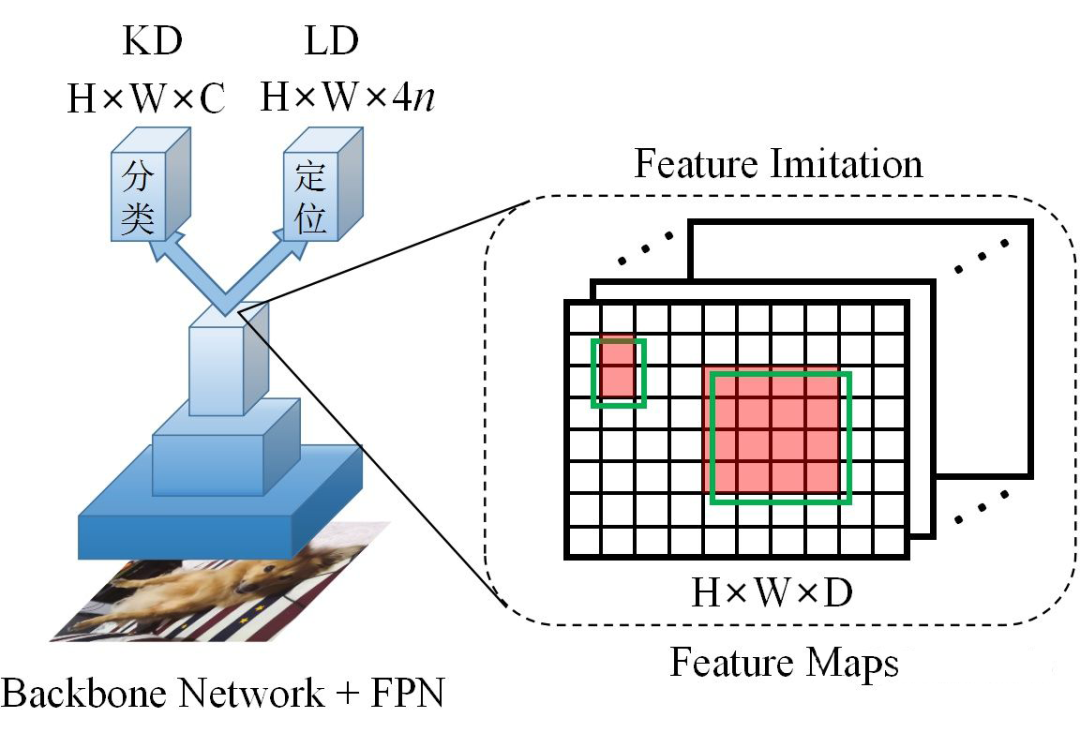

有了这个 logit mimicking 策略,我们可以与 Feature imitation 对比一下

![]()

这个实验首次展示了 logit mimicking 的巨大潜力,也说明了 logit mimicking 多年以来的蒸馏效率低下的原因是

缺少有效的定位知识传递

。当引入了 LD 后,弥补了这一缺陷,logit mimicking 居然可以超过 Feature imitation。

当然上表也展示了,最优的蒸馏策略依然是 logit mimicking 与 Feature imitation 都用上。只是可以注意到的是,在有了 logit mimicking 之后,各个 Feature imitation 的性能差异也不是很明显了,选择哪个蒸馏区域都差不了多少。

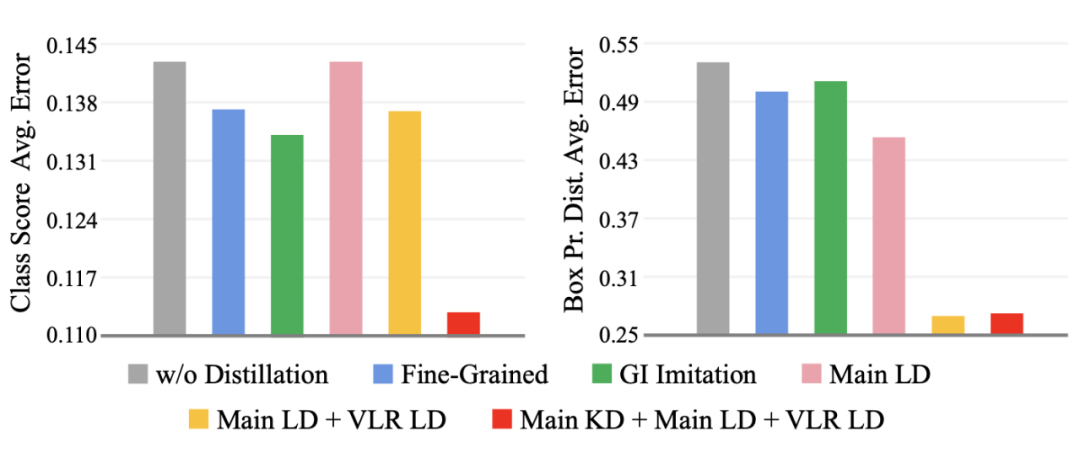

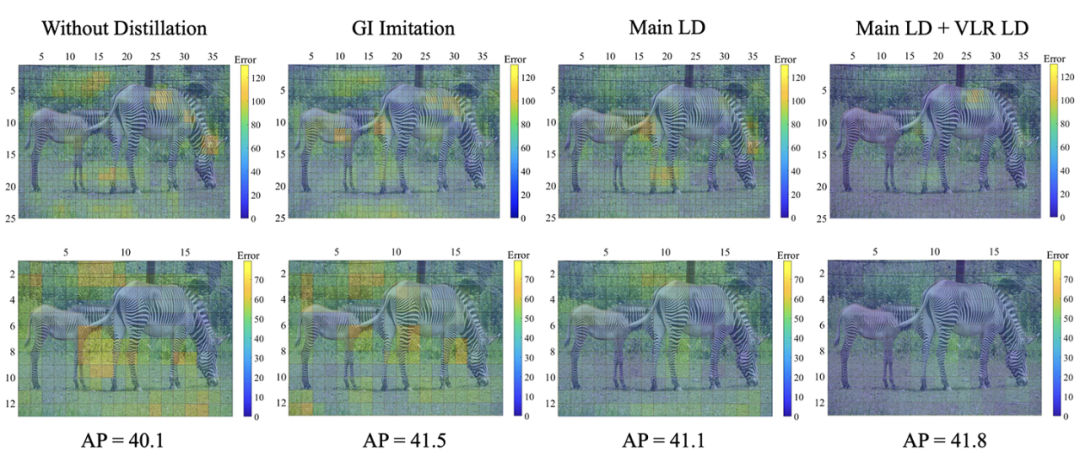

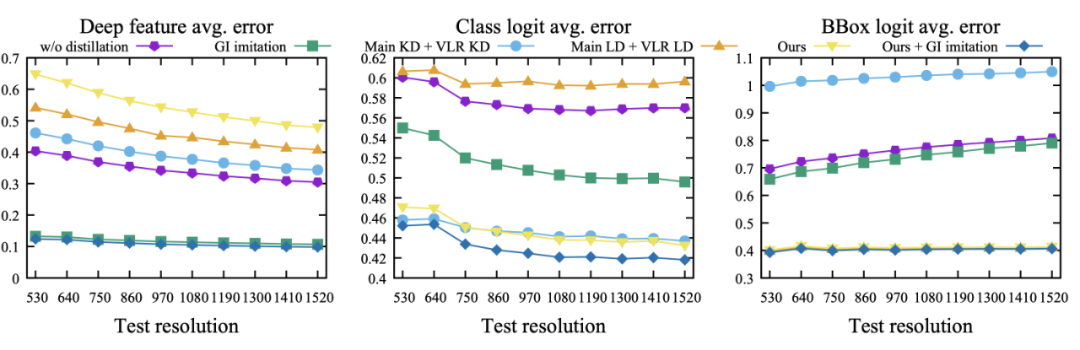

下图展示的是 student 与 teacher 的平均分类误差与定位误差。

可以看到一些代表性 Feature imitation 方法(如 Fine-Grained,GI)确实可以同时降低分类误差与定位误差。在仅用上 LD 时,定位误差得到明显下降,但分类误差无法降低也是可以理解的。而在进一步用上了 KD 之后,两个误差都得到了明显下降。

![]()

![]()

1.4 一些有意思但不知何用的东西

LD loss 对定位的指导可以取缔 bbox regression,即不使用 bbox regression 亦可超过 baseline. (这表明 teacher bbox 分布的监督非常强悍)

![]()

VLR 仅仅提供了分而治之蒸馏的初步解决方案,未来设计一种更优雅的区域选择机制,进行因地制宜地传递分类知识和定位知识或许是一个可供研究的方向。

-

LD 的出现揭示了目标检测的分类知识与定位知识可以分开传递,这对其他领域(如实例分割)是否也存在第三种 mask 知识可供分别传递还有待研究。

logit 蒸馏与 feature 蒸馏之争

![]()

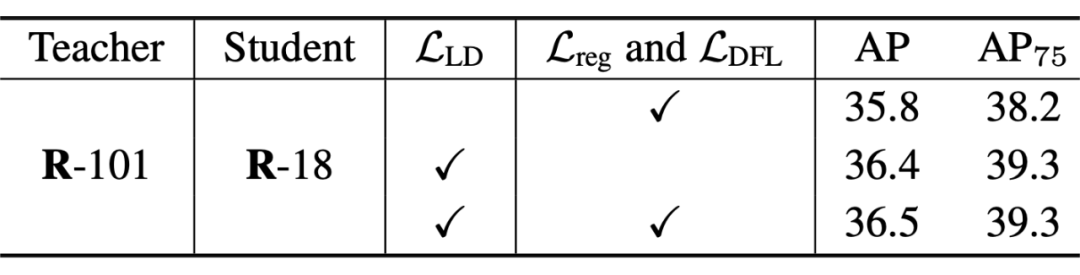

论文标题:

Localization Distillation for Object Detection

https://arxiv.org/pdf/2204.05957.pdf

https://github.com/HikariTJU/LD

https://github.com/Zzh-tju/Rotated-LD

我们展示了定位蒸馏(LD)在目标检测知识蒸馏中起到重要作用,并且分类知识与定位知识可

因地制宜

地传递给学生。在目睹了 logit mimicking 首次超越了 feature imitation 之后,我们就更加好奇 logit mimicking 到底是怎么 work 的?

接下来是 LD 的拓展部分,分为三个部分,Logit Mimicking vs Feature Imitation,LD 的性质,Rotated LD。

2.1 Logit Mimicking vs Feature Imitation

Logit mimicking,即最广为人知的分类 KD [8],最初是用在图像分类任务上。而 Feature imitation 主要受 FitNet [3] 的启发,在中间隐藏层上做知识传递(使用 L2 loss 居多)。如今有了定位蒸馏 LD,数学表达式上与分类 KD 一致,二者统一为 logit mimicking 框架。这更加明确了目标检测知识蒸馏的两个派系,一派 logit mimicking,一派 feature imitation,框架大体如下所示:

![]()

那么以往所有针对 feature imitation 而设计的蒸馏区域,带权的 imitation loss,其思想都可以沿用到 logit mimicking 层面,并且还可以对分类 KD 与定位 LD 分别考虑。若再把目标检测领域多年来在分类分支与定位分支的交互学习方面所发展出的各种训练策略、loss 设计的思想借鉴过来,未来看到一种动态的、分类与定位相结合的 logit mimicking 还是很有希望的。

言归正传,logit 蒸馏与 feature蒸馏孰优孰劣一直以来都是一个谜,到今天也依然如此。尽管一些 feature imitation 工作通过不断设计出更好的蒸馏区域与带权的 imitation loss,使得 feature imitation 在目标检测中展现出了强大的优势。综合以往文献,这里总结了三个主要原因:

分类 KD 的性能受到类别数量的限制,是会变化的,类别少了知识就少,并且如果数据集中都是一些风马牛不相及的类别,知识可能会更少,这使得分类 KD 帮助有限。

-

分类 KD 很显然一直以来都只能在分类 head 上操作,这自然忽视了定位知识传递的重要性。

若把特征图比作树根,下游的各个 head 比作叶子,则特征图自然包含了下游任务所需的所有知识。因此 feature imitation 自然会传递这种混合知识,同时提升各个下游任务。

2.1.1 几个疑问

现如今有了 LD 后,logit mimicking 再次崭露头角,并可以超过 feature imitation,我们不禁要问:logit mimicking 与 feature imitation 到底是如何 work 的?它们学出来的模型到底差异在哪里?有何特点?我们能否不只看最终的检测性能?以往的工作曾指出 feature imitation 会增加师生特征图之间的一致性,而特征图的对齐是否是使学生获得涨点的关键因素?

-

它们的师生 feature 误差,师生 class logit 误差,以及师生 bbox logit 误差是怎样的?

-

logit mimicking 的梯度既然会回传至特征图,那对 feature 会产生什么影响?同样地 feature imitation 对下游的 head 没有任何约束,那对 logit 会产生什么影响?

feature imitation 对学生特征图施加的是 L2 强约束,而 logit mimicking 对学生特征图无显式约束,这会产生什么后果?如果我稍微对学生 feature 添加一个扰动,它们的性能又会产生什么变化?

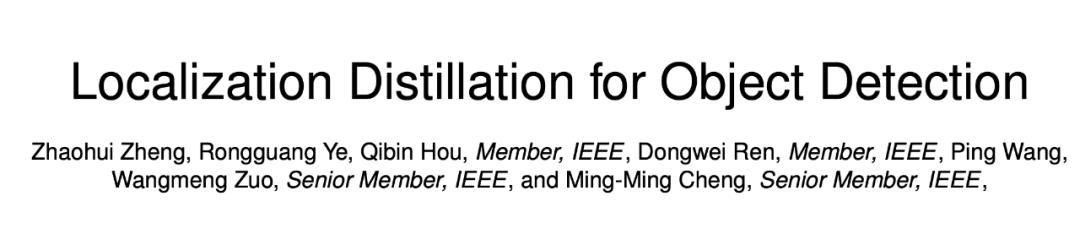

2.1.2 师生误差分析

我们首先可视化了采取各种蒸馏策略训练而出的检测器的师生 feature 误差,class logit 误差,以及 bbox logit 误差,来观察 logit mimicking 与 feature imitation 的基本工作机制。这里我们选用最先进的 GI imitation [6] 来作为 feature imitation 的代表,这是一种蒸馏区域会动态变化的 feature imitation 方法。Ours 表示 Main KD + Main LD + VLR LD,具体含义可回看上一章节。

可以看到,分类 KD,LD,feature imitation 都会显著缩小自身目标的误差。即分类 KD 会显著缩小 class logit 误差,LD 显著缩小 bbox logit 误差,feature imitation 显著缩小 feature 误差。同时看到,feature imitation 也会一定程度上缩小 class logit 误差与 bbox logit 误差,这证实了它的确传递了混合知识。更进一步,分类 KD 仅仅缩小了 class logit 误差,但增大了 bbox logit 误差与 feature 误差。而 LD 也仅仅缩小了 bbox logit 误差,但增大了 class logit 误差与 feature 误差。这表明分类 KD 与 LD,用上其一都会极大地主导网络更倾向于该特定 head 的学习。

![]()

▲ 三种师生误差:分别是feature误差、class logit误差、bbox logit误差

再次观察上图,我们看到 logit mimicking 使得 feature 误差增大了。这是一个比较有意思的现象。这说明 logit mimicking 回传至特征图的梯度,并没有让师生特征图彼此更接近,反而是更远离了。仔细一想,教师学出来的 feature,本身就是一个大模型在更多 epoch 训练下得到的,它是一个 high-level 的具有抽象语义的特征。因此,强制学生学习这样的 high-level 特征未必是一件好事,它限制了学生特征所能学习的空间大小。上图表明,我们完全不需要学出接近教师的feature,亦可以获得良好的检测性能。

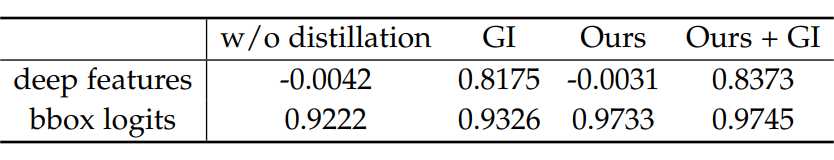

当然,仅仅从 Ln 范数距离来看待上面三种师生误差也不够全面,我们还计算了师生 feature 向量,师生 bbox logit 向量的皮尔逊相关系数,来观察它们的线性相关程度。这里 Ours 代表 logit mimicking,GI 代表 GI imitation技术。

我们知道两个向量的皮尔逊相关系数

表明了它们的线性相关程度。

表示它们强正线性相关,

表示它们无线性相关性,

表示它们强负线性相关。

![]()

▲ 师生feature、bbox logit的皮尔逊相关系数

由上表,我们看到当不使用任何蒸馏时,学生的 feature 与教师的 feature 产生了近乎 0 的皮尔逊相关系数,说明二者的 feature 无线性相关性。而 feature imitation 很明显增大了师生 feature 的线性相关性。至于 logit mimicking,我们观察到它也是产生几乎 0 的皮尔逊相关系数。由此可见,logit mimicking 对学生 feature 的学习几乎没有影响,既不拉近与教师 feature 的距离,也不增大与教师 feature 的线性相关性,而是让学生 feature 自由地学习。但就是这样,logit mimicking 依然提升了性能,甚至超过了 feature imitation。

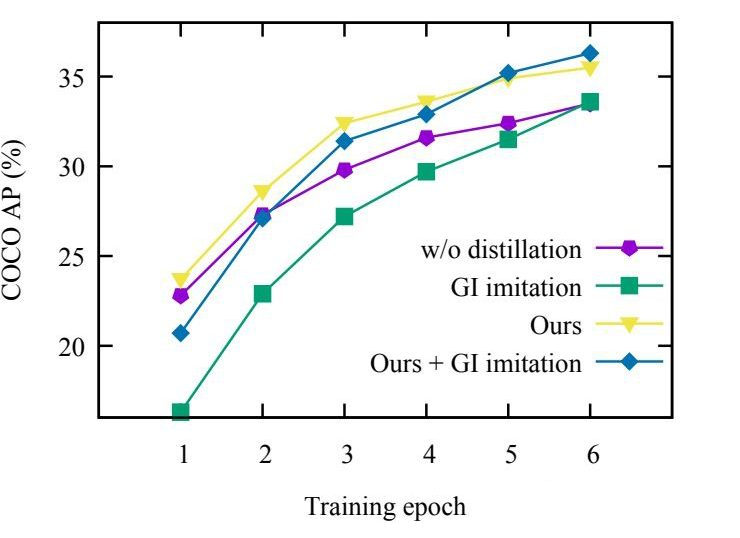

![]() ▲ 训练前期的表现

▲ 训练前期的表现

不仅如此,我们还观察到,feature imitation 由于对学生特征图施加强监督(L2 loss),它会导致训练前期的优化难度剧增。而 logit mimicking 则可以加速模型收敛。

既然 logit mimicking 给予了 feature 更多的自由去学习,也就是说它允许学生 feature 在更宽广的范围内收敛到对下游任务有利的位置上。因此,一个直接的猜测是,logit mimicking 可以学习到更加鲁棒的特征。而 feature imitation 限制了学生 feature 不能距离教师 feature 太远,从而限制了 feature 的学习范围。

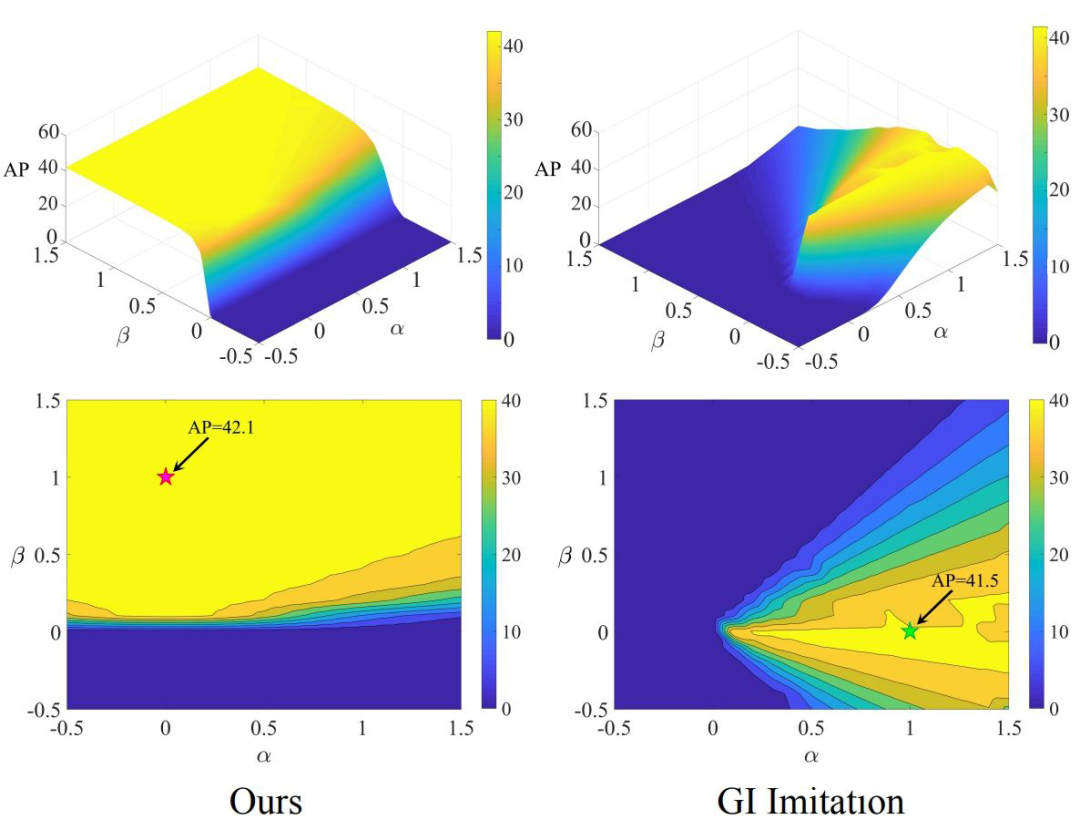

为此,我们进一步提出了一种名为

AP landscape

的可视化技术,其专门针对目标检测而开发。

AP landscape 定义为 AP 在特征子空间中的可视化,这主要受到 loss surface [9] 可视化的启发。loss surface 选取两个模型的网络参数点

,并使用这两个网络参数点所插值出的新网络参数

来进行推理,并统计出该新网络在推理时产生的 loss。

在 AP landscape 的可视化中,我们同样有两个 feature maps,一个是通过 feature imitation 学习得出的feature

,另一个是通过 logit mimicking 学习得出的 feature

,我们也对这两个 feature 进行插值,得到新的 feature

,我让这两个检测器都使用这个新 feature

作为它们 head 的输入特征,进而观察这样的 feature 改变会对最终检测性能产生什么影响?

很显然,这样的可视化只有两种,一种是 1D 的,一种是 2D。更高维就需要抽象的可视化了。

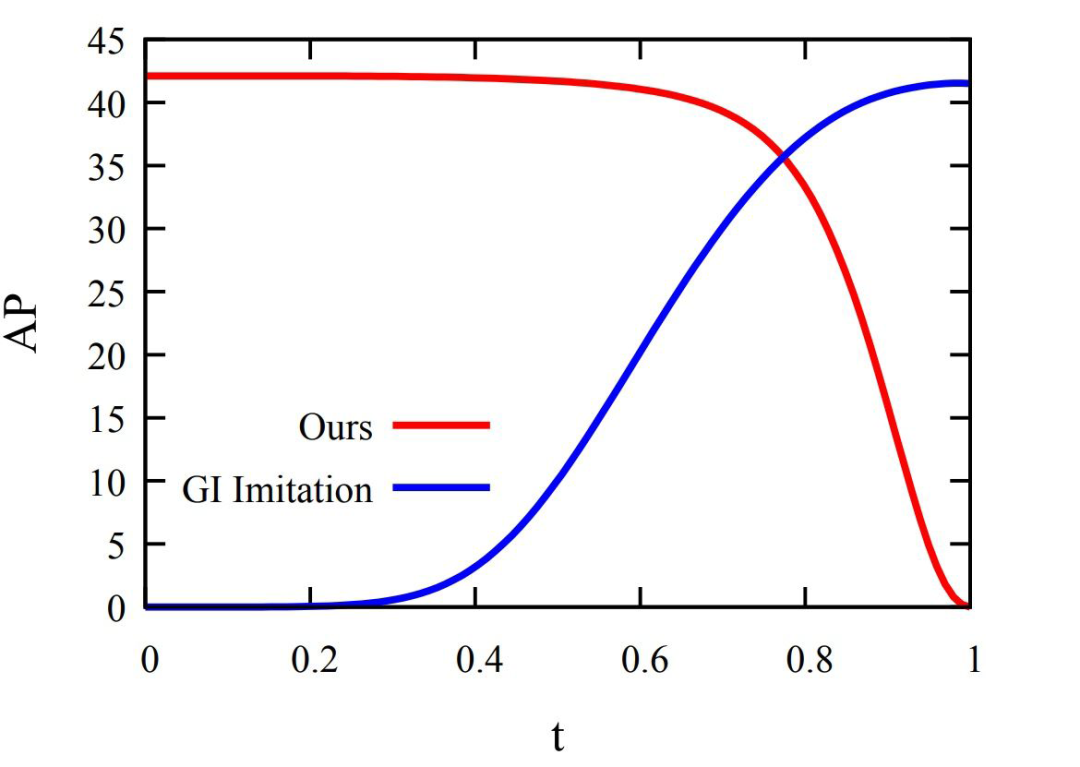

2.1.3 1D AP landscape

以

,

为端点,引入一个参数

,得到

。这样获得的 AP landscape 是一条曲线。当

时,

,表示此时是使用 logit mimicking 所学 feature 进行推理,而

则表示是使用 feature imitation 所学 feature 进行推理。在推理时,使用的是它们各自的 head,也就是仅仅把这两个 detector 的 feature 进行了改变,而保持其他组件不变。

![]() ▲ AP landscape 1D可视化

▲ AP landscape 1D可视化

由 1D 可视化我们看到,logit mimicking 在一个很大的范围内(

)均保持着极高的性能,而当

时,AP 达到 0。feature imitation 则随着

逐渐远离 1,AP 迅速下降,且同样当

时,AP 达到 0。从这里我们可以看出似乎 logit mimicking 所学 feature 更加鲁棒,其可以容忍更大的扰动,而不会很快地降低性能。

2.1.4 2D AP landscape

以

,

为基向量,引入两个参数

,得到

。(这里之所以能以

,

为基向量,是因为它们都是极其高维的向量,正交概率几乎为1)。显然 1D 可视化就是 2D 可视化中

这条直线。由于我们无法在这样的特征子空间

中得到精确的 AP landscape,因此只能离散取点测试,再进行平滑处理。同时考虑到计算量的问题,我们也将可视化范围限定在

的矩形范围内。

![]()

▲ AP landscape 2D可视化

从 2D 可视化中,我们更能明显看到 logit mimicking (左)与 feature imitation(右)所学出来的 feature 差异了。logit mimicking 学出来的 feature(左下图红色五角星)处于一个很宽广、很平坦的高 AP 范围内。而 feature imitation 则产生了一个相对陡峭、尖锐的 AP landscape。注意到,左下图的红色五角星与右下图的绿色五角星之间的连线,即为 1D 可视化范围。

综合检测性能以及以上实验现象,我们可以得出一些结论:

-

-

分类 KD 与 LD 允许我们对不同的任务进行分而治之的蒸馏。

-

logit mimicking 赋予 feature 更大的学习自由度,这使它产生了更为抗扰动的特征。

-

师生 feature 相匹配并不是性能提高的充分条件。

logit 本身是一种更明确具体的知识,能够加速网络收敛。反观 feature imitation,强制令学生 feature 逼近教师 feature,会加大优化难度,特别是在训练早期阶段。

2.2 LD 的性质

LD 与分类 KD 具有相同的数学表达式,它们二者的优化效果有什么联系吗?在本文中,我们给出了 LD 与分类 KD 的理论联系,

LD 的优化效果可以等价于两个分类 KD 优化效果的线性组合

。

简单来说,设学生预测的 logit 为

,其经过带有温度

的 softmax 变换得到概率分布

,另一些概率分布为

。我们用

表示

与

的 LD loss 关于某个 logit

的梯度,

,

表示

与

的分类 KD loss 关于某个 logit

的梯度。我们有如下命题:

给定学生的概率分布

,两个求和为 1 的常数

。则有:

-

给定概率分布

,LD 在它们的线性组合

上的优化效果等价于两个在

上的 KD 优化效果的线性组合。

-

给定概率分布

,LD 在

上的优化效果等价于在其分解出的概率分布

与

上的 KD 优化效果的线性组合。

由此可见,LD 不仅在数学表达式上与分类 KD 相同,还有着等价的优化效果。对于一个实数位置的定位问题,LD 优化效果可由两个整数位置分类问题的 KD 优化效果线性表示。作为一个特殊情形,如果 ground-truth 位置不是实数位置而是整数位置的话,LD 优化效果刚好可以等于 KD 优化效果,毕竟整数是实数的特殊情形。

此外,根据 Understanding and Improving Knowledge Distillation

[10]

,分类 KD 是对 cross entropy loss 进行 gradient rescaling(梯度重缩放),我们进一步拓展了这一结论,证明了 LD 是对 Distribution Focal Loss

[11

]

的gradient rescaling。

最后展望一下,既然 LD 与分类 KD 有着这样的紧密联系,那么

在分类 KD 上的一些研究成果是否也能拓展到 LD 中呢

?例如 label smoothing 与分类 KD [12] 的联系,Regularization 与分类 KD

[13

]

的联系,Relational KD [14],在线 Self-Distillation [15],离线 Self-KD,助教蒸馏 [16],DKD [17] 等等,五花八门。目前我们仅研究了离线 Self-LD,以及助教蒸馏 LD 可以提高检测性能。显然这里还存有很大的探索空间。

这里特别提一句,旷视新作 DKD (CVPR 2022) 针对分类 KD 进行改进,使得分类 KD 重回 SOTA 蒸馏行列。实验表明在目标检测上 DKD 落后于 feature imitation 的关键在于 DKD 无法应用于定位任务,那么很显然 LD + DKD 的有机结合则可能使 logit mimicking 进一步强大。

2.3 旋转LD

Rotated LD 作为水平框 LD 的一个直接拓展,我们也尝试了一下,效果还不错。做法很简单,就是把旋转角

也离散成概率分布。但需要注意的是旋转角的回归区间和其他四个坐标的回归区间可能不同。目前我们主要实现了旋转检测器的 Rotated-RetinaNet,以及 GWD [18]。因为它们两个是很多旋转检测器的基础。

代码基于最近的旋转目标检测库 MMRotate,已公布于:

https://github.com/Zzh-tju/Rotated-LD

![]()

总结

LD 的出现,给了所有需要目标定位的 CV 任务一个进一步提高定位质量的空间。触手可及的一些应用还有如 3D detection + LD,object tracking + LD,PolarMask

[19]

+ LD,

RepPoints

[20] + LD。

所有的拓展都万变不离其宗,都是先把需要回归的变量离散化,一般是变成含有8个或 16 个小区间的概率分布。再训练一个教师,教师一般比学生大一点,但无需大太多,二者 AP 相差 5 个点以内就可以了。然后就可以开始蒸馏了,计算师生概率分布的 LD loss。这里所需要的炼丹过程应该为:确定概率分布小区间个数,确定软化概率分布的温度,确定 loss weight。至于蒸馏区域一般选择 positive location,或者包含它的更大的区域。

至于 logit 蒸馏与 feature 蒸馏到底孰强孰弱,这个我想不会有定论。它们二者各有各的特点,首先 logit mimicking 直接蒸馏的是最为明确具体的知识,具有加速网络前期收敛、让 feature 自由学习、直接提升对应任务性能的优点。而 feature imitation 虽然一定程度上加大了网络前期训练难度,限制了 feature 学习范围,但可以同时提升下游所有任务,并且可以利用多个隐藏层,蒸馏范围的选择面较广。所以目前为止,我们认为最好的蒸馏方案应该是 logit mimicking 与 feature imitation 同时使用,让它们发挥各自的强项同时弥补对方的弱项,以实现收益最大化。

有任何学术问题欢迎在评论区评论,工程问题请在我们 github 主页中提 issue。

[1] https://proceedings.neurips.cc/paper/2020/hash/f0bda020d2470f2e74990a07a607ebd9-Abstract.html

[2] https://openaccess.thecvf.com/content_CVPR_2020/html/Qiu_Offset_Bin_Classification_Network_for_Accurate_Object_Detection_CVPR_2020_paper.html

[3] https://arxiv.org/abs/1412.6550

[4] https://openaccess.thecvf.com/content_CVPR_2019/html/Wang_Distilling_Object_Detectors_With_Fine-Grained_Feature_Imitation_CVPR_2019_paper.html

[5] https://openaccess.thecvf.com/content/CVPR2021/html/Guo_Distilling_Object_Detectors_via_Decoupled_Features_CVPR_2021_paper.html

[6] https://openaccess.thecvf.com/content/CVPR2021/html/Dai_General_Instance_Distillation_for_Object_Detection_CVPR_2021_paper.html

[7] https://openaccess.thecvf.com/content_CVPR_2020/html/Song_Revisiting_the_Sibling_Head_in_Object_Detector_CVPR_2020_paper

[8] https://arxiv.org/abs/1503.02531

[9] https://proceedings.neurips.cc/paper/2018/file/a41b3bb3e6b050b6c9067c67f663b915-Paper.pdf

[10] https://arxiv.org/abs/2002.03532

[11] https://proceedings.neurips.cc/paper/2020/file/f0bda020d2470f2e74990a07a607ebd9-Paper.pdf

[12] https://openaccess.thecvf.com/content_CVPR_2020/papers/Yuan_Revisiting_Knowledge_Distillation_via_Label_Smoothing_Regularization_CVPR_2020_paper.pdf

[13] https://proceedings.neurips.cc/paper/2020/file/2288f691b58edecadcc9a8691762b4fd-Paper.pdf

[14] https://openaccess.thecvf.com/content_CVPR_2019/papers/Park_Relational_Knowledge_Distillation_CVPR_2019_paper.pdf

[15] https://openaccess.thecvf.com/content_ICCV_2019/papers/Zhang_Be_Your_Own_Teacher_Improve_the_Performance_of_Convolutional_Neural_ICCV_2019_paper.pdf

[16] https://arxiv.org/abs/1902.03393

[17] https://arxiv.org/abs/2203.08679

[18] https://zhuanlan.zhihu.com/p/372357305

[19] https://zhuanlan.zhihu.com/p/84890413

[20] https://arxiv.org/abs/1904.11490

![]()

![]()

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

![]()

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

![]()

▲ 训练前期的表现

▲ 训练前期的表现