如何应对多GPU大规模训练的挑战?

几年前,深度学习还是一个只有少数几位人工智能和数据科学研究人员涉足的领域。而如今情况早已今非昔比。尤其是在 GPU 技术的推动下,深度学习正在全球掀起一番新的浪潮。自动驾驶汽车、工业目标检测、AI 医疗影像、自然语言处理等,如今人工智能已经成为了与每个人的生活息息相关的一项项应用。在 GPU 的加持下,训练神经网络的时间已经从起初的数月大幅缩短。

然而随着模型的复杂程度和规模的不断增大,单个 GPU 的计算能力已经无法满足大规模神经网络的训练需求。以自动驾驶汽车为例,自动驾驶汽车的人工智能训练可以说得上是密集型计算的终极挑战。一台数据收集车辆每小时能生成 1 TB 数据。整个车队经过数年行驶后,其数据量将会很快达到几 PB(千兆兆字节)的量级。

此外,例如 BERT 这类用于自然语言处理的大型计算密集型模型,其规模也是十分巨大——BERT 学习了包含有 33 亿个单词的英语语料库。前不久,NVIDIA Research 还推出了 Megatron 项目,该项目旨在打造适用于最先进的 NLP 的 Transformer 模型。将具有 15 亿参数 GPT-2 模型扩展为更大规模的 GPT-2 8B 模型——一个具有 83 亿参数的 Transformer 语言模型,是有史以来最大规模的 Transformer 语言模型,是 BERT 的 24 倍,GPT-2 的 5.6 倍。

面对如此大规模的模型,即便是性能最强大的 GPU,凭借单 GPU 的计算能力也无法在短时间内快速完成训练。这时就需要采用多 GPU 训练的方式,在多个 GPU 或更大规模的 GPU 集群上训练大规模模型数据。

例如:NVIDIA 此前发布的全球速度排名第 22 位的超级计算机 - DGX SuperPOD,其内含 1,536 颗 NVIDIA V100 Tensor Core GPU,由 NVIDIA NVSwitch 及 Mellanox 网络结构相联接,为其提供强力支持。DGX SuperPOD 软硬件平台能够在不到 2 分钟的时间之内完成 ResNet-50 训练。相较于 2015 年,ResNet-50 模型推出的时候,即便采用当时最先进的系统 – 单颗 NVIDIA K80 GPU,也需要 25 天才能完成训练任务,DGX SuperPOD 生成结果的速度较之加快了 18,000 倍。

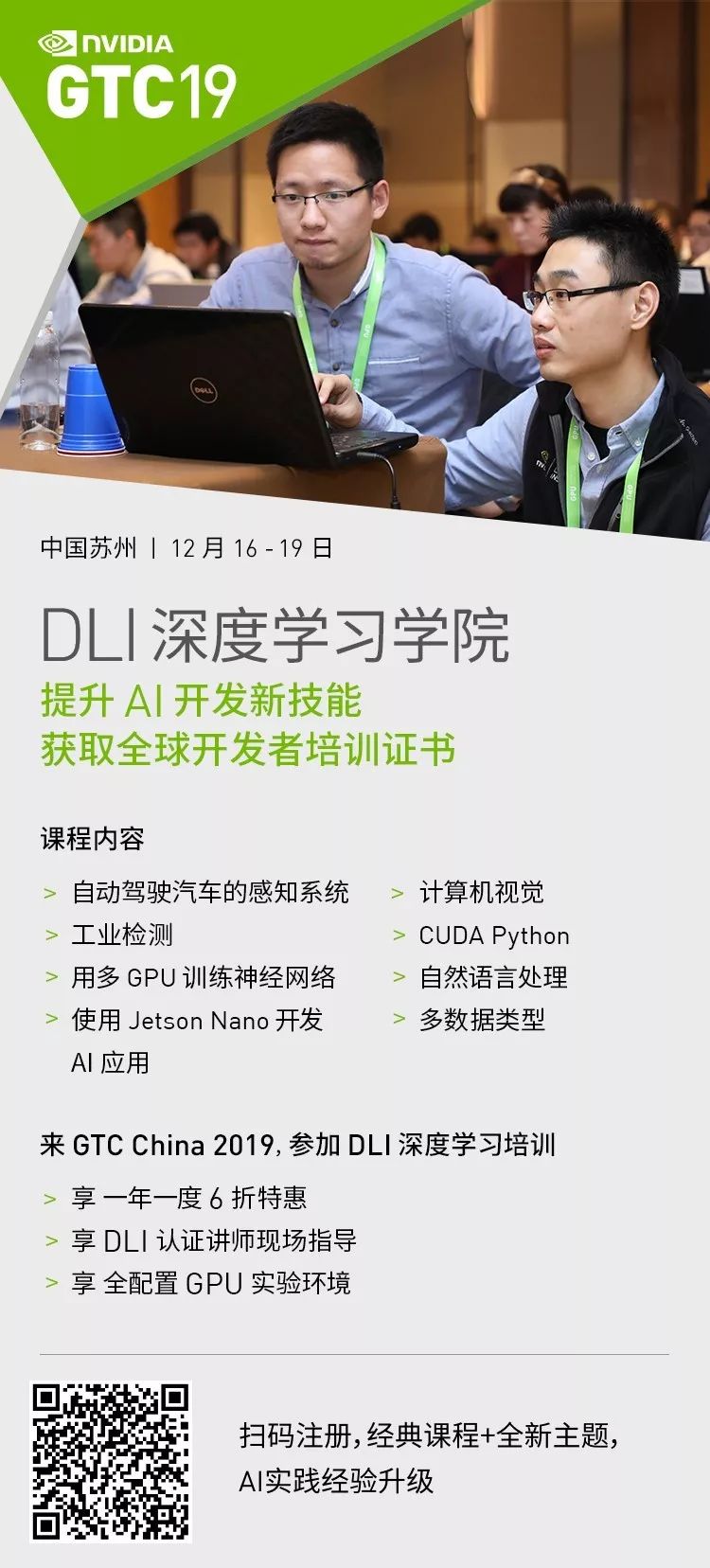

然而,采用多 GPU 训练,不是简单的 GPU 数量堆砌,其背后依赖着一系列复杂的算法。为了帮助开发者们更好地应用多个 GPU 训练神经网络,NVIDIA 在 GTC CHINA 2019 大会期间推出《深度学习基础 — 用多 GPU 训练神经网络》主题深度学习学院(DLI)培训。

NVIDIA 深度学习学院(DLI)是面向开发者、数据科学家和研究人员所设置的,在全球提供深度学习和加速计算的应用实践培训。通过在云端完全配置的 GPU 服务器上训练和部署神经网络,亲自实践完成应用项目开发,掌握深度学习应用开发的策略、方法、资源和端到端流程。参与者完成每一个 8 小时主题培训后,还可以获得 NVIDIA 培训证书,助力职业发展。

点击视频,回顾 GTC CHINA 2018 DLI 深度学习课程培训盛况:

▲ GTC CHINA 2018 DLI深度学习课程培训视频

今年 12 月 16-19 日,在 GTC CHINA 2019 在苏州金鸡湖国际会议中心举办期间,NVIDIA 将于 12 月 17 日推出《深度学习基础 — 用多 GPU 训练神经网络》DLI 培训,旨在帮助开发者们应对大规模训练的算法和工程挑战。

学习模式:由 NVIDIA DLI 认证讲师教授的现场培训

适用行业:所有行业

实验资源:提供云端完全配置的 GPU 服务器

培训证书:学习完成并通过在线测试,即可获取证书

预备知识:具备随机梯度下降法的知识和经验

工具、库和框架:TensorFlow

课程时长: 8 小时

语言:中文

在驱动自动驾驶汽车等 AI 应用方面,人们对于深度神经网络存在着巨大的计算需求。使用单个 GPU 进行一个训练周期可能需耗费数周时间,而对于自动驾驶汽车研究等领域所用的更大数据集,该周期甚至长达数年。使用多个 GPU 进行深度学习能够显著缩短训练大量数据所需的时间,从而为深度学习中的复杂问题提供了可行的解决方案。

本课程将教您如何使用多个 GPU 来训练神经网络。您将了解到:

针对多 GPU 的训练方法

进行大规模训练面临的算法和工程挑

克服上述挑战所用的关键技术

完成本课程后,您将能够使用 TensorFlow 十分有效地并行训练深度神经网络。

了解更多 DLI 深度学习培训课程,请访问:

https://www.nvidia.cn/gtc/training/

点击“阅读原文”链接,即刻注册吧!

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 即刻注册