ICLR 2018 有什么值得关注的亮点?

列表——taineleau(知乎)

Learning Differentially Private Recurrent Language Models

Synthetic and Natural Noise Both Break Neural Machine Translation

Learning One-hidden-layer Neural Networks with Landscape Design

Neural Sketch Learning for Conditional Program Generation

Minimal-Entropy Correlation Alignment for Unsupervised Deep Domain Adaptation

N2N learning: Network to Network Compression via Policy Gradient Reinforcement Learning

Simulating Action Dynamics with Neural Process Networks

A Neural Representation of Sketch Drawings

Certified Defenses against Adversarial Examples

A Deep Reinforced Model for Abstractive Summarization

DCN+: Mixed Objective And Deep Residual Coattention for Question Answering

作者:宫一尘

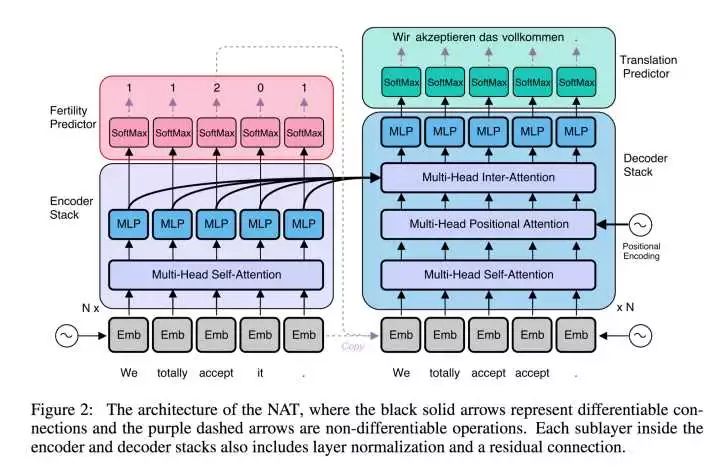

这篇文章一定是做机器翻译必看的一篇文章。是佳涛在Saleforce Research做的工作。这个工作成功实现了non-autoregressive 的机器翻译,并获得了非常接近SoTA的成绩。传统的autoregressive翻译需要在decoding的时候每次生成一个词,并把生成的词放到下一个timestamp的decoding输入中,再生成下一个输出。而这篇文章成功地将inference简化为一次,也就是说,将在inference过程中将省下80%~90%的计算量,粗略估计可以为机器翻译服务省下近80%的成本。之前很多优秀的研究者包括Kyunghyun Cho也探索过这个领域,不过无疾而终,因为这个确实是一个很难的问题。而这个工作让我们看到了曙光。很期待接下来有别的工作可以在这个基础上展开。

作者:lei tai

介绍一个隔壁组Ilya Loshchilov&&Frank Hutter教授的成果, 应该是重剑无锋, 大巧不工的典范了。Fixing Weight Decay Regularization in Adam

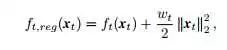

Adam作为一个非常常用的深度学习优化方法, 可以说用途非常广泛了(三年不到引用4000+...). Weight Decay也是大量数据优化时, 训练后期非常常用的一个trick. 出发点是目前分类分割最好的一些结果, 都发现自适应梯度方法(比如Adam)的扩展性不如SGD+Momentum. 这篇paper发现了一个简单, 但是很少有人注意的事实, 那就是现行的所有深度学习框架, 在同时处理自适应梯度类方法(比如Adam)和weight decay的时候, 一定程度上抵消了weight decay的作用. Weight decay本身的目的是限制一下值比较大的weight, 使值比较大的weight下降的更多, 从而避免模型过拟合于某几个大的weight。

而目前L2的实现方法, 使梯度值较大的weight, 下降的比预想的要少. 换句话说, 两个weight一样大, weight decay对他们应该起到的作用是一样的. 但是其中梯度比较大的那个因为Adam的归一化, 反而下降的比较小. 从而指出L2和weight decay并非完全等价。解决的办法也非常简单:

现行框架都是在优化器之前加上L2项, 这样L2的作用就受到了优化器和learning rate(alpha)的影响. Adam的自适应归一化, 将梯度大的weight也进行了归一化, 抵消了L2带来的weight decay的作用. 这篇paper按照weight decay原始的概念, 把它加到了优化器作用之后, 使其与learning rate完全脱钩, 真正发挥weight decay的作用. (公式中SetScheduleMultiplier来自Frank2017年的ICLR SGDR: Stochastic Gradient Descent with Warm Restarts)。

作者:刘嘉耿

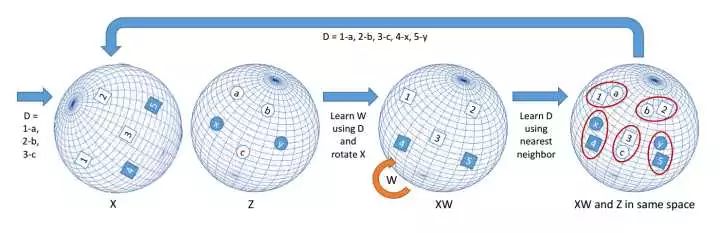

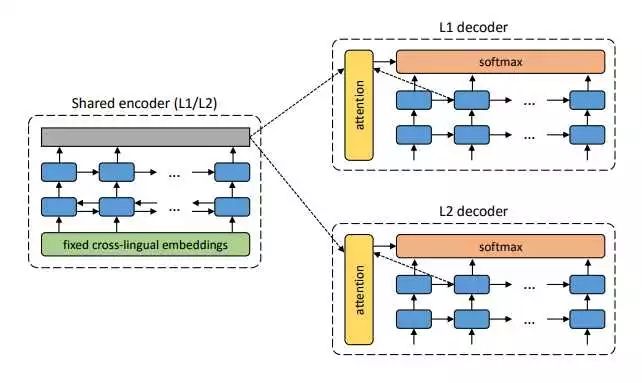

ICLR 2018 在机器翻译领域连出几篇亮点文章,比如大牛 Cho 等人的无监督翻译 Unsupervised Neural Machine Translation ,在几乎没有平行语料的情况下,借助各种语言中普遍存在的阿拉伯数字作为种子对,用近两年的 cross-lingual embedding + noisy input reconstruction + backtranslation 等方法得到了接近有监督模型的结果。

趣闻:本文主要作者来自巴斯克州立大学 (Euskal Herriko Unibertsitatea) ,其使用的巴斯克语是欧洲仅存的孤立语言。

感谢知乎朋友的分析与回答,谢谢!