实操教程|使用计算机视觉算法检测钢板中的焊接缺陷

极市导读

使用CV算法,我们可以通过图像轻松检测焊接故障,并精确测量每个故障的严重程度,这将进一步有助于加快图像识别速度并避免出现不利情况。本文详解了该缺陷检测的流程并附有相关代码。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

Github代码连接:https://github.com/malakar-soham/cnn-in-welding

目录

-

介绍 -

先决条件 -

图像分割 -

图像矩 -

了解数据 -

使用的方法和算法 -

结果 -

参考

1. 介绍

焊接缺陷可以定义为焊接零件中出现的焊接表面不规则、不连续、缺陷或不一致。焊接接头的缺陷可能导致零件和组件的报废、昂贵的维修费用、工作条件下的性能显著降低,以及在极端情况下,还会导致财产和生命损失的灾难性故障。

此外,由于焊接技术的固有缺陷和金属的特性,在焊接过程中总会存在一定的缺陷。

由于固有的冶金几何缺陷、机械性能的不均匀性和残余应力的存在,焊接接头通常是裂纹萌生的位置,因此评估焊接质量非常重要。

在实践中,几乎不可能获得完美的焊接,并且在大多数情况下,没有必要提供所需的足够的维修功能。然而,早发现和隔离措施总是比事故更可取的。

使用我们的算法,我们可以通过图像轻松检测焊接故障,并精确测量每个故障的严重程度,这将进一步有助于加快图像识别速度并避免出现不利情况。

研究发现,使用卷积神经网络算法和 U-Net 架构使该过程更加高效,工作结束时准确率为 98.3%。

2. 先决条件

-

对机器学习的基本理解

-

卷积神经网络的基本思想

-

了解卷积、最大池化和上采样操作

-

U-Net架构思路

-

对残差块中的跳过连接的基本理解(可选)

-

使用 Python、TensorFlow 和 Keras 库的 ConvNets 的工作知识(可选)

3. 图像分割

分割将图像划分为包含具有相似属性的像素的不同区域。为了对图像分析和解释有意义且有用,区域应与所描绘的对象或感兴趣的特征密切相关。

图像分析的成功取决于分割的可靠性,但图像的准确分割通常是一个非常具有挑战性的问题。

4. 图像矩

图像矩是图像像素强度的某个特定加权平均值,图像矩对于描述分割后的对象很有用。

通过图像矩发现的图像的简单属性包括:

-

面积(或总强度)

-

质心

-

有关其方向的信息。

5. 了解数据

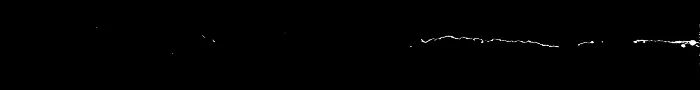

该数据集包含两个目录,原始图像存储在“images”目录中,分割图像存储在“labels”目录中。

让我们将数据可视化:

上面的这些原始图像是 RGB 图像,必须用于训练模型和测试模型。这些图片的尺寸各不相同。直观地说,较暗的部分是焊接缺陷,模型需要对这些图像进行图像分割。

'labels' 目录中的这些图像是二进制图像或地面真实标签。这是我们的模型必须为给定的原始图像预测的内容。在二值图像中,像素具有“高”值或“低”值,白色区域或“高”值表示缺陷区域,黑色区域或“低”值表示无缺陷。

6. 使用的方法和算法

我们将 U-Net 架构解决这个问题。我们将通过三个主要步骤检测故障并测量这些焊接图像的严重程度:

-

图像分割

-

使用颜色表示严重性

-

使用图像矩测量严重性

训练模型

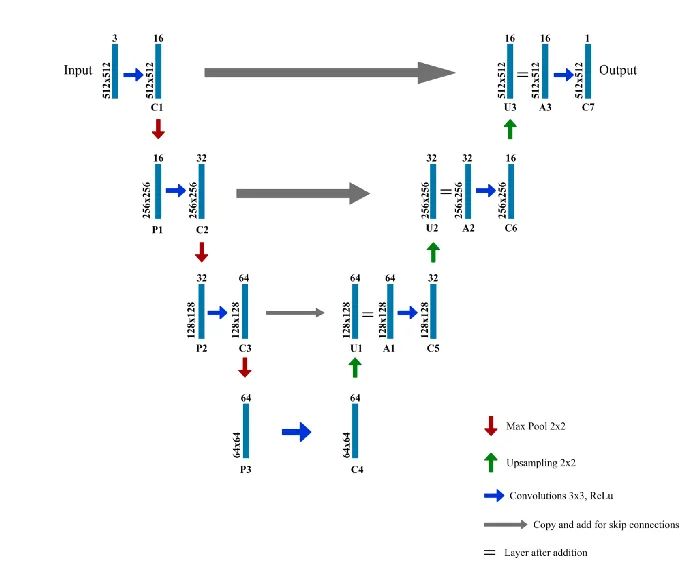

以下是我们用于模型的 U-Net 架构:

注意事项:

-

每个蓝色框对应一个多通道特征图

-

通道的数量显示在框的顶部。

-

(x,y) 尺寸位于框的左下边缘。

-

箭头表示不同的操作。

-

图层的名称在图层下方提供。

-

C1、C2、…… C7是卷积运算后的输出层

-

P1、P2、P3是最大池化操作的输出层

-

U1、U2、U3是上采样操作的输出层

-

A1、A2、A3 是跳跃式连接。

-

左侧是收缩路径,其中应用了常规卷积和最大池化操作

-

图像的大小逐渐减小,而深度逐渐增加。

-

右侧是扩展路径,其中应用了 (上采样) 转置卷积和常规卷积操作

-

在扩展路径中,图像尺寸逐渐增大,深度逐渐减小

-

为了获得更精确的位置,在扩展的每个步骤中,我们通过将转置卷积层的输出与来自编码器的特征图在同一级别连接来使用跳过连接:

A1 = U1 + C3

A2 = U2 + C2

A3 = U3 + C1

每次连接后,我们再次应用常规卷积,以便模型可以学习组装更精确的输出。

import numpy as np

import cv2

import os

import random

import tensorflow as tf

h,w = 512,512

def create_model():

inputs = tf.keras.layers.Input(shape=(h,w,3))

conv1 = tf.keras.layers.Conv2D(16,(3,3),activation='relu',padding='same')(inputs)

pool1 = tf.keras.layers.MaxPool2D()(conv1)

conv2 = tf.keras.layers.Conv2D(32,(3,3),activation='relu',padding='same')(pool1)

pool2 = tf.keras.layers.MaxPool2D()(conv2)

conv3 = tf.keras.layers.Conv2D(64,(3,3),activation='relu',padding='same')(pool2)

pool3 = tf.keras.layers.MaxPool2D()(conv3)

conv4 = tf.keras.layers.Conv2D(64,(3,3),activation='relu',padding='same')(pool3)

upsm5 = tf.keras.layers.UpSampling2D()(conv4)

upad5 = tf.keras.layers.Add()([conv3,upsm5])

conv5 = tf.keras.layers.Conv2D(32,(3,3),activation='relu',padding='same')(upad5)

upsm6 = tf.keras.layers.UpSampling2D()(conv5)

upad6 = tf.keras.layers.Add()([conv2,upsm6])

conv6 = tf.keras.layers.Conv2D(16,(3,3),activation='relu',padding='same')(upad6)

upsm7 = tf.keras.layers.UpSampling2D()(conv6)

upad7 = tf.keras.layers.Add()([conv1,upsm7])

conv7 = tf.keras.layers.Conv2D(1,(3,3),activation='relu',padding='same')(upad7)

model = tf.keras.models.Model(inputs=inputs, outputs=conv7)

return model

images = []

labels = []

files = os.listdir('./dataset/images/')

random.shuffle(files)

for f in files:

img = cv2.imread('./dataset/images/' + f)

parts = f.split('_')

label_name = './dataset/labels/' + 'W0002_' + parts[1]

label = cv2.imread(label_name,2)

img = cv2.resize(img,(w,h))

label = cv2.resize(label,(w,h))

images.append(img)

labels.append(label)

images = np.array(images)

labels = np.array(labels)

labels = np.reshape(labels,

(labels.shape[0],labels.shape[1],labels.shape[2],1))

print(images.shape)

print(labels.shape)

images = images/255

labels = labels/255

model = tf.keras.models.load_model('my_model')

#model = create_model() # uncomment this to create a new model

print(model.summary())

model.compile(optimizer='adam', loss='binary_crossentropy',metrics=['accuracy'])

model.fit(images,labels,epochs=100,batch_size=10)

model.evaluate(images,labels)

model.save('my_model')

模型是用 Adam 优化器编译的,我们使用二进制交叉熵损失函数,因为只有两个类(缺陷和无缺陷)。

我们使用批量处理大小为 10 的 100 个 epoch(模型在所有输入上运行的次数)。

测试模型

由于模型的输入尺寸为 512x512x3 ,因此我们已将输入大小调整为该尺寸。接下来,我们通过将图像除以 255 来规范化图像以加快计算速度。

图像已被输入模型,用于预测二进制输出。为了放大像素的强度,二进制输出乘以 1000。

然后将图像转换为 16 位整数以便于图像处理。之后,算法会检测缺陷并通过颜色分级以及根据缺陷的严重程度为具有缺陷的像素分配权重,来直观地标记缺陷的严重程度。然后,考虑加权像素在该图像上计算图像矩。

图像最终转换回 8 位整数,输出图像显示颜色分级及其严重性值。

import numpy as np

import cv2

from google.colab.patches import cv2_imshow

import os

import random

import tensorflow as tf

h,w = 512,512

num_cases = 10

images = []

labels = []

files = os.listdir('./dataset/images/')

random.shuffle(files)

model = tf.keras.models.load_model('my_model')

lowSevere = 1

midSevere = 2

highSevere = 4

for f in files[0:num_cases]:

test_img = cv2.imread('./dataset/images/' + f)

resized_img = cv2.resize(test_img,(w,h))

resized_img = resized_img/255

cropped_img = np.reshape(resized_img,

(1,resized_img.shape[0],resized_img.shape[1],resized_img.shape[2]))

test_out = model.predict(cropped_img)

test_out = test_out[0,:,:,0]*1000

test_out = np.clip(test_out,0,255)

resized_test_out = cv2.resize(test_out,(test_img.shape[1],test_img.shape[0]))

resized_test_out = resized_test_out.astype(np.uint16)

test_img = test_img.astype(np.uint16)

grey = cv2.cvtColor(test_img, cv2.COLOR_BGR2GRAY)

for i in range(test_img.shape[0]):

for j in range(test_img.shape[1]):

if(grey[i,j]>150 & resized_test_out[i,j]>40):

test_img[i,j,1]=test_img[i,j,1] + resized_test_out[i,j]

resized_test_out[i,j] = lowSevere

elif(grey[i,j]<100 & resized_test_out[i,j]>40):

test_img[i,j,2]=test_img[i,j,2] + resized_test_out[i,j]

resized_test_out[i,j] = highSevere

elif(resized_test_out[i,j]>40):

test_img[i,j,0]=test_img[i,j,0] + resized_test_out[i,j]

resized_test_out[i,j] = midSevere

else:

resized_test_out[i,j] = 0

M = cv2.moments(resized_test_out)

maxMomentArea = resized_test_out.shape[1]*resized_test_out.shape[0]*highSevere

print("0th Moment = " , (M["m00"]*100/maxMomentArea), "%")

test_img = np.clip(test_img,0,255)

test_img = test_img.astype(np.uint8)

cv2_imshow(test_img)

cv2.waitKey(0)

7. 结果

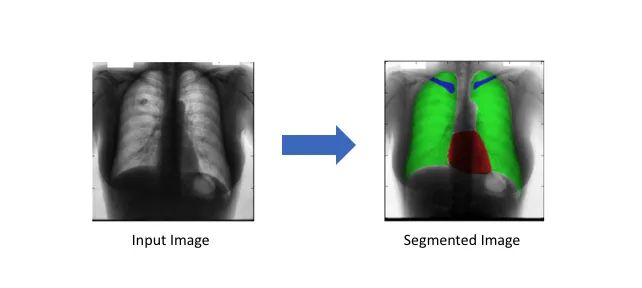

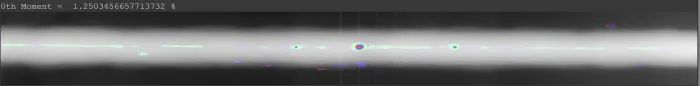

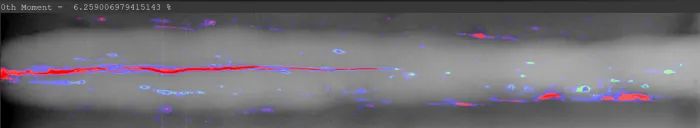

我们用于严重性检测的视觉指标是颜色,在图像中,颜色为:

-

绿色表示存在严重缺陷的区域。

-

蓝色表示缺陷更严重的区域。

-

红色表示最严重的缺陷区域。

第0个时刻以百分比的形式显示在输出图像旁边,作为严重性的经验度量。以下是三个随机样本,显示了原始输入、真实情况和模型生成的输出。

示例 1:

示例 2:

示例 3:

参考

-

https://domingomery.ing.puc.cl/material/gdxray/ -

https://www.cs.auckland.ac.nz/courses/compsci773s1c/lectures/ImageProcessing-html/topic3.htm#adaptive -

https://medium.com/r/?url=https%3A%2F%2Fen.wikipedia.org%2Fwiki%2FImage_moment -

https://medium.com/r/?url=https%3A%2F%2Ftowardsdatascience.com%2Funderstanding-semantic-segmentation-with-unet-6be4f42d4b47 -

https://www.sciencedirect.com/topics/materials-science/welding-defect

公众号后台回复“数据集”获取30+深度学习数据集下载~

# CV技术社群邀请函 #

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~