【干货】近年火爆的Attention模型,它的套路这里都有!

【文末有彩蛋!】

推荐阅读时间:8min~13min

主要内容:简介明了的讲解一些Attention Model的套路和理论

---------------------------------------------

作者:YBB

单位:清华大学研究生

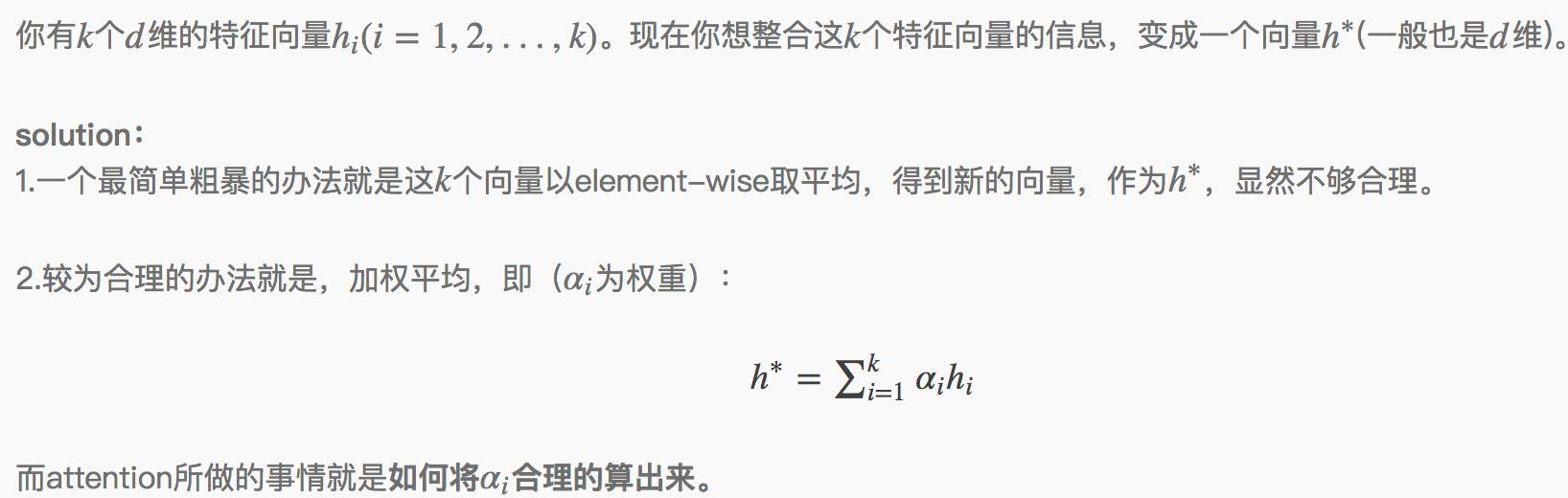

attention其实就是一个加权平均。

attention处理的问题,往往面临的是这样一个场景:

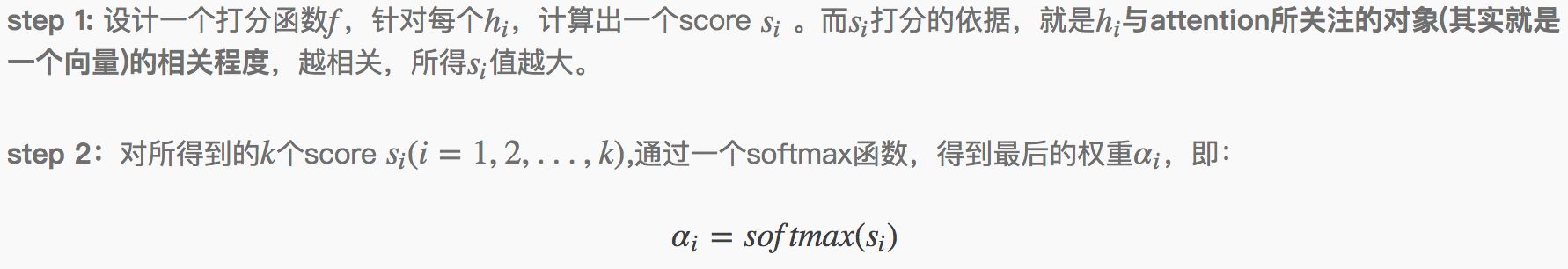

如何计算得到alpha(i),一般分为两个步骤:

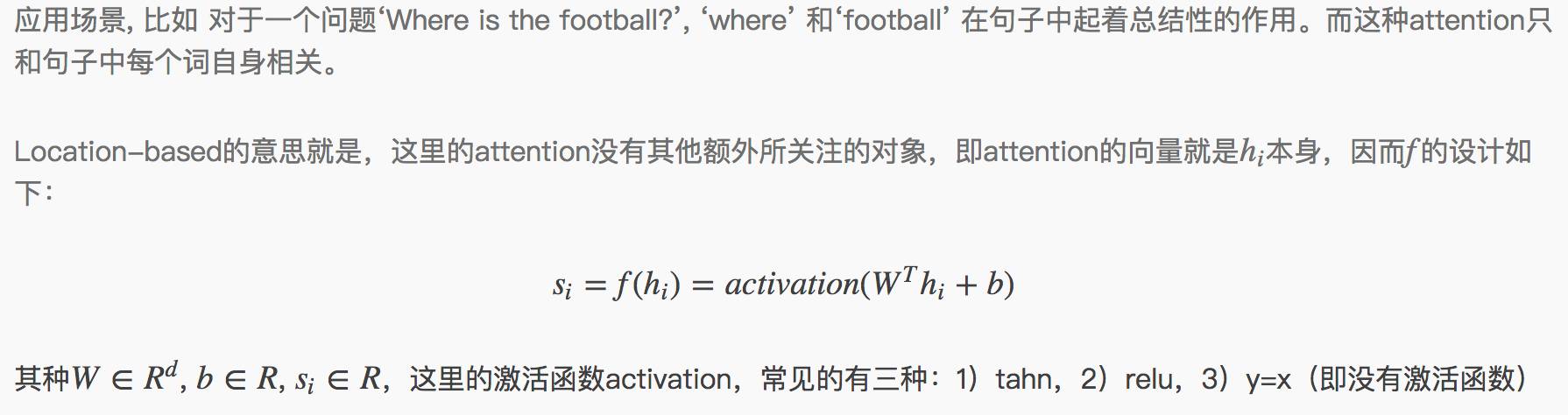

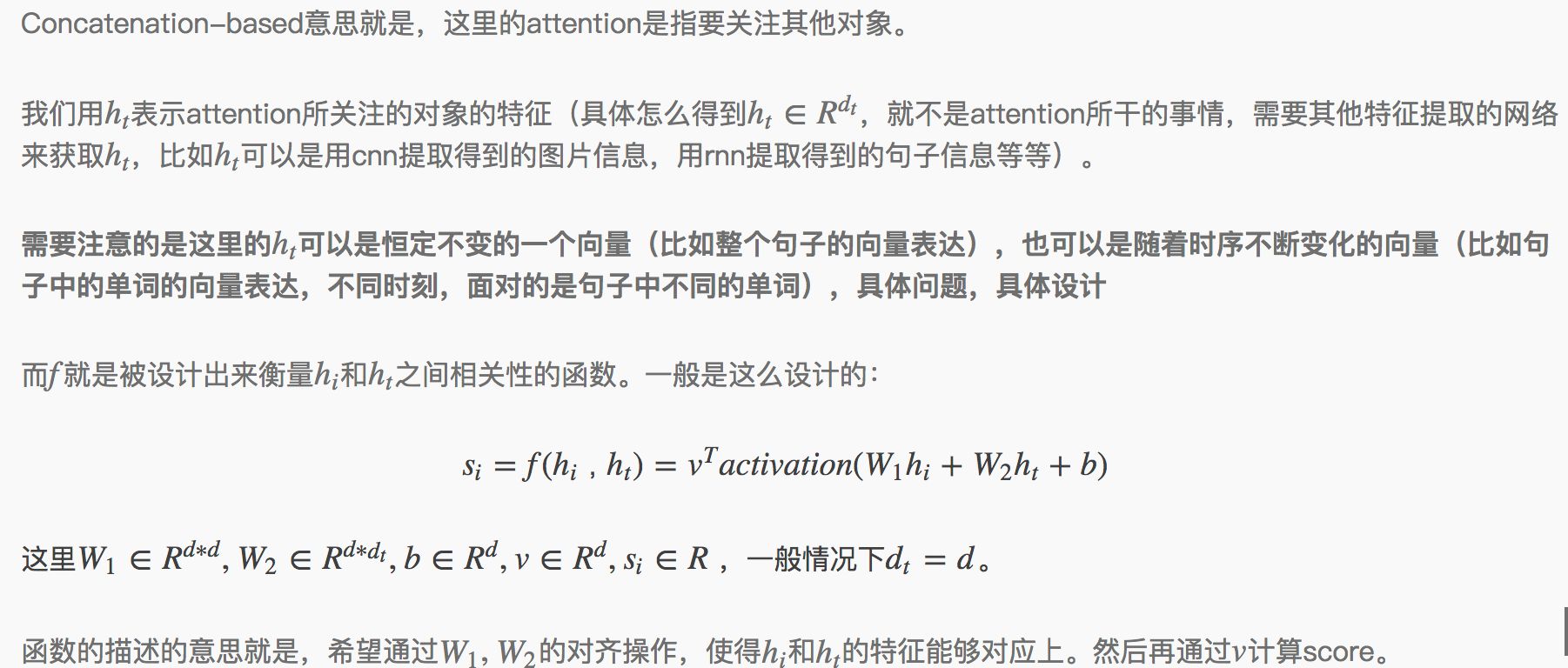

那么如何设计step 1中的打分函数

其中General Attention并不常见,(可能笔者读的paper不够多,目前还没有遇到过)因此在这里不做介绍。接下来详细介绍下Location-based Attention和Concatenation-based Attention的设计。

具体我们来举几个例子,可能具体实现上,有略微区别,不过都大同小异:

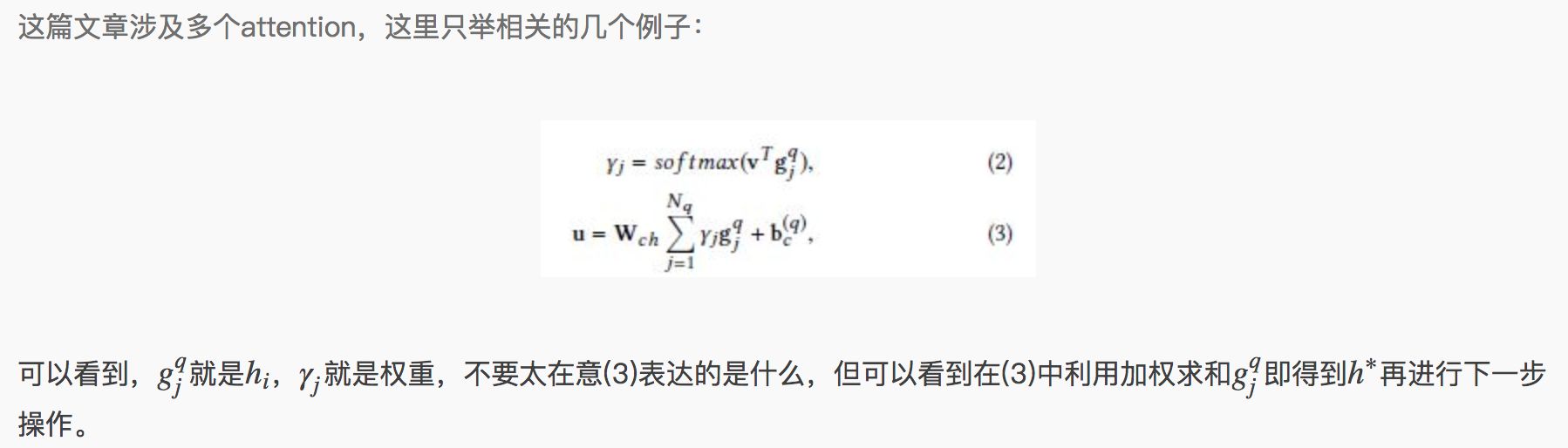

Example 1:A Context-aware Attention Network for Interactive Interactive Question Answering_KDD2017

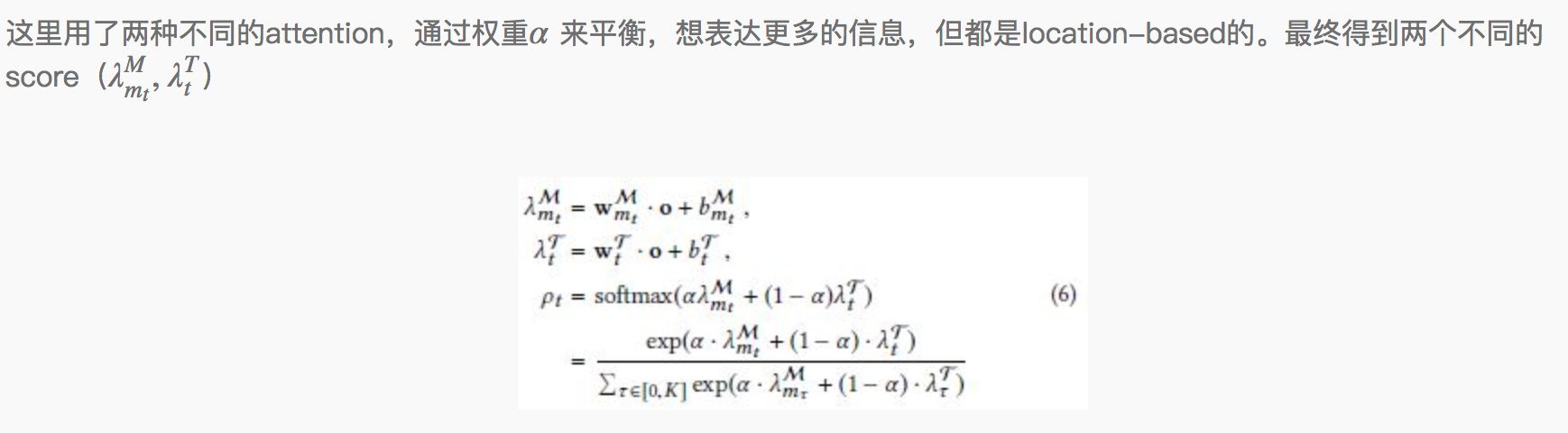

Example 2:Dynamic Attention Deep Model for Article Recommendation by Learning Human Editors’ Demonstration_KDD2017

转自:机器学习算法与自然语言处理

完整内容请点击“阅读原文”