LeCun最近在推特上表示,他的一篇文章已被NeurIPS 2021拒绝,但他依然非常自豪:「问题不在于NeurIPS,而在于新兴领域顶会的筛选做法」。尽管LeCun表达了他对双盲评审的认可,关于双盲评审是否是一件好事的讨论仍在继续。>>加入极市CV技术交流群,走在计算机视觉的最前沿

要说最近什么话题热度高,那肯定少不了图灵奖得主Yann Andre LeCun的文章被NeurIPS 2021拒稿了。

在论文上传到arXiv之后,LeCun便去Twitter和Facebook做了宣传,在拒稿之后更是Twitter、Facebook、LinkedIn齐发。LeCun表示,因为是「双盲」的原因,所以审稿人并不知道论文的作者。

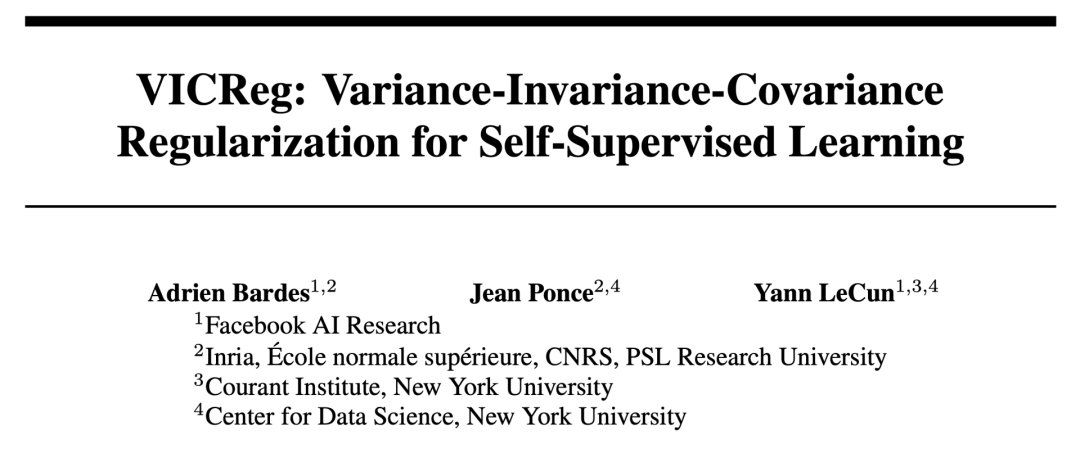

这篇题为:「VICReg: Variance-Invariance-Covariance Regularization for Self-Supervised Learning」的论文,自5月以来已收到12次引用。

https://arxiv.org/pdf/2105.04906.pdf

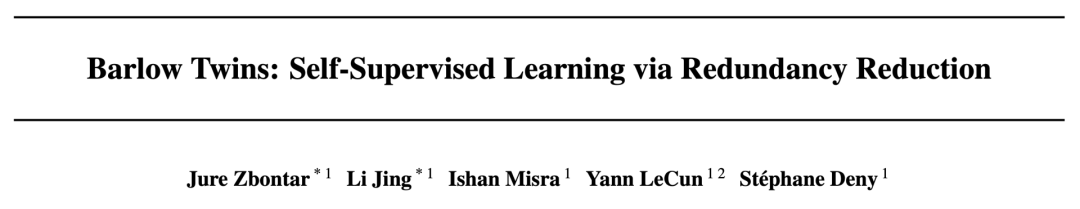

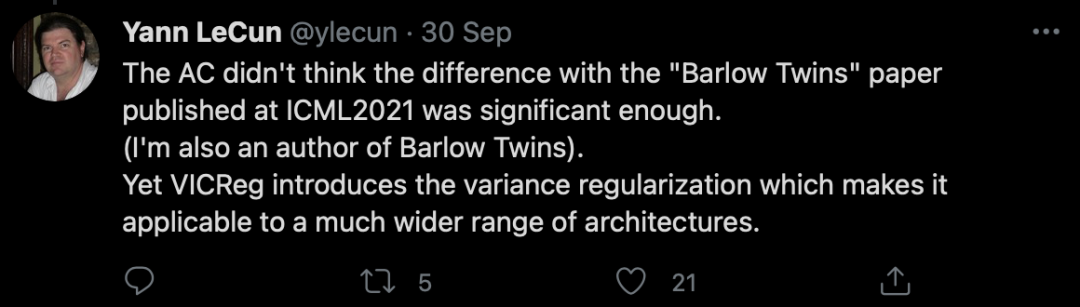

NeurIPS给出的拒稿理由是「VICReg」与发表在ICML2021上的「Barlow Twins」差异不大。

https://arxiv.org/pdf/2103.03230.pdf

然而LeCun认为,相比而言,VICReg引入了方差正则化,使其可以适用于更广泛的架构。

不过,VICReg「精心设计」的3项损失函数中,除了「方差项」是创新以外,「不变项」是经典约束项,「协方差项」则借鉴了自己之前的论文Barlow Twins。

众所周知,Yann LeCun是纽约大学Courant数学科学研究所的教授,也是Facebook的副总裁、首席人工智能科学家,美国国家科学和工程院以及国家工程院的成员。

作为公认的卷积网络(CNN)之父,LeCun在人工智能、机器学习、深度学习、计算机视觉、智能数据分析、数据挖掘、数据压缩和机器人等方面具有着丰富的学术和工业经验。

此外,LeCun也是DjVu图像压缩技术和Lush编程语言的共同创造者。

自然,这样一位人物的论文被拒确实有些出乎意料,也让学术界和人工智能领域的不少人感到震惊。

对于LeCun被拒稿,有网友表示不解:「考虑到Yann LeCun在AI界的成就,NeurIPS 2021的审稿人有可能拒绝LeCun教授写的论文吗?」

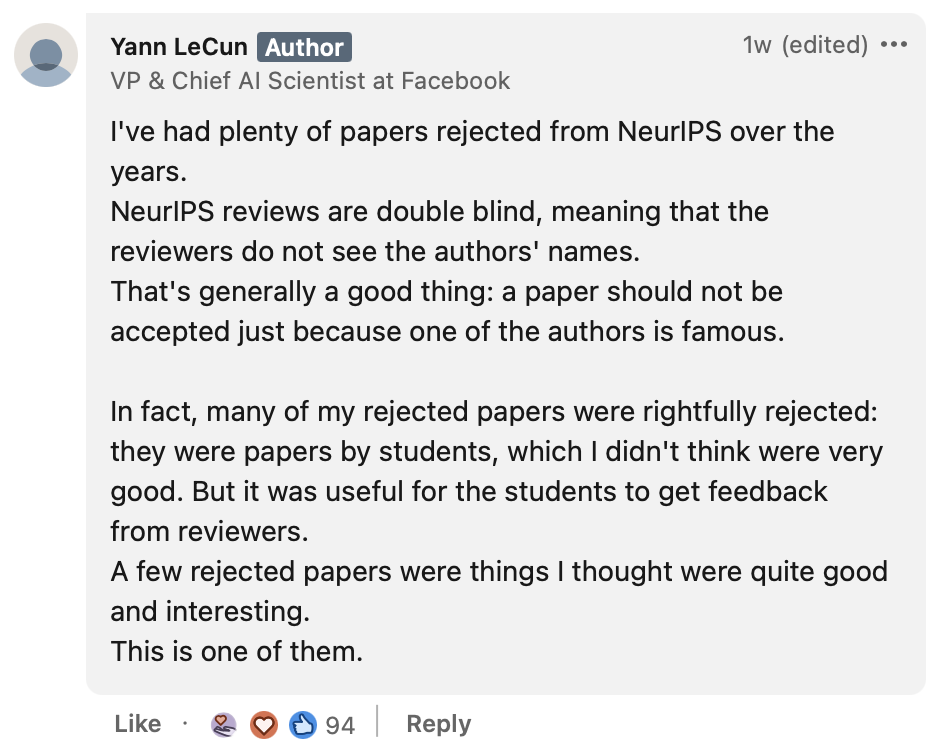

LeCun则表示:「这些年我有许多论文都被NeurIPS拒了。NeurIPS的评审是以双盲的方式进行的,这意味着评审员不知道作者的身份。这是件好事,一篇论文不应该仅仅因为其中一位作者的名气而被接受。此外,对于写论文的学生来说,接受审稿人的意见是非常有益的。不过,在被拒绝的文章中,有一些是我认为非常好、非常吸引人的,例如这一篇。」

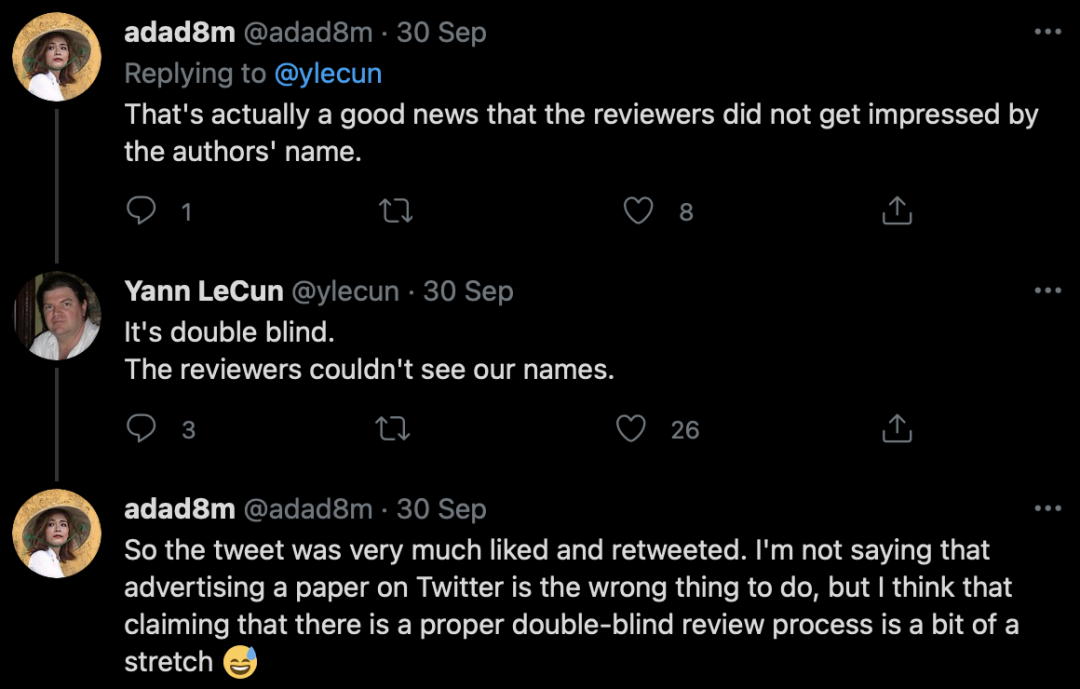

虽然NeurIPS采用「双盲审」的机制,但是网友犀利地指出,LeCun发的这条推文得到了很多人的点赞和转发。在此声称这是一个适当的双盲审过程实在有点牵强。

双盲同行评审,即作者和审稿人双方都保持匿名,只有编辑才知道各方的身份。

但如果通过媒体大肆宣扬你的工作,那就让盲审失去了本来的意义!

为啥呢?如果你作为评审人接触到了一个拥有大量追随者和资源,并同时进行社交媒体推广的作者的作品,你会不由自主被影响「那么多人觉得这是一个好工作,这应该不会太差吧」,这样一来,对追随者较少或不参加此类社交推广活动的作者自然是不公平。

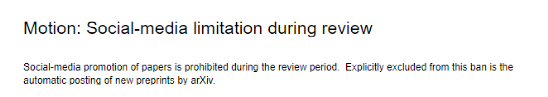

今年的 CVPR 2021的PAMI TC会议上提出了一条动议,主要内容是:

在审查期间,禁止在社交媒体上宣传论文。被排除在这一禁令之外的是 arXiv 自动发布的新预印本。

LeCun立刻就提出了反对:「限制交流会阻碍学术进步,而且违背道德规范。CVPR的这项新政策疯了!」

那么这次LeCun的论文被拒稿,到底是不是评审人成功地遵守了「双盲」的原则呢?

最近正好有一篇由谷歌和剑桥大学的研究人员撰写的关于NeurIPS 2014同行评审结果的研究。

https://arxiv.org/pdf/2109.09774.pdf

论文重新审视了2014年的NeurIPS,结果表明评审员质量分数的变化有50%是主观因素造成的。

作者发现在过去的七年中,对于被接受的论文来说,质量分数和论文的影响力之间没有任何关联;而对于被拒绝的论文来说,二者之间则存在关联。

简而言之,从NeurIPS 2014的结果来看,会议的评审过程有利于「差论文」的识别,但不利于发现「好论文」。

LeCun对此表示,「问题不在于NeurIPS,而是在高速成长的领域中,有高选择标准的会议的审查习惯所带来的的一个普遍问题」。

于是,问题似乎又回到了原点。一边是在社交媒体大肆宣传自己的论文,一边是难以判断优质论文的主观评审。

LeCun的推特下有人评论道:即使这篇论文被拒,但这篇论文也因为「Yann LeCun论文被拒」这一消息得到了比大多数NeurlPS论文都要多的关注机会。

LeCun认为「这篇文章是值得阅读的,因为它已经得到了比大多数NeurlPS论文都多的引用次数」。

针对引用次数是否能代表论文质量这一问题,Reddit的网友也展开了激烈的讨论,有博主认为「一篇文章已经被引用了12次,然而在得到官方发表的时候还是十分艰难,这说明传统的会议和发表流程周期实在太长了,这个非常值得关注的问题」。

「质量不高的论文引用数比高质量论文多这种事也经常发生,倒不是说LeCun这篇不行,只是12次引用这种东西其实并不能说明太多问题。」

「在一个新论文层出不穷的领域,你觉得作者在引用他人文章前会把这篇文章好好看再细细品吗?当然不会。」

「LeCun可能产出垃圾文章但是收获一堆引用,如果一个无名小卒的论文得到了很多引用,却没有发表机会,这就完全是另一码事了。」

原博主认同「引用数和论文质量不挂钩」,他想强调的是「实际研究进展是比论文发表要快的,所以出版和审查系统需要改进,不能总是让论文在发表前被引用这种事发生」。

下方的回答也指出了「引用未审阅的工作是真正的问题」,但仍然坚持「尽管审阅发表的流程是挺慢的,但是审阅的过程是无可替代的」。

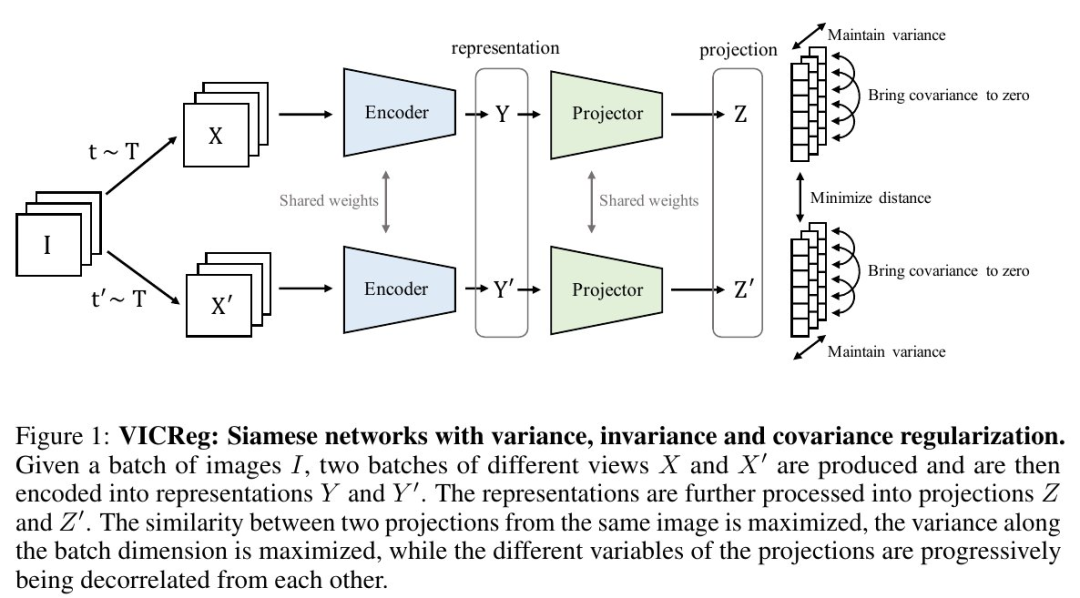

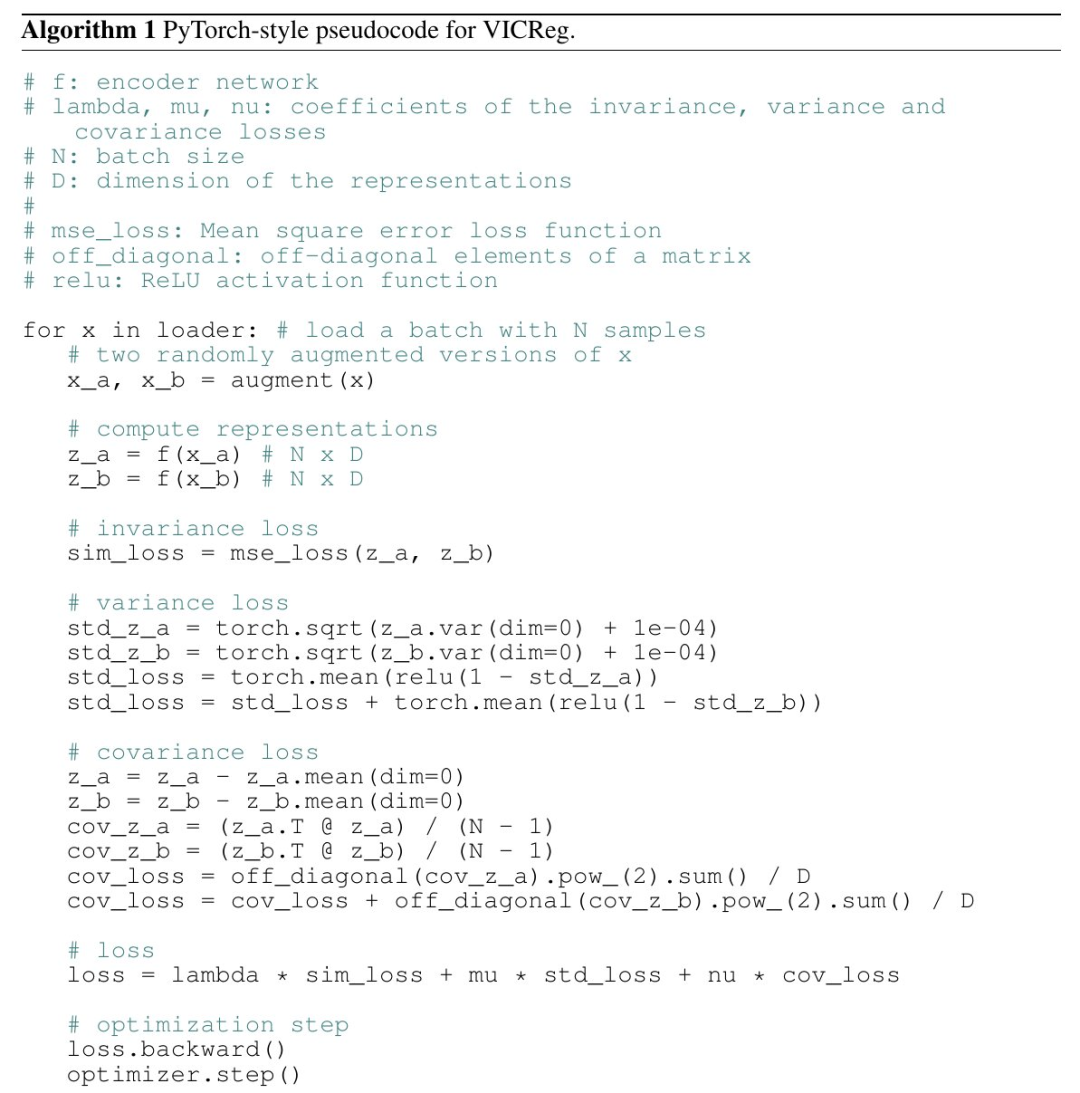

VICReg是一种非常简单有效的联合嵌入体系结构(Joint-Embedding Architectures,JEA)自监督训练图像表征学习方法,它将问题分解为三个不同的原则:用不变项学习对不同视图的不变性,用方差正则项避免表征的崩溃,用协方差正则项将信息分散到表征的不同维度。

联合嵌入体系结构(JEA)由2个可训练模型Gx(x)和Gx'(x')组成,用成对的「兼容」输入(x,x')训练。例如:x和x'是同一个图像的变形版本。

该工作解决的主要问题是模型训练时的崩溃,VICReg是为联合嵌入体系结构(JEA)精心设计的损失函数,由3项组成:

-

方差项:采用铰链损失,以维持Gx(x)和Gx'(x')的每个组成部分的标准偏差维持在一个边界以上,

这是该论文的创新之处

。

-

不变项:即||Gx(x)-Gx'(x')||^2,

这是经典的约束项

。

-

协方差项:即Gx(x)和Gx'(x')的协方差矩阵的偏离项的平方和,

此项借鉴了Barlow Twins中的思想

。

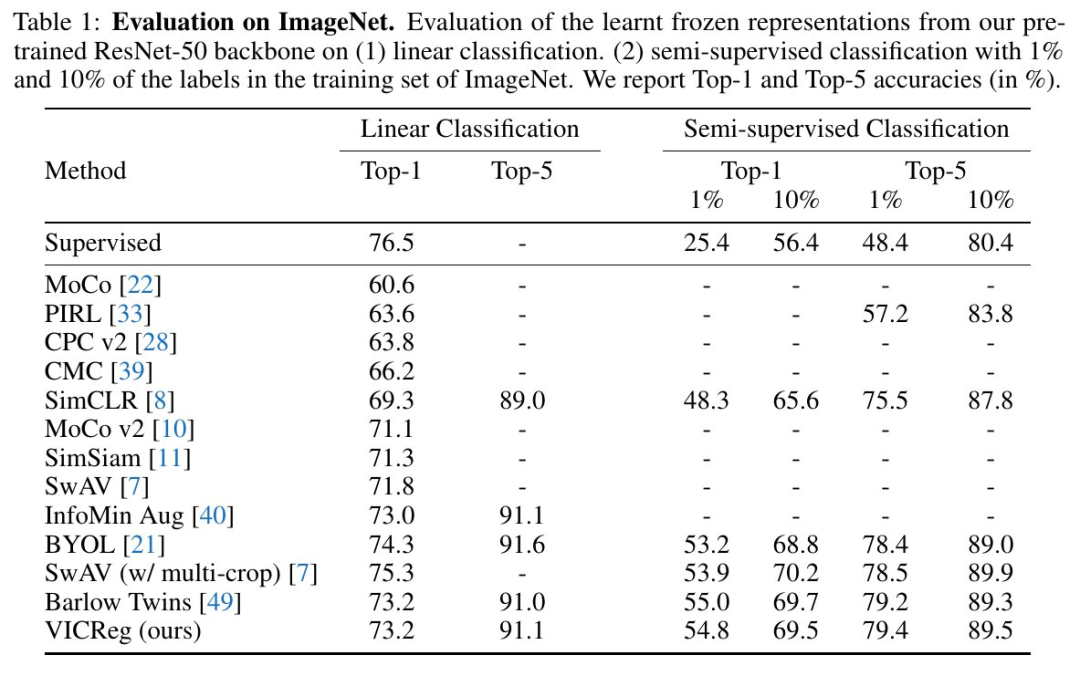

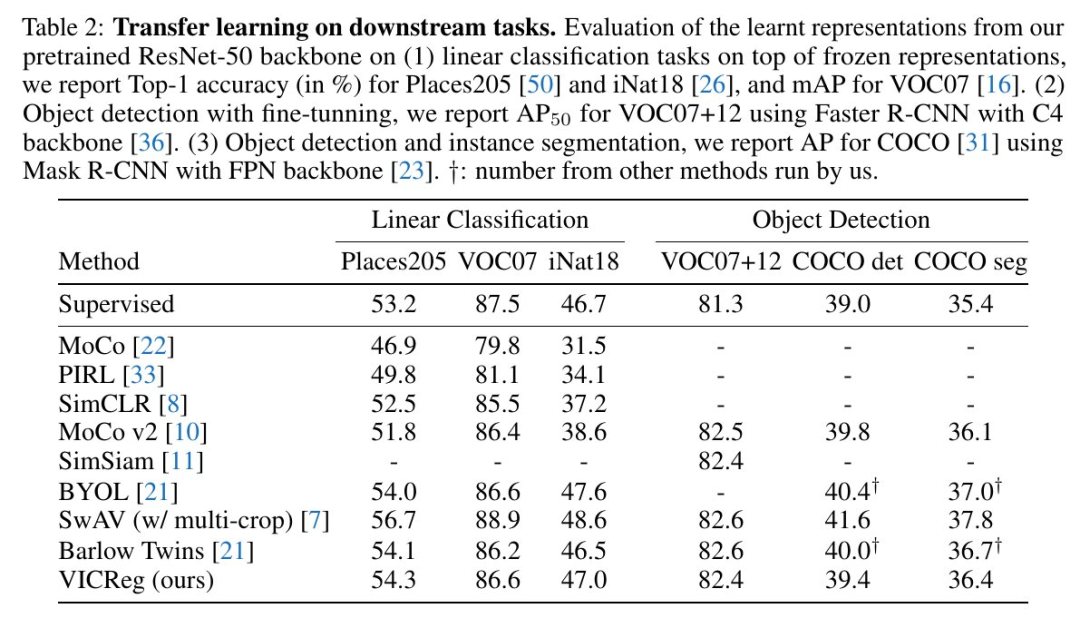

在几个下游任务中,VICReg获得了与最新技术水平相当的结果,扩展了非对照性自监督学习的前沿。

每个处理批次的协方差矩阵的计算决定了VICReg的计算和内存成本,而协方差矩阵的计算在投影向量的维度上是二次方的。实验表明,提高投影的维度可以显著提高性能,这表明需要有不依赖协方差矩阵的全部计算的替代性冗余减少方法。

VICReg使用线性分类器头在ImageNet上,在低数据状态下的半监督ImageNet上,还有在下游任务的迁移学习上,都取得了有竞争力的结果。

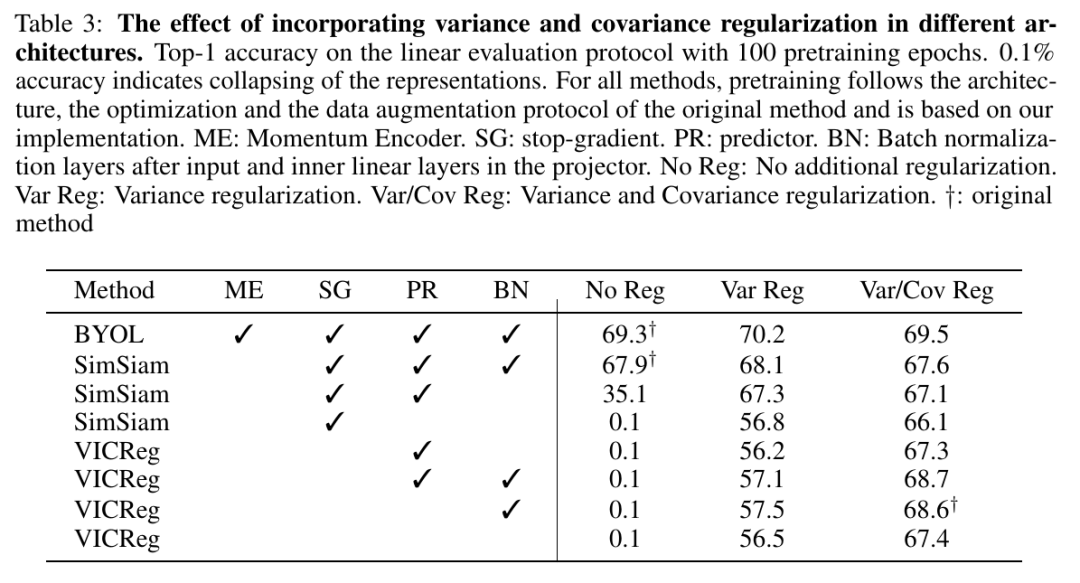

当与SimSiam等方法一起使用时,方差铰链项可以防止崩溃,还可以减少对批处理范数或预测器的需求。

-

采用简单的方差铰链损失,很好地控制模型训练时的崩溃(见PyTorch伪代码)

-

-

两个分支之间无需共享权重(尽管在实验中权重是共享的)

-

不需要平均移动权重、梯度停止、预测器、负样本挖掘,存储体,最近邻和种种量化/蒸馏手段

analyticsindiamag.com/yann-lecun-paper-rejected/

arxiv.org/pdf/2105.04906.pdf

arxiv.org/pdf/2109.09774.pdf

facebook.com/story.php?story_fbid=10157921242067143&id=722677142

linkedin.com/posts/yann-lecun-0b999_yann-lecun-activity-6850419687931592704-tWKo/

reddit.com/r/computerscience/comments/q0j4vh/yann_lecuns_paper_gets_rejected_from_neurips_2021/hf8nvvv/

twitter.com/ylecun/status/1392493077999325191

twitter.com/ylecun/status/1409393630310248452

twitter.com/ylecun/status/1443133393986748421

zhuanlan.zhihu.com/p/385382149

公众号后台回复“CVPR21检测”获取CVPR2021目标检测论文下载~

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~

觉得有用麻烦给个在看啦~

![]()