ICIP 2019 开源论文 | 基于注意力网络的RGBD图像语义分割方法

作者丨赵磊

单位丨北京林业大学硕士生

研究方向丨语义分割

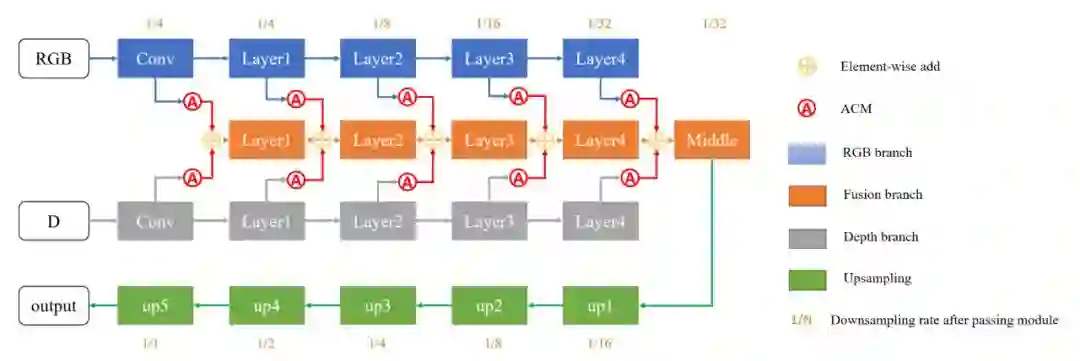

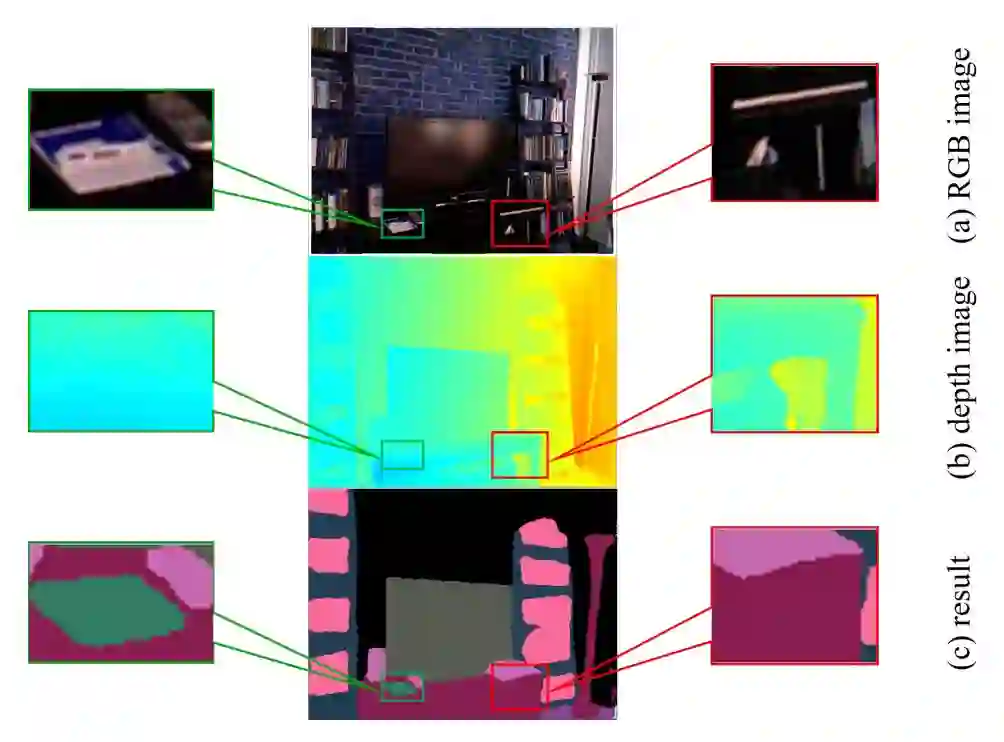

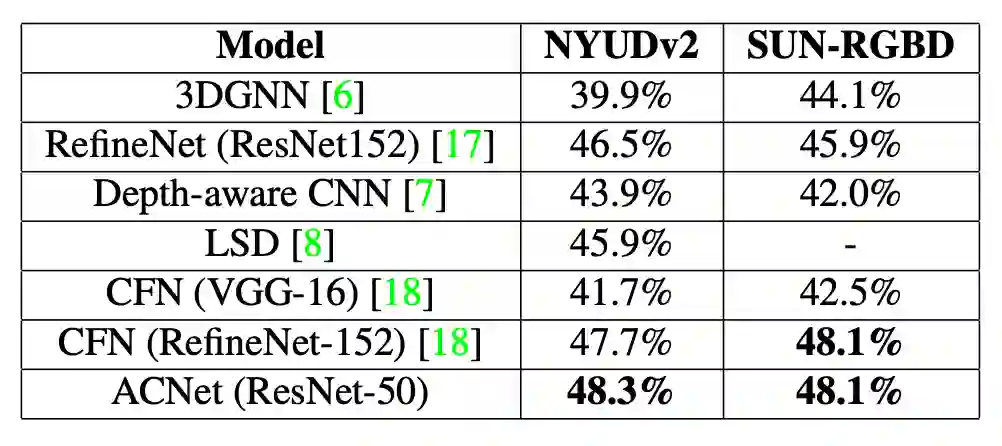

本文已经被 ICIP 2019 (2019 IEEE International Conference on Image Processing) 接收,论文提出了一种全新的方法,基于时下流行的注意力机制,用于室内场景下的 RGBD 图像语义分割——通过利用图像深度信息,获得更好的语义分割效果,在包含 40 个类别的复杂室内场景通用数据集 NYUDv2 上取得了 SOTA 效果,mIoU 达到了 48.3%,论文主要的贡献在于注意力辅助模块和三平行分支的网络架构。

背景

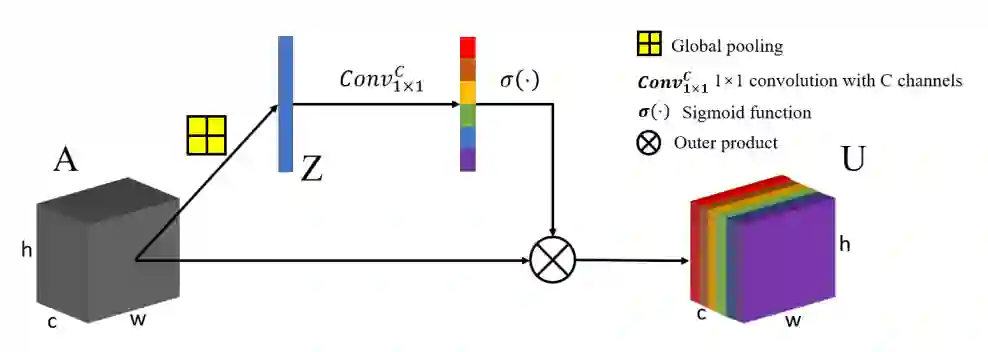

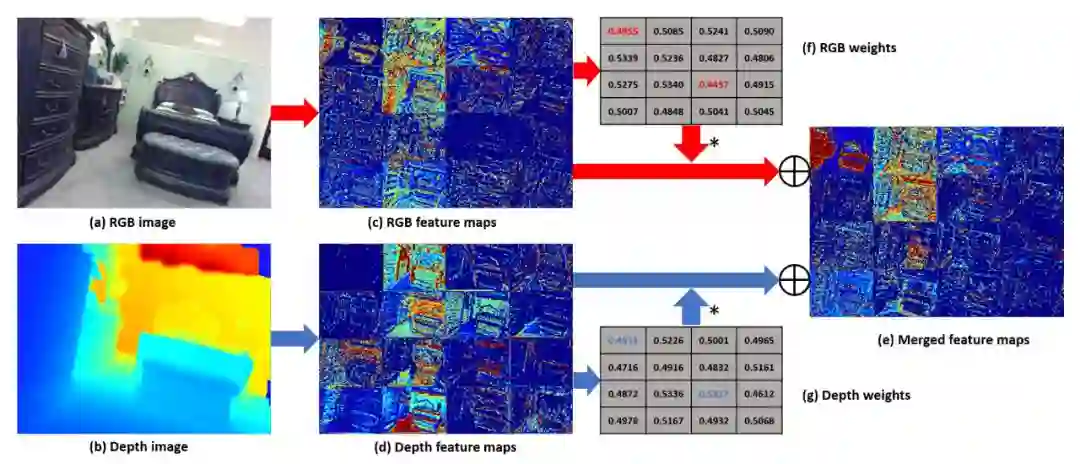

ACNet

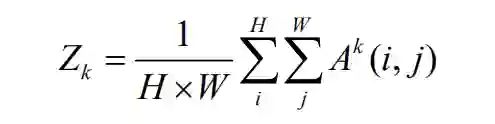

,首先应用全局平均池化,得到输出

,首先应用全局平均池化,得到输出

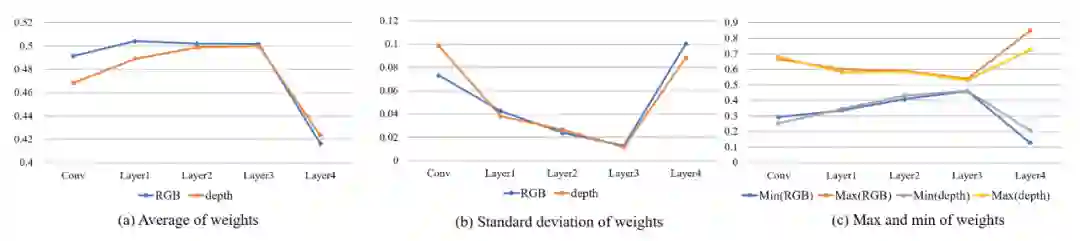

实验

总结

参考文献

[1] https://arxiv.org/abs/1905.10089

[2] https://github.com/anheidelonghu/ACNet

点击以下标题查看更多往期内容:

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

▽ 点击 | 阅读原文 | 下载论文 & 源码