【ICLR2021】彩色化变换器,Colorization Transformer

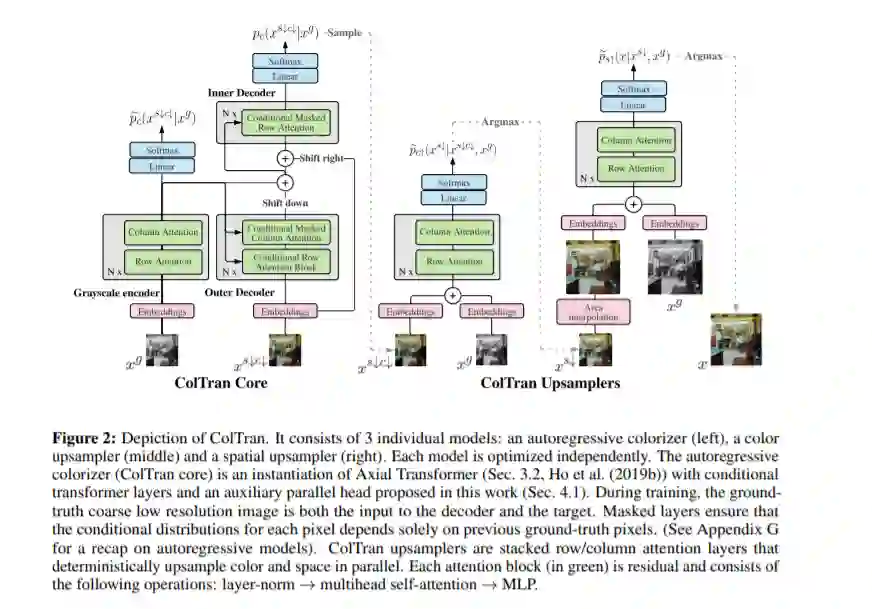

我们介绍了Colorization Transformer,这是一种基于自注意力,多样化的高保真图像着色的新颖方法。给定灰度图像,着色过程分三个步骤进行。我们首先使用条件自回归Transformer产生灰度图像的低分辨率粗色。我们的体系结构采用条件transformer层来有效调节灰度输入。随后的两个完全并行网络将粗糙的彩色低分辨率图像上采样为精细的彩色高分辨率图像。从Colorization Transformer进行采样可生成多种颜色,其保真度优于基于FID结果和在Mechanical Turk测试中的人工评估为ImageNet着色的最新技术。值得注意的是,在超过60%的情况下,人类评估师更喜欢三种生成的着色中评分最高的事实,而不是事实。

https://www.zhuanzhi.ai/paper/a362fff43be7a2b9613cfaad3fa7789b

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“ColTran” 可以获取《【ICLR2021】彩色化变换器,Colorization Transformer》专知下载链接索引

登录查看更多

相关内容

Transformer是谷歌发表的论文《Attention Is All You Need》提出一种完全基于Attention的翻译架构

专知会员服务

25+阅读 · 2020年7月1日

Arxiv

3+阅读 · 2018年3月20日