NLP 任务中有哪些巧妙的 idea?

注:图片来自网络

文章作者:邱锡鹏 复旦大学 副教授

编辑整理:Hoh Xil

内容来源:知乎@邱锡鹏

出品社区:DataFun

注:欢迎转载,转载请注明出处

导读:近期,小编在知乎中关注到了一个有意思的话题 "NLP 任务中有哪些巧妙的idea?" ,目前已经有1188+关注,40000+浏览量,今天小编就为大家分享下获得最高点赞的答案,复旦大学邱锡鹏教授的回答:

这个问题很有趣!看了下目前的回答都是深度学习之后的,我就回答几个深度学习之前的吧:

先从语义表示说起,个人觉得都是简单并且巧妙的想法 ( 但其背后的理论不一定简单 )。

1. 分布式假设 ( Distributional Hypothesis )

"Linguistic items with similar distributions have similar meanings."

直白点就是,一个词的语义可以用它的上下文表示。

对 NLP 来说,个人觉得分布式假设是来自语言学的最有价值的 "理论" 之一。

2. 词袋模型 ( Bag-of-Words )

将一篇文档看作是一个词的集合,不考虑语法,甚至是词序信息也都抛弃了。

BoW 模型解决了用机器学习来做 NLP 的一个痛点问题:怎样把一个变成的文本序列转换为定长的向量。

相关扩展:N-gram,TF-IDF 等。

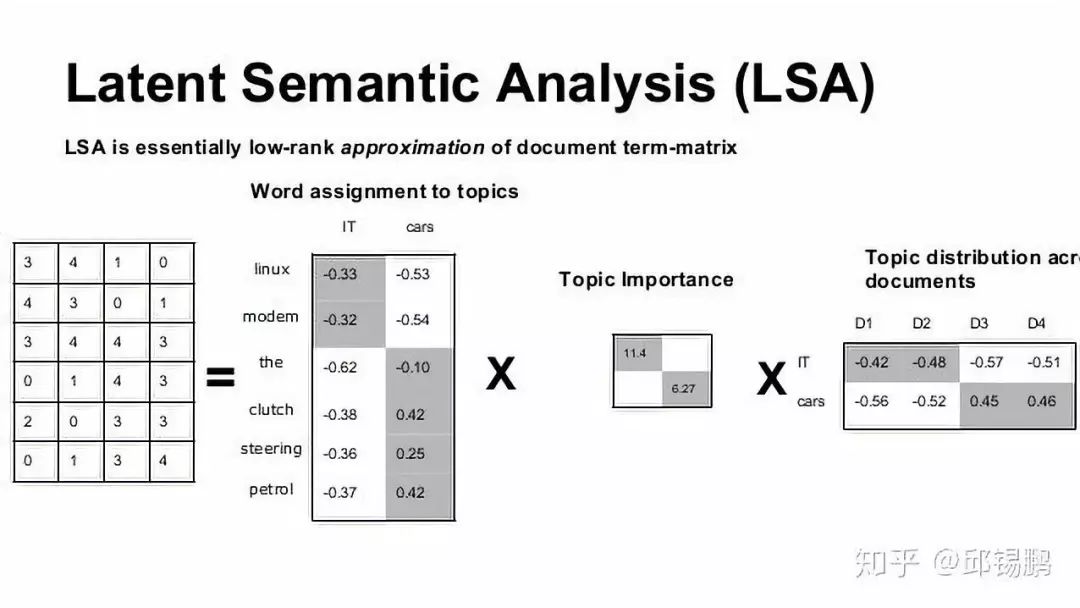

3. 潜在语义分析 ( Latent Semantic Analysis )

基于上面的分布式假设和词袋模型,我们可以构建一个词-文档矩阵 ( term-document matrix )

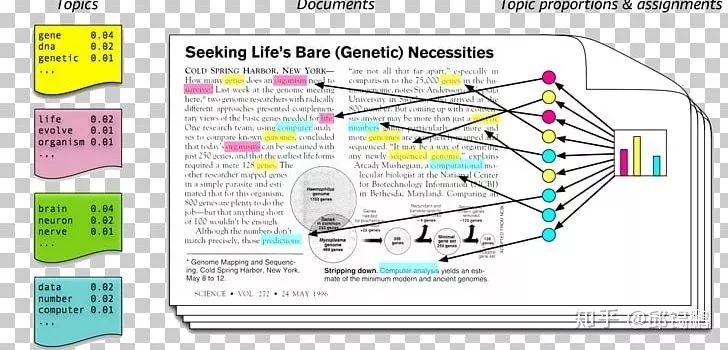

4. 概率主题模型 ( Probabilistic Topic Models )

概率主题模型比词袋模型多引入了一个 "主题 ( Topic )" 作为隐变量。词和文档的之间关联变成了:文档 -> 主题 -> 词。这个想法合情合理,听上去就更好。如果你觉得哪里不好,又可以魔改。概率主题模型的数学基础 ( 概率有向图模型 ) 十分漂亮,并且基于吉布斯采样的推断简单到不可思议,甚至不需要图模型的知识就可以理解。PTM 是前深度学习时代 NLP 领域的一个大宝矿 ( Shui Keng )!

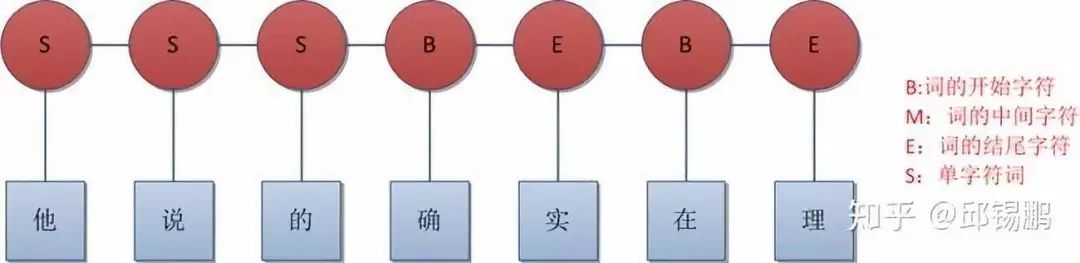

5. 基于 BMES 的中文分词或基于 BIO 的 NER/Chunking

BMES 是 Begin/Middle/End/Single 的缩写,代表所标记的字符是一个词语的开始/中间/结尾/单字词。

BIO 是 Begin/Inside/Outside 的缩写,表示所标记的词是一个实体名的开始/内部/外部。

这种标记将带有分割性质的 NLP 任务转换为序列标注任务,可以使用 HMM、CRF 等成熟的机器学习模型。

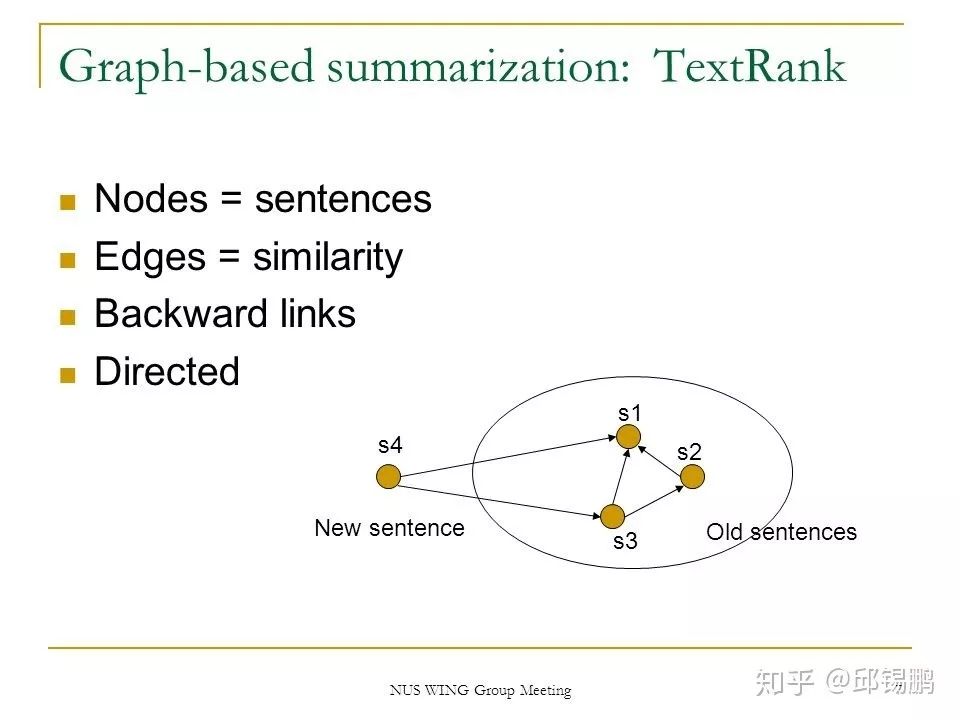

6. 基于 PageRank 的 TextRank

PageRank 本身非常巧妙了,TextRank 更是巧妙地将 PageRank 应用到 NLP 中的词排序或句子排序上面,比如关键词抽取、文本摘要等。

参考资料:

1. "Linguistic items with similar distributions have similar meanings."

https://en.wikipedia.org/wiki/Distributional_semantics

2. term-document matrix

https://en.wikipedia.org/wiki/Term-document_matrix

原文链接:

https://www.zhihu.com/question/356132676/answer/901244271

分享嘉宾

▬

——END——

文章推荐:

DataFun:

专注于大数据、人工智能领域的知识分享平台。

一个「在看」,一段时光!👇