从重参数的角度看离散概率分布的构建

©PaperWeekly 原创 · 作者 | 苏剑林

单位 | 追一科技

研究方向 | NLP、神经网络

一般来说,神经网络的输出都是无约束的,也就是值域为 ,而为了得到有约束的输出,通常是采用加激活函数的方式。例如,如果我们想要输出一个概率分布来代表每个类别的概率,那么通常在最后加上 Softmax 作为激活函数。那么一个紧接着的疑问就是:除了 Softmax,还有什么别的操作能生成一个概率分布吗?

问题定义

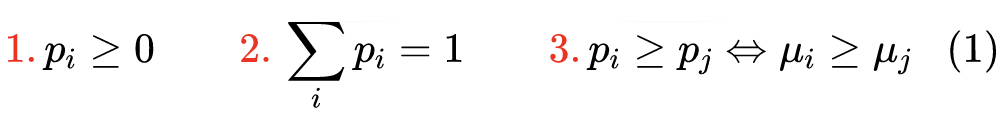

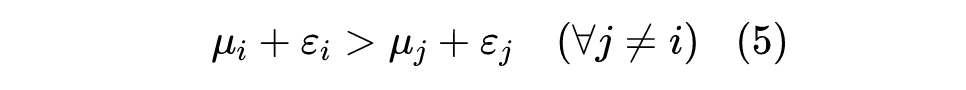

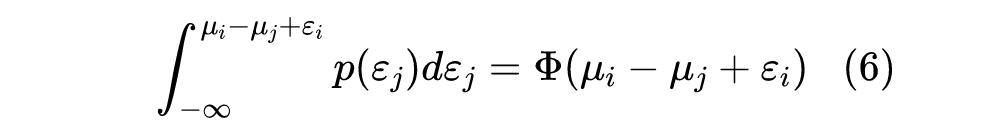

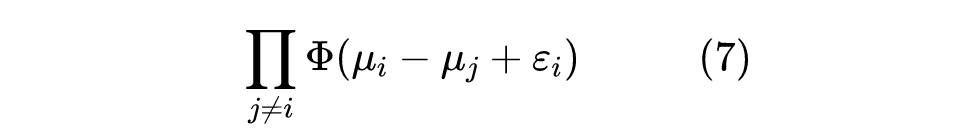

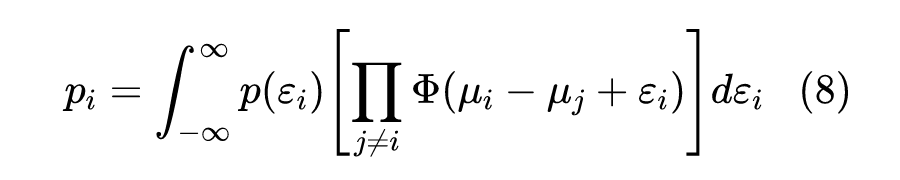

假设模型的输出向量为 ,不失一般性,这里假设 两两不等。我们希望通过某个变换 将 转换为 元概率分布 ,并保持一定的性质。比如,最基本的要求是:

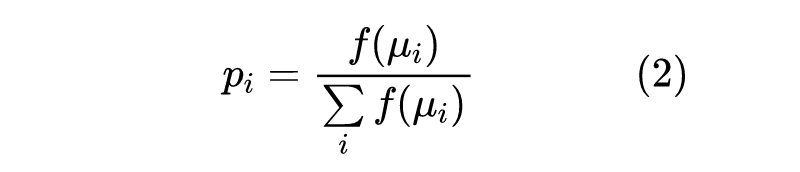

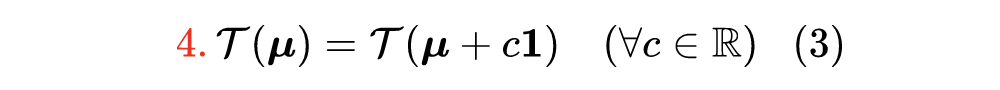

当然,这些要求都很平凡,只要 是 的单调函数(对于 Softmax 有 ),那么变换

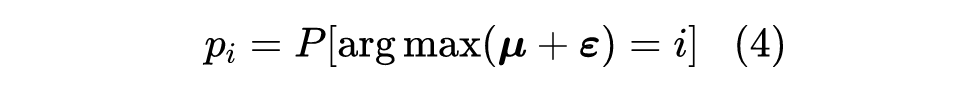

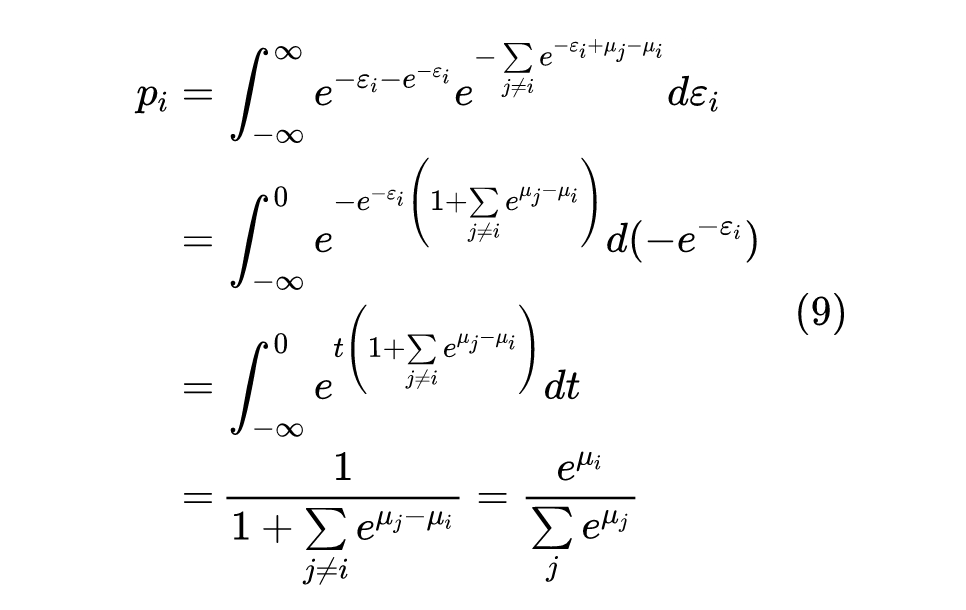

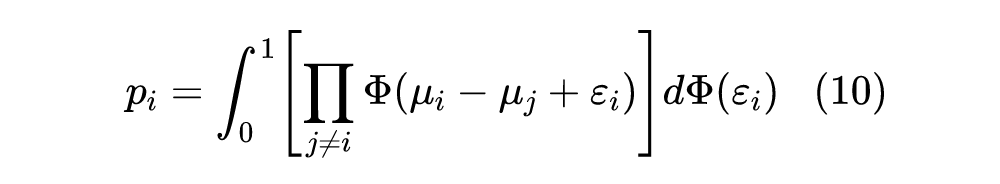

来定义变换 。由于 是独立同分布的,且整个定义只跟 有关,也就是只涉及到每个分量的相对大小,因此所定义的变换必然是满足前述4个条件的。

对照《漫谈重参数:从正态分布到 Gumbel Softmax》[1] 中关于 Gumbel Max [2] 的介绍,我们可以发现上述推导跟重参数正好相反,它是先定义了重参数的方法,然后在反向推导出对应的概率分布。

现在我们可以来重新检验一下之前的结果,即当噪声分布取 Gumbel 分布时,式(8)是否能得到常规的 Softmax 操作。Gumbel 噪声是 通过 变换而来,由于 的分布正好是 ,所以解出来 正好就是 Gumbel 分布的累积分布函数,即 ,而 就是 的导数,即 。

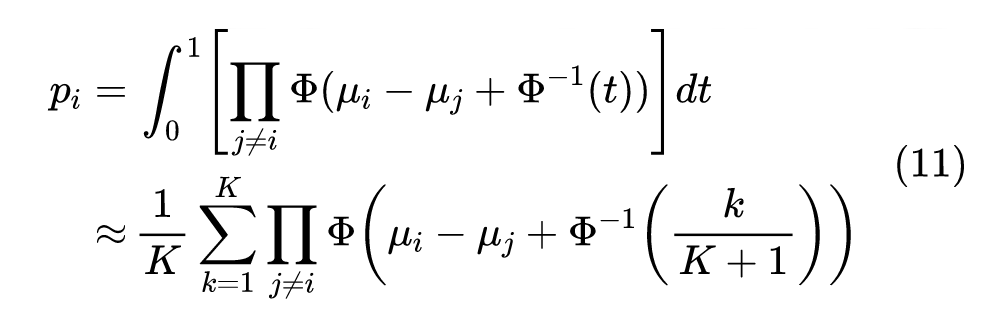

其中 是 的逆函数,在概率中也叫分位函数(Quantile Function、Percent Point Function 等)。

从上式可以看到,只要我们知道 的解析式,就可以对 进行近似计算。注意我们不需要知道 的解析式,因为采样点 的结果我们可以用其他数值方法提前计算好。

参考文献

[2] https://en.wikipedia.org/wiki/Gumbel_distribution

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧