【CVPR 2020 Oral】小样本类增量学习

文章简介:

实现对新类别进行持续增量学习的能力对于现实世界人工智能系统的发展至关重要。目前的类增量学习(CIL,class-incremental learning)研究往往提供了较为充足的带标签新类别样本,而在诸如智能相册等实际应用中,用户可能只有兴趣提供极少量有标签的新类别样本。因此研究小样本深度类增量学习迫在眉睫。在本文中,我们着重研究这个面向实际应用但极具挑战性的小样本类增量连续学习(FSCIL,few-shot class-incremental learning)问题。FSCIL要求CNN模型从少量的带标签样本中增量式地学习新的类别,而不会忘记先前学习的样本。

传统的深度类增量学习研究通常使用知识蒸馏(knowledge distillation)方法。它们通常存储一部分旧类别的样本,通过蒸馏损失函数来维持分类模型在旧类别样本上的输出。尽管在某种程度上有效,这种基于蒸馏损失的方法也存在一些问题。首先,其面临严重的类别不平衡问题,即分类器输出会严重偏置(baised)到拥有较多样本的类别上;其次,它们往往面临在新旧类之间进行性能折衷(trade-off)的困境。由于在极少样本情况下,需要认为增大学习率以及增强新类损失的梯度才能使新类别的学习变得有意义,而一旦这样做,对旧类别知识的维持就会更加困难。因此这种性能折衷困境在小样本类增量环境下会更为严重。

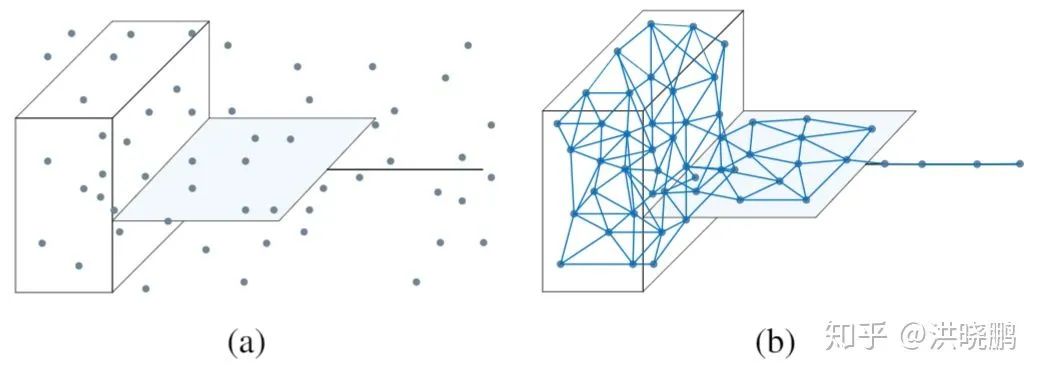

为此,我们尝试从一种新的认知启发的角度来解决小样本类增量学习问题。近期的认知学研究表明,物体的拓扑对维持已学知识的记忆非常重要。一旦记忆的拓扑特性发生改变,会导致人类对已见过物体视觉刺激的再认出现大幅退化,这直接导致了灾难性遗忘(catastrophic forgetting)的产生。为此,我们认为,保持住旧知识空间的拓扑结构,是解决灾难性遗忘的关键。因此,我们提出使用神经气体(NG,neural gas)网络来对已学知识进行抽取和表示。该网络可以学习并保留由不同类别形成的特征流形的拓扑。在此基础上,我们提出了拓扑保持知识增长器(TOPIC,TOPology-Preserving Knowledge InCrementer)框架。TOPIC框架一方面通过稳定神经气体网络NG的拓扑结构缓解了旧知识的遗忘,另一方面通过使NG成长并适应新的训练样本来改进在少量新类别样本上的表征学习。

参考链接:

https://zhuanlan.zhihu.com/p/136823964

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“FSCL” 可以获取《CVPR 2020 Oral小样本类增量学习》专知下载链接索引