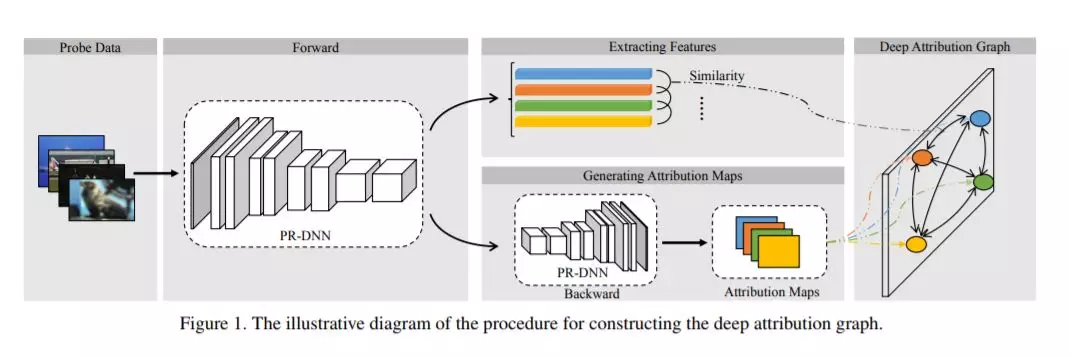

通过对异构任务的预训练深度神经网络(PR-DNNs)中编码的知识之间的内在联系,揭示了它们之间的互换性,从而使知识从一个任务转移到另一个任务,从而减少后者的训练工作量。本文提出了深度归因图(depa)来研究从PR-DNNs中学习到的知识的可转移性。在DEPARA中,节点对应于输入,并由与PR-DNN输出相关的向量化属性映射表示。边缘表示输入之间的相关性,并通过从PR-DNN中提取的特征的相似性来度量。两种PR-DNNs的知识转移能力是通过其对应基因间的相似性来衡量的。我们将DEPARA应用于转移学习中两个重要但尚未研究的问题:预先训练的模型选择和层选择。大量的实验证明了所提出的方法在解决这两个问题上的有效性和优越性。复制本文结果的代码、数据和模型可以在

成为VIP会员查看完整内容

相关内容

CVPR is the premier annual computer vision event comprising the main conference and several co-located workshops and short courses. With its high quality and low cost, it provides an exceptional value for students, academics and industry researchers.

CVPR 2020 will take place at The Washington State Convention Center in Seattle, WA, from June 16 to June 20, 2020.

http://cvpr2020.thecvf.com/

专知会员服务

29+阅读 · 2020年4月17日

专知会员服务

52+阅读 · 2020年2月8日

专知会员服务

102+阅读 · 2019年11月24日

Arxiv

5+阅读 · 2020年6月10日

Arxiv

7+阅读 · 2018年4月17日