BP反向传播矩阵推导图示详解

©PaperWeekly 原创 · 作者|孙裕道

学校|北京邮电大学博士生

研究方向|GAN图像生成、情绪对抗样本生成

背景介绍

BP(反向传播)是有 Geffrey Hinton 在 1988 年发表的论文《Learning representations by back-propagating errors》 中首次被提出来。

该论文从题目到内容到参考文献一共 2 页半,Hinton 也借此工作荣获 2018 年的图领奖。在深度学习领域,BP 的重要程度在怎么强调也不为过,本文会从矩阵的视角对 BP 进行详细推导,为了更好地理解 BP 的工作原理,本文也画了大量的示意图帮助理解。

引言

在吴恩达的斯坦福机器学习的讲义中关于 BP 原理的介绍只给出了最后的 BP 矩阵的推导结果,略去了中间的推导过程。本文会对略去的推导过程进行补全。为了减少阅读阻碍,BP 矩阵证明过程会从预备知识开始慢慢铺展开来,其中最难啃的部分就是矩阵形式的链式法则。本文文章结构和的各个章节的内容如下:

-

section 3 是一些预备知识介绍了矩阵求导的细节,如果想要看懂之后的 BP 矩阵推导这部分的两个小节一定要看明白

-

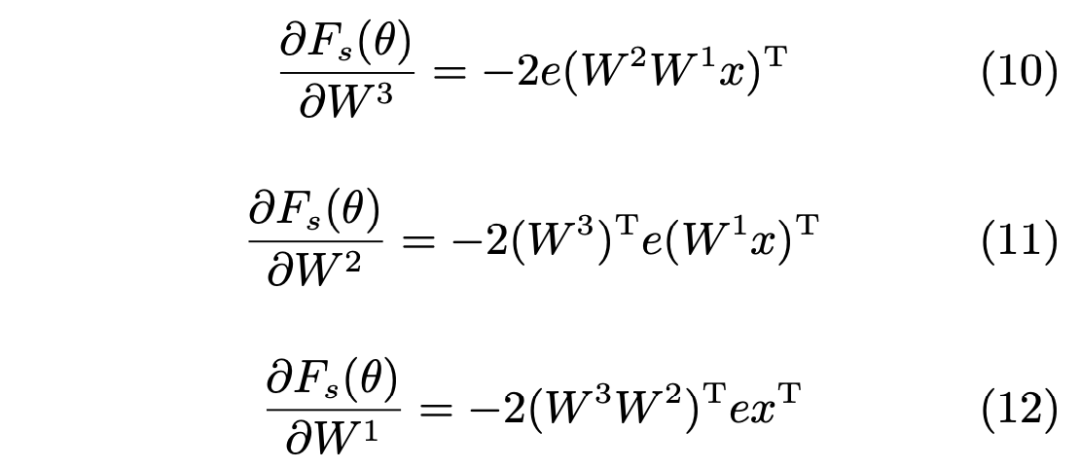

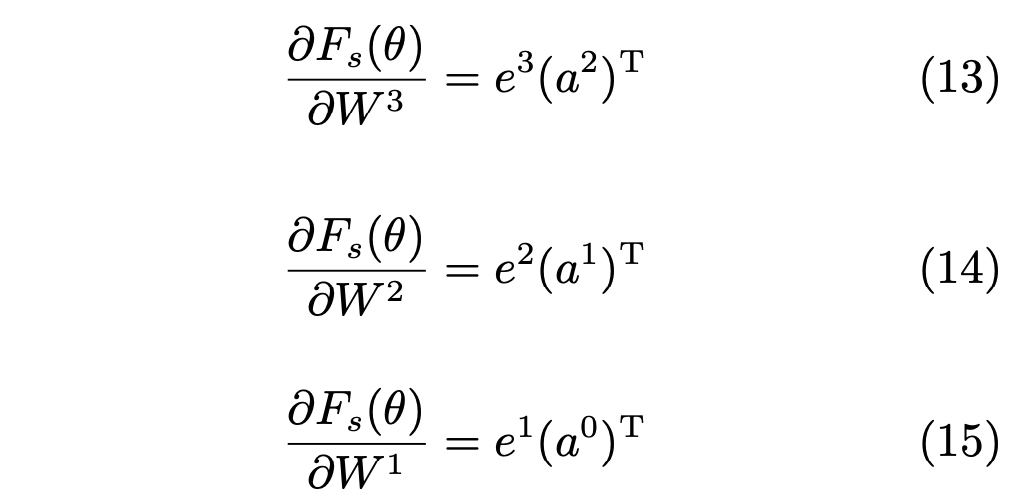

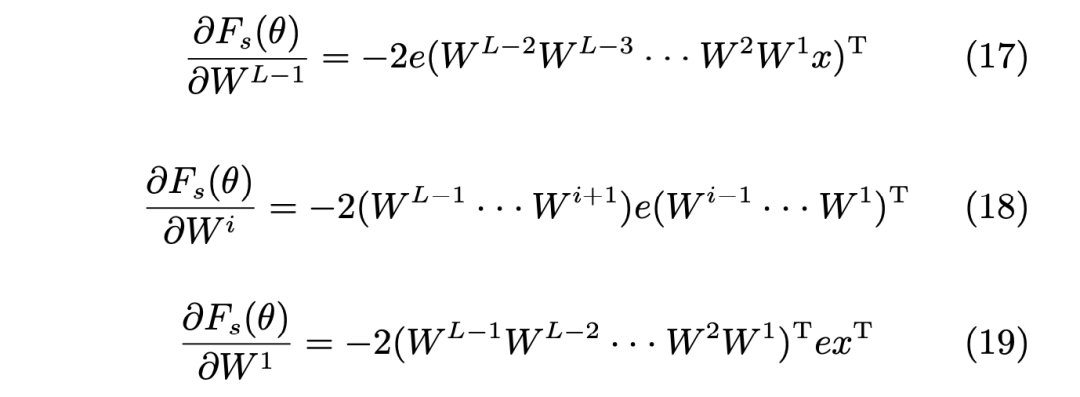

section 4 是关于 4 层无激活函数的 BP 推导细节 -

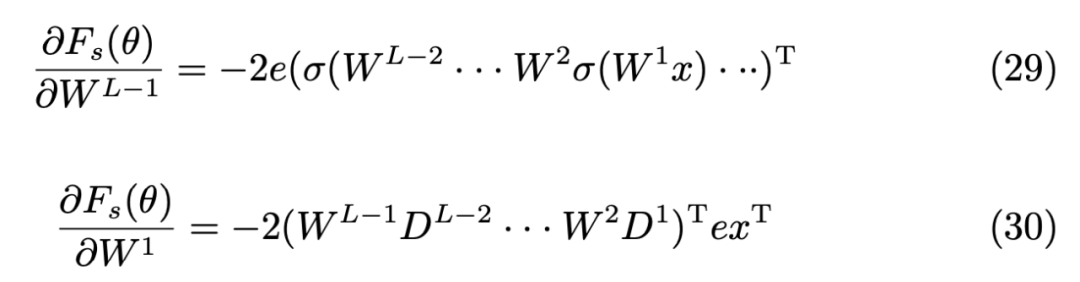

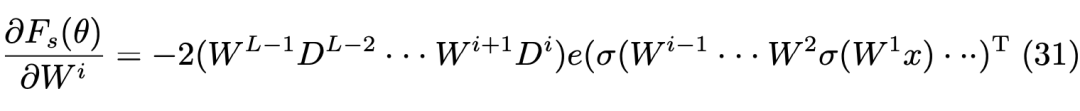

section 5 是关于 L 层无激活函数的 BP 推导细节 -

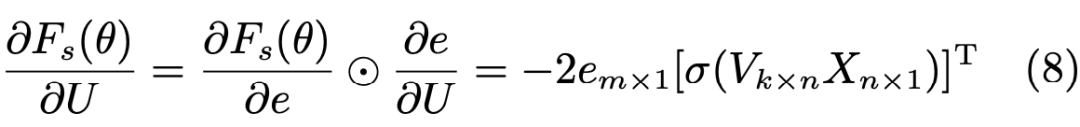

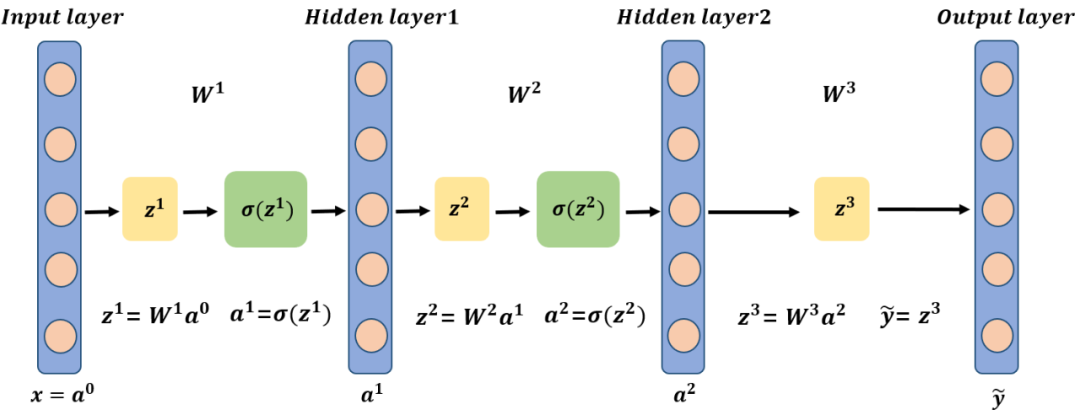

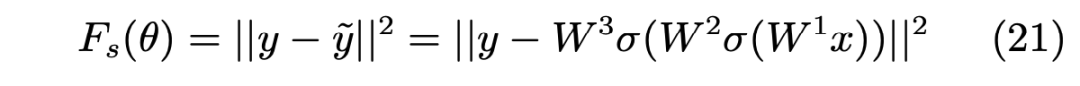

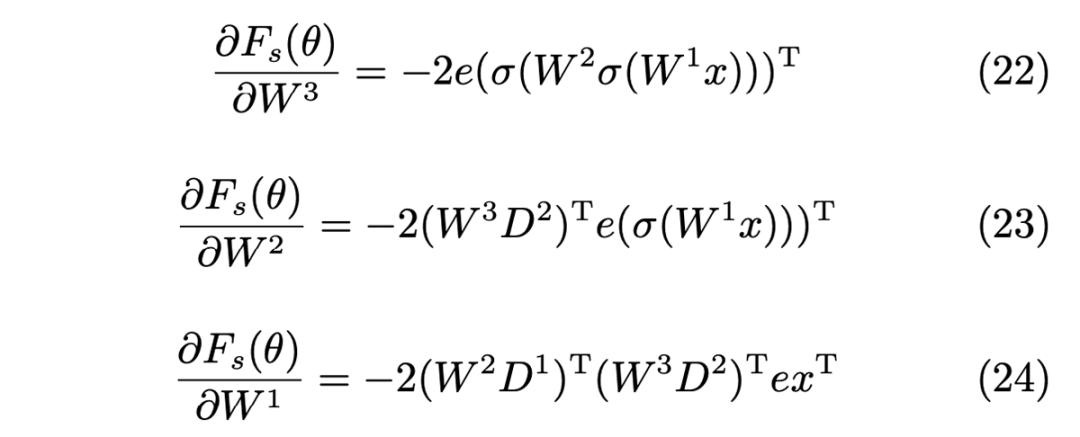

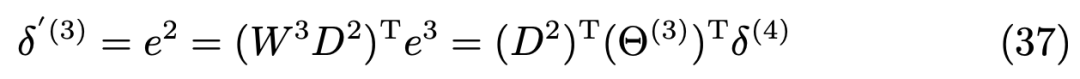

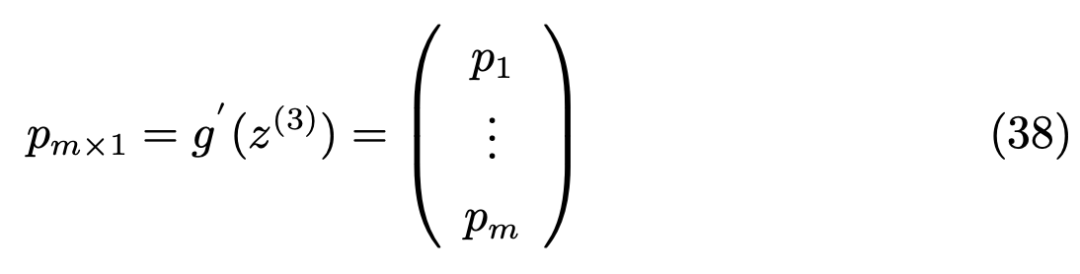

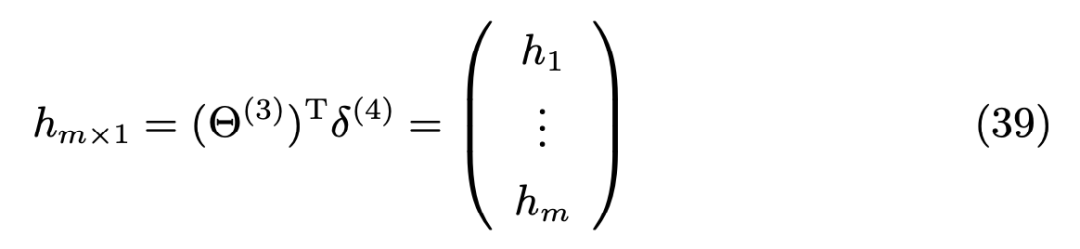

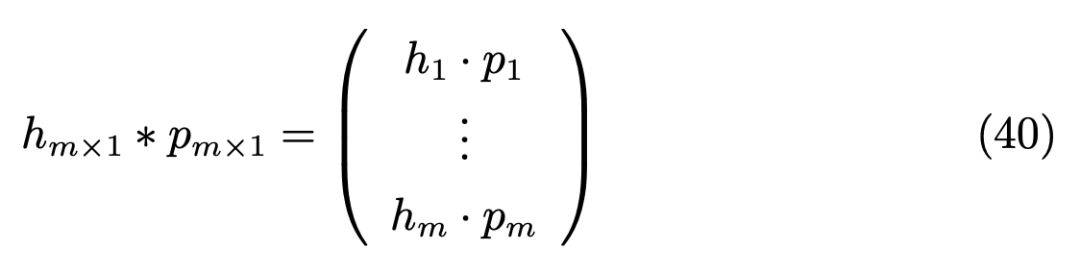

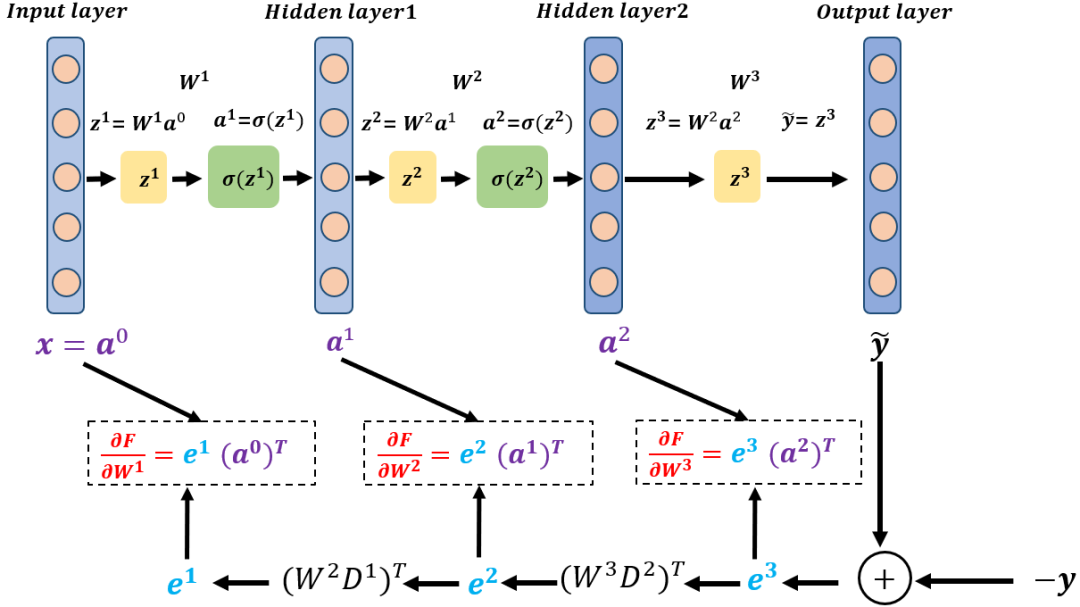

section 6 是关于 4 层含激活函数的 BP 推导细节 -

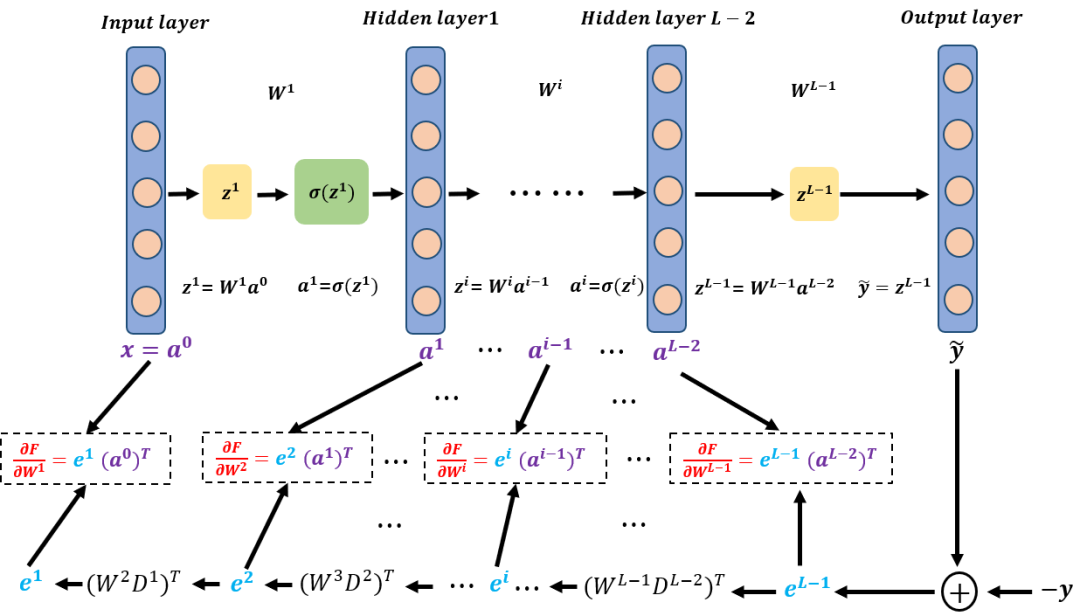

section 7 是关于 L 层含激活函数的 BP 推导细节 -

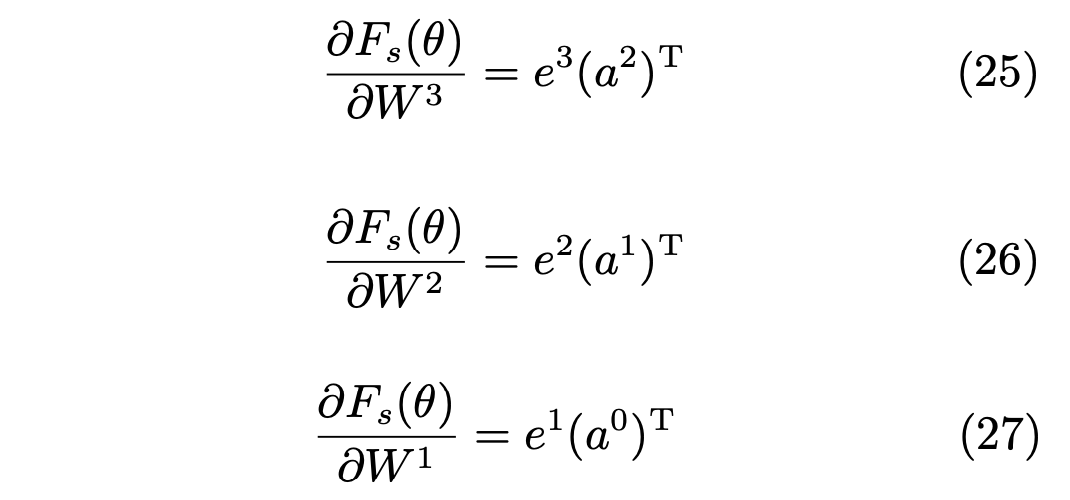

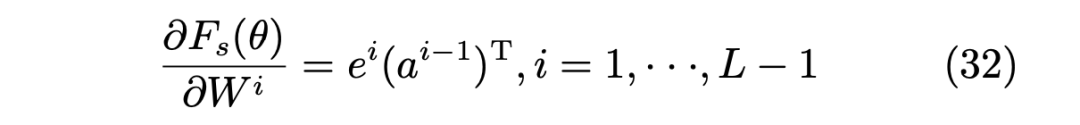

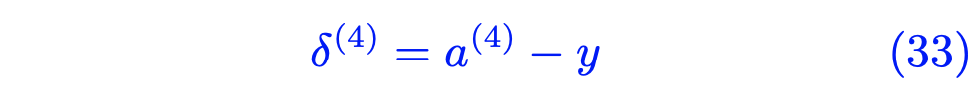

section 8 是对吴恩达机器学习讲义中关于 BP 章节结果的验证

预备知识

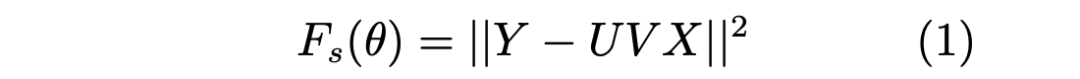

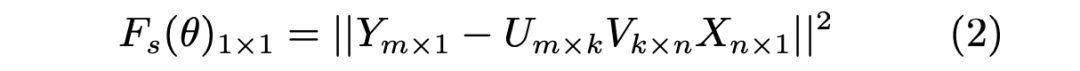

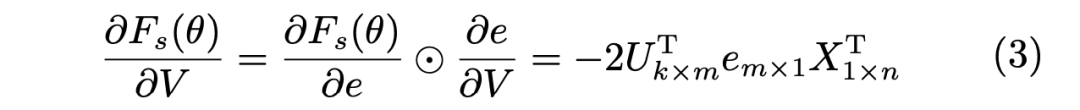

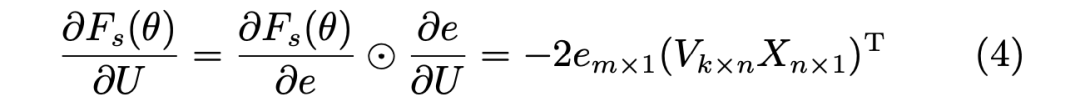

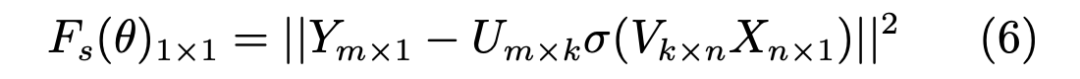

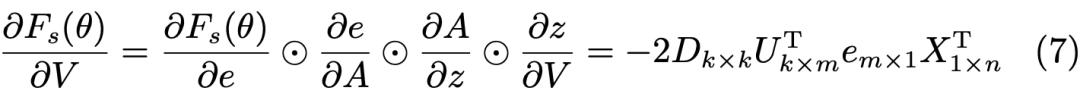

3.1 推导形式1

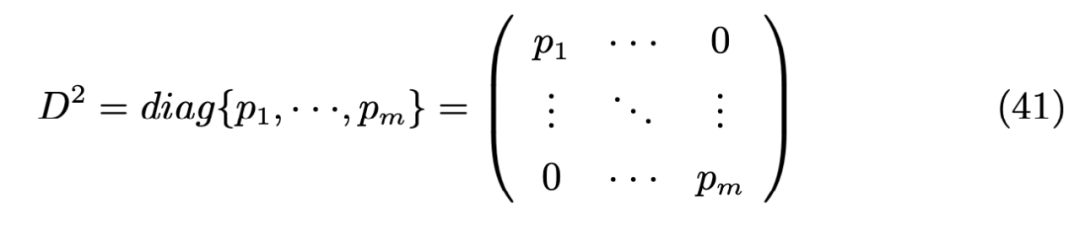

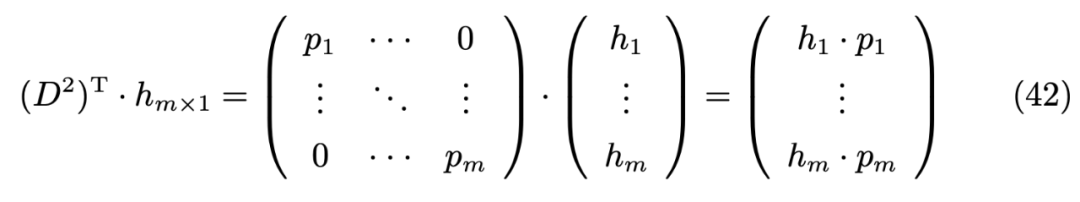

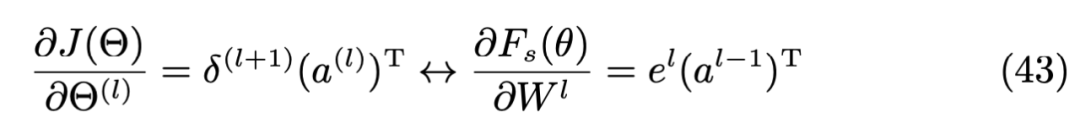

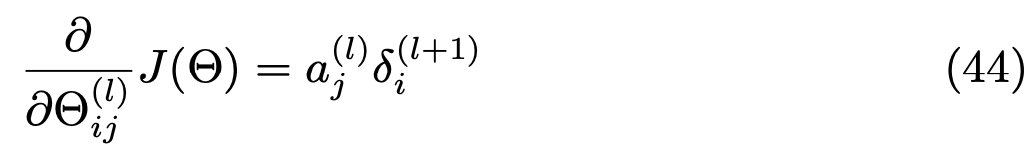

3.2 推导形式2

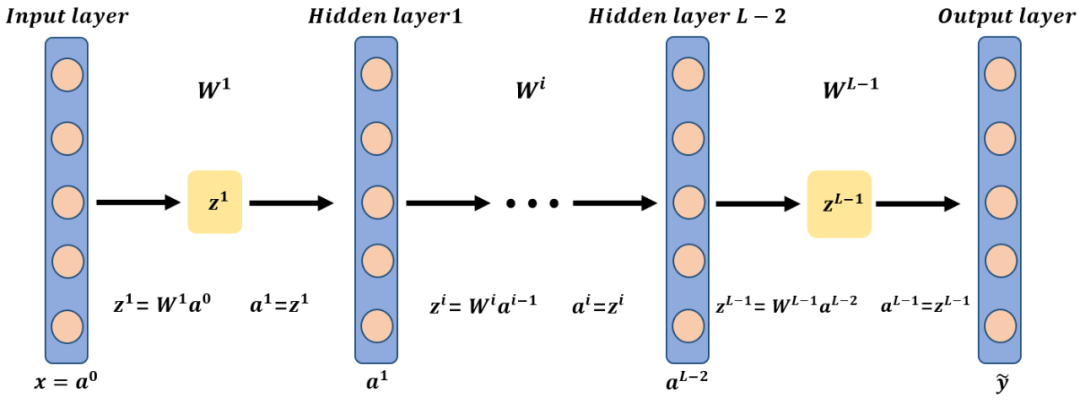

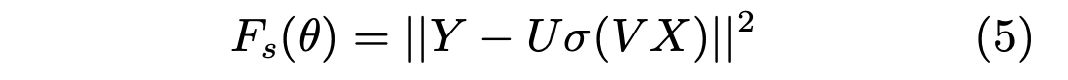

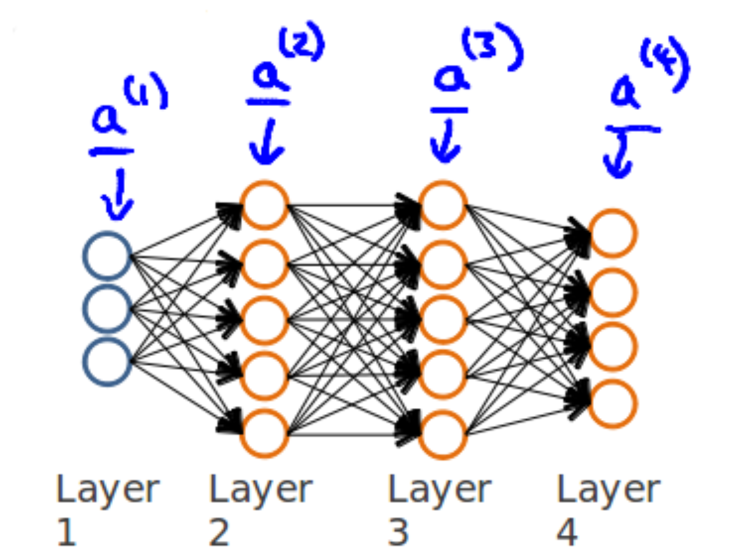

▲ 图1:4层无激活函数的前向传播过程

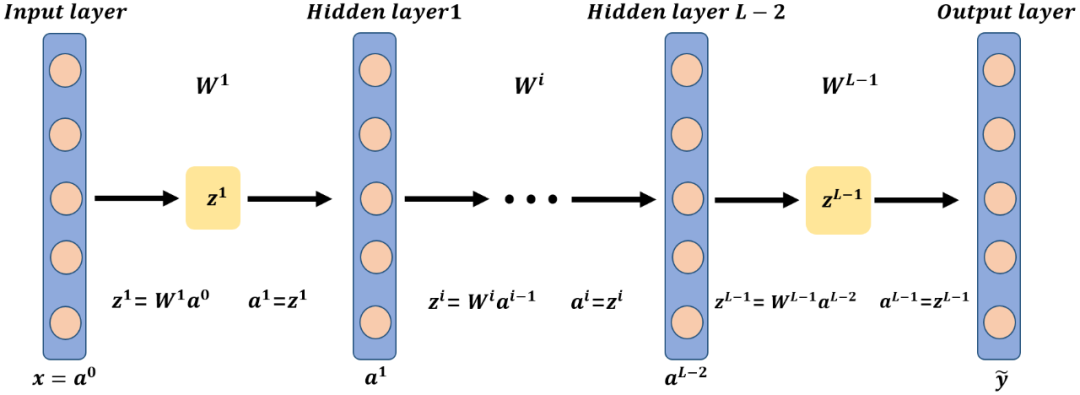

▲ 图2:4层无激活函数的BP原理图

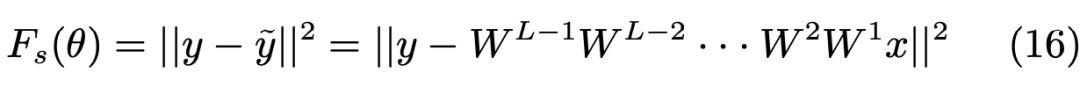

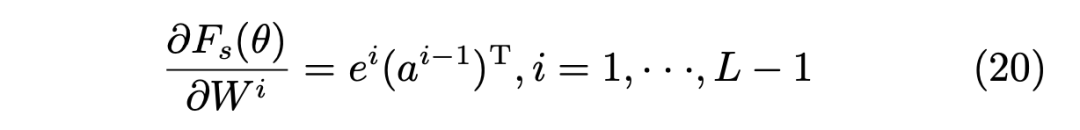

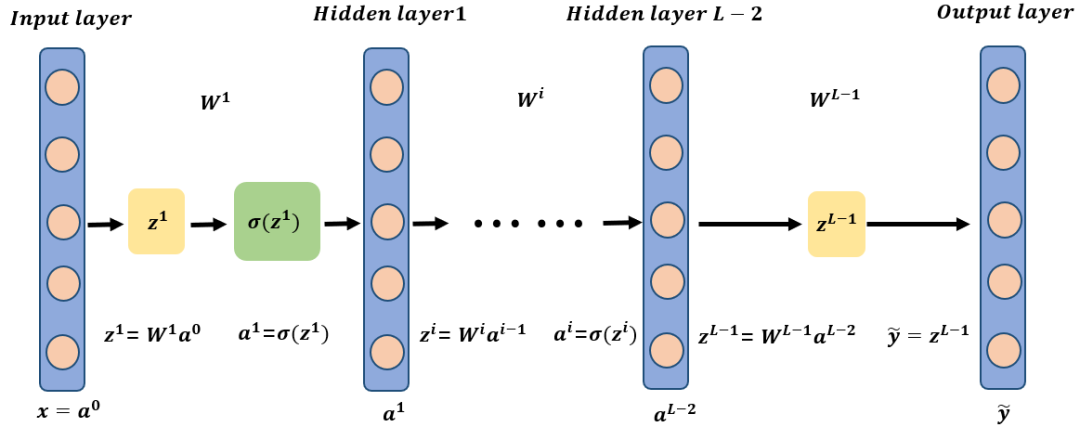

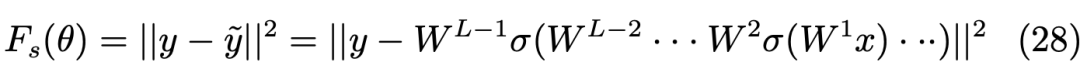

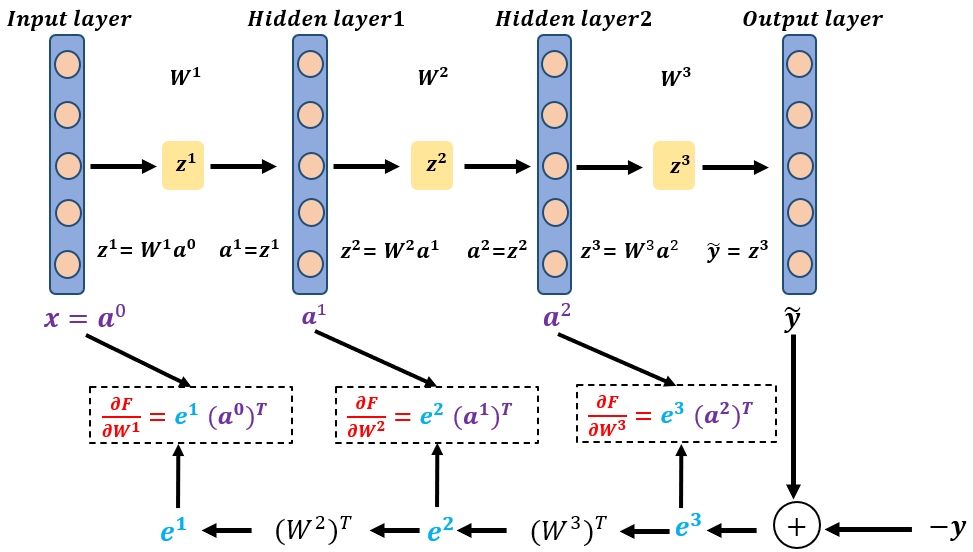

L层无激活函数的神经网络

验证BP矩阵推导

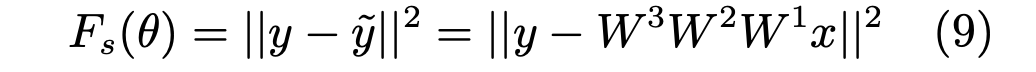

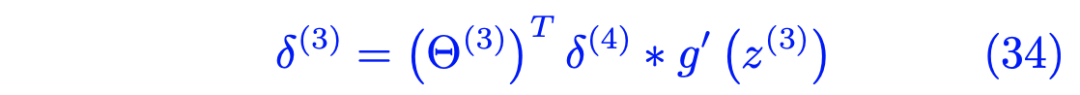

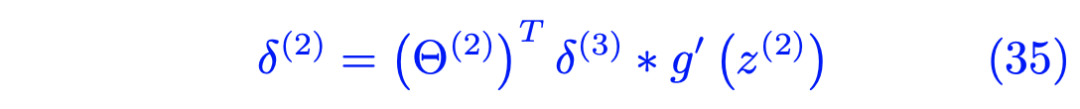

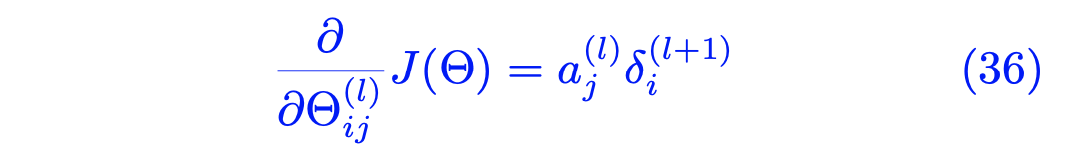

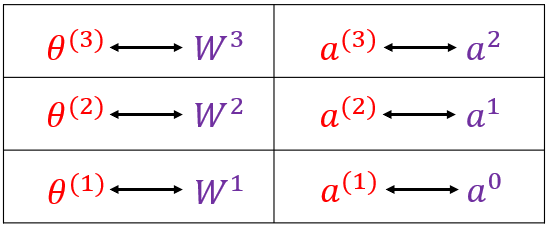

本节主要是对吴恩达机器学习讲义中(ML-AndrewNg-Notes: Coursera)关于 BP 原理结论部分的验证,所以本文的主要目的是验证吴中的关于 BP 结论与本文的 section 4 之间的结论是否一致。由于符号和表示形式的差异,将吴中关于 BP 原理部分的描述用蓝色字体表示(该部分在),将验证过程用红色字体表示。

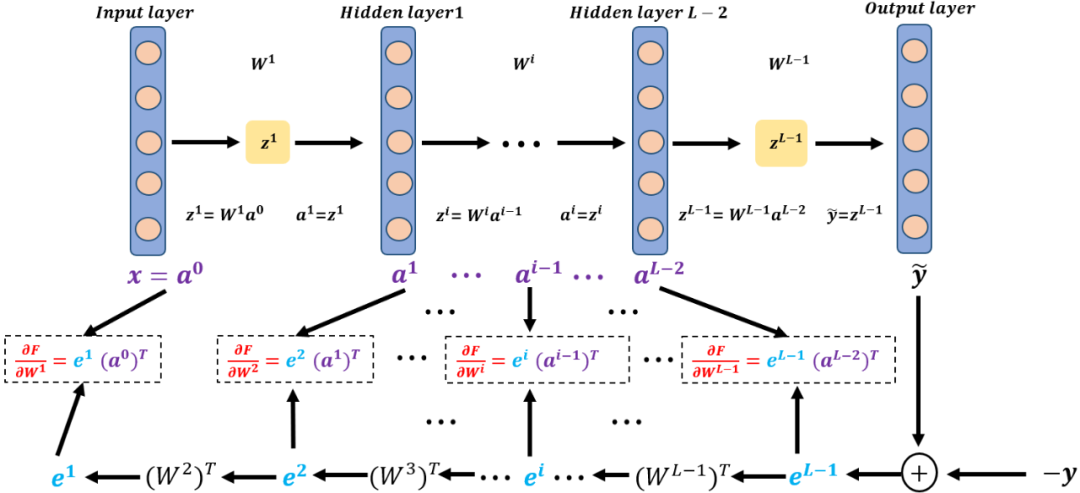

▲ 图9:吴恩达机器学习讲义中的网络结构

更多阅读

#投 稿 通 道#

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。