真·机械朋克!物理学家用扬声器搭建神经网络,登上今日Nature

晓查 发自 凹非寺

量子位 | 公众号 QbitAI

用喇叭识别手写数字?

听起来好像是玄学,但这其实是正经的Nature论文啊。

下面的图,表面上看起来是个改造过的喇叭,其实用它来识别手写数字,正确率接近90%。

这就是来自康奈尔大学的物理学家们整出的新花样。

他们用扬声器、电子器件、激光器,分别造出了声学、电学、光学版的物理神经网络(PNN)。

而且以上这些神经网络还能用反向传播算法执行训练。

物理学家整出PNN的原因是:摩尔定律已死,我们要用物理系统拯救机器学习。

据这篇文章所说,和软件实现的神经网络相比,PNN有希望将机器学习的能效和速度提高好几个数量级。

如何用物理反向传播

科学家之所以能用物理设备搭建神经网络,是因为物理实验与机器学习的本质都是一样的——调参、优化。

物理学中存在着非常多的非线性系统(声学、电学、光学都有),能和人工神经网络一样用来逼近任意函数,。

声学的神经网络就是这样的。

两位做实验的博士后拆掉了扬声器上方的振膜,将方形的钛金属板和喇叭动圈相连。

来自计算机的接收控制信号以及金属板震荡产生输入信号,再把信号输出到扬声器上,由此制造了一个反馈闭环。

至于如何进行反向传播,作者提出了一种混合物理世界与计算机的算法,称为“物理感知训练” (PAT),可以反向传播直接训练任何物理系统来执行深度神经网络的通用框架。

在声学神经网络系统中,振荡板接收由MNIST图像改造的声音输入样本(红),在驱动振动板后,信号由麦克风记录(灰),并及时数模转换为输出信号(蓝)。

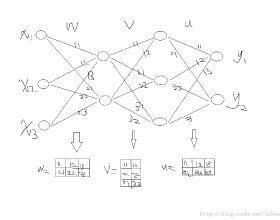

整个物理系统的流程如下图:先将数字信号转换为模拟信号,输入进物理系统中,然后将输出与真实结果对比,经过反向传播后,调整物理系统的参数。

通过对扬声器参数的反复调试,他们在MNIST数据集上达到了87%的正确率。

也许你会问,训练过程中还是要用到计算机啊,这有什么优势?

的确,PNN在训练上可能并不占优势,但PNN的运行靠的是物理定律,一旦网络训练完成,就无需计算机介入,在推理延时和功耗上都具有优势。

而且PNN在结构上比软件版的神经网络简单多了。

还有电学和光学版

除了声学版,研究人员还打造了电学版和光学版神经网络。

电学版使用了四个电子元器件电阻、电容、电感和三级管,就像中学物理实验一样,电路极其简单。

这套模拟电路PNN能够以93%的测试准确率执行MNIST图像分类任务。

而光学版最为复杂,近红外激光通过倍频晶体被转化为蓝光,不过这套系统的准确率最高,能够达到97%。

另外,这套光学系统还能对语音进行简单的分类。

以上所用到的物理系统训练算法PAT可以用于任何系统,你甚至可以用它来打造流体乃至机械朋克版神经网络。

参考链接:

[1]https://www.nature.com/articles/s41586-021-04223-6

[2]https://github.com/mcmahon-lab/Physics-Aware-Training

[3]https://news.cornell.edu/stories/2022/01/physical-systems-perform-machine-learning-computations

— 完 —

「智能汽车」交流群招募中!

欢迎关注智能汽车、自动驾驶的小伙伴们加入社群,与行业大咖交流、切磋,不错过智能汽车行业发展&技术进展。

ps.加好友请务必备注您的姓名-公司-职位哦~

点这里👇关注我,记得标星哦~

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见~