2021年12月2日下午15:45,哈尔滨工业大学社会计算与信息检索研究中心(哈工大SCIR)邀请到了微软研究院首席研究员楼建光博士为我中心全体在校师生带来学术讲座。

![]()

本次“赛尔讲坛”在在线上举行,楼建光的报告主题为《DNN模型的组合泛化能力初探》,由我中心车万翔教授主持。

![]()

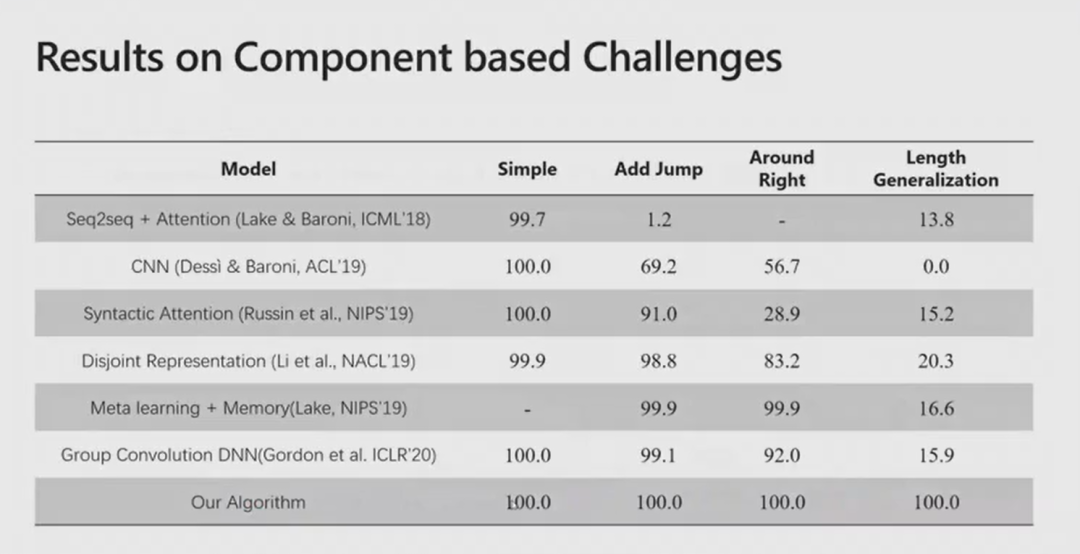

楼建光博士在2016年前主要从事软件工程、大规模系统等工作,对自动化程序生成非常关注,并以此为契机因此跨入自然语言处理领的研究。人脑通过学习并编程指导自身行为是一个非常自然的过程,但是AI编程存在很多问题,无法处理复杂的任务。复杂的任务往往是由简单任务组合起来的,AI通常能够学会简单的子任务,但是无法处理由简单子任务组成的复杂任务,这就是组合泛化问题。Humboldt曾说过“Infinite use of finite means”,有限的概念能够组合成无限的运用。组合泛化问题存在于很多的计算机科学研究领域,计算机视觉中存在很多简单视觉元素组合构成复杂视觉类型的问题;自然语言处理中单词往往是有限的,但是能通过组合表达大量复杂的语义。人在在推理过程中也运用了很多组合的能力,是人基本的能力,也是我们通向真正人工智能的过程中必须让机器具有的重要能力。楼建光团队从三个角度出发着手研究该问题:现有模型是否具有这种能力,如何让模型具有这种能力,如何设计新的模型具有这种能力。研究者们提出了SCAN、CFQ、COGS等数据集用来验证模型是否有组合推广能力。 首先楼建光博士解释了什么是compositionality(组合性),组合性其实是一种代数性。现有深度学习在实例之间建立端到端的直接映射。而楼建光博士希望构建一种代数系统。如果我们希望模型具有无限的组合能力,模型需要学习代数空间的映射能力,而不是实例之间的映射能力。代数比算数更抽象,更有组合能力。为了使模型能够自动构建代数空间,并自动在代数空间内学习映射,楼建光团队设计了一个新的架构模型,包含两个组成成分:1. Composer,用于将概念进行归纳。2,Decoder(+memory),通过引入memory辅助模型将归纳好的概念进行演绎,整个过程是迭代进行的。由于目前数据集在训练过程中没有逐步的监督信号进行迭代训练,因此使用层次化的强化学习(Hierarchical RL)进行训练。实验证明这种模型架构在衡量模型组合泛化能力的数据集上大规模领先已有的模型,甚至在部分数据集上达到了100%的准确率。

![]()

接下来楼建光博士还介绍了使用迭代回译(Iterative Back-Translation)在组合泛化领域中生成大量自然语言和对应代码的伪样本,从而辅助自动代码生成的工作。实验证明使用迭代回译能够使代码生成模型具有更好的组合泛化性能。

![]()

讲座过后,我中心老师同学向楼建光博士请教了组合泛化对已有机器学习泛化能力的拓展、组合泛化是否能够由机器学习规则以及组合泛化在实际应用场景的应用,楼建光博士对这些问题都给予了耐心细致的解答,大家都受益匪浅。

讲者简介:

楼建光博士,现为微软研究院首席研究员。多年来主要从事机器学习和人工智能技术在商业智能(Business Intelligence)数据分析、大规模在线软件系统分析(Software Analytics)等方面的研究与应用工作。研究兴趣包括交互式数据分析机器人、自动数据理解、程序自动生成、大规模在系统智能诊断与运维等方面。多项成果在微软公司的大规模在线系统实践中得到广泛应用。部分工作发表在人工智能、自然语言处理、计算机软件、系统及数据挖掘相关的知名国际会议。

本期责任编辑:刘 铭

理解语言,认知社会

以中文技术,助民族复兴