【ICML2020投稿论文-DeepMind】时序差分学习的推理与泛化,Temporal Difference Learning

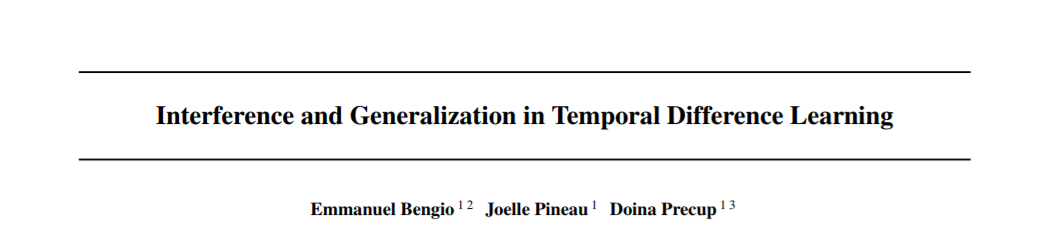

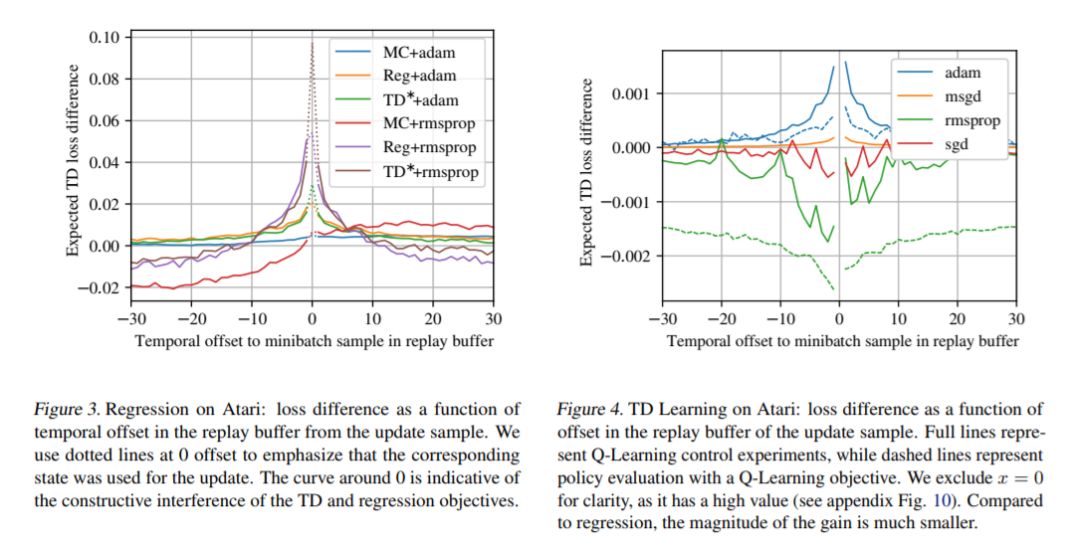

我们研究了时间差分(TD)学习中泛化与干涉之间的关系。干涉被定义为两个不同梯度的内积,表示它们的对齐。这个量从对神经网络、参数共享和动态学习的各种观察中产生。我们发现,TD很容易导致低干扰、欠泛化参数,而在监督学习中,这种效应似乎是相反的。我们假设,原因可以追溯到相互作用之间的动态干扰和bootstrapping。这是由几个观察:支持经验之间的负面关系泛化间隙和干涉TD,引导对干扰的负面影响和当地的一致性目标,和信息的传播速度之间的对比在TD(0)和TD(λ)和回归蒙特卡罗政策评估等任务。我们希望这些新的发现能够指导未来更好的引导方法的发现。

https://www.zhuanzhi.ai/paper/2f0b380ba75a18c409cb583f87751b59

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“IGT” 就可以获取《【ICML2020投稿论文-DeepMind】时序差分学习的推理与泛化,Temporal Difference Learning》专知下载链接

登录查看更多

相关内容

Arxiv

5+阅读 · 2018年7月11日