TPAMI 2022 | 利用子图同构计数提升图神经网络的表达能力

论文地址:

论文介绍

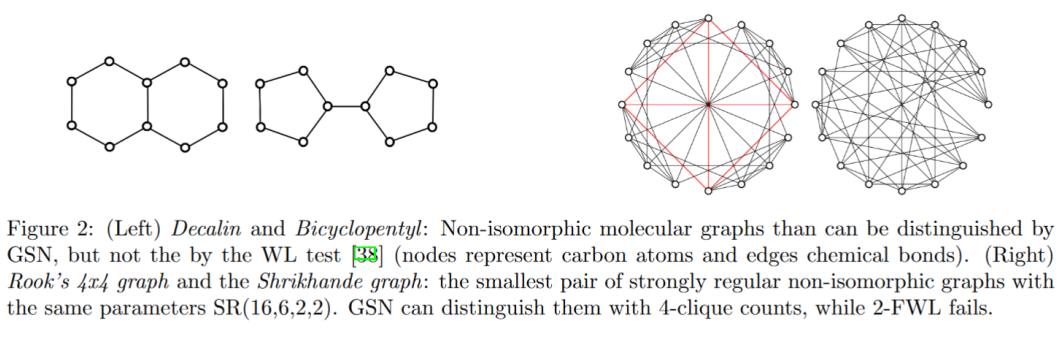

尽管图神经网络(GNNs)在很多的应用中都取得了很大的成绩,但是最近研究发现 GNNs 捕捉底层图结构上仍然有缺陷。研究表明标准的 GNNs 表达能力受到 Weisfeiler-Leman(WL)图同构测试的限制,例如无法检测和计数图的子结构,然而在一些任务中的子结构往往与下游任务密切相关。因此,本文提出了图结构网络(GSN),是一种基于子结构编码的拓扑感知的消息传递方案,并分析了 GSN 的表达能力,证明了它比 WL test 的表达能力更强,还证明了它的普适性。

在复杂的网络中,子结构是十分重要的,但是大多数 GNNs 依靠多个消息传递过程来使该节点发现全图的结构。

本文提出了三个问题:

(1)如何超越各向同性,也就是局部对称和聚合函数

(2)如何确保 GNNs 知道图的结构?

(3)如何不牺牲同构性和 GNNs 泛化能力的前提下实现上述的目标?

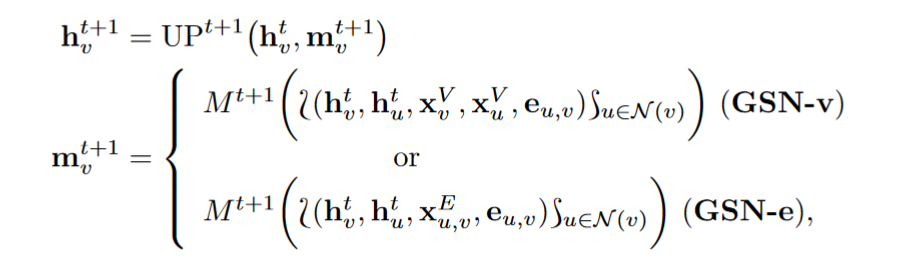

作者首先通过在聚合函数中引入结构信息来打破局部对称问题:每个邻居(消息)的贡献根据其与节点中心的结构关系进行不同的转换,这些关系是通过计算某些子结构的外观来表示的。这样可以解决问题 1 和问题 2,而子结构对顶点的排列是不变的,所以 GNNs 对同构是不变的,因此可以解决问题 3。

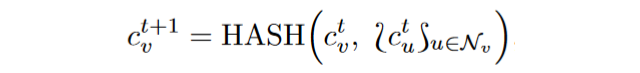

表示一个多重集(允许元素重复的集合),N(v) 表示节点 v 的邻居。WL 算法在颜色停止变化时停止,并输出颜色的直方图。具有不同直方图的两个图不是同构的,但如果直方图相同,这两个图也有可能不同构。

实验过程

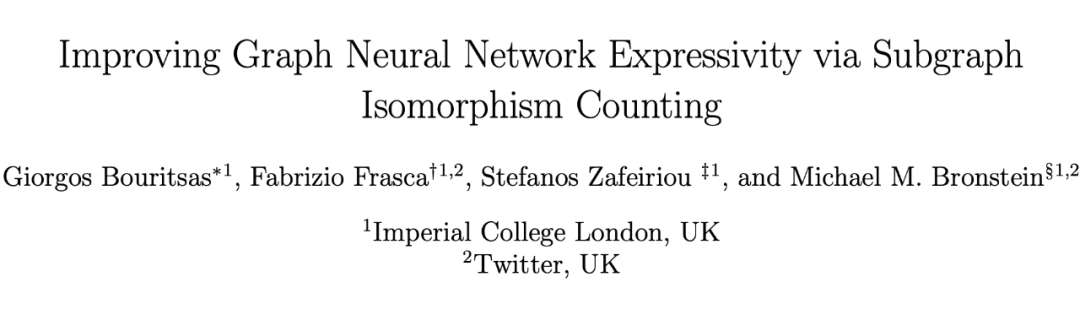

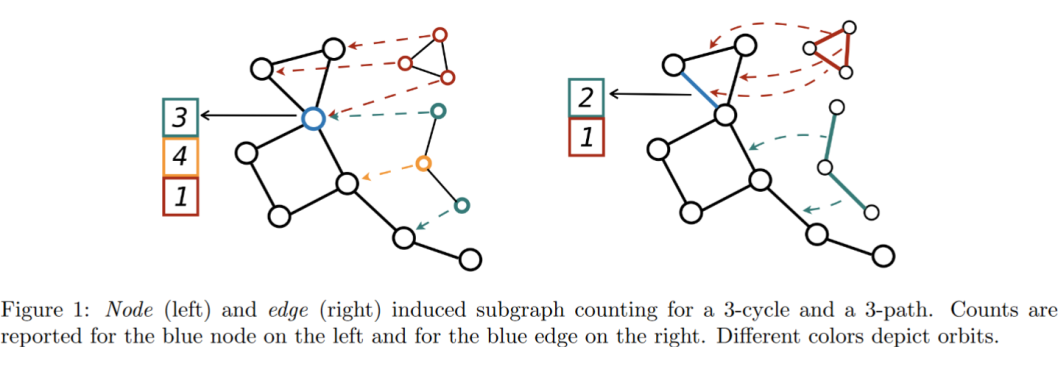

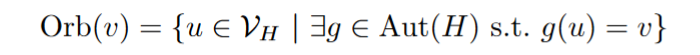

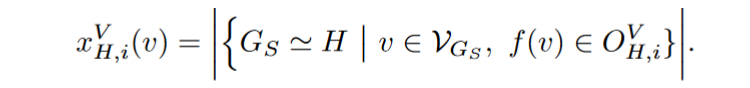

图由具有重复结构角色的节点或者边组成,但是 GNNs 中的节点被当做同样的角色进行操作,因此不知道节点的不同结构角色。尽管最初直觉认为 GNNs 可以通过构造更深层的架构来发现这些角色的不同,但实际上 GNNs 并不能达到这个目的,并且无视结构的属性,例如三角形或者更大的循环。因此,文中显式的将结构角色编码为消息传递的一部分。

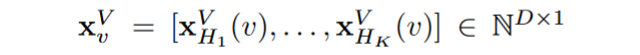

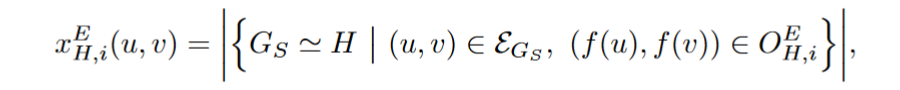

3.1 结构消息传递

3.2 GSNs的性能

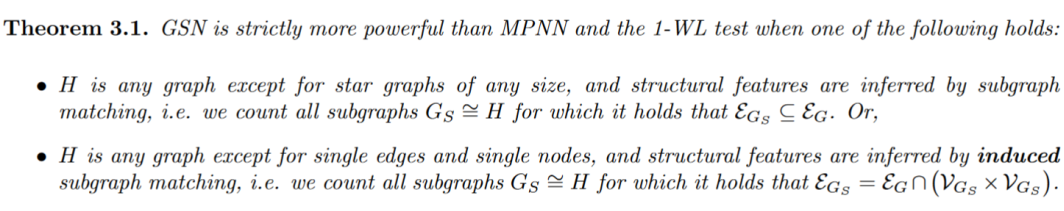

文中给出了定理 3.1 已经它的证明。因为 GSN 模型包含 MPNN,因此其至少具有和 MPNN 一样的表达能力,也证明了 GSN 至少与 1 阶 WL test 具有同样的表达能力。

除了表达性能的证明外,文中还证明了 GSNs 的普适性:因为子结构集合 H 包含了所有大小为 k=n-1 的图,所以 GSN 可以区分所有大小为 n 的非同构图,因此具有普适性。

对于集合中的每个图 H,顶点结构标识符可以由相应的边标识符重构,因此可以证明对于每一个 GSN-v,都存在一个 GSN-e 可以模拟 GSN-v 的行为。

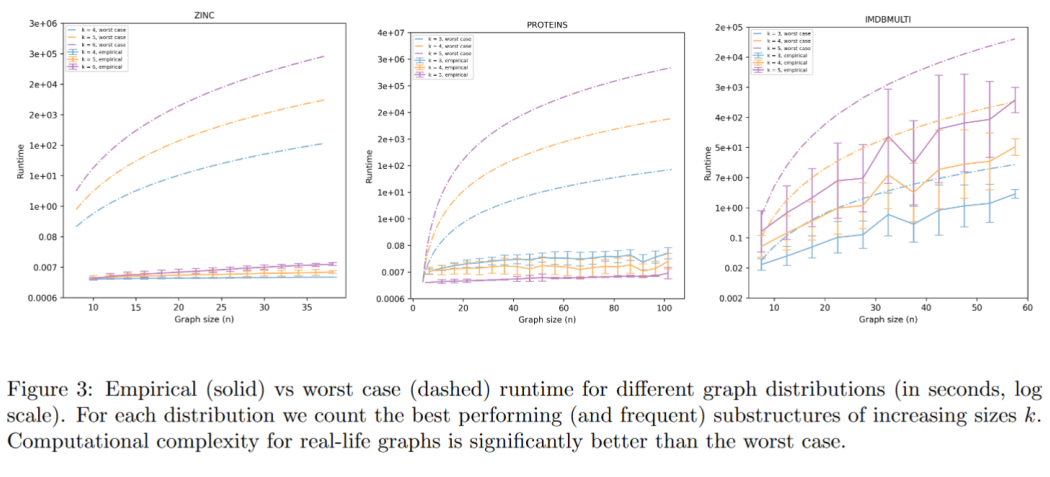

图 3 针对最坏的情况对计数算法的运行时间进行了定量分析,针对三种不同的图分布:分子、蛋白质联系图、社交网络。当图是稀疏的(对于前两种情况),匹配的数量很少,算法比最坏的情况要快得多,同时随着图 n 的大小,它的伸缩性更好。在社交网络图中,运行时间也比最坏情况更好。

实验结果

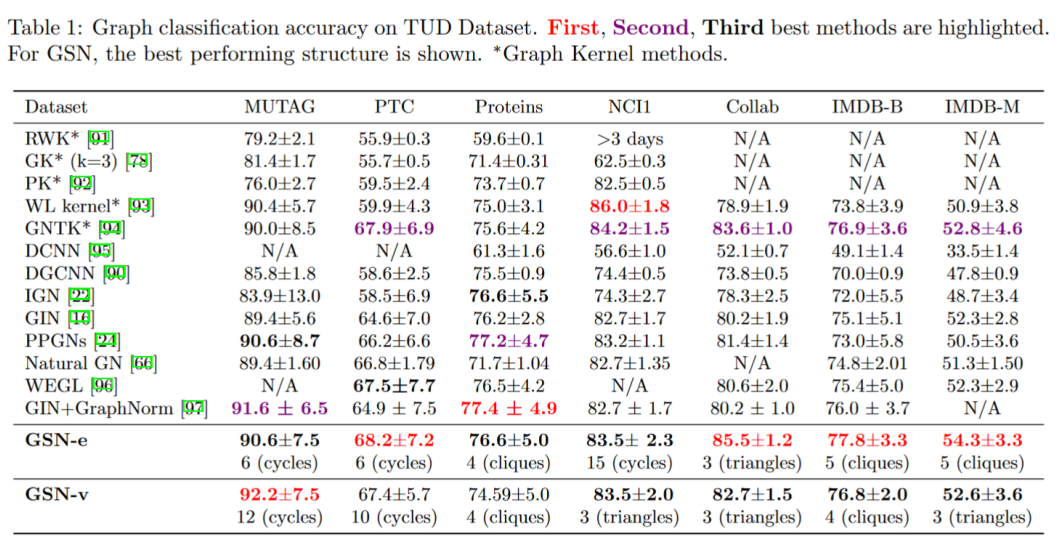

测试了 TUD 数据集上的图分类精度,在大部分数据集上 GSN 取得了最好的精确度。

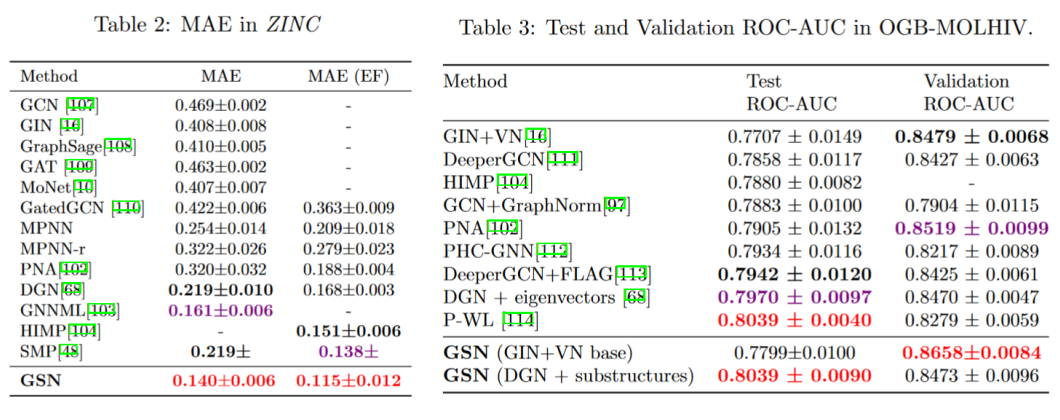

测试 ZINC 数据集中的平均绝对误差(MAE),GSN 的平均绝对误差最小,且远小于 GCN。

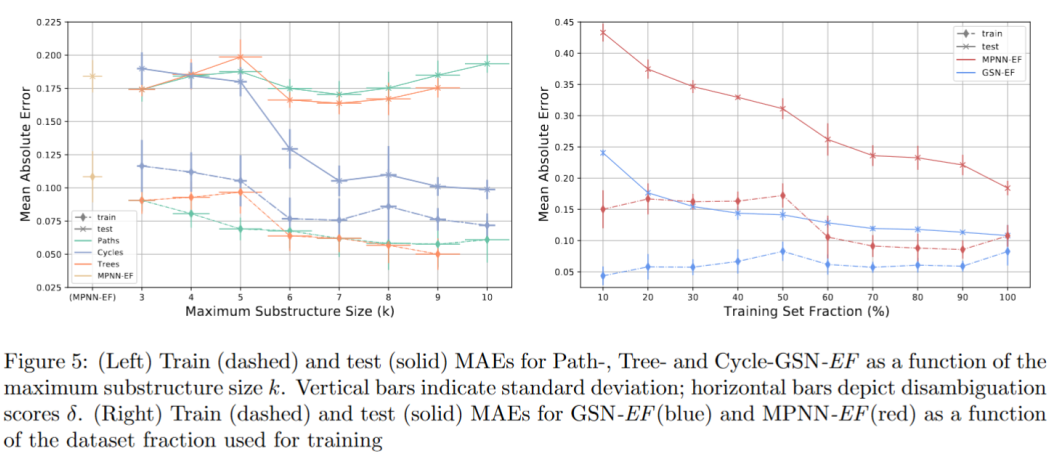

图 5 比较了不同子结构族(循环、路径和非同构树:每个实验都使用家族中所有大小 ≤ k 的子结构)的训练和测试误差

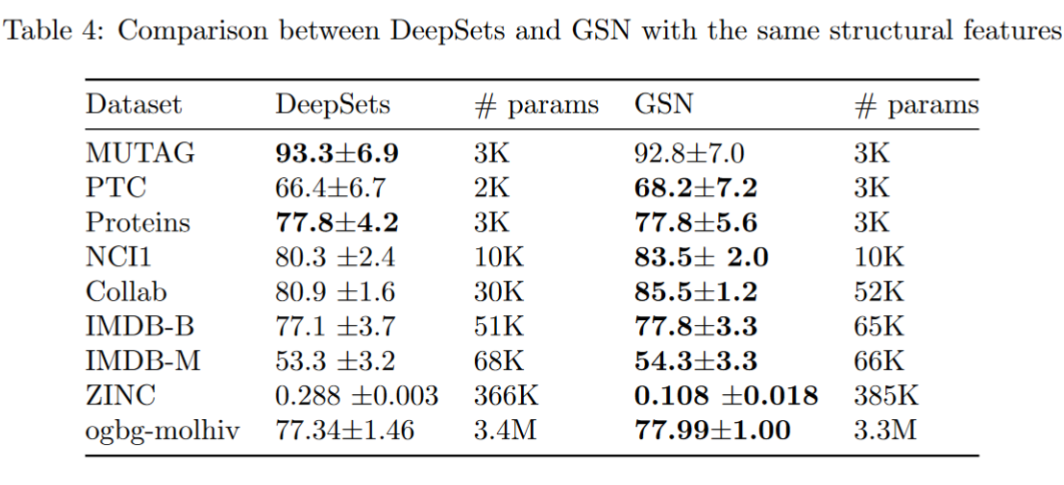

GSN 在各种数据集上获得了较高的性能,并且常常优于其他传统的消息传递网络的性能。

总结

本文提出了一种设计结构感知图神经网络的新方法。由于传统 GNNs 在捕获图的重要拓扑属性方面存在局限性,作者制定了一种消息传递方案,增强了通过子图同构提取的结构特征。最后通过实验验证了这个模型可以改进表达能力,并在现实场景中获得了最先进的性能。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧