挑战泛化能力天花板!突破GNN中消息传递范式的限制

“问渠那得清如许,为有源头活水来”,通过前沿领域知识的学习,从其他研究领域得到启发,对研究问题的本质有更清晰的认识和理解,是自我提高的不竭源泉。为此,我们特别精选论文阅读笔记,开辟“源头活水”专栏,帮助你广泛而深入的阅读科研文献,敬请关注。

编辑:人工智能前沿讲习

01

02

03

04

-

迹:矩阵对角线的和 -

元素乘:矩阵元素按位置相乘

05

-

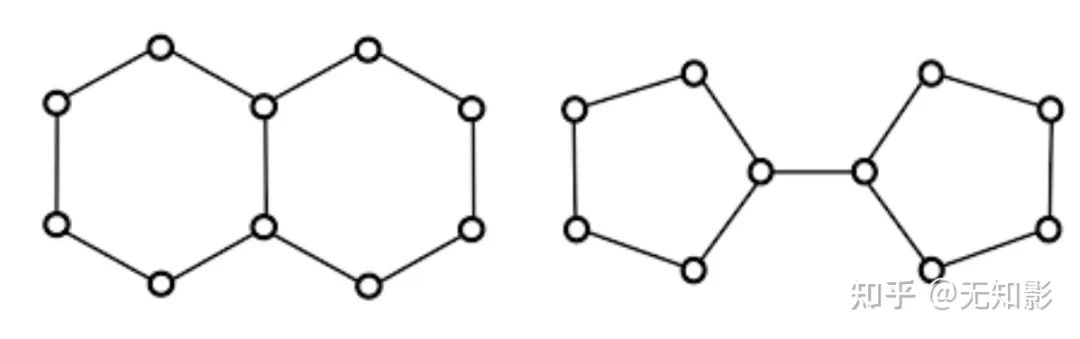

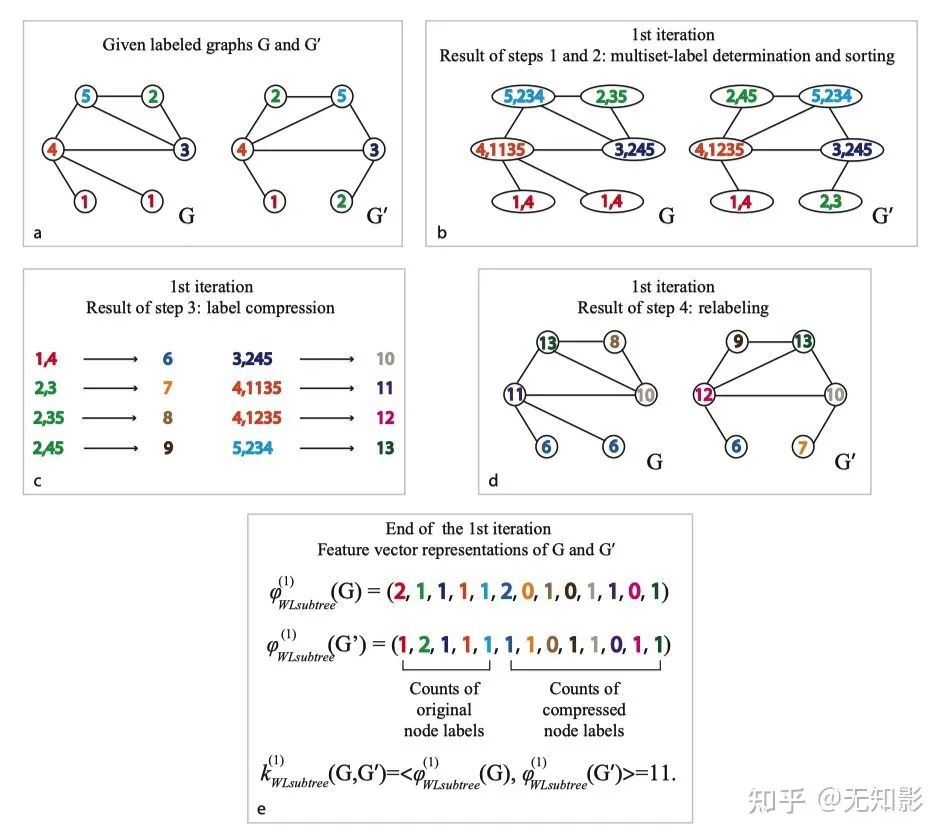

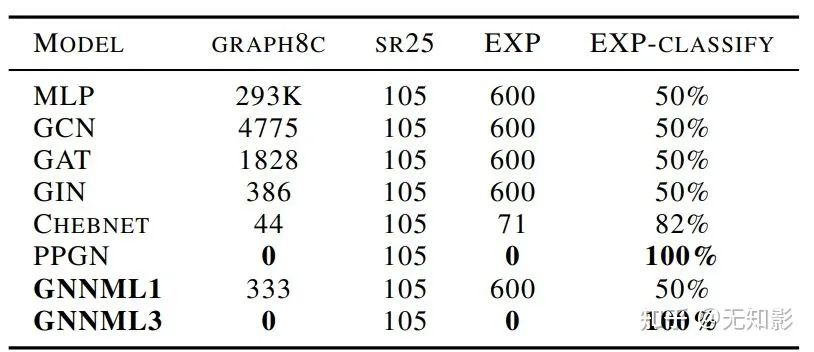

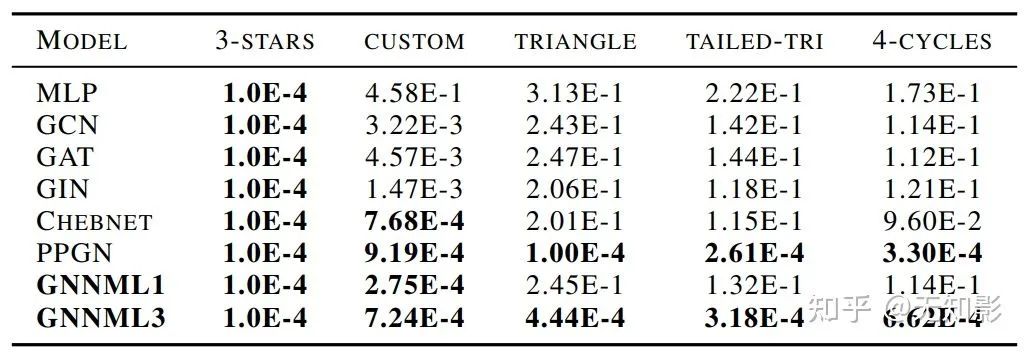

多少对1-WL和3-WL等价的非同构图不能被模型区分? -

给定一个图,模型能够对图中的子结构(模体)计数吗? -

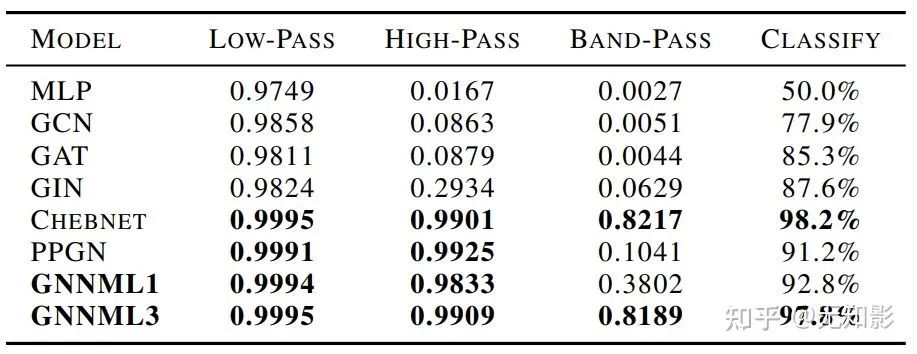

模型能够学习到低通、高通和带通滤波器的性质吗? -

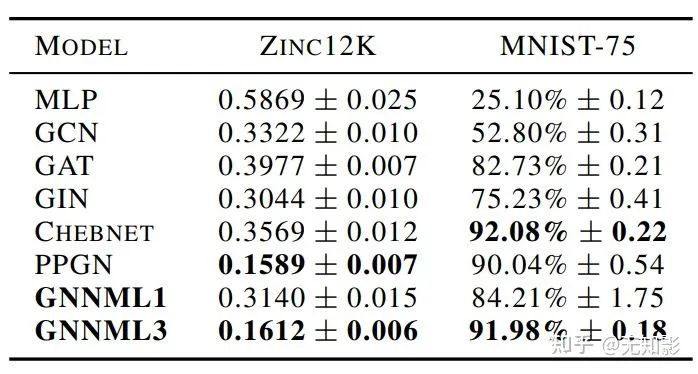

模型在下游任务中的表现怎么样?

06

-

逻辑严密,有理有据。推理细节可以参考原文的附录。 -

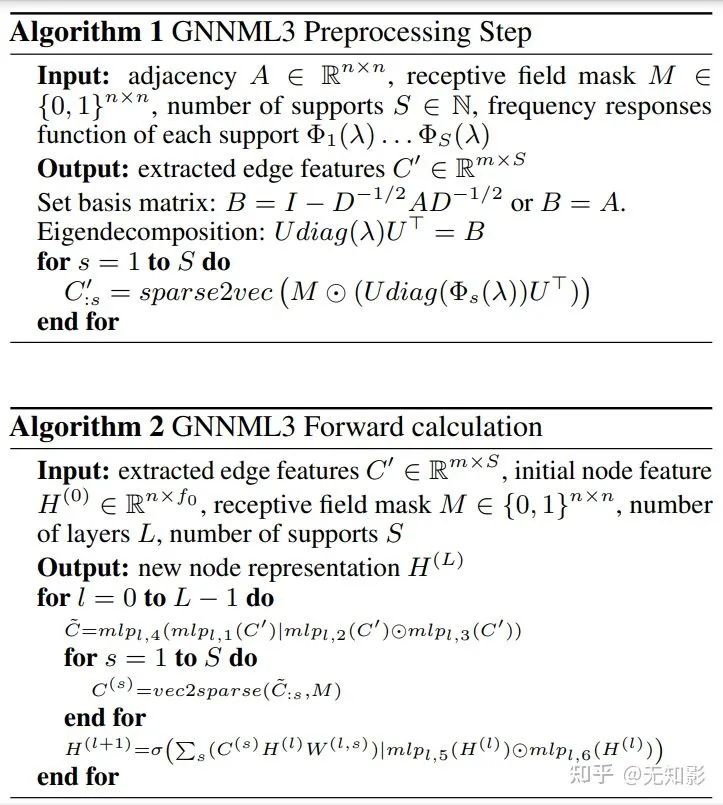

可扩展性有限。预计算图拉普拉斯矩阵的特征向量矩阵

登录查看更多