回顾 | 跟李沐一起动手学深度学习第十八课:seq2seq(编码器和解码器)和注意力机制

本文为2月3日(周六)上午,将门联合亚马逊AI主任科学家李沐博士:从零开始入门深度学习第十八课的内容回顾,继续由亚马逊应用科学家Aston Zhang为大家带来。

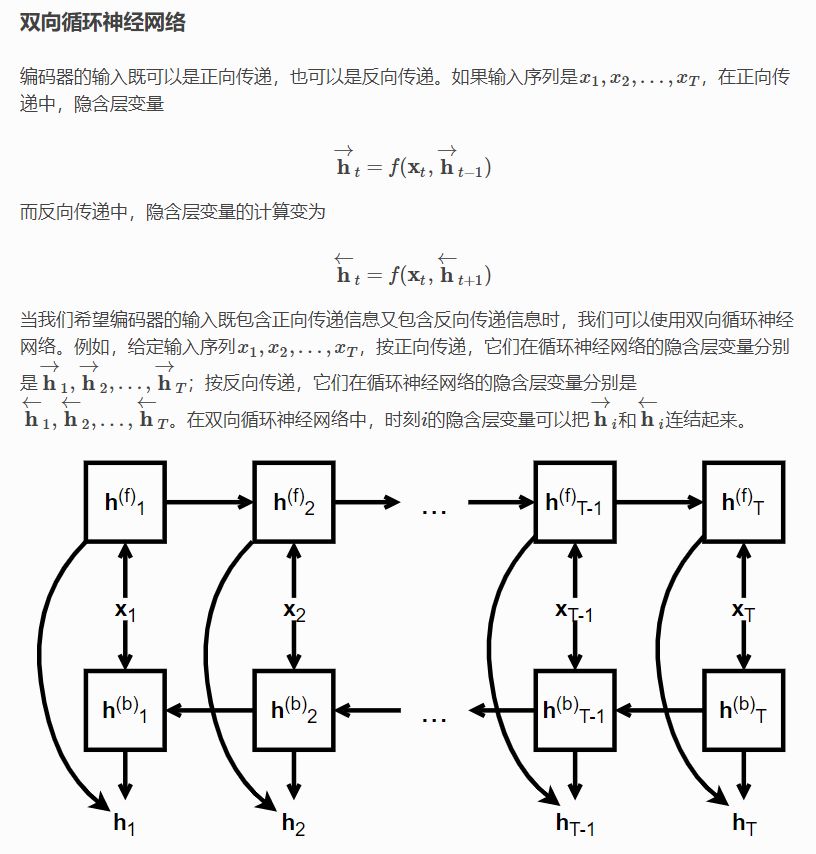

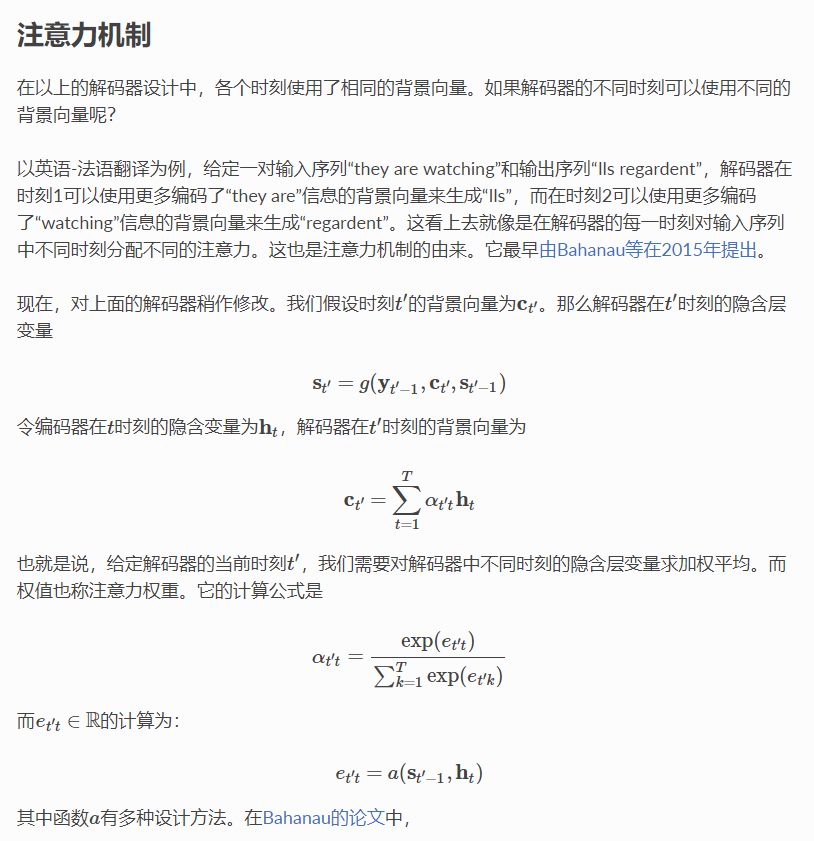

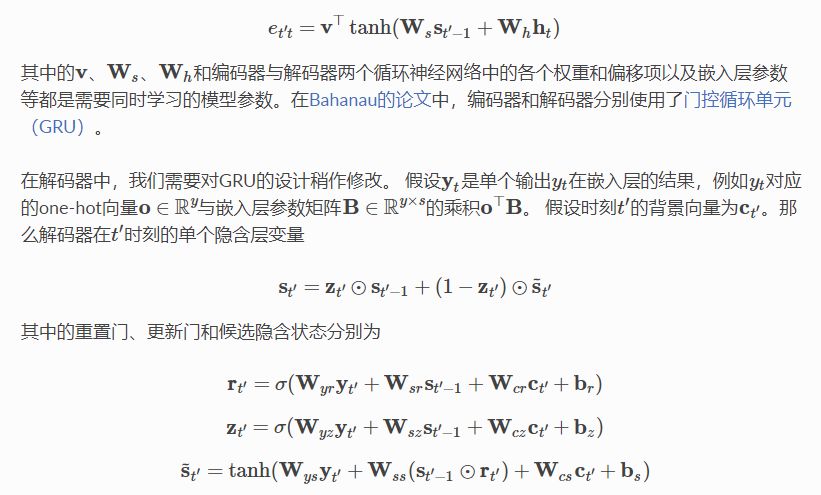

在循环神经网络中我们学习了如何将一个序列转化成定长输出(例如一个标签)。本节课中,我们介绍了如何将一个序列转化成一个不定长的序列输出(例如一个不定长的标签序列)。

获取完整回顾视频>>关注“将门创投”(thejiangmen)微信公众号,回复“第十八课”获取下载链接。

……

获取完整回顾视频>>关注“将门创投”(thejiangmen)微信公众号,回复“第十八课”获取下载链接。

转自:将门创投

完整内容请点击“阅读原文”

登录查看更多

相关内容

Arxiv

9+阅读 · 2019年3月29日

Arxiv

3+阅读 · 2018年3月20日