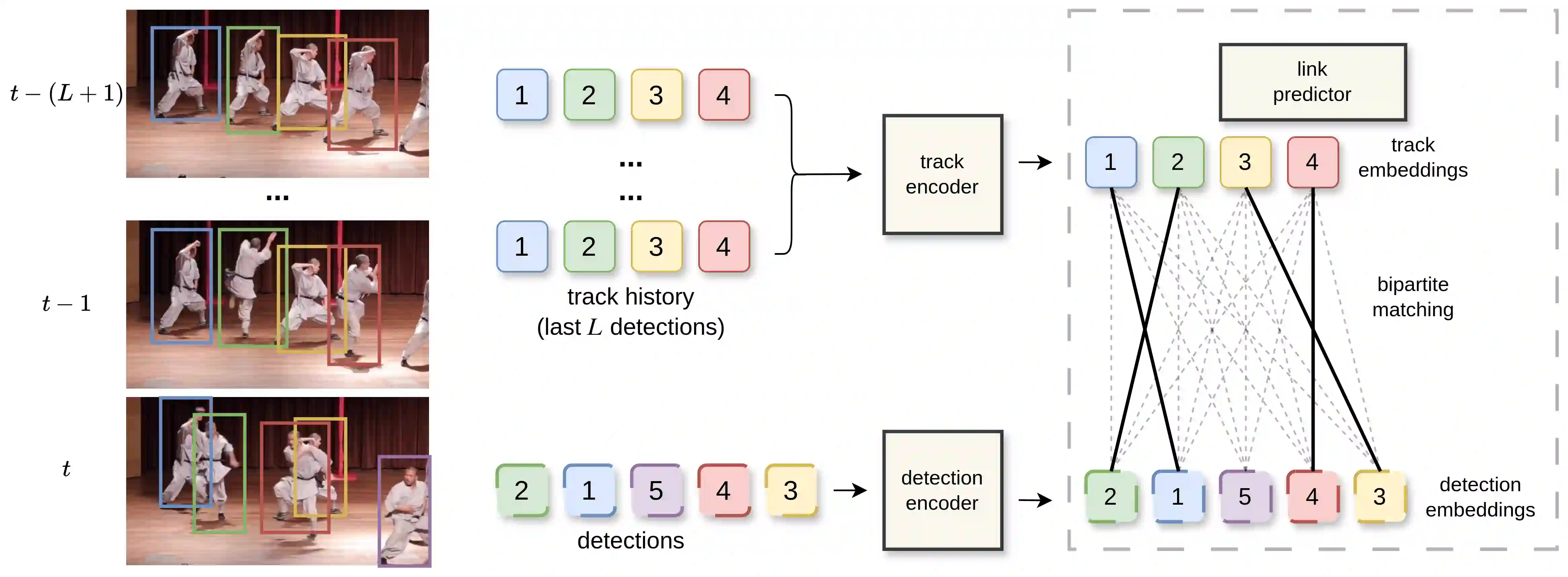

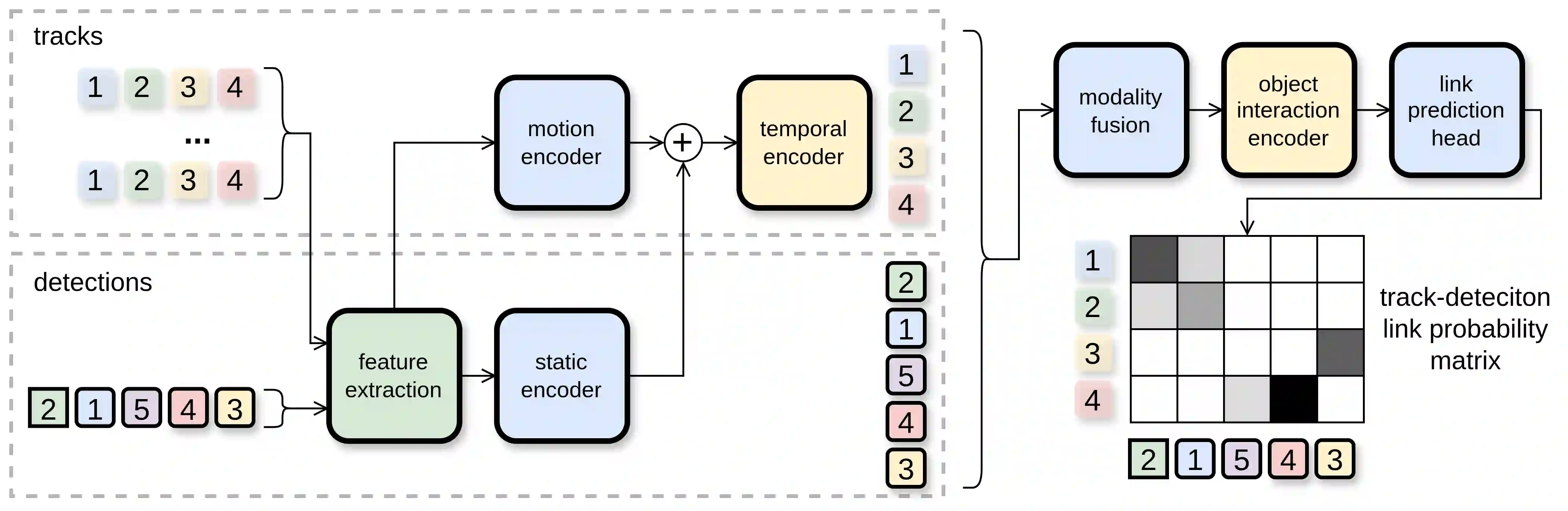

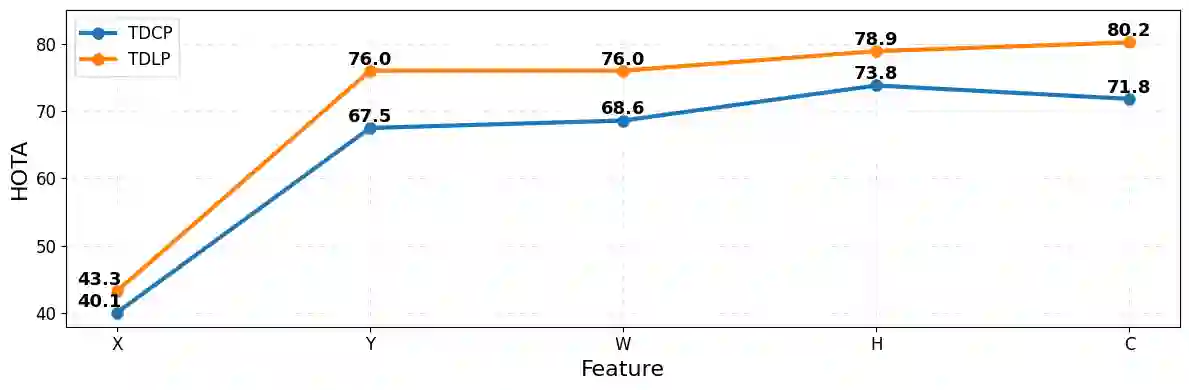

Multi-object tracking aims to maintain object identities over time by associating detections across video frames. Two dominant paradigms exist in literature: tracking-by-detection methods, which are computationally efficient but rely on handcrafted association heuristics, and end-to-end approaches, which learn association from data at the cost of higher computational complexity. We propose Track-Detection Link Prediction (TDLP), a tracking-by-detection method that performs per-frame association via link prediction between tracks and detections, i.e., by predicting the correct continuation of each track at every frame. TDLP is architecturally designed primarily for geometric features such as bounding boxes, while optionally incorporating additional cues, including pose and appearance. Unlike heuristic-based methods, TDLP learns association directly from data without handcrafted rules, while remaining modular and computationally efficient compared to end-to-end trackers. Extensive experiments on multiple benchmarks demonstrate that TDLP consistently surpasses state-of-the-art performance across both tracking-by-detection and end-to-end methods. Finally, we provide a detailed analysis comparing link prediction with metric learning-based association and show that link prediction is more effective, particularly when handling heterogeneous features such as detection bounding boxes. Our code is available at \href{https://github.com/Robotmurlock/TDLP}{https://github.com/Robotmurlock/TDLP}.

翻译:多目标跟踪旨在通过关联视频帧间的检测结果来维持目标身份随时间的一致性。现有文献中存在两种主流范式:基于检测的跟踪方法计算效率高但依赖于手工设计的关联启发式规则,以及端到端方法虽能从数据中学习关联但以更高的计算复杂度为代价。我们提出轨迹-检测链接预测方法,这是一种基于检测的跟踪方法,通过轨迹与检测之间的链接预测执行逐帧关联,即在每一帧预测每个轨迹的正确延续。TDLP在架构设计上主要适用于边界框等几何特征,同时可选择性地融合姿态和外观等附加线索。与基于启发式规则的方法不同,TDLP无需手工规则直接从数据中学习关联,同时相较于端到端跟踪器仍保持模块化和计算高效性。在多个基准测试上的大量实验表明,TDLP在基于检测的跟踪和端到端方法中均持续超越最先进性能。最后,我们通过详细分析比较了链接预测与基于度量学习的关联方法,证明链接预测在处理检测边界框等异构特征时更具优势。代码发布于\href{https://github.com/Robotmurlock/TDLP}{https://github.com/Robotmurlock/TDLP}。