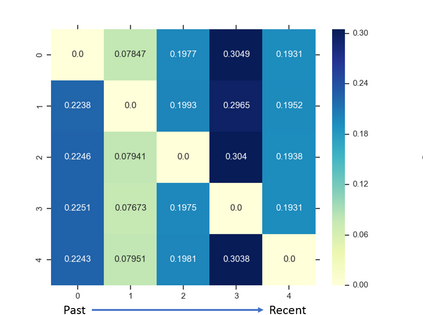

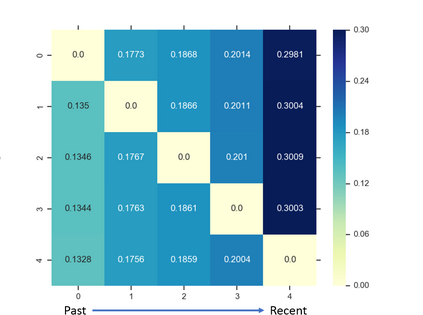

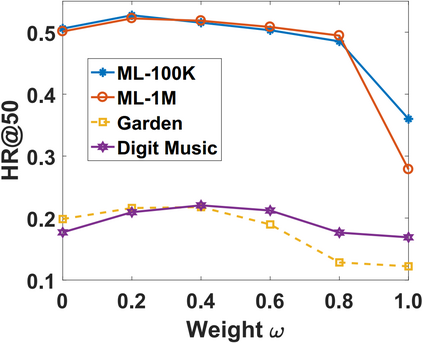

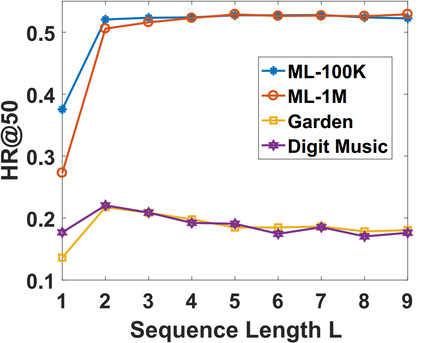

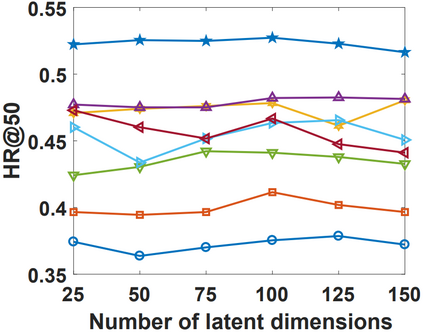

In this paper, we propose a novel sequence-aware recommendation model. Our model utilizes self-attention mechanism to infer the item-item relationship from user's historical interactions. With self-attention, it is able to estimate the relative weights of each item in user interaction trajectories to learn better representations for user's transient interests. The model is finally trained in a metric learning framework, taking both short-term and long-term intentions into consideration. Experiments on a wide range of datasets on different domains demonstrate that our approach outperforms the state-of-the-art by a wide margin.

翻译:在本文中,我们提出了一个新颖的序列意识建议模式。 我们的模型利用自我注意机制从用户的历史互动中推断项目项目项目的关系。 通过自我注意,它能够估计用户互动轨迹中每个项目的相对权重, 以更好地表达用户的短暂利益。 模型最终在一个衡量学习框架中接受了培训, 同时考虑到短期和长期的意图。 对不同领域的广泛数据集的实验表明,我们的方法在宽广的幅度内超过了最新技术。