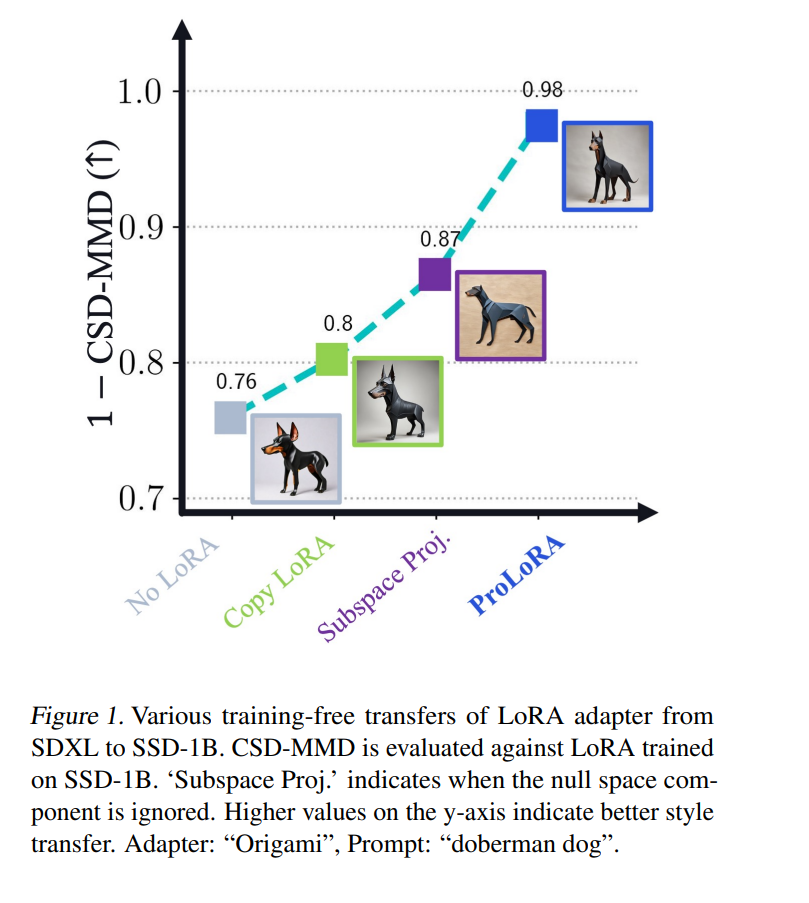

我们提出了 ProLoRA,一种实现文本到图像扩散模型中参数高效微调的零样本适应的方法。ProLoRA 能够在无需额外训练数据的情况下,将预训练的低秩调整(例如 LoRA)从一个源模型迁移到目标模型。这克服了传统方法的局限性:传统微调方式在更换基础模型时通常需要重新训练,而数据获取常常是难点。 ProLoRA 的关键在于:将源模型的调整内容投影到目标模型的权重空间,利用子空间与零空间的相似性,并有选择地应用于对齐的网络层。在多个主流文本生成图像模型上的评估表明,ProLoRA 能够成功迁移知识,在无需重新训练的前提下,实现与微调后模型相当的性能表现。

成为VIP会员查看完整内容

相关内容

Arxiv

40+阅读 · 2023年4月19日

Arxiv

210+阅读 · 2023年4月7日

Arxiv

20+阅读 · 2023年3月21日