1. 引言

随着AlexNet[1]在ImageNet比赛[2]上的识别性能的突破,人工智能有了很大的发展。提出了许多具有代表性的深度神经网络,如VGG[3]、ResNet[4]、Inception[5]、LSTM[6]等。研究人员通常为他们的任务收集和注释一些样本,并基于大规模数据集上预训练的基座训练他们的模型(例如用于计算机视觉的ImageNet[2],用于自然语言处理的Glove[7]和Skip-thought vectors[8])。与传统的手工功能相比,许多任务都可以通过这种端到端方式很好地解决,例如目标检测、分割和识别。然而,所得到的深度模型泛化能力仍然有限。收集和注释一个更大的数据集可以在一定程度上解决这些问题,但这个过程是昂贵和乏味的。 为了解决这个问题,Ashish等人提出了Transformer网络[9],该网络在机器翻译任务上取得了新的SOTA(最先进的)性能。之后,在大规模语料上进行自监督预训练,然后在下游任务上进行微调,吸引了越来越多研究者的关注。许多预训练的大模型都是遵循这样的范式提出的,如BERT [10], GPT [11,12], T5 [13], XLNet[14],也引发了CV领域预训练的新研究热点。越来越多的大规模NLP和CV模型通过预训练和微调范式展示了强大的效果,包括ViT[15]和Swin-Transformer[16]。

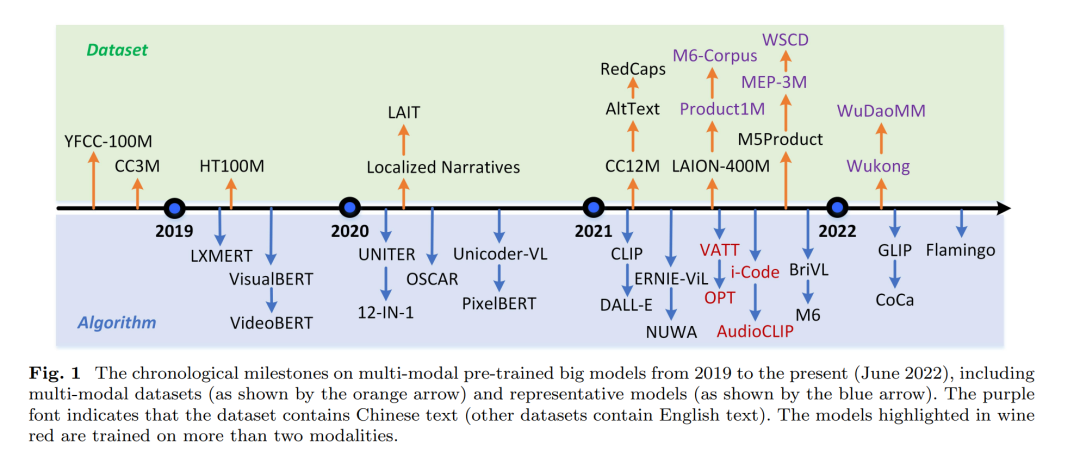

尽管这一进展为人工智能的发展带来了新的动力,然而,单模态缺陷所带来的问题仍然难以解决。研究人员试图纳入更多模态来弥合深度模型的数据差距。许多基于多模态融合的任务也采用传统的深度学习方式进行探索,如RGB、深度、自然语言、点云、音频、事件流等。许多大规模预训练多模态模型[17-23]被提出,这些模型在下游任务上相继设置新的SOTA,如图1所示。文中对这些工作进行了全面的综述,旨在帮助感兴趣的研究者快速了解该领域的历史和最新发展。

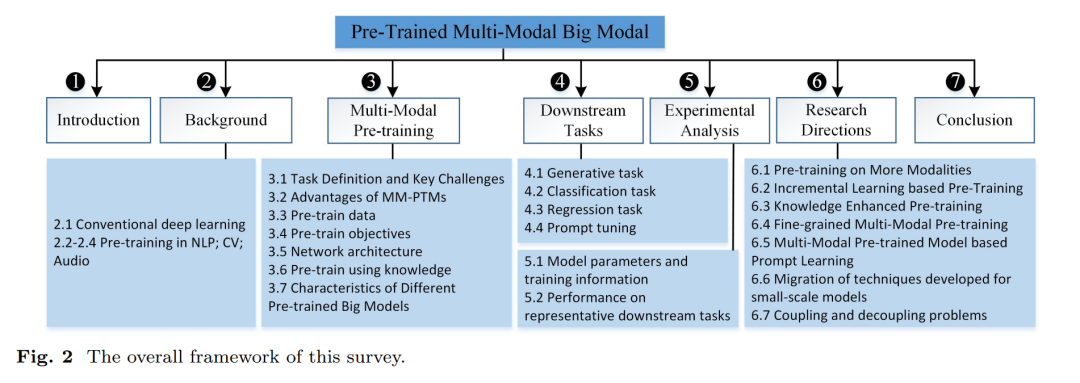

综述组织。文中首先回顾了多模态预训练技术的研究背景,从传统的深度学习范式到单模态任务的预训练,包括自然语言处理、计算机视觉和自动语音处理。然后,在3.1节和3.2节中,重点介绍MM-PTMs,并描述任务定义、关键挑战和好处。在以下子节中还将审查关键组件,包括大规模数据、网络架构、优化目标和知识增强的预训练。为了验证预训练模型的有效性,使用许多下游任务进行定量评估。在第4节中,详细回顾了这些任务的任务定义和评估指标。在第5节中,我们回顾了用于训练的模型参数和硬件,并报告了几个代表性下游任务的实验结果。最后,在第6节中,总结了本综述并提出了多个需要研究的研究方向。这个综述的架构如图2所示。

与现有评论的区别。虽然已经有两项针对MM-PTMs的综述[24,25],但我们的综述与现有综述之间的差异可以总结如下: * 范围:现有的多模态综述[24,25]只关注视觉-语言,然而,多模态信息问题是一个更广泛的研究主题。本文比上述综述更全面,引入了更多的模态,如音频、视频、表格等。 * 时效性:本文介绍了针对多模态预训练提出的最新数据集和算法(从2019年到2022年6月),这是一个很长的综述,同时,他们的工作属于短论文。 * 对MM-PTMs的新见解:通过从不同的角度对现有MM-PTMs进行分类和分析,本文可以帮助读者从详细和高层次的角度掌握最前沿的方法和技术。此外,提出的MM-PTMs研究方向是经过深思熟虑的,将为后续研究提供新的线索。

2. 多模态预训练

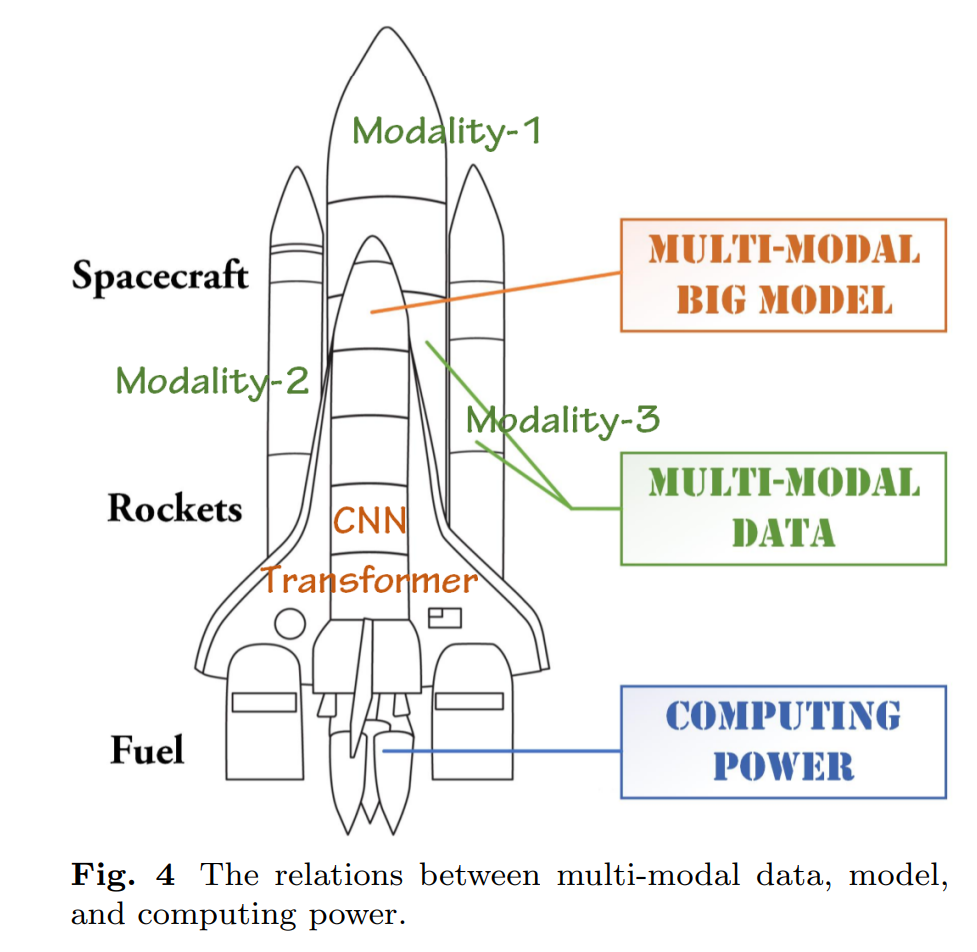

**任务的定义。**通常,深度神经网络是在大规模数据集上进行训练的,例如,广泛使用的残差网络[4]是在ImageNet数据集[2]上使用分类任务进行预训练的。相比之下,多模态预训练大型模型通常在大规模训练数据集上进行训练。通常,这些数据由于规模太大而无法标注,因此没有标注标签。另一方面,参数需要达到一定的规模。如图4所示,多模态数据、大模型和计算能力是紧密联系的。总之,多模态预训练通常是指在计算能力的支持下,对海量多模态数据进行无监督的预训练,即具有大量参数的多模态模型。

与单模态预训练大模型相比,MM-PTMs更适合实际应用场景。具体而言,MM-PTMs可以很好地解决多模态协同生成、模态补全、跨域检索等问题。同时,多模态数据包含更多的信息,可以弥补单一模态的缺陷。因此,MM-PTMs有助于提取多模态的共同特征。最近的许多工作表明,MM-PTMs的使用确实带来了额外的先验知识[76-78]。与小规模的多模态模型相比,通过自监督/无监督学习得到的MM-PTMs的泛化能力显著提高。由于一些先验知识仅包含在海量的大数据中,而人工选择的少量标注数据存在偏差,因此小规模模型很难掌握这些知识。

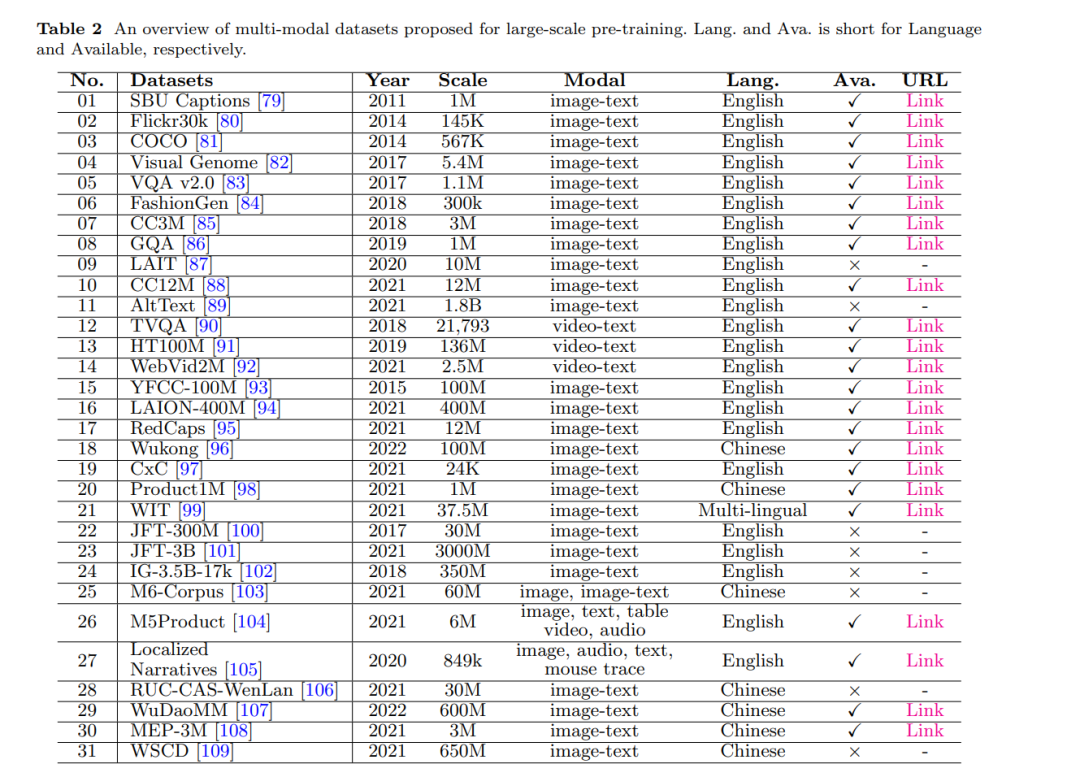

预训练数据集

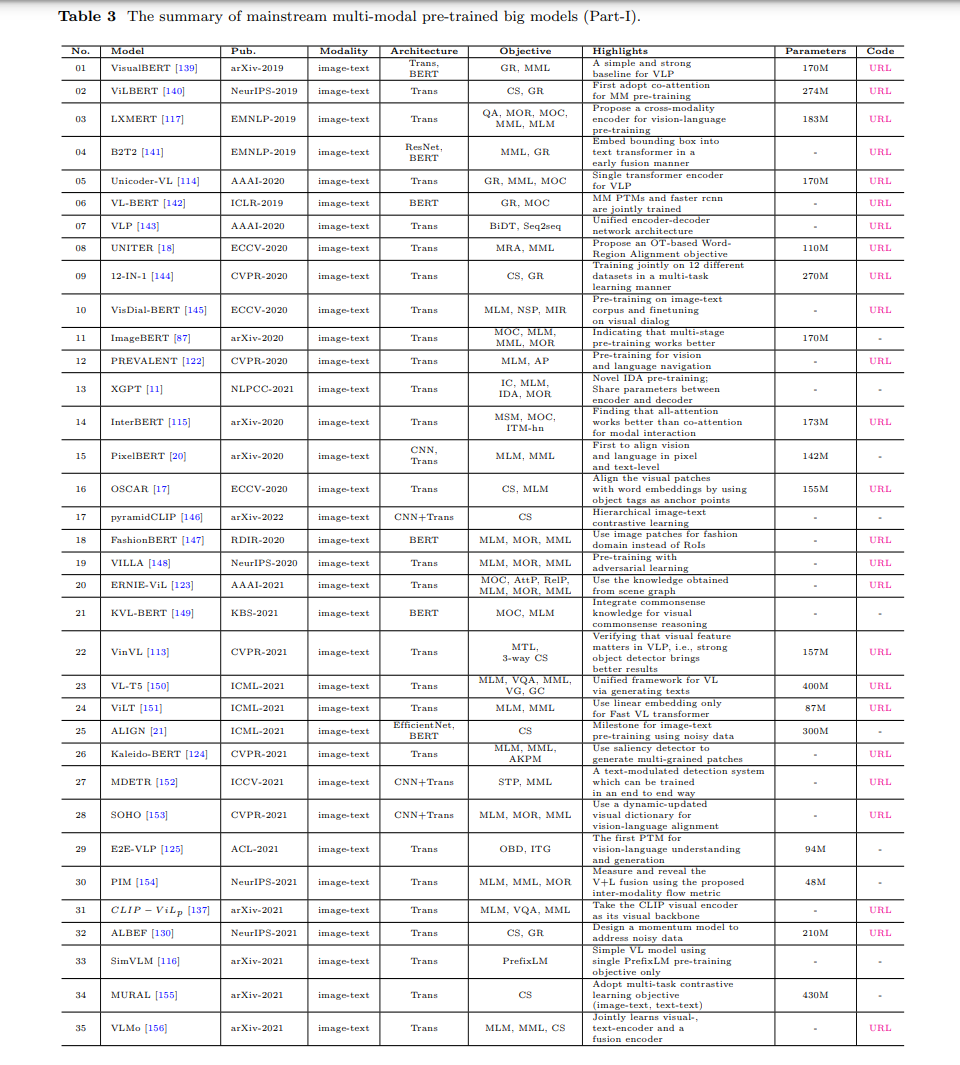

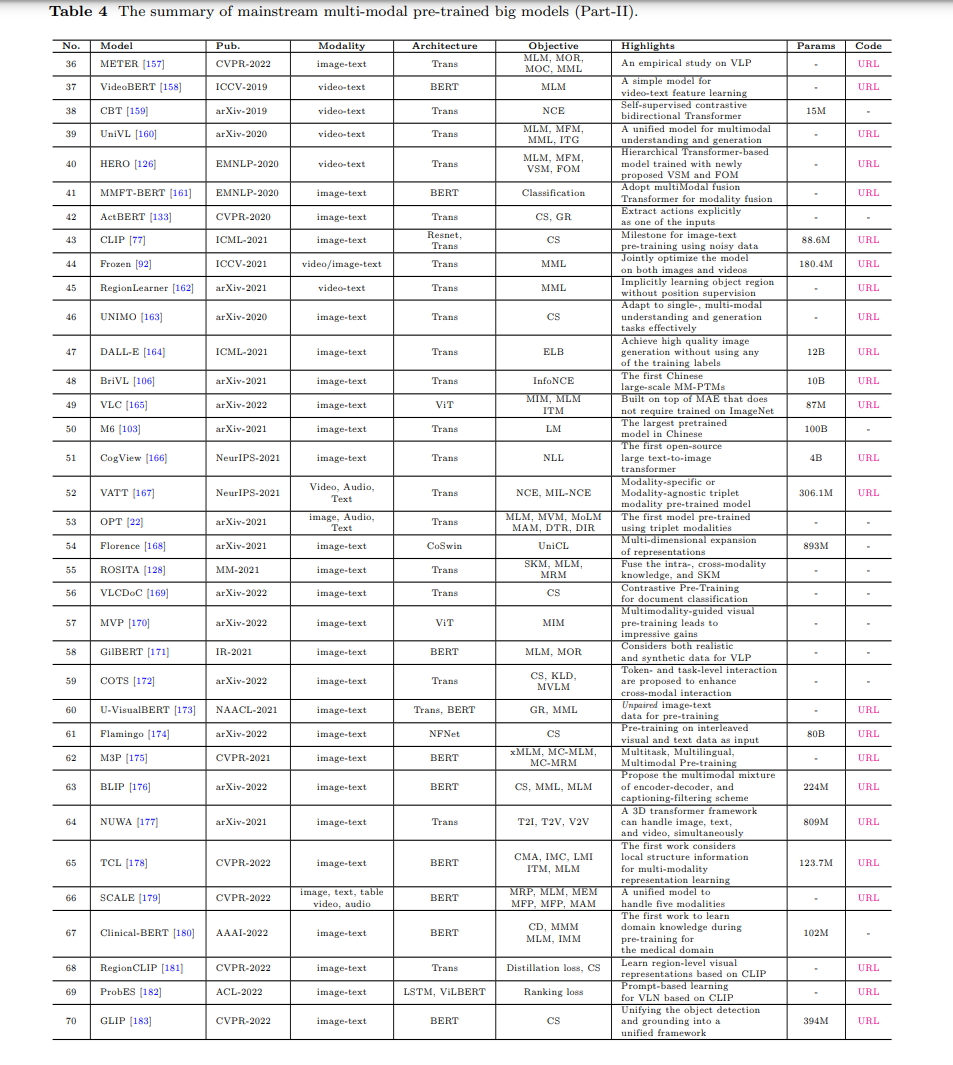

如表2所示,针对预训练任务提出了许多大规模多模态数据集。在本小节中,我们将简要介绍这些数据集,以帮助读者快速掌握预训练所需的数据信息。

预训练目标

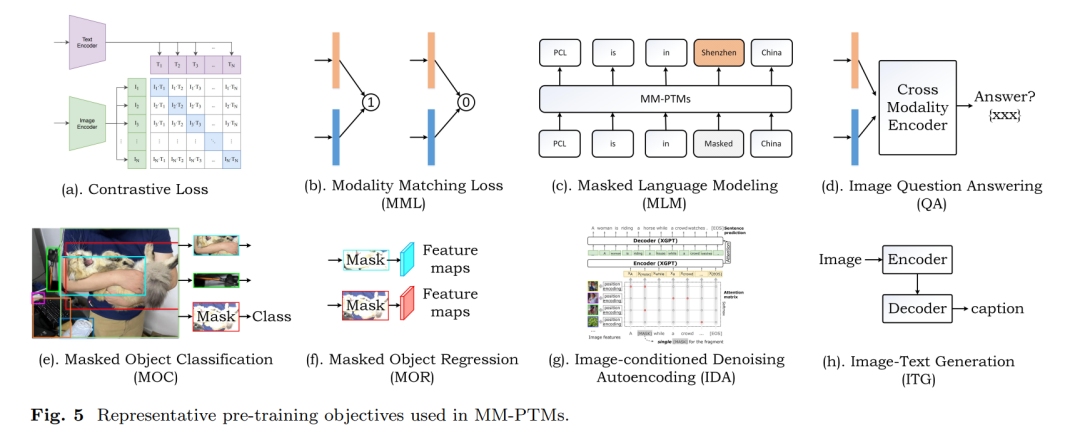

如何设计学习目标是多模态预训练中非常重要的一步。目前,提出了以下学习目标,包括对比损失、生成损失等。

预训练架构

在大规模预训练时代,目前大多数预训练模型的灵感来自Transformer(主要由自注意力层组成)。它最初是在2017年为自然语言处理任务[9]开发的,它在许多下游任务上大幅提高了新的SOTA性能。此类框架也被引入计算机视觉领域,因此,针对各种任务和输入设计统一的网络架构是当前的研究热点。

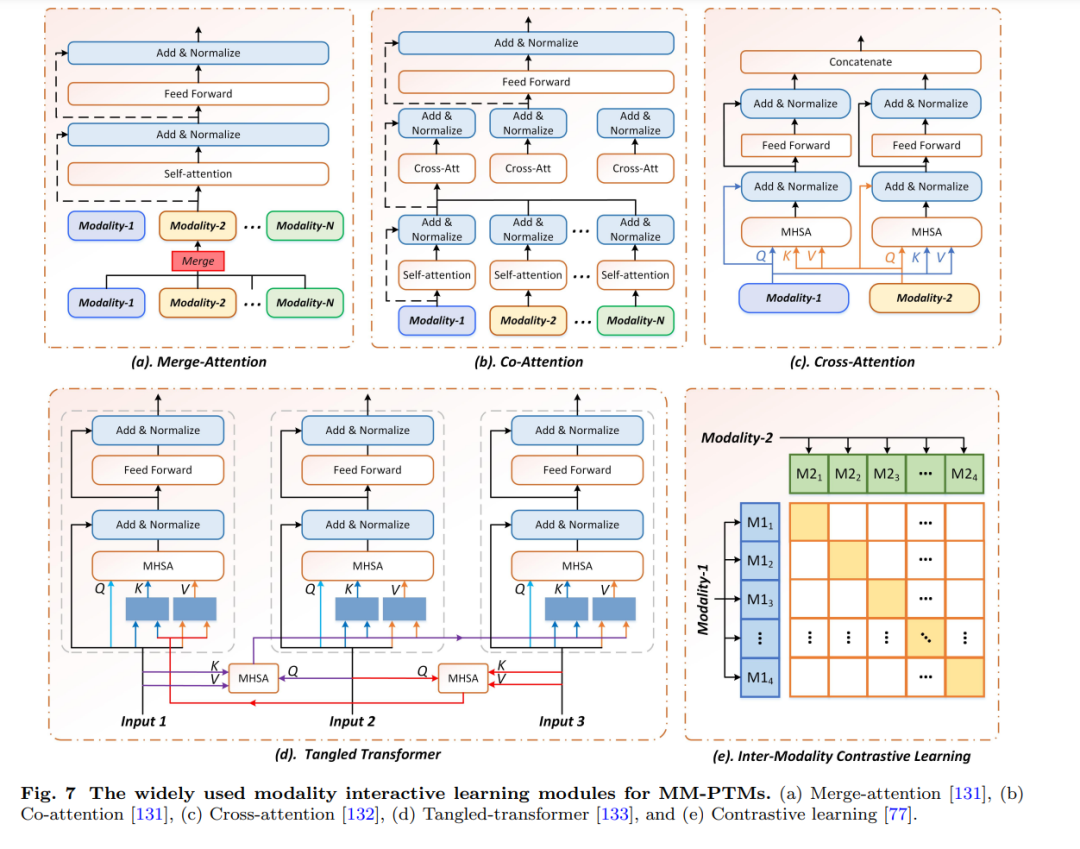

多层transformer广泛应用于目前许多MM-PTMs中。每个模态的输入首先由独立的编码器提取作为特征嵌入,然后与其他模态进行交互。根据多模态信息融合方式的不同,MM-PTMs可分为单模态和跨模态两类。在本小节中,我们将分别介绍这两种架构。

目前的大规模预训练多模态模型大多采用concate、add、Mergeattention、Co-attention和Cross-attention[132]来实现模态之间的交互学习。以下各段将介绍这些模块。

预训练知识利用

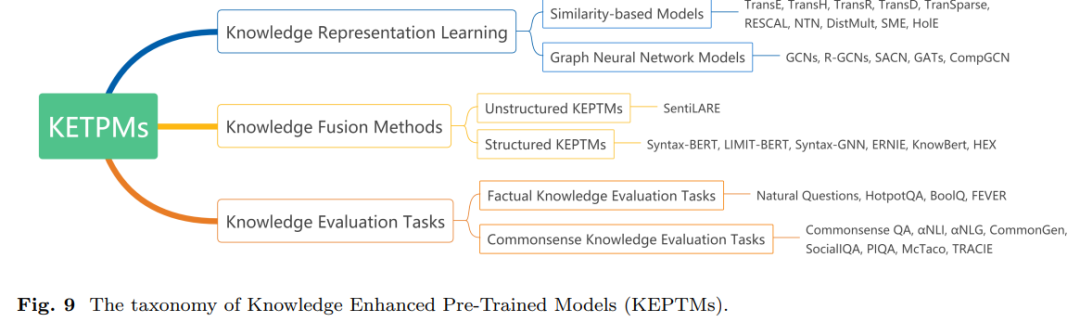

传统的预训练模型逻辑推理能力差,缺乏可解释性。为了缓解这些问题,在预训练模型中直接涉及知识,对数据的深入理解,即使用知识进行预训练,也称为知识增强预训练模型(KEPTMs),如图9所示。

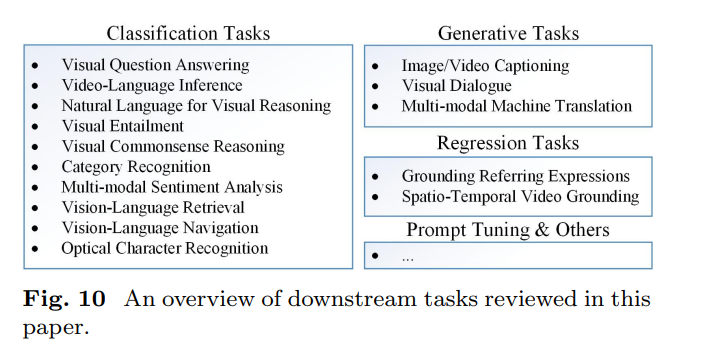

3. 下游任务

在预训练阶段之后,研究人员通常会在许多下游任务中测试他们的模型,以验证这种强大的能力。具体来说,验证采用了生成任务、分类任务、回归任务,下面将讨论这些任务。快速学习作为一种新的学习范式,以修改下游任务来适应预先训练好的大模型为目标,受到越来越多的关注。本部分还对几种有代表性的提示学习算法进行了综述。这些下游任务的概述如图10所示。