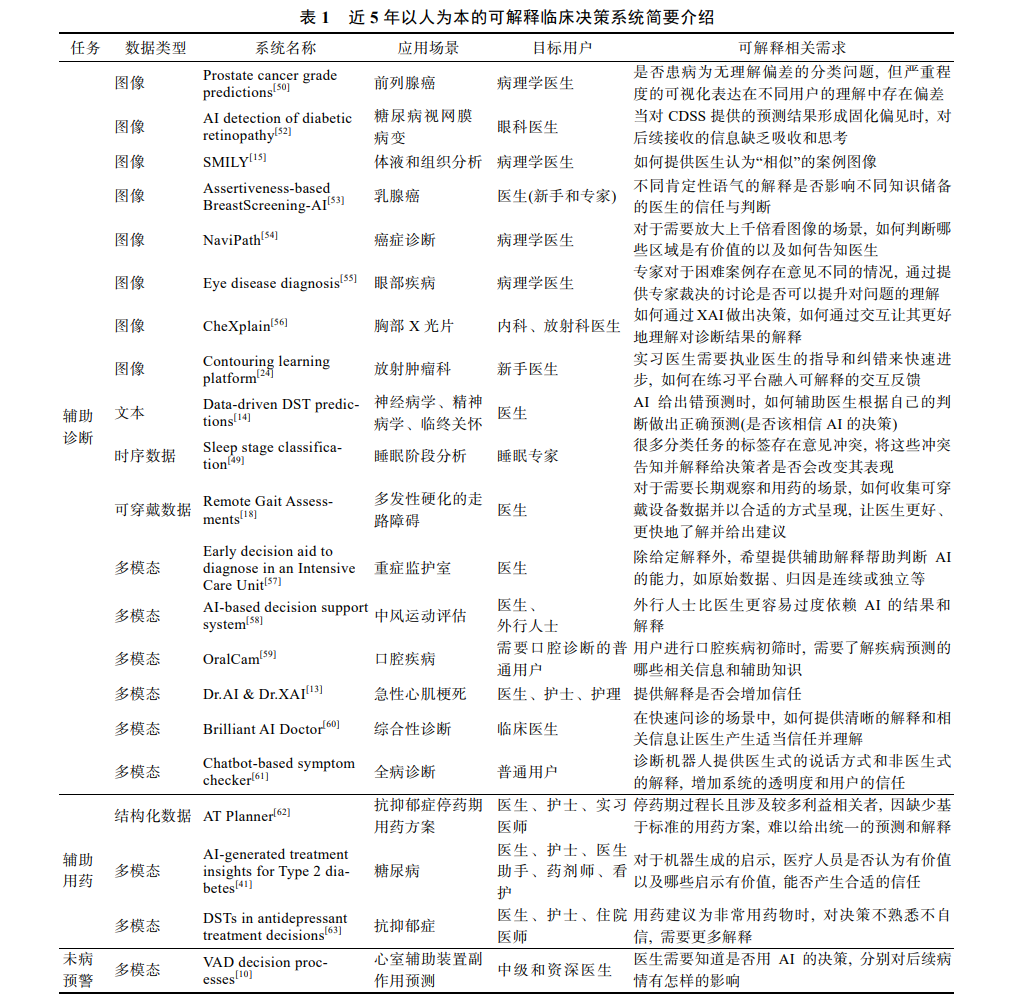

随着人工智能(artificial intelligence, AI)的高速发展, “黑盒”模型已逐渐展示出逼近甚至超越人类的能力, 尤 其在智能医疗等高风险应用场景中, 其可解释性是用户在应用中信任和理解 AI 的关键基础. 虽然已有工作提供了大 量事前和事后的 AI 可解释方法, 但大都采用通用型解决思路, 未考虑不同用户在不同场景下多维度的理解和信任需 求. 以人为本的 AI 可解释方法能够针对用户实际需求对 AI 模型进行可解释分析, 近年来逐渐受到国内外学者的关 注. 文中聚焦智能医疗应用, 对近 5 年人机交互国际顶级会议的文献进行分析, 回顾现有辅助诊断、辅助用药、未病 预警方面以人为本的 AI 可解释方法及系统, 从决策时间花费、用户专业度和诊疗工作流程 3 个维度梳理和定位可解 释需求的系统性方法, 得出 4 类典型用户画像和对应案例; 并从考虑资源受限、不同用户的多样需求、与现有流程结 合 3 个方面, 为如何设计可解释的医疗辅助诊断系统提出建议.

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日

Arxiv

152+阅读 · 2023年3月29日