多模态3D场景理解由于其在自动驾驶和人机交互等多个领域的广泛应用而受到了广泛关注。与传统的单一模态3D理解相比,引入额外的模态不仅提高了场景解释的丰富性和精确性,而且确保了更为鲁棒和有弹性的理解。在多变和具有挑战性的环境中,这尤为重要,因为仅依赖3D数据可能是不够的。尽管在过去三年中,多模态3D方法的发展呈现上升趋势,尤其是那些整合多摄像头图像(3D+2D)和文本描述(3D+语言)的方法,但值得注意的是,缺乏一个全面且深入的综述。在这篇文章中,我们提供了最近进展的系统性调研,以填补这一空白。我们首先简要介绍一个背景,正式定义各种3D多模态任务并总结其固有的挑战。之后,我们提出了一个新颖的分类法,根据模态和任务对现有方法进行了全面分类,探索了它们各自的优势和局限性。此外,我们还提供了最近方法在几个基准数据集上的比较结果,以及深入的分析。最后,我们讨论了尚未解决的问题,并为未来的研究提供了几个可能的方向。

https://www.zhuanzhi.ai/paper/db0ef107bb8313585581f0bab52ab996

给定一个3D点云和来自另一模态的信息,如2D图像和自然语言,多模态3D场景理解旨在理解每个物体及其周围环境的语义含义 [1], [2], [3]。对3D场景的全面理解使代理能够识别实体的类别和位置,并创建场景的新品牌内容和风格。与仅使用3D点云相比,2D图像的加入提供了额外的颜色和纹理信息,而自然语言的引入则实现了人机交互。因此,多模态3D场景理解已成为计算机视觉中的一个重要研究领域,应用于自动驾驶[4]、机器人导航[5]和人机交互[6]。

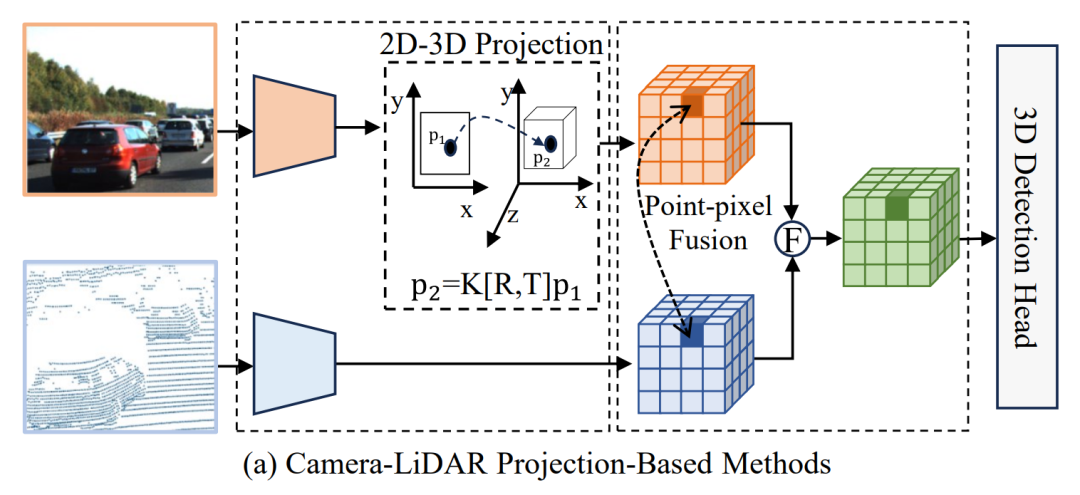

多模态3D场景理解可进一步分为:(1) 3D+2D场景理解。3D LiDAR点云提供了充足的深度和几何结构信息,这有助于获得3D物体的形状和姿态。但它们缺乏颜色信息和纹理细节,对于远距离的物体往往稀疏而无序[7], [8], [9], [10], [11]。相反,2D相机图像通常包含丰富的颜色、纹理和背景,但缺乏几何信息,且易受天气和光线条件的影响[12], [13], [14], [15]。自然地,利用LiDAR点云和相机图像之间的互补性可以更好地、更完整地感知3D环境。但这两种传感器捕获的同一个3D场景的表示之间经常会出现差异,因为LiDAR传感器通过360度旋转捕获点云,而相机从透视视图捕获图像,没有深度感[16]。为了解决这个问题,提出了一些3D+2D场景理解方法,通过基于几何的对齐[17]和基于语义的对齐[18]来进行LiDAR-相机融合。基于融合的特征,这些方法可以进一步执行3D物体检测和分割[19], [20], [21],这通常用于自动驾驶和机器人导航。(2) 3D+语言场景理解。传统的3D场景理解通常要求用户具有专业知识,这对普通用户不友好[22], [23], [24], [25], [26], [27]。用户现在期望有一种更便捷的方式将他们的意图传达给计算机,实现信息交换并获得个性化的结果。为了实现便捷的人机交互,研究人员提出了3D+语言场景理解。它结合3D视觉信息和自然语言作为输入[28], [29], [30],因为自然语言可以作为背景知识和查询条件来反映用户意图。通过多模态交互,经常采用如Transformer[31], [32]或图神经网络[33], [34]等技术,3D+语言场景理解方法不仅可以定位用户提到的实体(例如,视觉定位和开放词汇识别),还可以生成用户所需的内容(例如,密集字幕,视觉问题回答,场景生成)。

尽管近年来出现了众多方法,但多模态3D场景理解的很大一部分仍然分散在不同的任务中,并且没有此类系统的调查存在。因此,有必要系统地总结近期的研究,全面评估不同方法的性能,并有前瞻性地指出未来的研究方向。这激发了本次调查,将填补这一空白。本文的主要贡献可以总结为:

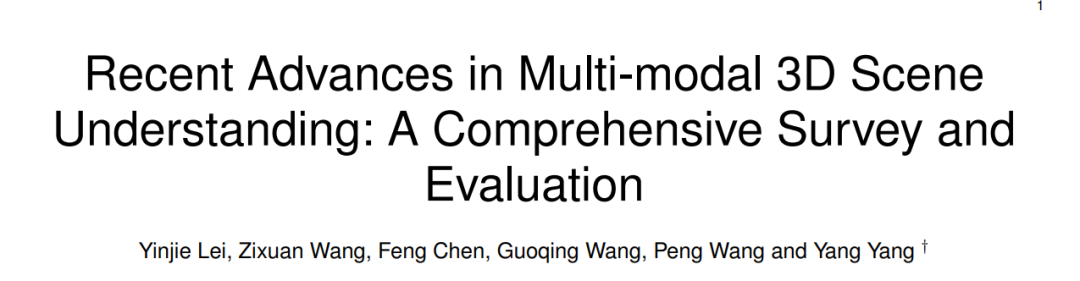

• 关于多模态3D场景理解的系统性调查。据我们所知,这是第一篇全面讨论多模态3D场景理解近期进展的调查。为了使读者对我们的文章有清晰的理解,我们从所需数据模态和目标下游任务的角度将算法分类为不同的分类,如图1所示。

• 全面的性能评估和分析。我们比较了几个公开可用的数据集上现有的多模态3D场景理解方法。我们的深入分析可以帮助研究者为其特定应用选择合适的基线,同时也提供了关于修改现有方法的有价值的见解。

•** 对未来前景的有洞察力的讨论**。基于系统调查和全面的性能比较,讨论了一些有前途的未来研究方向,包括大规模3D基础模型、数据高效训练、3D建模的计算效率以及添加额外模态。

本文的结构组织如下。第2节总结了多模态3D场景理解中的问题定义和主要挑战。第3节和第4节分别对3D+2D和3D+语言场景理解中用于不同下游任务的典型方法进行了深入探讨。第5节介绍了基准数据集、评估指标以及不同技术的比较分析。最后,第6节总结了这篇文章并讨论了未来研究的有前途的方向。

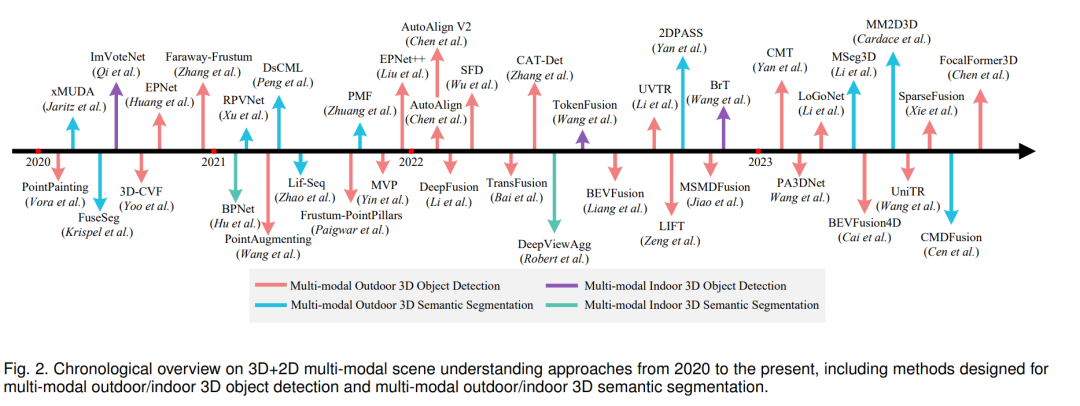

3D+2D多模态场景理解可以细分为多模态室外/室内3D对象检测和多模态室外/室内3D语义分割。从2020年至今的现有3D+2D多模态方法的时间性概述如图2所示。

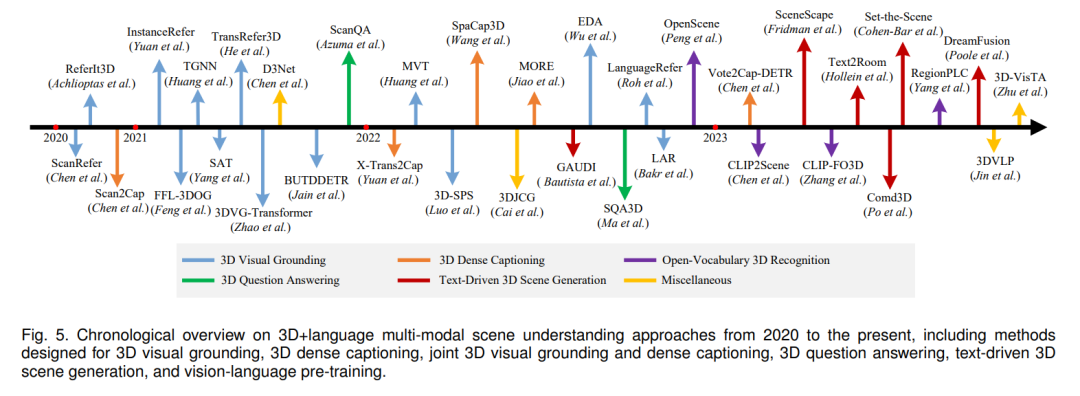

3D+语言多模态场景理解可以分为3D视觉锚定、3D密集标注、3D问题回答、文本驱动的3D场景生成、开放词汇的3D识别以及其他类别。从2020年至今的现有3D+语言多模态方法的时间性概述如图5所示。

**结论与展望 **

本综述为您提供了多模态3D场景理解的最新深入了解。我们首先总结了3D+2D和3D+语言情况下的任务定义和固有挑战。接着是对每个任务的关键技术的结构化分类。此外,我们提供了对几个基准数据集的最新进展的比较结果,并提供了有洞察力的观察。我们希望这项调查能为新手和经验丰富的从业者提供一个全面的指导。在多模态3D场景理解中,仍有许多进一步探索的可能性。以下提供了一些有前途的未来研究方向。 大规模3D-语言基础模型。基于2D到3D转移的当前3D VLMs在零射击能力和下游应用中受到限制,主要是由于数据规模有限和几何信息保留不足[41]。这强调了大规模3D-语言基础模型的必要性。解决这一挑战的主要解决方案在于创建可以支持从零开始训练VLMs的大型数据集。此外,高效的迁移学习方法,包括像提示调整[177]和LORA[178]这样的技术,通过利用预训练的知识为特定任务提供了很大的应用前景。

数据高效训练。考虑到与数据收集和注释相关的显著成本,当前的许多研究都局限于小规模数据集。因此,强调为有限数据量量身定制的健壮模型训练和优化的开发变得越来越重要,从而减少对大规模数据集的依赖。最近的研究已经在解决数据注释挑战方面展现出了有前途的结果,通过无监督和弱监督学习方法。此外,使用文本到图像或文本到3D生成合成逼真样本有望进一步被研究,这可能缓解数据收集问题。

3D建模的计算效率。鉴于点云的大量体积,计算需求可能会显著增加。因此,计算效率高的3D模型变得至关重要。为了应对这一挑战,采用模型压缩技术,如量化[179]、修剪[180]和高效结构[181],对于减少计算复杂性至关重要。此外,利用硬件优化如Flash attention[182]可以促进应用在边缘设备上的部署,为提高效率提供另一种途径。

纳入其他模式。尽管在多模态3D建模方面取得了令人印象深刻的进展,但主要的重点仍然是图像和语言。我们设想将更多的模式,如音频,纳入一个综合模型来适应它们的联合分布,这对于理解复杂的3D场景更为有助。鉴于训练新模型时的复杂训练要求和成对数据的稀缺,提高现有的多模态3D模型的效果可能更为有效,通过集成其他模式。一个可行的方法[183]是使用最小的成对数据集对齐每一个定义良好的、特定模式的模型。