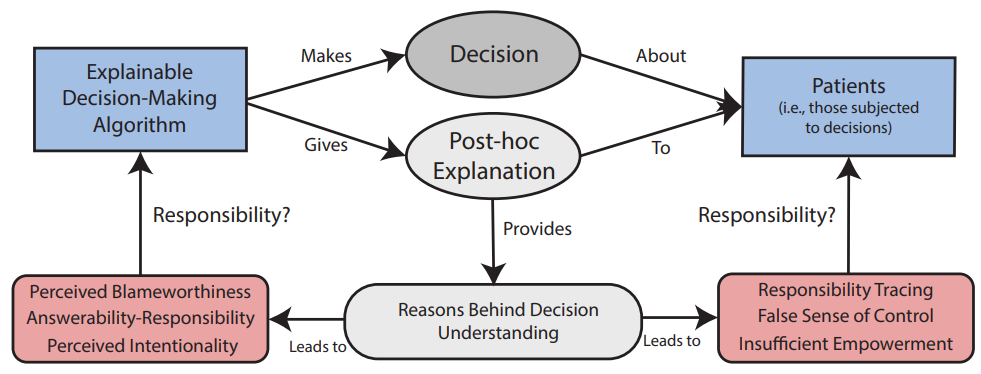

决策算法正在被用于重要的决策中,例如谁应该被纳入医疗保健计划和被雇用。尽管这些系统目前被部署在高风险的场景中,但许多系统无法解释其决策。这种局限性促使了可解释人工智能(XAI)计划的提出,该计划旨在使算法可以解释,以符合法律要求,促进信任,并保持问责制。本文质疑可解释性是否以及在多大程度上可以帮助解决自主人工智能系统带来的责任问题。我们认为,提供事后解释的XAI系统可以被看作是可问责的智能体,掩盖了开发者在决策过程中的责任。此外,我们认为XAI可能会导致对脆弱的利益相关者的不正确责任归属,比如那些受到算法决策影响的人(即病人),因为他们被误导地认为对可解释的算法有控制。如果设计者选择将算法和病人作为道德和法律上的“替罪羊”,这种可解释性和责任感之间的冲突就会加剧。我们最后提出了一系列关于如何处理算法决策的社会技术过程中的这种紧张关系的建议,以及为防止设计者逃避责任而进行的硬性监管辩护。

引言

人工智能(AI)现在被广泛用于各种情况,从娱乐等低风险的场景[90]到选择谁应该优先获得医疗帮助等高风险的生死决策[75]。广泛的研究已经提出了算法决策是否会对社会产生负面影响。例如,研究发现,算法保释决策有种族偏见[2],讨论了用于招聘决策的人工智能系统如何嵌入偏见[8],并发现在线广告对女性有歧视[27]。

大多数决策算法的一个主要问题是其不透明性。大多数算法都是黑盒的,不对其决策、建议或处理提供解释[76]。这一局限性是开发可解释人工智能(XAI)的核心动力,它提议通过 "使[其]功能清晰易懂 "来使算法变得可解释[3]。在算法决策的背景下,XAI创建的模型的行为可以很容易理解(即那些透明的模型),或者可以在决策后解释其行为(例如,通过提供事后的解释)。对XAI的呼吁已经在工业界、学术界和政策制定中变得很普遍[48]。

XAI领域的目标是创建便于将责任归于参与其开发和部署的人类智能体系统。由于责任差距的存在,分配算法决策的责任被广泛认为是一项困难的任务[4, 69]。正如Robbins[81]所主张的,可解释的系统将保持有意义的人类控制,允许将责任追溯到设计者、用户和病人(即那些受算法决策影响的人)。这并不是说,XAI的提出只是为了处理责任问题。例如,解释也可以用来遵守法律要求,促进对决策算法的信任,并评估其准确性[57]。

我们在本文中认为,XAI并不是解决自主决策算法所带来的大量责任问题的万能药。我们将讨论的重点放在那些被设计为做出后果性决定并能在事后提供解释的人工智能系统上,也就是说,那些可以事后解释的算法。虽然我们同意可解释的系统对于负责任地部署算法决策是必要的,但我们表明XAI的事后解释可能与公众对AI系统的代理权和可问责性的理解不一致。此外,我们讨论了那些受制于算法决策的人(即病人)如何可能被视为对XAI系统具有有意义的人类控制,并说明这种印象是错误的,不能转化为对算法的真正授权。

考虑到问责是对代理人采取行动的原因的反应[86],事后可解释的算法可能被视为可以解释其决定背后原因的行为者,因此是可问责的。可解释的人工智能系统也可能被视为比其不透明的同行更有能力和意图,从而导致更高的问责水平[63, 64]。这种印象掩盖了人类代理人在算法决策中的责任,并将普通人的道德判断转移到机器上,有可能影响政策制定者并阻碍有益的人工智能技术的采用[11, 19]。

出于对开发者可以为自主系统的部署洗白其代理权[82]并实施表面的道德措施以避免监管[38]的担忧,我们展示了他们如何利用XAI为病人创造一种虚假的理解和控制感。我们用研究来说明这种误导性的印象,研究表明,算法解释往往是无意义的,让个人无法真正控制[83]。XAI系统也可以被用来欺骗病人,甚至是那些在AI相关领域受过训练的人[33],制造道德和法律上的替罪羊。

通过说明可解释系统的责任是如何模糊的,我们以XAI领域的新颖和批判的视角分析了自主系统所带来的责任差距,从而对文献做出了贡献。我们的结论是对可解释系统的呼吁,这将强调开发者在整个决策算法的开发和部署过程中的责任。最后,我们讨论了目前的监管方法如何未能解决可解释性和责任之间的冲突,并提供了潜在的解决方案。

图 1. 此图中总结了要点。提供事后解释的决策算法可以被视为应为自己的决策负责的应受指责的代理人;我们解释了如何通过增加意向性和能力的归因来解释这种看法。可解释的系统还可能导致将责任错误地归因于受算法决策影响的人(即患者)。可解释的系统给人以自信和授权的印象,暗示患者应该承担一些责任。这个概念是不正确的,可能会被试图逃避算法决策责任的设计师所利用。