深度分层强化学习是深度强化学习领域的一个重要研究方向,它重点关注经典深度强化学习难以解决的 稀疏奖励、顺序决策和弱迁移能力等问题.其核心思想在于,根据分层思想构建具有多层结构的强化学习策略,运用 时序抽象表达方法组合时间细粒度的下层动作,学习时间粗粒度的、有语义的上层动作,将复杂问题分解为数个简 单问题进行求解.近年来,随着研究的深入,深度分层强化学习方法已经取得了实质性的突破,且被应用于视觉导航、 自然语言处理、推荐系统和视频描述生成等生活领域.该文首先介绍了分层强化学习的理论基础;然后描述了深度 分层强化学习的核心技术,包括分层抽象技术和常用实验环境;详细分析了基于技能的深度分层强化学习框架和基 于子目标的深度分层强化学习框架,对比了各类算法的研究现状和发展趋势;接下来介绍了深度分层强化学习在多 个现实生活领域中的应用;最后,对深度分层强化学习进行展望和总结.

强化学习(reinforcement learning,简称 RL)是机器学习领域的一个重要分支,它以马尔可夫决策过程 (markov decision process,简称 MDP)为理论基础,是一种交互式学习方法[1] .深度强化学习(deep reinforcementlearning,简称 DRL)作为深度学习(deep learning,简称 DL)[2]和 RL 的结合算法,同时具备了 DL的感知能力和 RL的决策能力,初步形成从输入原始数据到输出动作控制的完整智能系统.近些年,刘全等人[3]对 DRL进行了全面 的分析和解读,总结了深度𝑄网络(deep q-learning network,简称 DQN)[4]、深度确定性策略梯度(deep deterministicpolicy gradient,简称 DDPG)[5]和异步行动者-评论家(asynchronous advantage actor-critic,简称 A3C)[6]等经典算 法,并介绍了多种前沿研究方向.

分层强化学习(hierarchical reinforcement learning,简称 HRL)[7]作为 RL的重要分支,与经典 RL方法的最大 区别在于,它以半马尔可夫决策过程(semi-markov decision process,简称 SMDP)[8]为理论基础,基于分层抽象技 术,从结构上对 RL 进行改进,重点关注 RL 难以解决的稀疏奖励、顺序决策和弱迁移能力等问题,实现了更强的 探索能力和迁移能力.但是,HRL 仍然存在计算能力不足,无法对状态特征进行高效表达的问题,通常只能处理 离散状态-动作空间任务.在 DRL 的成功应用后,深度分层强化学习(deep hierarchical reinforcement learning,简 称 DHRL)[9]同样将 DL 方法引入 HRL 框架,不仅从理论层面对 HRL 进行了拓展,还利用深度网络实现了更强的 特征提取能力和策略学习能力,构建了更有效、更灵活的分层结构,可以有效解决更复杂的任务[10].随着 DHRL理论的发展和完善,逐步形成了,以下层策略学习基础任务实现能力,上层策略学习下游任务解决方案的问题求 解路线.目前,DHRL 已经被广泛应用于视觉导航[11]、自然语言处理[12]、推荐系统[13]和视频描述生成[14]等真实 世界应用领域.

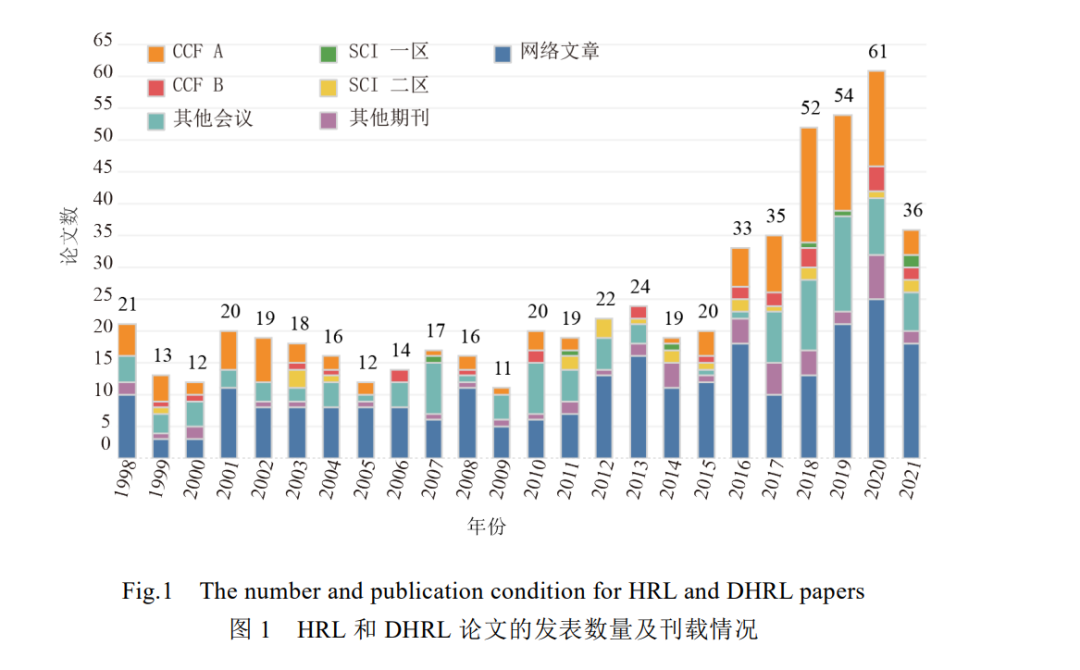

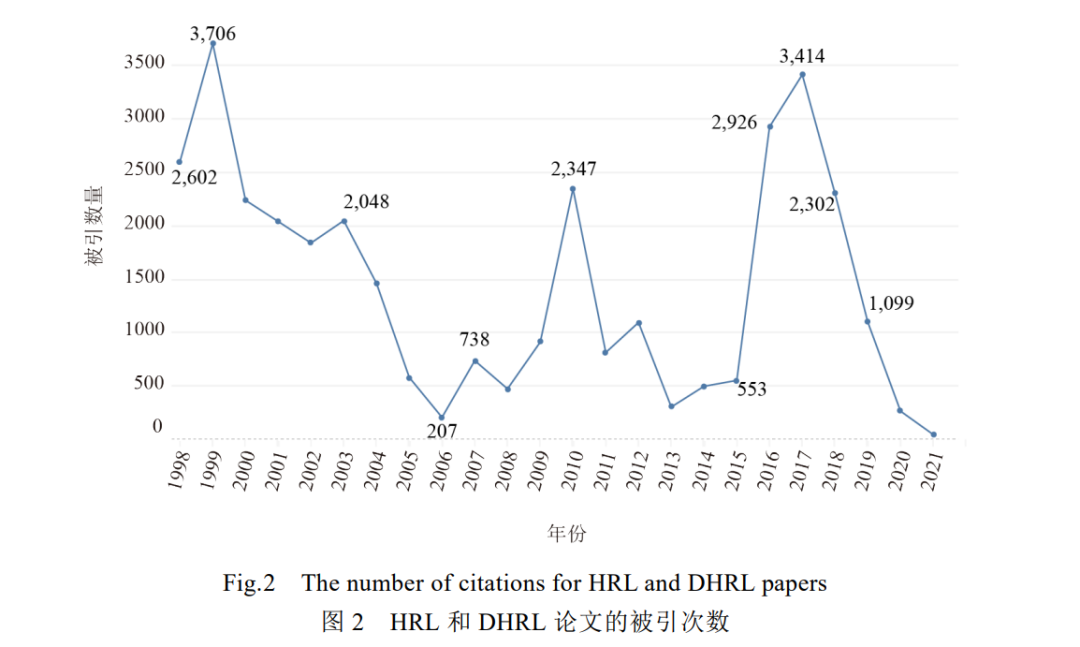

为了对 DHRL 进行系统的分析和总结,我们首先在中国计算机学会推荐国际学术会议和期刊,以及 CNKI论文数据库中,以“hierarchical reinforcement learning”,“option reinforcement learning”和“subgoal reinforcementlearning”等关键词进行检索,并在谷歌学术中,将被引次数超过 500 的核心论文[1, 15-17]作为基准,检索引用了这些 论文的HRL和 DHRL论文;然后通过人工审查方式,对已检索的论文进行筛选,排除与研究问题无关和已被收录 的网络论文.我们用图 1 和图 2 对所筛选论文进行展示.图 1 反映了从 1998 年(HRL理论基础被提出的年份[8])至 2021 年(截止到 2021 年 6 月),在各类会议、期刊和网络上,较有影响力的 HRL和 DHRL相关论文的数量及 刊载情况,它们中的绝大多数都被收录于 CCF A 类会议(112 篇)、CCF B类会议(25篇)、SCI 一区期刊(7篇)和 SCI 二区期刊(22 篇).图 2 反映了从 1998 年至 2021 年(截止到 2021 年 6 月),HRL和 DHRL相关论文的被引次 数.从图 1 和图 2 可以看出,一方面,HRL 与 DHRL 的研究热度逐年增加,尤其是在 2016之后,随着 DL的发展和 DRL 的出现,国内外学者对 DHRL 的关注程度与日俱增.另一方面,相关论文的被引次数在 1999年和 2017年出 现高峰,这与 RL 奠基工作的开展和 DRL 的飞跃式发展有着密切关系.

本文以 HRL 基础理论为研究脉络,重点关注 DHRL 的研究现状和发展趋势. 第1章对 HRL的基础理论进 行介绍;第 2 章描述了 DHRL 的核心技术,包括可以解决的问题、常用实验环境和 DHRL主流框架的划分依据;第 3、4 章分析了两种 DHRL 框架下的核心算法,详细说明了各类算法的发展历程、研究重心和优缺点;第 5章 对 DHRL 在现实生活领域中的应用进行介绍;第 6、7 章对 DHRL 进行展望和总结.

深度分层强化学习技术

SMDP 和时序抽象法作为 DHRL 方法的核心技术,是构造分层结构的基础,我们将这两种核心技术统称为 分层抽象技术.当一个序列动作包含多个序列动作或多个基础动作时,可以认为前者是比后者层次更高、语义 更强的动作[8] .将这些动作以一定规则进行组合,便形成了 DHRL 的多层结构.与经典 DRL相比,DHRL算法有更 强的问题解决能力,具体来说,DHRL 常用来解决以下 3 种问题:

(1) 稀疏奖励

DRL 的本质是利用奖励函数强化行为的过程,好的奖励函数可以反映任务的特性,引导状态和动作的价值 被正确估计,进一步优化策略.但经典 DRL 把状态空间看成一个巨大的、平坦的搜索空间[21] ,这意味着,智能体 从初始状态到终止状态的路径非常长,过长的路径会产生奖励信号变弱、延迟增高等问题.一旦环境只能提供 稀疏奖励信号,问题会变得更为棘手.此外, -贪婪策略和动作噪音作为 DRL常用的探索方案[22, 23],只能辅助智 能体探索临近的、有限的状态空间,尤其在稀疏奖励环境下,无法为智能体提供探索更广阔状态空间的动力.反 过来,探索能力又会影响算法在稀疏奖励环境中的性能.而 DHRL 利用分层抽象技术,可以组合多个时序扩展动 作,帮助智能体实现更大范围的状态空间快速覆盖,强化探索能力;同时,也可以快速捕获外部奖励,或收集内部 奖励,以此克服稀疏奖励问题.

(2) 顺序决策

许多任务的实现需要遵循一定的顺序决策过程,例如在蒙特祖玛的复仇中,需要先拿到钥匙才可以打开门.该问题有时也被看成部分可观测马尔可夫决策过程(partially observable MDP,简称 POMDP)[24, 25],因为从本质 上来说,如果不给予先验知识,钥匙的获取对智能体来说是不可观测的.经典 DRL往往无法记录中间过程,或找 不到决策规律.DHRL 的多层结构可以关注不同水平的知识结构[26] ,智能体在得到一些关键信息后,切换上层策 略,以实现对顺序决策信息的隐性表达.

(3) 弱迁移能力

经典 DRL 通常存在策略可迁移能力不足的问题,即每一个任务都需要学习专属的网络[4] ,且一种算法往往 只可以在单一或少数几个任务上取得较优结果.DHRL 能够学到具有高迁移能力的 option,在面对相似任务时,智能体可以快速获得学习能力[27] .同时,DHRL 充分利用状态抽象法,将不同状态转化为相似的抽象特征,建立有 效的状态特征表达机制[28] ,辅助 option 在相似状态区域上的重用. DHRL 具有较强的学习能力,可以说,DHRL 对复杂问题的求解能力正是源于分层抽象技术的应用.但分层 抽象技术同样也会引入一些额外问题,包括分层结构参数过多,训练时间过长,option学习过程与组合过程的矛 盾,异策略分层同步训练不稳定,以及子目标太远难以到达等问题.对于一些更具体的情况,我们将在后续章节 于每一个核心算法的论述中进行说明,并介绍更为优秀的算法如何在前文基础上进行改进,以解决这些额外问 题.

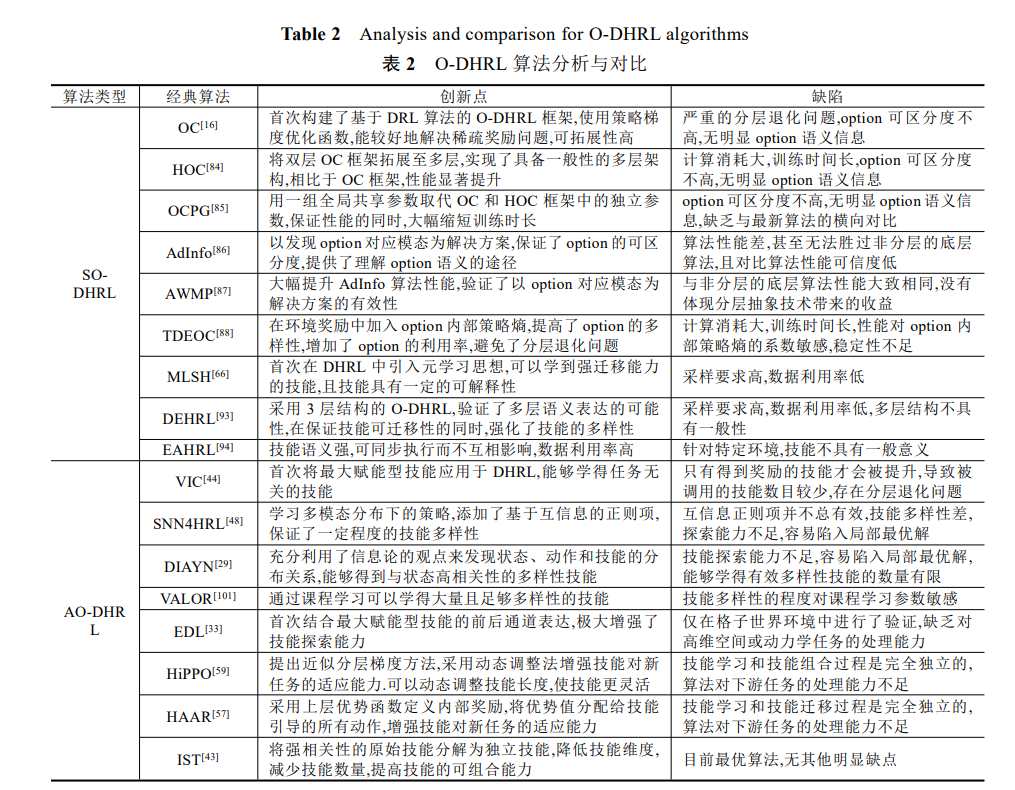

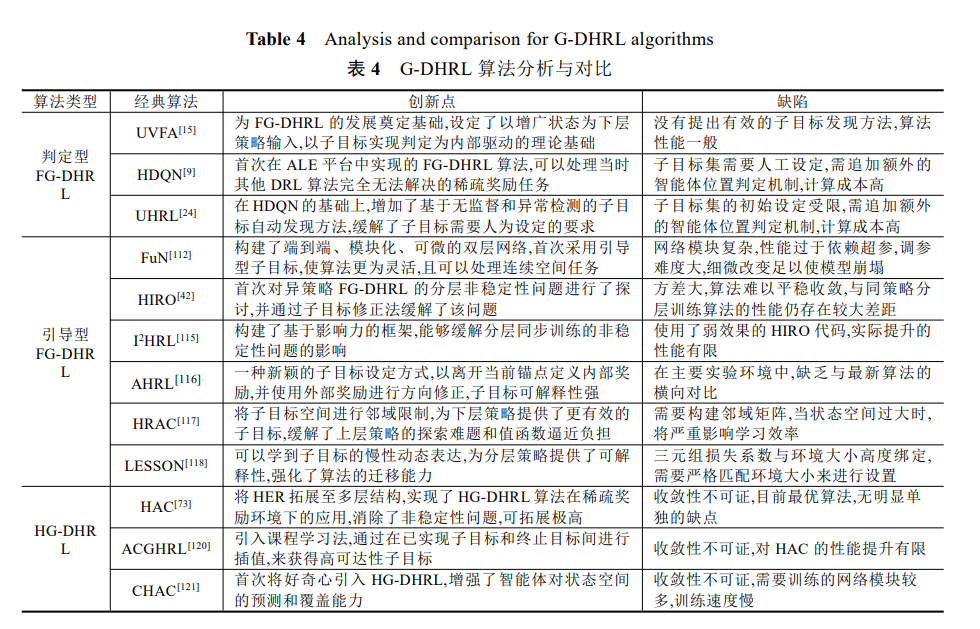

基于分层抽象技术,学者们提出了丰富多样的 DHRL 方法,根据求解思路的差异,我们将它们分为: (1)基于技能的深度分层强化学习框架(option-based DHRL,简称 O-DHRL)(option 在 O-DHRL中常被称为技能(skill),为保证符号的统一,下文依然用符号 o 来表示).下层网络学习一组技能,然后由上层网络调用这些技能,使用不 同的组合技能来解决下游任务;** (2) 基于子目标的深度分层强化学习框架**(subgoal-based DHRL,简称 G-DHRL).利用神经网络提取状态特征,然后将状态特征作为子目标空间.上层网络学习产生子目标,下层网络根据内部驱 动来实现子目标.除此之外,早些年学者还提出了基于子任务的分层强化学习框架(subtask-based HRL,简称 S-HRL)[60] ,但该框架引入了严重的先验知识问题,需要人工经验进行任务分解,如果原问题复杂难分,则难以使 用该方法.因此,在追求端到端解决问题的 DRL 领域中,极少有论文[61-63]以 S-HRL为基础进行拓展,不足以构成 完整的 DHRL 研究方向,故本文不讨论该支线.

基于技能的深度分层强化学习

O-DHRL 与 SMDP 密不可分,而求解 SMDP 问题的关键在于如何定义和寻找 option.从内容上看,option既 可以由先验知识定义,也可以由算法学习产生.从形式上看,option 既可以是单步的基础动作,也可以是一组动作 序列,或是另一组 option. O-DHRL 的每个 option 可以由一个 3 元组 ,

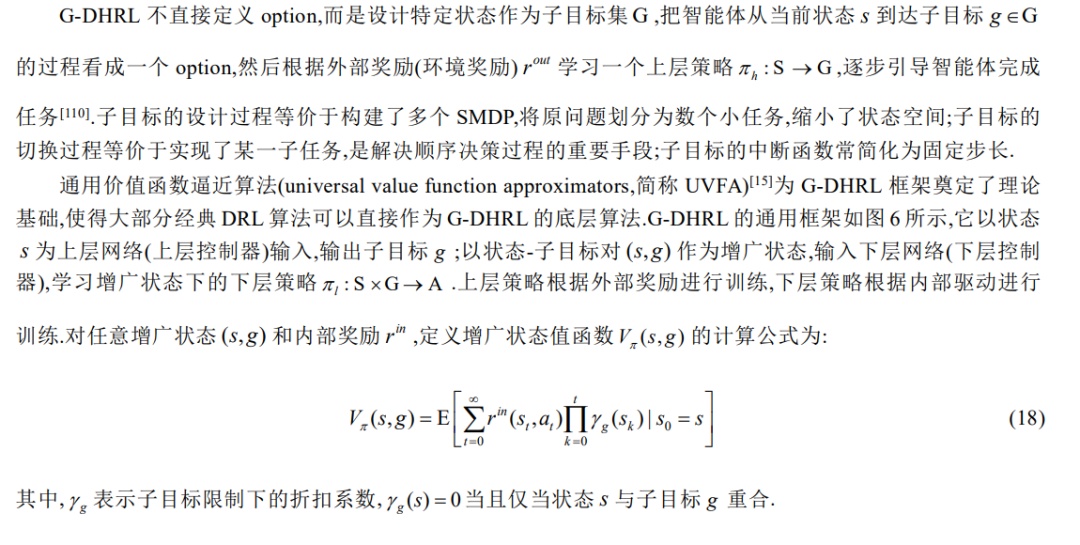

基于子目标的深度分层强化学习

深度分层强化学习应用

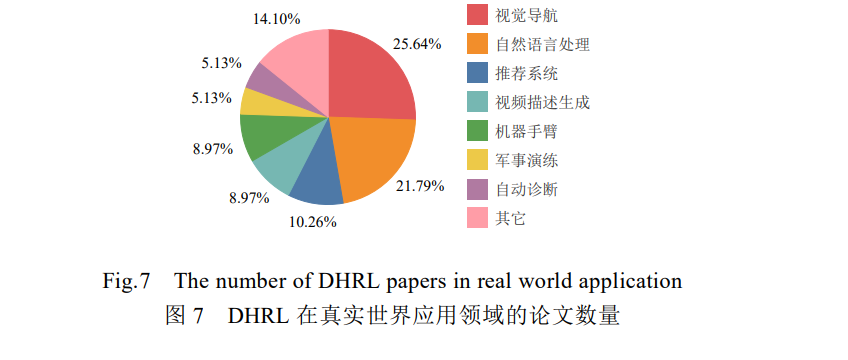

目前,DHRL 方法已经被广泛应用于视觉导航、自然语言处理、推荐系统和视频描述生成等真实世界应 用领域,以解决现实生活中的稀疏奖励和顺序决策等问题,并展现出巨大的商业价值.图 7描述了从 2016年至 2021 年(截止到 2021 年 6 月),DHRL 在不同真实世界应用领域的论文数量占比情况(共 78篇).

视觉导航领域

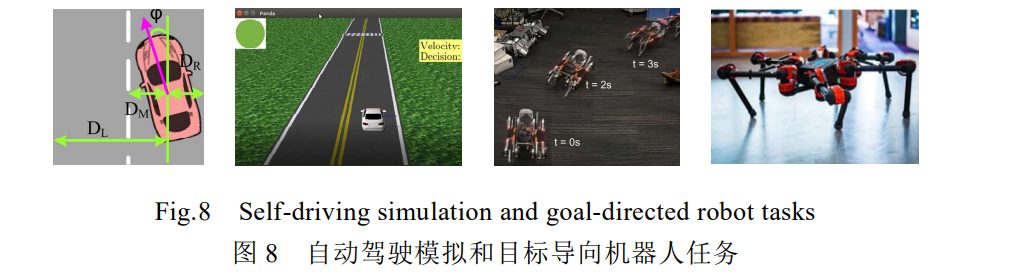

视觉导航领域包括自动驾驶模拟和目标导向机器人两种任务,它们不仅要求智能体具备对图像数据的表 达能力,还要求控制器能够以不同频率更新路况信息和动作策略.考虑到这些特性,将分层抽象技术应用在视觉 导航领域,可以发挥重要作用.

大量研究表明,许多动物在自我定位和路径规划方面形成空间表达的能力,都依赖于大脑对原始感知信号 的特征编码.在自动驾驶模拟任务中,慢性特征分析算法(slow feature analysis,简称 SFA)[123]从视觉图像中学得 拓扑地图,利用 DHRL 从拓扑地图中学得丰富的环境层级表达,为车辆在不同空间尺度上实现自我定位和方向 检测.在红绿灯通行问题中,Chen 等人[11]提出了一种分层策略梯度方法,学习数个简单且有差异的技能,然后组 合技能来获得对复杂问题的求解能力,使车辆在交通灯变黄时做出正确选择.这些算法的实验结果均表明,相比 于经典 DRL,DHRL 有更好的学习能力,可以帮助车辆实现模拟驾驶,包括并道和等待红绿灯等操作. 在目标导向机器人应用中,出于稳定和安全的考虑,位置估计器需要以较低频率更新,而动作控制器必须在 几毫秒内计算出电机指令.Jain 等人[124]针对 4 足机器人路径跟踪任务,充分利用 DHRL的分层结构特性和时序 解耦方案,为上下层控制器使用不同的状态表达,强调位置估计和动作控制的不同关注点,确保下层策略的可重 用能力;并在可变的时间尺度上更新上下层策略,减轻硬件对上层状态信息的处理需求.Li 等人[125]在 18自由度 机器人的多目标导向任务中,对技能进行预训练,得到可以实现简单目标的技能(如转弯和直线行走),然后对技 能进行规划学习.这种分层学习方式不仅可以利用预训练技能提高对多目标任务的求解能力,还可以减少构建 上层模型所需的硬件数据.

自然语言处理领域

DHRL 在自然语言处理领域常用于任务导向型对话生成(task-oriented)和开放域对话生成(open-domain)方 向,与经典环境 Atari 相比,这些任务的动作维度要高出多个数量级. 在任务导向型对话生成任务中,Budzianowski 等人[126]利用 DHRL 的强迁移能力来学习跨领域对话系统.考 虑到不同领域中存在着相似的子域,如订购房间和购买书本主域都有付款子域,该算法在不同主域的相似子域 中学习可共享的信息,以训练通用的下层策略.Saha 等人[127, 128]利用 DHRL框架来学习多意图对话策略.考虑到 大多数对话系统只使用了用户语义,而忽略了用户行为和情感在对话中的作用,该算法将基于情感的即时奖励 引入到对话系统基础奖励中,使问答机器人具有自适应能力,意图获得最大用户满意度.实验结果表明,用户情 感和行为等信息在创造复合性的问答机器人和最大化用户满意度方面,均发挥了重要作用. 在开放域对话生成领域,经典 DRL 方法[129, 130]往往只能在单词层面上构建奖励模型,这种低水平的控制将 不利于信用分配,导致奖励模型难以跟踪长期对话目标.为克服这一挑战,Saleh 等人[131]提出变分对话模型分层 强化学习算法(variational sequence model HRL,简称 VHRL),该算法不再单纯考虑单词级别的信息,而是在话语 层次上建立奖励模型,提高模型的全局视野和灵活性,以学习长期的对话回报.VHRL避免了在电影这类长对话 数据中,可能产生的不适当、有偏见或攻击性的文本,在人类评估和自动指标性能方面,均超过了最先进的对话 模型[132] .

** 推荐系统领域**

推荐系统具有巨大的商业价值,序列推荐(sequential recommendations)作为推荐系统中与 DRL技术紧密相关的研究方向[133, 134] ,意图通过交互获得的项目序列(item sequence)来刻画用户偏好. 对于同质项目(homogeneous items)(如不同类型的文章),注意力机制方法[132]已经可以区分不同历史项目 对推荐目标项目的贡献程度,但当用户记录存在过多噪音时,注意力机制的效果会变差.为了消除用户记录的噪 音,Zhang 等人[135]将推荐问题形式化为顺序决策过程,在由数据集和基础推荐模型构成的环境反馈下,上层控制 器判断用户记录是否需要修改,下层控制器对需要修改的项目进行判定和删除.该算法在慕课(open onlinecourses,简称 MOOCs)数据集中进行了验证,结果显示,可以有效消除用户噪音的影响.此外,为了克服项目数据 过大和用户记录稀疏的问题,Wang 等人[136]提出基于聚类的分层强化学习算法(clustering-based reinforcementlearning,简称 CHRL).该算法先对基础推荐系统进行预训练,然后设计分层结构来过滤可能误导推荐系统的交 互,同时加入聚类策略,以减少项目数据的稀疏问题. 相比于同质项目推荐系统,综合推荐系统[137]需要在一个页面中同时推荐异质项目(heterogeneous item)(如 文章和视频).Xie 等人[138]提出综合推荐分层强化学习框架(HRL framework for integrated recommendation,简称 HRL-Rec),在该框架中,上层控制器作为频道选择器,负责在列表推荐器中生成频道序列;下层控制器作为项目 推荐器,负责在频道列表中选择项目,以此捕获用户不同粒度的偏好.目前,该方案已应用于微信看一看线上系 统,实现了 DHRL 在推荐系统领域的商业价值.

视频描述生成领域

视频描述(video captioning,简称 VC)作为集视觉和文本两个维度的多模态任务,具有更高的复杂度.当前基 于 DL 的视频描述方法通常利用自动编码器(auto-encoder),来学习从视频序列到文本序列的转移过程[139],但这 些方法往往只能提取到粗粒度的视频特征,无法在噪音背景下捕获明确的对象,损失了对重要内容的理解能力.为消除视频噪音,提取细粒度的视频描述特征,Wang 等人[14]在 VC领域中引入 DHRL,将文本和视频语境视 为强化学习环境,定义任务为一个顺序决策过程.在该算法中,上层控制器为新文本片段产生子目标,下层控制 器按序列产生的单词来生成文本片段,采用二元判定机制评估当前子目标是否被实现.为了克服更具挑战的多 语句生成问题,Huang 等人[140]提出了一种 DHRL框架,上层控制器为每个图像序列生成语义连贯的主题,下层控 制器根据主题,使用语义合成网络生成句子描述,将句子生成建立在主题的基础上.该算法在视觉故事(visualstorytelling,简称 VIST)数据集上的评测结果表明,其性能明显优于其他 DL模型[141] .此外,Chen等人[142]首次将 DHRL 应用于视频摘要生成领域,将整个任务分解成若干子任务,通过定义子目标和内部奖励来解决稀疏奖励 问题.该算法在视频摘要数据集上的表现不仅超越了最先进的无监督方法[143] ,甚至超越了它的有监督扩展方法 [144] .