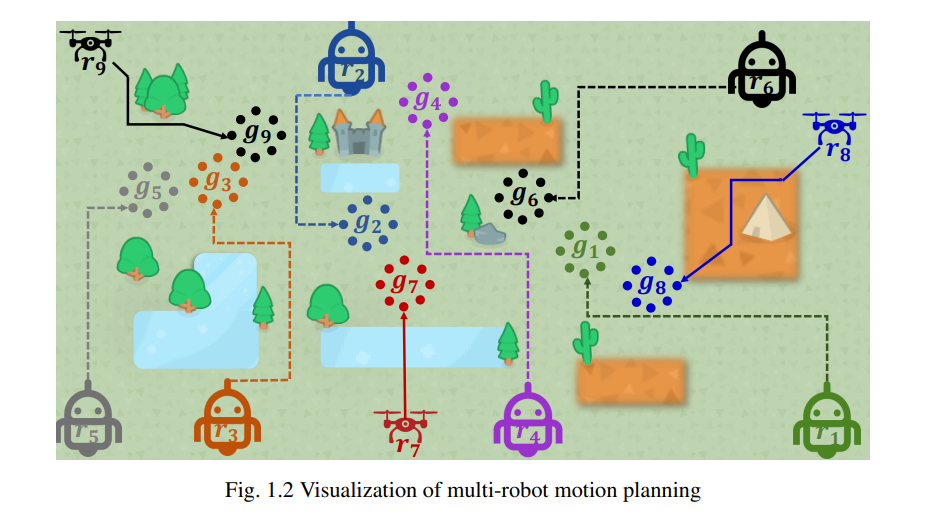

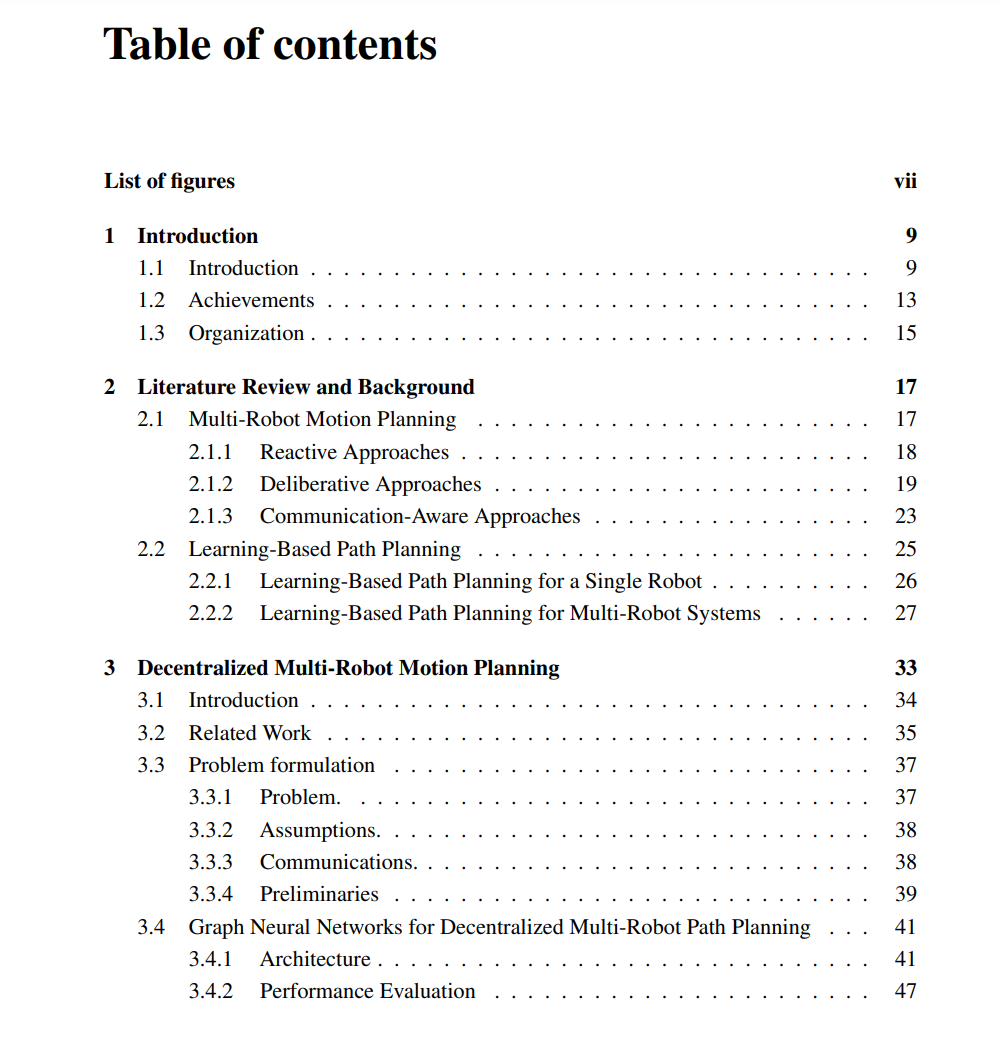

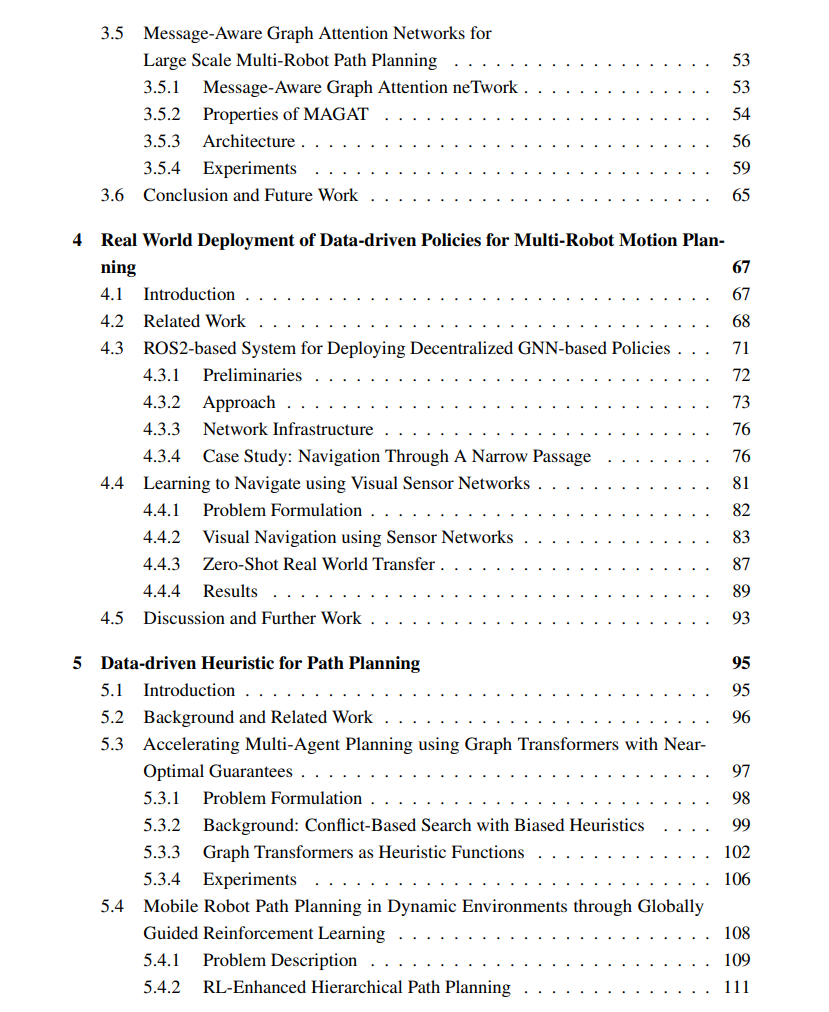

人口的快速增长和持续的城市化产生了对具有高生产率和效率的自动化系统的需求。多机器人系统的发展旨在通过控制一组机器人来处理大规模和复杂的任务(例如在地震后进行搜救操作)。控制这种系统的关键组成部分是在给定环境中引导每个机器人从起始位置到目标位置,使用无碰撞路径,这称为多机器人运动规划。随着团队规模的增加,基于集中式方法计算解决方案变得计算上昂贵且难以处理。因此,研究人员一直在探索分散式方法,以单独为每个机器人计算轨迹,并仅在出现冲突情况下进行重新规划。这种方法可以最大程度地减少任务的计算复杂性,但容易产生次优和部分解决方案。在计算解决方案的最优性和完整性保证之间取得平衡仍然是一个未解决的问题。

在本论文中,我们特别有兴趣探究基于机器学习(尤其是图神经网络)的方法,通过将在线计算转移到离线训练过程中,寻找在最优性和复杂性之间的权衡。然而,基于学习的方法也产生了对模拟到真实系统和解决方案的需求,以最小化差距,并为生成的解决方案提供可解释性和保证。因此,我们首先开发了一个框架,该框架可以基于图神经网络(GNN)来学习机器人之间的通信,以更好地在分散式方式下根据其局部信息进行个体决策。该框架由一个编码器(即卷积神经网络),它从局部观测中提取适当的特征,以及一个学习在机器人之间显式地传递这些特征的GNN,以及用于动作选择的多层感知器组成。通过共同训练这些组件,系统可以学会确定对整个团队而言哪些信息最相关,并将其共享以促进高效的路径规划。在此基础上,我们提出了一种名为"Message Aware Graph Attention neTwork"(MAGAT)的方法,将GNN与类似于键-查询的注意机制相结合,以提高机器人间通信的效果。我们通过在小问题实例上训练模型,然后在机器人密度增加、地图大小变化以及更大的问题实例(高达原机器人数量的100倍)上测试模型的泛化能力。

为了将我们的解决方案移植到真实世界,我们开发了一个基于ROS的系统,允许完全分散式地执行基于GNN的策略。我们在一个需要机器人之间紧密协调的案例研究中展示了我们的框架,并呈现了首次成功的结果,展示了基于GNN的策略在依赖临时通信的分散式多机器人系统上成功实现了实际部署。在扩展该系统时,我们提出了一种仅基于视觉的学习方法,利用GNN对相关的视点信息进行编码和传递给移动机器人。在导航过程中,机器人受到一个模型的引导,我们通过模仿学习来训练这个模型,以近似最优的运动基元,从而预测有效的到目标的成本。我们的实验证明了它在引导机器人在以前未见过的具有不同传感器布局的环境中的泛化能力。

基于纯GNN的分散式路径规划已经通过端到端的学习方法在经验上证明了其性能。然而,这些黑箱方法在直接部署到实际工作场所时面临挑战,因为它们很难找到一个有保证且可解释的解决方案。因此,我们设计了图变换器(Graph Transformer)作为一种启发式函数,以加速在非网格设置中(尤其是在密集图中)的基于冲突的搜索(Conflict-Based Search,CBS)中的焦点搜索。我们的框架保证了解决方案的完备性和有界次优性。为了增强强化学习的可解释性和解释性,我们引入了全局路径规划算法(例如,A*算法)来生成全局最优路径,这作为奖励函数的一部分,鼓励机器人通过最优路径进行“弱监督”探索所有潜在解决方案。由于我们的奖励函数与环境无关,我们训练的框架可以推广到任意环境,并且可以以完全分布式的反应方式解决多机器人路径规划问题。

在我博士研究期间,我首先提出了面向多机器人协调的通信感知运动规划,引入了GNN来构建多机器人团队的通信通道,使它们可以学会如何显式地进行通信。通过基于端到端模仿学习流程的各种仿真实验,验证了这一新颖研究思想的可行性。为了将它们移植到现实中,我们构建了一个基于ROS2的系统,通过临时通信在多机器人通道情景中展示我们的思想,并在未知环境中通过随机采样的基于摄像头的传感器辅助单机器人导航。最后,我们通过在CBS的焦点搜索中引入启发式函数,并设计了一种名为G2RL的新型奖励机制,为先前的黑箱方法提供了解释和性能保证的方法。