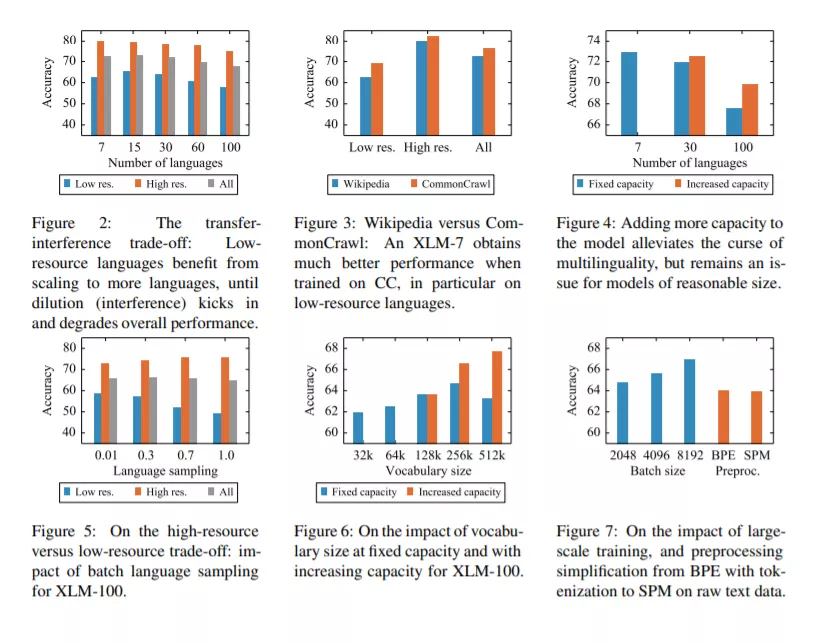

本文表明,在大规模的多语言预训练模型,可以显著地提高跨语言迁移任务的性能。我们使用超过2TB的过滤CommonCrawl数据,在100种语言上训练一个基于Transformer的掩码语言模型。我们的模型被称为XLM-R,在多种跨语言基准测试中显著优于多语言BERT (mBERT),包括XNLI的平均正确率+13.8%,MLQA的平均F1分数+12.3%,NER的平均F1分数+2.1%。XLM- r在低资源语言上表现特别好,与以前的XLM模型相比,XNLI在斯瓦希里语上的准确率提高了11.8%,在乌尔都语上的准确率提高了9.2%。我们还对实现这些收益所需的关键因素进行了详细的实证评估,包括(1)积极迁移和能力稀释之间的权衡,以及(2)大规模高资源语言和低资源语言的性能。最后,我们首次展示了在不牺牲每种语言性能的情况下进行多语言建模的可能性;XLM-Ris在GLUE和XNLI基准上有很强的单语言模型,非常有竞争力。我们将使XLM-R代码、数据和模型公开可用。

成为VIP会员查看完整内容

相关内容

专知会员服务

36+阅读 · 2020年4月14日

专知会员服务

27+阅读 · 2020年4月5日

Arxiv

3+阅读 · 2018年5月31日