自2012年AlexNet赢得ImageNet挑战赛以来,深度神经网络(DNN)在能力方面实现了数量级的飞跃。这一成功的主要推动力之一是大规模、高质量的精心构建的数据集的可用性。这类数据集(如ImageNet、MSCOCO等)通常通过人工方式在各类别之间进行均衡,以便模型能更好地学习所有类别。然而,这种构建过程代价高昂,往往需要舍弃宝贵的已标注样本,以平衡类别分布。现实世界中的数据(如来自互联网)分布与这些精心构建的数据集显著不同,往往集中于常见类别,导致类别严重不平衡。

因此,专为理想数据设计的算法在处理这类“长尾不平衡”与分布偏移的现实数据时性能明显下降。要拓展深度模型在现实中的应用,就必须摆脱依赖大量人工数据筛选的瓶颈,发展出能够从真实世界的有限与不完美数据中学习的鲁棒算法。

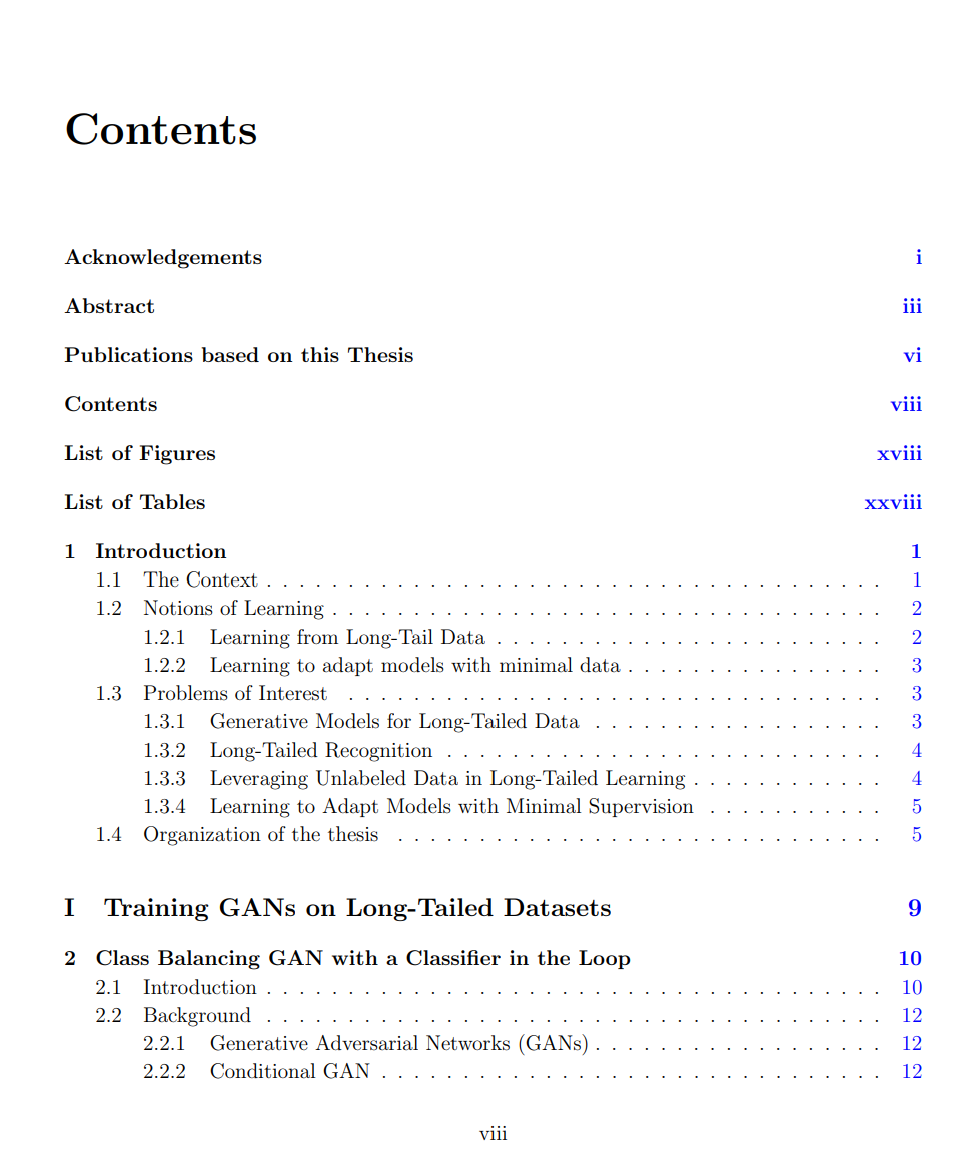

为达此目标,本论文提出了一系列实用的深度学习算法,使模型能够从现实中的有限与不完美数据中学习。论文分为四个部分,分别对应四类典型的学习场景:

一、从长尾数据中学习生成模型

首先,我们评估了生成对抗网络(GAN)在长尾数据集上的表现,发现现有GAN变体普遍存在模式崩溃(mode collapse)或类别生成遗漏的问题。为缓解这一现象,我们提出Class Balancing GAN with a Classifier in the Loop,通过引入分类器评估生成图像的模式分布,并反馈引导GAN均衡地生成各类样本。 进一步,我们发现GAN中的BatchNorm参数的谱范数爆炸与模式崩溃高度相关。于是提出Group Spectral Regularizer(gSR),一种低成本的正则化方法,有效抑制谱崩溃,并显著提升SNGAN和BigGAN等主流条件GAN在长尾数据上的性能。但在大规模数据集上,gSR可能引入类别混淆。 为解决此问题,我们在最新工作NoisyTwins中设计了一种显式建模的潜空间结构:为每个类别设定独立的高斯分布,通过对比学习方法(BarlowTwins)同时增强类别一致性与类内多样性,从而将高分辨率的StyleGAN成功扩展到ImageNet-LT和iNaturalist2019等千类长尾数据集上,并取得了SOTA表现。

二、长尾数据中的归纳式正则化

虽然基于图像生成可提升对尾类的分类性能,但训练额外的生成模型成本较高。为此,我们探索了更轻量的手段,如对尾类加大损失权重(loss re-weighting)。但该策略易导致模型陷入鞍点(saddle point)而非收敛到最优点,从而影响泛化能力。 我们引入Sharpness-Aware Minimization(SAM)以诱导模型逃离鞍点,促使尾类也能如头类一样有效泛化。此外,训练视觉Transformer(ViTs)在长尾分类任务中仍具挑战,因其缺乏如局部感知等归纳偏置,训练数据需求高。我们提出DeiT-LT,结合来自CNN的OOD蒸馏与低秩特征蒸馏,将CNN的鲁棒性引入可扩展的ViT模型中。

三、面向非可加性指标的半监督学习

上述方法均在监督学习框架下,避免丢弃已标注数据。而现实中,大量未标注数据的有效利用是关键。为此,我们构建了一种针对非可加性指标(如worst-case recall、H-mean recall)进行反馈学习的半监督学习框架。 我们提出Cost-Sensitive Self-Training(CSST),将传统的自训练方法(如FixMatch)推广至长尾数据下,并具备理论保证与良好实证表现。在主流的“自监督预训练 + 微调”范式中,我们还提出了SelMix,一种高效的微调方法,可用来优化非可加指标。SelMix放宽了“未标注数据分布与标注数据一致”的假设,增强模型对分布偏移的鲁棒性。

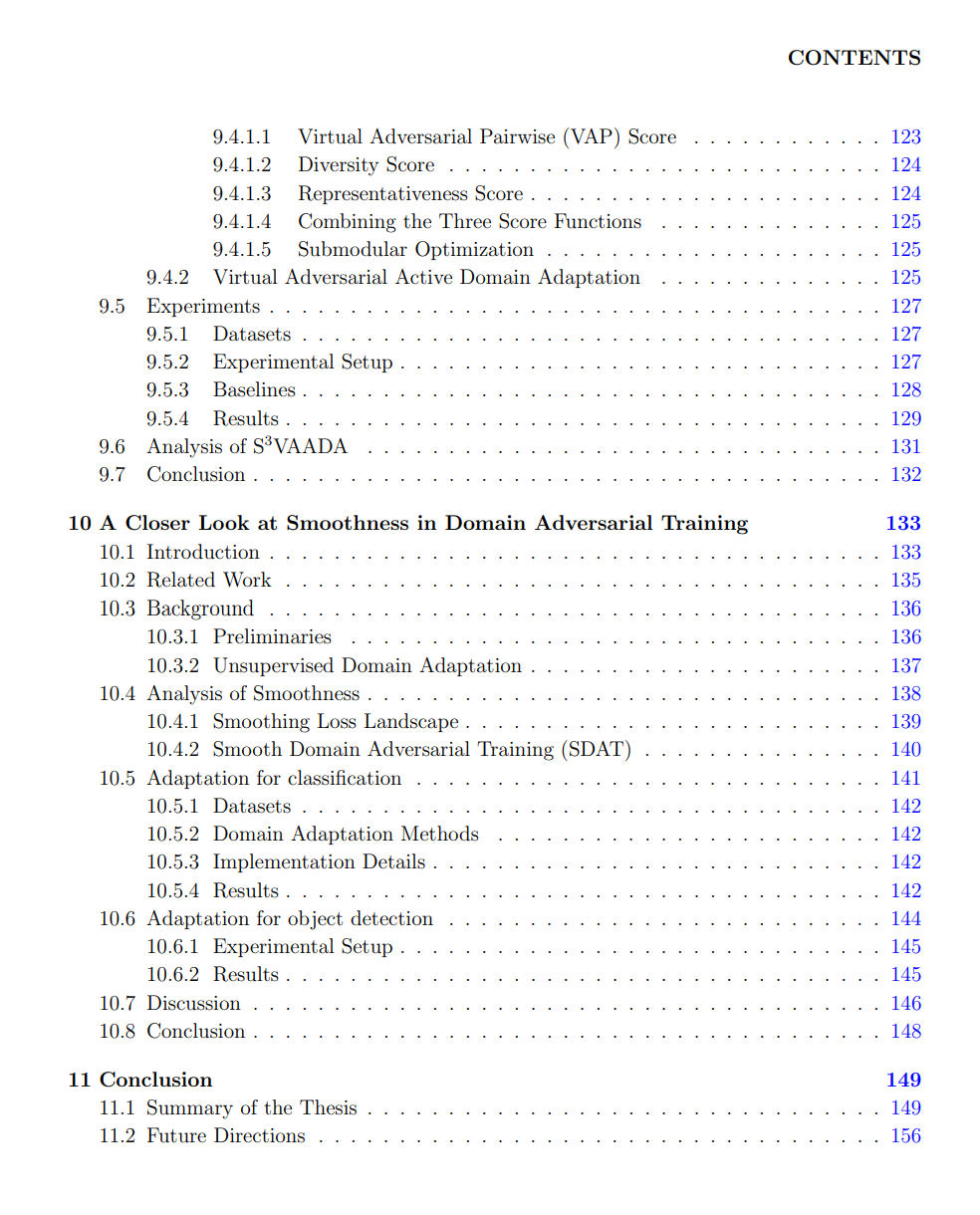

四、高效的领域自适应学习

长尾学习方法主要提升的是受限数据下的“内分布”泛化能力,但实际应用中,模型还需能在跨领域的场景下泛化。为此,我们提出子模集选择的对抗性领域自适应方法,通过精挑细选少量目标域样本用于标注,最大化模型性能提升。 进一步,为提高适应效率,我们引入Smooth Domain Adversarial Training(SDAT),该方法使模型收敛到更具泛化能力的“平滑最小值”,从而实现跨任务、跨领域的高效模型迁移。

总结:本论文系统探索了在真实世界中如何从有限与不完美数据中训练深度神经网络模型,涵盖生成学习、判别学习、半监督学习与跨域迁移四大子方向,为深度模型的大规模实际部署提供了坚实算法基础与方法论支撑。