这是一门关于机器学习的入门课程。机器学习是一组技术,它允许机器从数据和经验中学习,而不是要求人类手工指定所需的行为。在过去的20年里,机器学习技术在人工智能的学术领域和科技行业中都变得越来越重要。本课程提供了一些最常用的ML算法的广泛介绍。

课程的前半部分侧重于监督学习。我们从最近邻、决策树和集合开始。然后介绍了参数化模型,包括线性回归、logistic回归和softmax回归以及神经网络。然后我们转向无监督学习,特别关注概率模型,以及主成分分析和k均值。最后,我们介绍了强化学习的基础知识。

课程内容:

- 最近邻导论

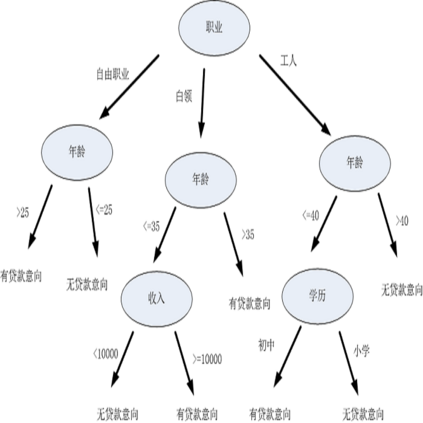

- 决策树集成

- 线性回归线性分类

- Softmax回归、SVM、Boosting

- PCA、Kmeans、最大似然

- 概率图模型

- 期望最大化

- 神经网络

- 卷积神经网络

- 强化学习

- 可微分隐私

- 算法公平性

https://www.cs.toronto.edu/~huang/courses/csc2515_2020f/

推荐阅读材料: Hastie, Tibshirani, and Friedman: “The Elements of Statistical Learning” Christopher Bishop: “Pattern Recognition and Machine Learning”, 2006. Kevin Murphy: “Machine Learning: a Probabilistic Perspective”, 2012. David Mackay: “Information Theory, Inference, and Learning Algorithms”, 2003. Shai Shalev-Shwartz & Shai Ben-David: “Understanding Machine Learning: From Theory to Algorithms”, 2014.

学习路线图:

成为VIP会员查看完整内容