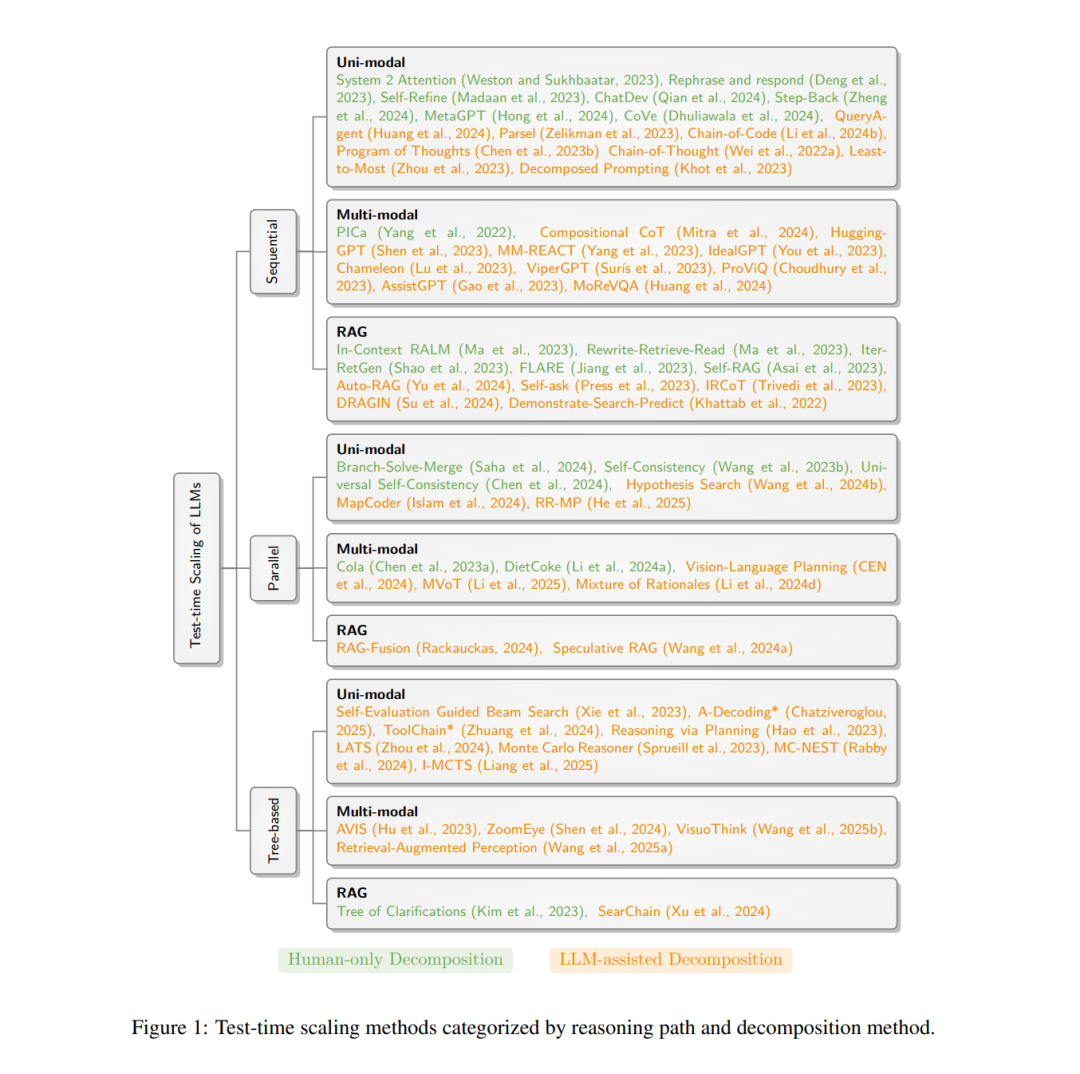

在本文中,我们综述了通过在推理阶段分配额外计算资源来提升预训练大语言模型预测准确性的相关技术。在对测试时扩展(test-time scaling)方法进行分类时,我们特别强调了任务是如何被分解为子问题,以及这些子问题在拓扑结构上的组织方式——包括顺序式、并行式或树状结构。这样的视角使我们能够在统一框架下理解诸如 Chain-of-Thought、Branch–Solve–Merge 和 Tree-of-Thought 等多种方法。我们还综合了现有对此类技术的分析,总结了它们各自的优势与不足,并在最后指出值得进一步探索的有前景的研究方向。

1 引言

测试时扩展(Test-time Scaling, TTS)指的是在推理阶段以更多计算资源换取更高预测准确率的策略(Brown et al., 2024; OpenAI, 2024; Wu et al., 2024; DeepSeek-AI et al., 2025)。通过在推理时间投入额外计算以提升精度,测试时扩展能够在不改变模型参数的前提下,提升大语言模型(LLMs)和视觉语言模型(VLMs)的性能,并已在诸如 ARC-AGI(Chollet, 2019)等复杂任务上展现出性能提升。 测试时扩展最经典的例子无疑是 Chain-of-Thought(CoT)技术(Wei et al., 2022a)。该方法在预测最终答案之前,会顺序生成一系列描述思考过程的中间文本 token。已有研究表明,这些中间 token 能够扩展具有固定层数的 Transformer 网络可解决的问题范围(Li et al., 2024d)。 除了 CoT 的顺序式执行方式外,也可以用不同方式组织子任务或子问题。本综述论文的核心观点是:子问题结构对于性能至关重要。这一原则在理论计算机科学中早已广为人知(Cormen et al., 2001),并体现在分治法、动态规划等技术中。例如,Branch–Solve–Merge(Saha et al., 2024)和 A-Decoding*(Chatziveroglou, 2025)等方法会以并行或树搜索的方式求解子问题。 在本文中,我们从子问题结构的视角系统综述测试时扩展技术。我们提出的一个关键洞察是:子问题的识别与组织方式在不同问题域(单模态 vs. 多模态)或不同类型的大语言模型(直接生成 vs. 检索增强¹)中具有共通影响。为展示这一点,我们在不同问题域和模型家族中对相关技术进行梳理,并讨论它们的共同优缺点,以期为未来研究提供启发。 有必要明确本综述的范围。我们仅讨论不改变主 LLM 参数的方法,但不排除对小型辅助 LLM 进行微调的方法,例如在树搜索中学习启发式函数(第 3.3 节)。我们专注于以计算换精度的方法,而不讨论加速推理的方法。需要强调的是,本综述主要关注子任务/子问题结构,而非面向具体领域的技术(例如检索增强生成 RAG 中的检索技术)。 此外,将 TTS 与若干相关领域区分开来也很重要。TTS 可用于提升 LLM/VLM 的推理能力或智能体型 LLM 的能力,但这些领域还包含其他与 TTS 不同的技术。例如,推理能力可以通过训练时技术(如强化学习,DeepSeek-AI et al., 2025)提升;而智能体型 LLM 涉及诸如社会模拟(Park et al., 2023)等主题。 我们的主要贡献如下:第一,我们从子任务结构的视角,对 TTS 技术进行了详细综述,强调子任务分解在 TTS 设计中的核心地位。第二,我们对不同分解策略的相对优势与劣势进行了深入讨论,为研究者与实践者设计合适的 TTS 方法提供参考。