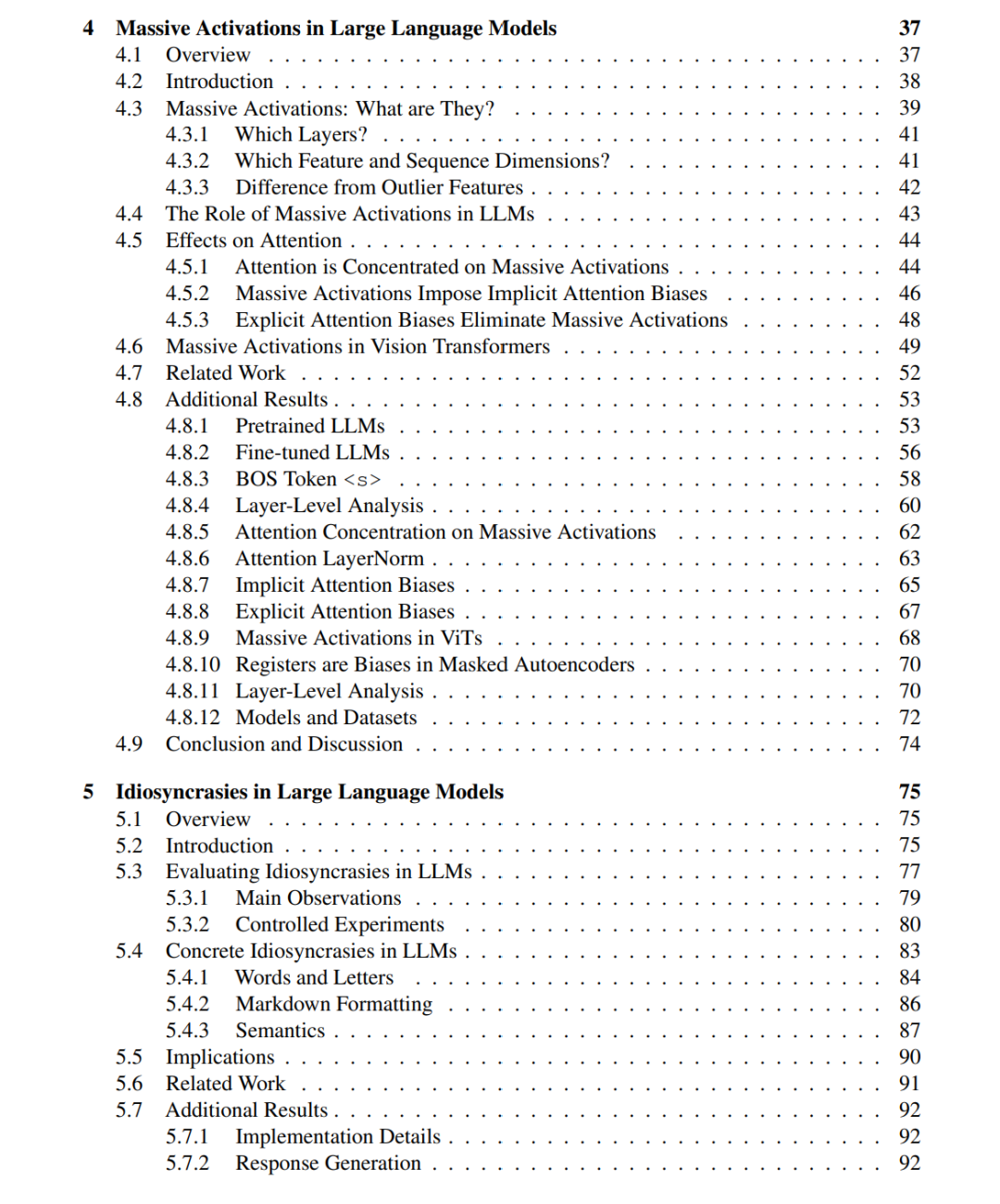

大型语言模型(Large Language Models, LLMs)是一类经过训练以理解和生成自然语言的深度学习模型。在我的博士研究期间,LLMs 已经深刻地改变了机器学习领域的格局。如今,它们被广泛应用于众多商业产品中,例如 ChatGPT。此外,从 LLMs 的开发过程中所获得的原理与经验,也持续塑造着机器学习研究的方向——包括尺度规律(scaling laws)与自监督表征学习(self-supervised representation learning)等新范式。 然而,这些快速的进展也可能掩盖了许多关于模型内部机制与行为的基础性问题。随着 LLM 能力的不断增强,超越传统训练与评估流程的严谨科学研究变得尤为重要,它对于深入理解与持续改进这些模型至关重要。 本论文旨在研究以往被忽视的 “大型语言模型的隐性特性(hidden properties)”。这些隐性特性涉及模型的内部权重空间、激活空间以及输出行为等不同层面。 首先,我们发现 LLMs 在其权重空间(weight space)中本质上具有稀疏性(intrinsic sparsity)。为验证这一隐性特征,我们提出了一种基于原理的剪枝方法(principled pruning approach),能够从预训练模型中提取出有效的稀疏子网络。 其次,我们进一步探索了激活空间(activation space),揭示了其中存在结构化异常值(structured outliers)。这些激活数量极少,但其绝对值幅度极高。我们称之为**“极大激活(massive activations)”。研究表明,这些激活与自注意力机制(self-attention mechanism)密切相关。针对这一现象,我们提出了一种不含此类异常激活的替代注意力机制**。 最后,我们聚焦于输出空间(output space),设计了一个概念上简单的分析框架,用于评估和研究 LLM 生成文本中的特异性(idiosyncrasies)。实验表明,不同模型生成的文本可以被以极高的准确率区分开来,我们进一步分析了导致这种差异的特征性“签名模式(signatures)”。 总体而言,本论文希望为现代基础模型(foundation models)提供一种全新的研究视角,以促进对其内部结构与行为机制的深入理解。