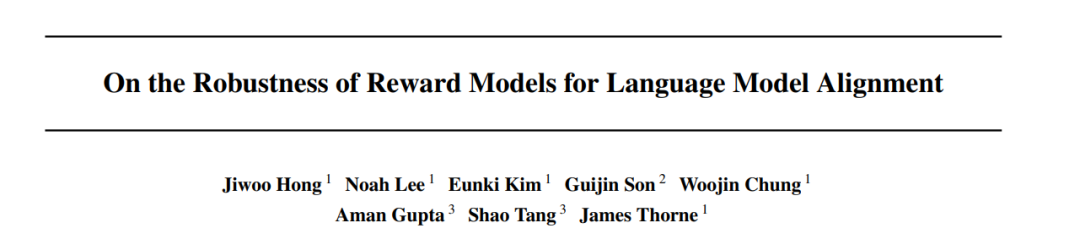

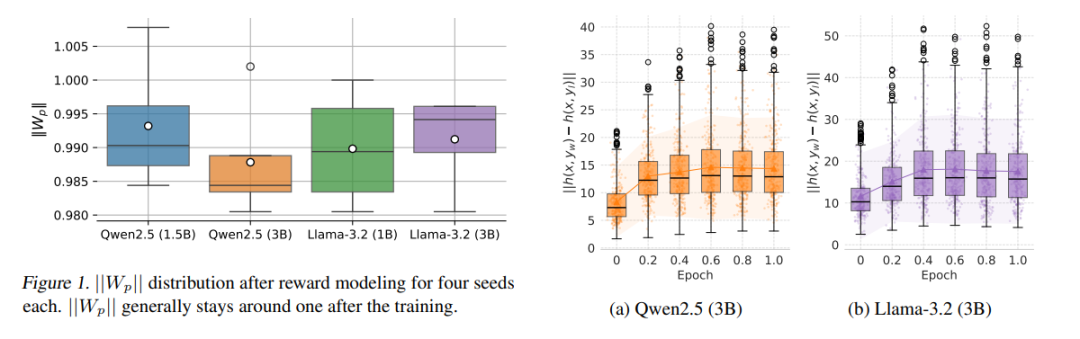

Bradley-Terry(BT)模型在基于人类反馈的强化学习(Reinforcement Learning with Human Feedback, RLHF)中的奖励建模中被广泛使用。尽管该方法在实际中表现出良好效果,但基于 BT 损失训练的奖励模型(Reward Models, RMs)容易发生过度优化,从而失去对未见输入分布的泛化能力。本文探讨了奖励模型训练中出现过度优化的根本原因及其对下游 RLHF 过程的影响,强调了在未见数据上保持分布鲁棒性的重要性。 首先,我们指出隐藏状态范数(hidden state norms)过度离散是导致过度优化的主要原因。为此,我们提出了一种批次级零和正则化方法(Batch-wise Sum-to-Zero Regularization, BSR),强制每个批次的奖励总和接近于零,以约束极端奖励值的出现。 我们在四种过度优化场景下评估了 BSR 对提升奖励模型鲁棒性的效果,结果显示 BSR 在各场景中均表现出更强的鲁棒性。随后,我们将原始 BT 模型与引入 BSR 的模型应用于 RLHF 训练,并实证验证了更鲁棒的奖励模型在策略对齐方面能更好地贴近黄金偏好模型(gold preference model)。 最后,我们将 BSR 应用于高质量数据和大规模模型中,结果显示在复杂偏好预测任务中,相比于当前 8B 规模的最先进奖励模型,性能提升超过 5%。在对 8B 奖励模型进行 RLOO(Reinforcement Learning with Leave-One-Out)训练时,AlpacaEval 2.0的生成文本长度减少了 40%,胜率提高了 7%。这一成果进一步表明,奖励模型的鲁棒性能够有效增强整个 RLHF 训练过程的稳健性。 我们已开源代码、数据与模型,详见: 🔗 https://github.com/LinkedIn-XFACT/RM-Robustness