随着AI系统在人类事务中的作用日益增强,基于人类行为洞察构建系统的重要性愈发凸显。特别是遵循人类合理性原则开发的模型,更可能产生产生可问责且可解释的结果,从而更好地确保系统行为与利益相关者期望的一致性。本论文将呈现基于人类合理性原则的三个应用研究:

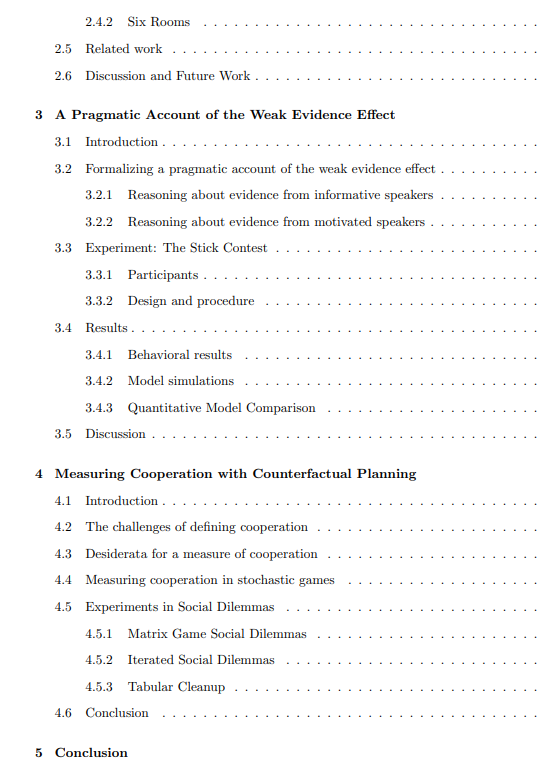

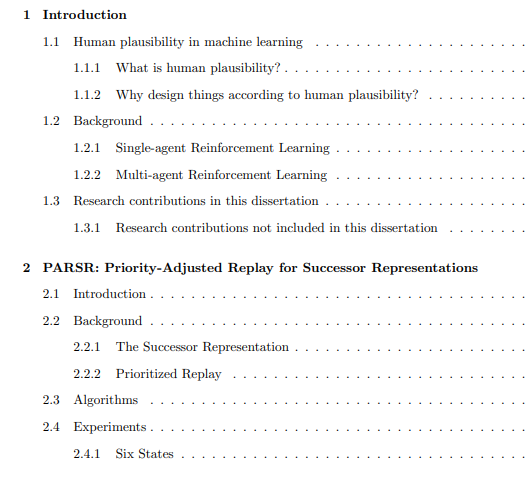

(i)合理表征:提出优先级调整后继表征回复(PARSR)算法——一种融合优先级回放与后继表征学习的单智能体强化学习算法。两种机制的结合使算法更具生物学合理性,能够模拟人类将先前任务知识迁移与泛化至新任务的能力。

(ii)合理推理:构建弱证据效应的实用解释模型,揭示社会认知中当人类必须考量说服性目标时整合他人证据的反直觉现象。由此推导出递归贝叶斯模型,阐释AI系统与人类利益相关者在存在既定利益时的双向理解机制。

(iii)合理评估:提出多智能体系统合作行为的可量化普适测度,该测度具有反事实对比性、情境依赖性及环境参数可定制性特征。其核心价值在于区分集体福利的实现路径——源自真实合作或个体自利行为(两者可能导致相同结果)。

成为VIP会员查看完整内容

相关内容

Arxiv

207+阅读 · 2023年4月7日

Arxiv

79+阅读 · 2023年4月4日

Arxiv

142+阅读 · 2023年3月29日

Arxiv

12+阅读 · 2021年10月4日