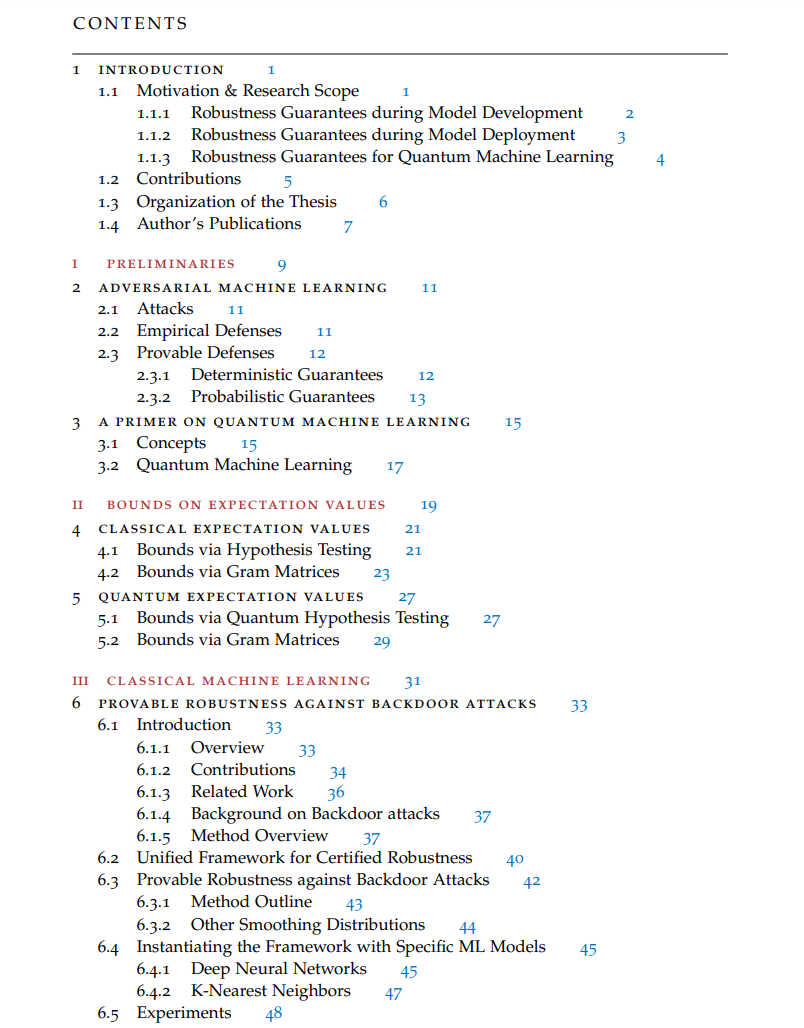

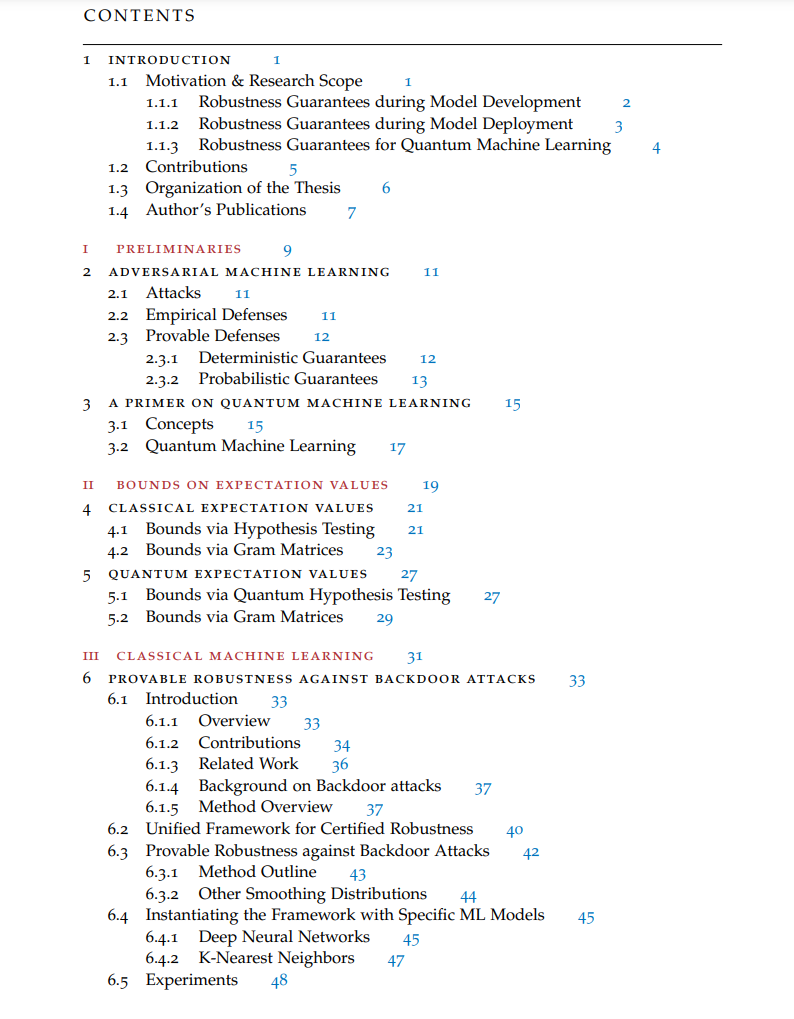

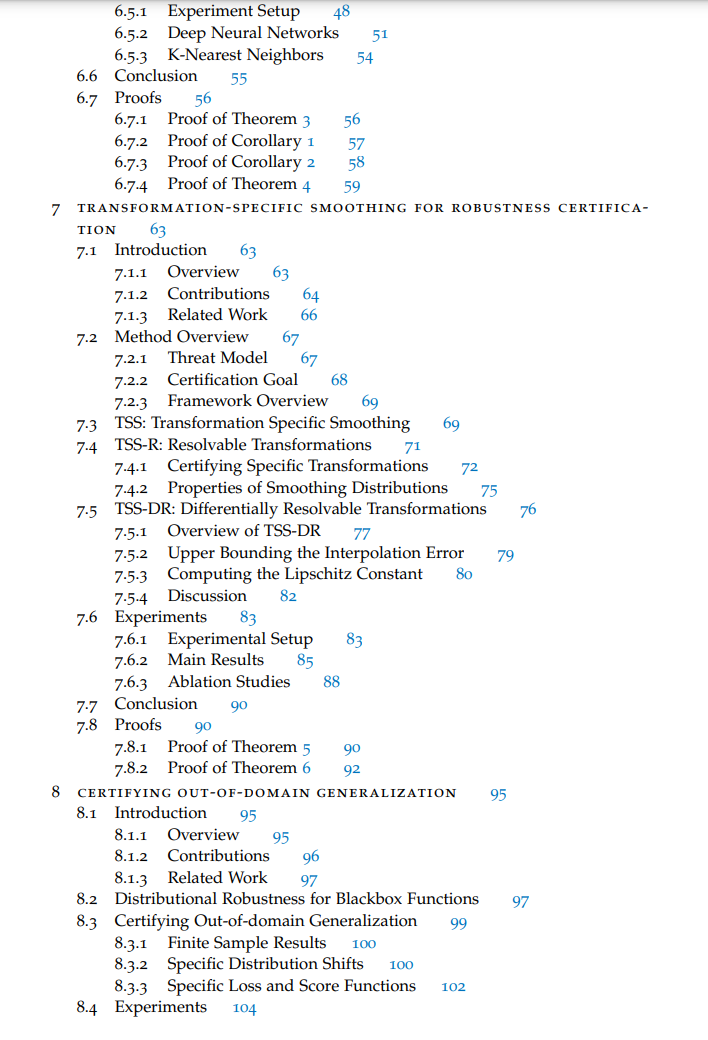

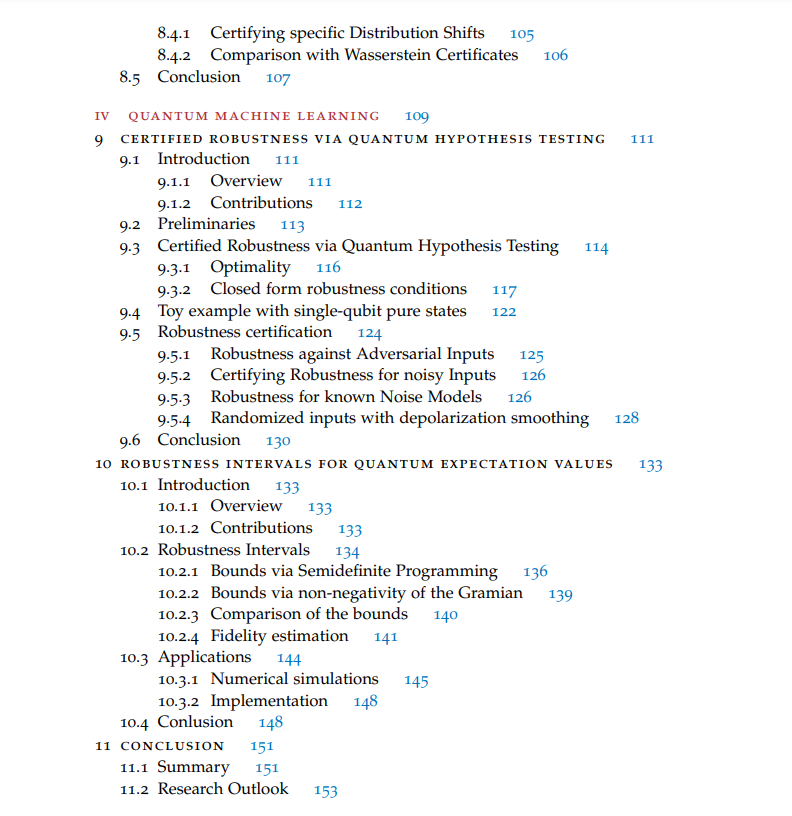

广泛采用的机器学习(ML)系统开启了一个前所未有的机遇时代,转变了行业、医疗保健和整个社会。然而,与这些机遇并存的是,ML面临着需要全面理解并充分解决的重大挑战。ML系统的内在复杂性使它们容易受到各个阶段的广泛对抗攻击和不确定性的影响。这些脆弱性源自ML系统运作的动态和不可预测的环境,其中输入数据的微小扰动可能导致灾难性的后果。此外,量子计算的出现及其最终整合到ML系统中引入了沿着新的维度的额外脆弱性。因此,开发能够保证ML系统韧性的方法学至关重要。这篇论文致力于开发概率鲁棒性保证,解决在ML流程的不同阶段出现的脆弱性问题,涵盖模型开发(包括训练和数据整理)和模型部署。此外,这些保证扩展到经典和量子计算框架,承认量子计算引入到ML领域的独特挑战和机遇。本论文的贡献有三方面:首先,我们关注模型开发阶段出现的对抗攻击,并开发了RAB,这是一个针对后门攻击(一种特定的数据投毒攻击)的可证明鲁棒的训练过程。我们的方法是基于从Neyman-Pearson引理衍生的概率鲁棒性保证的扩展,并基于对训练数据和测试实例进行平滑处理。除了这一扩展,我们还提出了针对特定模型类型所需的几项优化,使我们的方法能够有效应对常见的大规模数据集。除了方法的理论开发外,我们还在表格数据和计算机视觉数据集上展示了广泛的实验结果,并显示我们的鲁棒训练流程不仅提高了经验鲁棒性,而且提供了一个概率证书,保证了后门攻击已经失败。其次,我们将注意力转向模型部署阶段,并考虑来自语义转换以及数据分布变化的输入扰动。语义转换通常由低维参数空间(例如,旋转角度)控制,并在ℓp范数方面引起大量图像损坏。这使得传统的概率鲁棒性保证(提供对扰动幅度的界限)变得无效。为了解决这个问题,我们提出了TSS,一个针对来自语义扰动的输入损坏的鲁棒性认证框架。TSS利用Neyman-Pearson方法的随机平滑技术,并对变换参数进行平滑处理。结合新技术以限制插值误差和几种特定变换的认证方法,TSS为大量语义转换设定了新的最先进水平。与此工作线相对的,我们研究了ML系统对数据分布变化的鲁棒性,并与之前的结果相比,采取了基于人口的视角。我们在这里提出的保证不是针对特定实例的鲁棒性,而是通过界定训练分布周围的ϵ-球内任何分布上的最坏情况人口损失来呈现域外泛化的保证。与以前的方法不同,我们的方法只需要对模型函数的黑盒访问,因此可以扩展到大型模型,如EfficientNet-B7和BERT。在计算机视觉和自然语言基准测试上的多样化实验中,我们展示了我们的界限准确捕捉了由数据分布变化引起的最坏情况性能变化。第三,我们为量子ML开发了鲁棒性保证,我们覆盖了对抗案例和由自然噪声和退相干引起的输入损坏。为此,我们首先为量子分类器提出了一个鲁棒性保证,我们将Neyman-Pearson方法扩展到量子领域。有趣的是,由于从量子电路读出的固有概率性质,这一保证作为量子分类器的一般属性而存在,不需要像经典ML模型那样主动注入噪声进行平滑。最后,在噪声中等规模量子(NISQ)算法的开发阶段,自然噪声和退相干可能是比对抗场景更重要的障碍。作为最后一步,我们考虑了理想量子态的近似,其中近似误差可能来自噪声,或来自算法缺陷,如Ansätze的有限表达性。然后,我们扩展了基于量子假设测试(QHT)和格拉姆矩阵的非负性的技术,以导出量子期望值最坏情况误差的界限。在数值模拟中,我们研究了变分量子本征求解器(VQE),并在几个与量子化学相关的问题上验证了我们的界限。