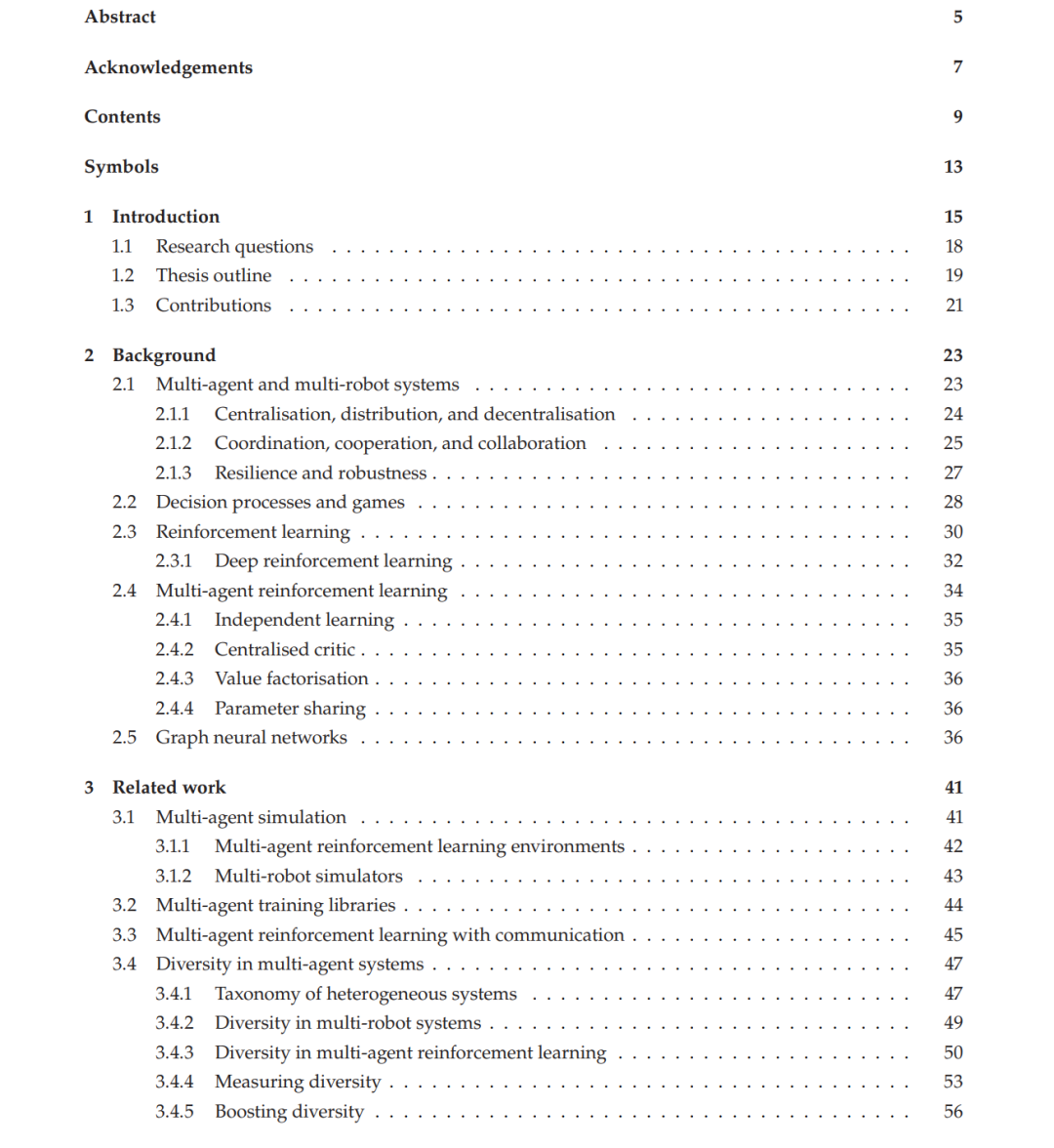

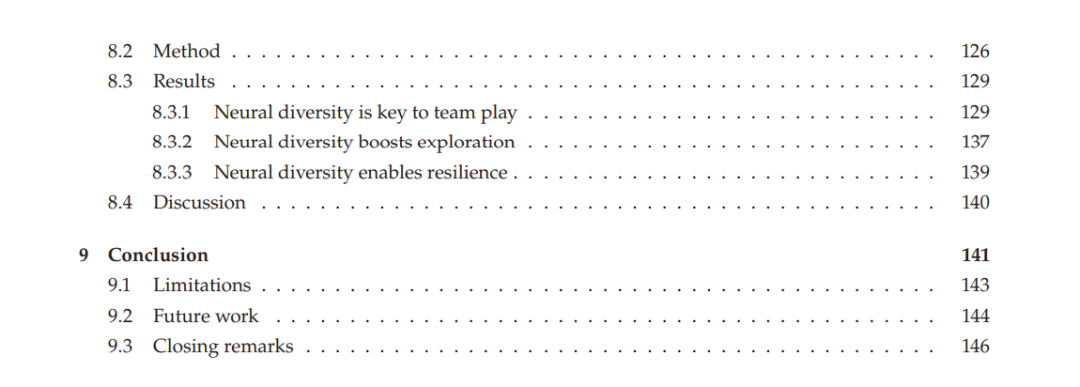

集体智能是生命的核心特征,并广泛存在于自然系统之中。尽管其重要性不言而喻,这一涌现属性对我们而言仍然知之甚少。自然系统的研究已表明,多样性是其涌现的核心原则之一;然而,在集体人工智能的研究中,多样性却基本上未被深入探索。 在多智能体学习中,缺乏对行为多样性的研究,主要原因在于传统方法往往将智能体的策略限制为相同。这种做法通过从所有个体的经验中训练一个共享策略来加速学习,但结果是智能体在行为上变得同质化。同质化的智能体在相同输入下被迫采取相同动作,从而失去了策略上的多样性。这个问题在多智能体强化学习(MARL)的背景下尤为明显,因为同质化训练常用于缓解模拟的高计算成本。虽然已有部分工作尝试通过额外的损失函数或内在奖励来增强 MARL 的行为多样性,但这些方法并未提供一种系统性的测量或控制手段。在这种做法下,它们实际上改变了原始任务的学习目标,从而损害了最优性。 本论文旨在通过研究神经(即行为)多样性在多智能体学习中的作用,来明确其在集体人工智能中的意义。为此,我们提出了 HetGPPO:一种新颖的图神经网络(GNN)模型,使智能体能够以异质的方式进行学习和通信。我们将 HetGPPO 部署在地面机器人群体上,展示了神经多样性在实际多机器人任务中所提供的内在抗噪性。为了量化由此产生的异质性,我们提出了系统神经多样性(System Neural Diversity, SND),这是一个用于多智能体学习中行为异质性的全新度量指标。SND 是首个能够在不同规模系统之间进行多样性比较并量化行为冗余的指标。最后,我们引入了基于 SND 的多样性控制方法(Diversity Control, DiCo),这是首个能够将多智能体系统的多样性精确控制到给定指标数值的方法。DiCo 是唯一无需增加学习目标即可约束多样性的方法,它通过对智能体策略网络施加结构性约束来实现。我们在合作与竞争任务的大规模实证研究中应用了 SND 和 DiCo。在多智能体模拟足球(每队最多五名球员)中,我们的结果表明,控制多样性能够促进新策略的涌现(如传球与守门),其表现优于同质化智能体,并展示了行为分工的必要性。 为支持神经多样性的研究,我们引入了若干新颖的开源库,用于模拟和训练多智能体系统(MAS)。首先,我们提出了向量化多智能体模拟器(VMAS),这是一个基于 PyTorch 编写的批量模拟器,包含多个多机器人任务。得益于图形处理器(GPU)加速与批量处理,VMAS 相比于以往最先进的软件实现了极大的加速。其次,我们介绍了 BenchMARL,这是一个多智能体强化学习训练库,旨在标准化基准测试并提升可复现性。BenchMARL 提供高性能、持续维护的最先进算法实现,使不同算法、模型与环境之间的比较成为可能。 本论文系统性地研究了多智能体系统中的神经多样性,证明了其在集体学习中关键但长期被忽视的作用。我们提出了一系列新方法,用于模拟、赋能、训练、测量与控制神经多样性。研究结果表明,神经多样性对于合作、探索与鲁棒性至关重要,为理解和发展集体人工通用智能奠定了基础。