【导读】ICML(International Conference on Machine Learning),即国际机器学习大会, 是机器学习领域全球最具影响力的学术会议之一,因此在该会议上发表论文的研究者也会备受关注。因疫情的影响, 今年第37届ICML大会已于2020年7月13日至18日在线上举行。据官方统计,ICML 2020共提交4990篇论文,接收论文1088篇,接收率为21.8%。与往年相比,接收率逐年走低。小编发现基于域自适应(Domain Adaptation)相关的paper也不少,域自适应及其在不同方式的转换和应用等等都是这几年比较火的topic,受到了很多人的关注。

为此,这期小编继续为大家奉上ICML 2020必读的六篇域自适应(Domain Adaptation)相关论文——连续域自适应、多源域自适应、无监督域自适应、少样本域自适应、开放集域自适应

ICML 2020 Accepted Paper: https://proceedings.icml.cc/book/2020

ICML2020ML、ICML2020CL、ICML2020CI、ICML2020GNN_Part2、ICML2020GNN_Part1

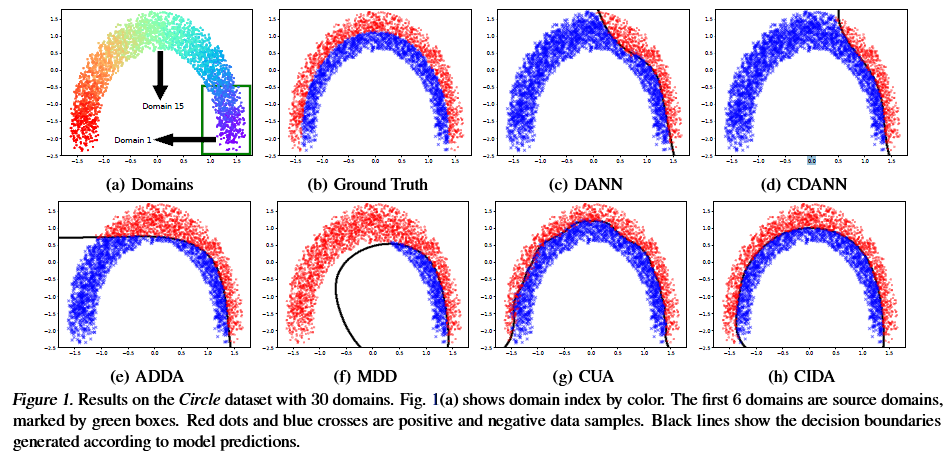

1、Continuously Indexed Domain Adaptation

作者:Hao Wang, Hao He, Dina Katabi

摘要:现有的域自适应集中于在具有分类索引的领域之间(例如,在数据集A和B之间)传递知识。然而,许多任务涉及连续索引的域。例如,在医疗应用中,人们经常需要在不同年龄的患者之间进行疾病分析和预测,而年龄是连续领域的指标。这样的任务对于现有的域自适应方法是有挑战性的,因为它们忽略了领域之间的潜在关系。在本文中,我们第一个提出了连续索引域自适应的方法。该方法将传统的对抗性适应与新颖的鉴别器相结合,该鉴别器对编码条件下的域索引分布进行建模。我们的理论分析证明了利用域索引在连续域范围内生成不变特征的意义。我们的实验结果表明,我们的方法在综合医学数据集和实际医学数据集上均优于最先进的域自适应方法。

代码链接: https://github.com/hehaodele/CIDA

网址: https://proceedings.icml.cc/paper/2020/hash/9a1756fd0c741126d7bbd4b692ccbd91

2、Domain Aggregation Networks for Multi-Source Domain Adaptation

作者:Junfeng Wen, Russell Greiner, Dale Schuurmans

摘要:在许多实际应用中,我们希望利用多个源数据集为不同但相关的目标数据集建立模型。尽管最近在经验上取得了成功,但大多数现有的研究都是采用特别的方法来组合多种来源,从而导致理论与实践之间的差距。本文提出了一种基于域差异的有限样本泛化边界,并据此提出了一种理论上合理的优化方法。我们的算法,Domain AggRegation Network(DARN),能够自动、动态地平衡包含更多数据以增加有效样本量和排除无关数据以避免训练过程中的负面影响。我们发现,DARN在多个实际任务(包括数字/对象识别和情感分析)上性能明显优于现有的最新技术。

网址: https://proceedings.icml.cc/paper/2020/hash/89d3d7800304002cd469f0c402bd3ea0

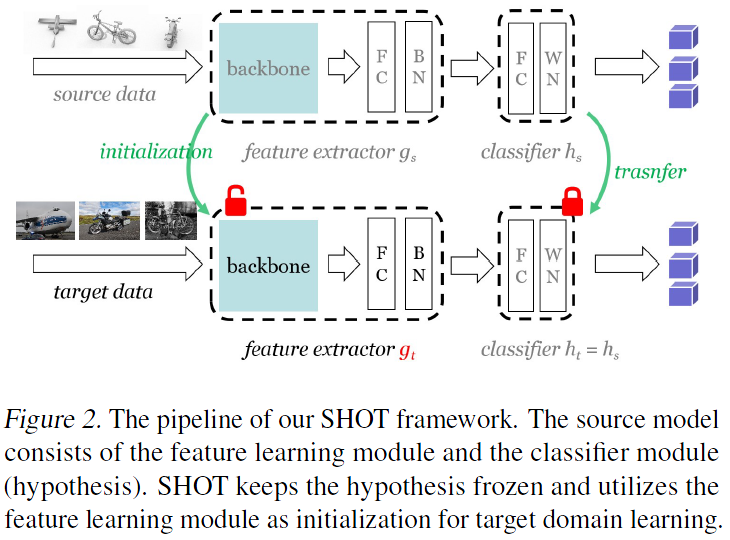

3、Do We Really Need to Access the Source Data? Source Hypothesis Transfer for Unsupervised Domain Adaptation

作者:Jian Liang, Dapeng Hu, Jiashi Feng

摘要:无监督域自适应(UDA)的目的是利用从标记的源数据集中学习的知识来解决新的未标记域中的相似任务。以前的UDA方法通常需要在学习适应模型时访问源数据,这使得它们对于分散的私有数据来说风险很大,效率低下。这项工作解决了一个只有经过训练的源模型可用的新环境,并研究了如何在没有源数据的情况下有效地利用这种模型来解决UDA问题。我们提出了一个简单而通用的表示学习框架,称为源假设迁移(SHOT)。SHOT冻结了源模型的分类器模块(假设),通过利用信息最大化和自监督伪标记将目标域的表示隐式地与源假设对齐,从而学习了特定于目标的特征提取模块。为了验证它的通用性,我们对SHOT在各种适应情况下进行了评估,包括闭集、部分集和开集域适配。实验表明,SHOT在多个域自适应基准中产生了最先进的结果。

代码链接: https://github.com/tim-learn/SHOT

网址: https://proceedings.icml.cc/paper/2020/hash/a597e50502f5ff68e3e25b9114205d4a

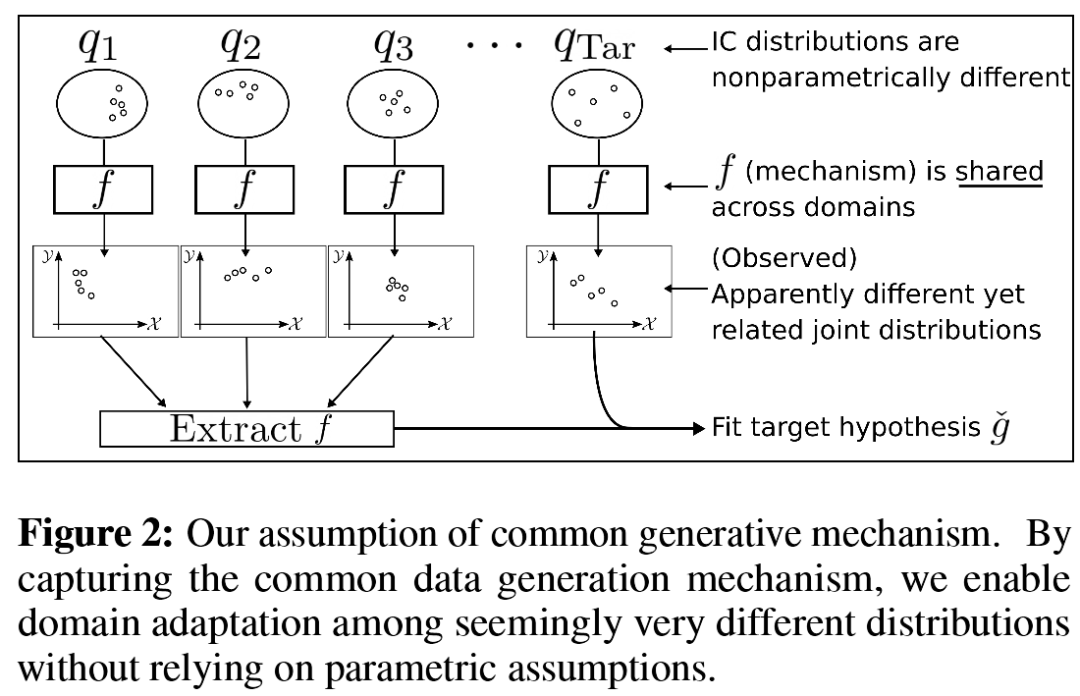

4、Few-shot Domain Adaptation by Causal Mechanism Transfer

作者:Takeshi Teshima, Issei Sato, Masashi Sugiyama

摘要:我们研究将少样本自监督域自适应方法应用于回归类问题,其中只有少量的已标记的目标域数据和大量的已标记源域数据可用。目前的许多域适应方法的转移条件都是基于参数化分布偏移或明显的分布相似性,例如相同的条件或很小的分布差异。然而,这些假设排除了在复杂的迁移环境或者明显不同的分布中适应的可能性。为了克服这个问题,我们提出了机制迁移(mechanism transfer),这是一种元分布场景,其中数据生成机制在域之间是不变的。这种迁移假设可以适应非参数化偏移所导致的明显的分布差异,同时也为域自适应学习提供一个坚实的统计基础。本文以因果模型中的结构方程为例,提出了一种新的域自适应学习方法,该方法在理论和实验上都表明了良好的可用性。我们提出的方法可以看做是第一次尝试利用结构因果模型来进行域自适应学习。

代码链接: https://github.com/takeshi-teshima/few-shot-domain-adaptation-by-causal-mechanism-transfer

网址:

https://proceedings.icml.cc/paper/2020/hash/3a15c7d0bbe60300a39f76f8a5ba6896

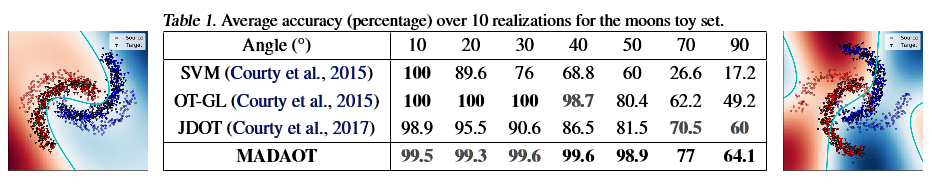

5、Margin-aware Adversarial Domain Adaptation with Optimal Transport

作者:Sofien Dhouib, Ievgen Redko, Carole Lartizien

摘要:本文对于无监督域适应学习提出了一种新的理论分析方法,涉及大边际分离,对抗性学习和最优传输。我们提出这种分析方法一般化了之前通过对目标边界违规率进行限定的工作,结果表明出对目标域类别进行分离质量控制优于对误分类率进行限定。该边界还强调了源域上的边际分离对自适应的好处,并引入了基于最优传输(OT)的域间距离,该距离与其他方法不同之处在于其依赖于具体的任务。从目前所获得的结果看,我们得到了一个新的域自适应解决方案,该方案引入了一种新的基于浅OT的对抗方法,并且在一些现实世界中的分类任务上优于其他域自适应方法。

代码链接: https://github.com/sofiendhouib/MADAOT

网址: https://proceedings.icml.cc/paper/2020/hash/1102a326d5f7c9e04fc3c89d0ede88c9

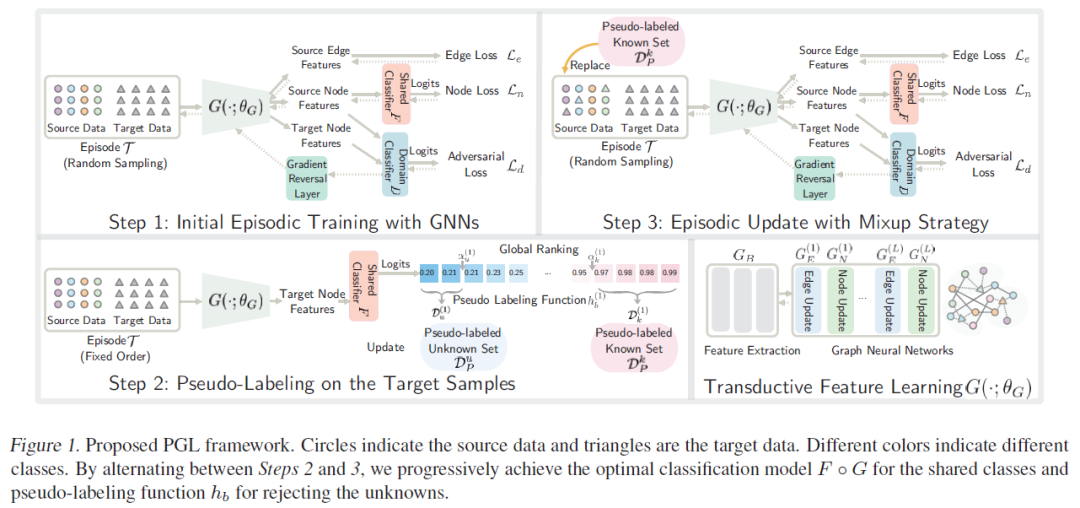

6、Progressive Graph Learning for Open-Set Domain Adaptation

作者:Yadan Luo, Zijian Wang, Zi Huang, Mahsa Baktashmotlagh

摘要:域偏移是计算机视觉识别中的一个基本问题,通常在源数据和目标数据遵循不同的分布时出现。现有的域适应方法都是在闭集环境下工作的,即假设源数据和目标数据共享完全相同的对象。在这篇论文中,我们解决了一个开放域在迁移时所面临的现实问题:目标域中所包含的一些样本类别在源域中并不存在。具体来说,本文提出了一种端到端的渐进式(PGL)学习框架,该框架集成了一个已训练过的图神经网络来抑制潜在的条件转移,并采用对抗性学习来缩小源域和目标域之间的分布差异。与目前的开放域自适应方法相比,我们的方法能够保证更加接近目标误差的上限。在三个公共基准数据集上的大量实验证明,我们的方法在开放域适应方面的性能明显优于目前的其他方法。

网址: https://proceedings.icml.cc/paper/2020/hash/42a0e188f5033bc65bf8d78622277c4e